Por qué «la fiabilidad es el producto» en ecosistemas empresariales

Cuando una empresa depende de plataformas compartidas para ejecutar finanzas, fabricación, logística, RR. HH. y canales de cliente, el tiempo de actividad deja de ser una cualidad «agradable de tener». Se convierte en aquello que se vende. Para una organización como Samsung SDS —que opera como un proveedor de servicios de TI y plataformas a gran escala— la fiabilidad no es solo una característica del servicio; es el servicio.

Qué significa realmente «la fiabilidad es el producto»

En apps de consumo, una breve interrupción puede ser molesta. En ecosistemas empresariales, puede pausar el reconocimiento de ingresos, retrasar envíos, romper reportes de cumplimiento o provocar penalizaciones contractuales. «La fiabilidad es el producto» significa que el éxito se juzga menos por nuevas funcionalidades y más por resultados como:

- procesos de negocio que se completan a tiempo

- integraciones críticas que se mantienen sanas

- rendimiento predecible durante picos

- recuperación rápida cuando ocurren incidentes

También implica que ingeniería y operaciones no son «fases» separadas. Forman parte de la misma promesa: clientes y stakeholders internos esperan que los sistemas funcionen —de forma coherente, medible y bajo estrés.

Qué es un «ecosistema» en términos empresariales

La fiabilidad empresarial rara vez trata sobre una única aplicación. Trata sobre una red de dependencias a través de:

- filiales y compañías del grupo que comparten identidad, redes y plataformas centrales

- proveedores que ofrecen herramientas SaaS, feeds de datos y componentes de infraestructura

- clientes y socios que se integran vía APIs, EDI, portales y apps móviles

- reguladores y auditores que exigen trazabilidad, controles e informes

Esta interconexión aumenta el radio de explosión de las fallas: un servicio degradado puede propagarse a docenas de sistemas downstream y obligaciones externas.

Qué esperar de este artículo

Este post se centra en ejemplos y patrones repetibles —no en detalles internos o propietarios. Aprenderás cómo las empresas abordan la fiabilidad mediante un modelo operativo (quién posee qué), decisiones de plataforma (estandarización que aun así soporta velocidad de entrega) y métricas (SLOs, rendimiento en incidentes y objetivos alineados al negocio).

Al final, deberías poder mapear estas ideas a tu propio entorno —ya sea que lideres una organización de TI central, un equipo de servicios compartidos o un grupo de plataforma que soporta un ecosistema de negocios dependientes.

Samsung SDS en contexto: servicios empresariales, plataformas y escala

Samsung SDS está ampliamente asociado con operar y modernizar TI empresarial compleja: los sistemas que mantienen funcionando a grandes organizaciones día tras día. En lugar de enfocarse en una sola app o línea de producto, su trabajo está más cerca de la «fontanería» de la empresa —plataformas, integración, operaciones y los servicios que hacen que los flujos de trabajo críticos sean confiables.

En la práctica, esto suele abarcar varias categorías que muchas grandes compañías necesitan simultáneamente:

- Servicios de nube e infraestructura: construir, migrar y operar entornos híbridos; fundamentos estándar de cómputo, almacenamiento y red.

- Servicios de seguridad: gestión de identidad y acceso, monitorización, gestión de vulnerabilidades y operaciones de seguridad que deben correr continuamente.

- Plataformas de datos y analítica: pipelines, controles de calidad de datos, gobernanza y sistemas que convierten actividad cruda en reportes confiables.

- Soporte ERP y logística: el núcleo operativo —compras, inventario, envíos, finanzas— donde minutos de inactividad pueden bloquear trabajo real.

- Operaciones gestionadas (gestión de servicios TI): monitorización 24/7, respuesta a incidentes, coordinación de cambios y mejora continua del servicio.

Por qué «escala» es diferente en conglomerados y ecosistemas de socios

Escala no es solo volumen de tráfico. Dentro de conglomerados y grandes redes de socios, la escala es sobre amplitud: muchas unidades de negocio, distintos regímenes de cumplimiento, múltiples geografías y una mezcla de servicios cloud modernos junto a sistemas legados que siguen siendo relevantes.

Esa amplitud crea una realidad operativa distinta:

- Sirves a muchos clientes internos con prioridades conflictivas.

- Te integras con proveedores, subsidiarias y socios, no solo con equipos internos.

- Debes soportar flujos de trabajo de larga duración (facturación, cumplimiento, nómina) donde la fiabilidad «suficiente» rara vez es aceptable.

La restricción clave: sistemas compartidos alimentan flujos críticos

La restricción más dura es el acoplamiento de dependencias. Cuando las plataformas centrales son compartidas —identidad, red, pipelines de datos, ERP, middleware de integración— los pequeños problemas pueden propagarse. Un servicio de autenticación lento puede parecer «la app caída». Un retraso en un pipeline de datos puede paralizar reportes, previsiones o envíos regulatorios.

Por eso los proveedores empresariales como Samsung SDS suelen ser juzgados menos por características y más por resultados: qué tan consistentemente los sistemas compartidos mantienen miles de flujos de trabajo downstream en ejecución.

Los ecosistemas amplifican el riesgo: dependencias compartidas y radio de explosión

Las plataformas empresariales rara vez fallan de forma aislada. En un ecosistema al estilo Samsung SDS, una «pequeña» caída en un servicio puede propagarse a proveedores, socios logísticos, unidades internas y canales al cliente —porque todos dependen del mismo conjunto de dependencias compartidas.

Las dependencias compartidas que todos olvidan

La mayoría de los recorridos empresariales atraviesan una cadena familiar de componentes del ecosistema:

- Identidad y acceso: SSO, federación, proveedores MFA, roles y derechos compartidos.

- Red y conectividad: VPNs, enlaces privados, DNS, gateways, WAF/CDN, reglas de enrutamiento de socios.

- Intercambio de datos: datos maestros compartidos, códigos de referencia, brokers de mensajes, servicios de transferencia de archivos.

- Facturación y derechos: comprobaciones de suscripción, generación de facturas, límites de crédito, medición de uso.

- Servicios de cumplimiento y auditoría: logging, retención, gestión de claves de cifrado y reportes regulatorios.

Cuando cualquiera de estos se degrada, puede bloquear múltiples «caminos felices» a la vez —checkout, creación de envíos, devoluciones, facturación o incorporación de socios.

Las decisiones de integración moldean el radio de explosión

Los ecosistemas se integran por distintos «tubos», cada uno con su propio patrón de fallas:

- APIs (tiempo real): sensibles a latencia, throttling y compatibilidad hacia atrás.

- EDI (intercambio estandarizado entre socios): mappings frágiles y expectativas de esquema estrictas.

- Lotes (transferencias programadas): fallas silenciosas que aparecen horas después como diferencias de conciliación.

- Streams de eventos (casi en tiempo real): replays, ordering y lag de consumidores que pueden amplificar defectos.

Un riesgo clave es la falla correlacionada: múltiples socios dependen del mismo endpoint, del mismo proveedor de identidad o del mismo conjunto de datos compartidos —así que una falla se convierte en muchos incidentes.

Modos de falla únicos en ecosistemas

Los ecosistemas introducen problemas que no ves en sistemas de una sola compañía:

- Desajustes de versión entre productor y consumidor (deriva de esquema API/EDI).

- Límites contractuales (rate limits, tamaño de payload, supuestos de timeout) que se exceden en picos.

- Identidades compartidas donde un problema de directorio bloquea a múltiples organizaciones.

- Propiedad ambigua: «no es nuestro sistema» retrasa la triage mientras la falla se expande.

Reducir el radio de explosión empieza por mapear explícitamente dependencias y viajes de socios, y luego diseñar integraciones que degraden de forma controlada en lugar de fallar todas a la vez (ver también /blog/reliability-targets-slos-error-budgets).

La estandarización solo ayuda si hace a los equipos más rápidos. En ecosistemas empresariales grandes, los fundamentos de la plataforma triunfan cuando eliminan decisiones repetidas (y errores repetidos) al mismo tiempo que dejan espacio a los equipos de producto para lanzar.

Una manera práctica de pensar la plataforma es por capas claras, cada una con un contrato distinto:

- Capa de infraestructura: cómputo, almacenamiento, red, primitivas de identidad y endurecimiento base.

- Capa de runtime: runtimes Kubernetes/VM, registro de contenedores, runners de CI/CD y gestión de configuración.

- Capa de servicios compartidos: logging/métricas, secretos, API gateway, mensajería, descubrimiento de servicios, feature flags.

- Plataformas de negocio: capacidades de dominio reutilizables —datos de cliente, facturación, procesamiento de documentos, integración ERP— expuestas mediante APIs estables.

Esta separación mantiene requisitos «nivel empresa» (seguridad, disponibilidad, auditabilidad) incorporados en la plataforma en lugar de ser reimplementados por cada aplicación.

Caminos dorados: carreteras pavimentadas, no reglas estrictas

Los golden paths son plantillas y flujos aprobados que hacen que la opción segura y fiable sea la más fácil: un esqueleto de servicio estándar, pipelines preconfigurados, dashboards por defecto y stacks conocidos-buenos. Los equipos pueden desviarse cuando sea necesario, pero lo hacen de forma intencional, con propiedad explícita de la complejidad adicional.

Un patrón creciente es tratar estos golden paths como kits de inicio productizados —incluyendo scaffolding, creación de entornos y valores por defecto para el «día 2» (health checks, dashboards, reglas de alerta). En plataformas como Koder.ai, los equipos pueden ir un paso más allá generando una app funcional mediante un flujo de trabajo conversacional, y luego usar planning mode, snapshots y rollback para mantener los cambios reversibles sin perder velocidad. El punto no es la marca de la herramienta: es hacer que el camino fiable tenga la menor fricción.

Multi-tenant vs dedicado: elegir el aislamiento correcto

Las plataformas multi-tenant reducen coste y aceleran la incorporación, pero requieren guardrails fuertes (cuotas, controles contra vecinos ruidosos, límites claros de datos). Los entornos dedicados cuestan más, pero pueden simplificar cumplimiento, aislamiento de rendimiento y ventanas de cambio específicas por cliente.

Reducir la carga cognitiva para los equipos de aplicación

Buenas decisiones de plataforma reducen la superficie de decisiones diarias: menos conversaciones como «¿qué librería de logging?», «¿cómo rotamos secretos?», «¿cuál es el patrón de despliegue?». Los equipos se concentran en la lógica de negocio mientras la plataforma hace cumplir la consistencia silenciosamente —y así la estandarización aumenta la velocidad de entrega en lugar de frenarla.

Objetivos de fiabilidad: SLOs, presupuestos de error y resultados de negocio

Los proveedores de TI empresariales no «hacen fiabilidad» como algo opcional: la fiabilidad es parte de lo que los clientes compran. La forma práctica de materializarlo es traducir expectativas en objetivos medibles que todos puedan entender y gestionar.

SLOs y SLIs en lenguaje llano

Un SLI (Service Level Indicator) es una métrica (por ejemplo: «porcentaje de transacciones de checkout que tuvieron éxito»). Un SLO (Service Level Objective) es el objetivo para esa métrica (por ejemplo: «99.9% de transacciones de checkout exitosas cada mes»).

Por qué importa: contratos y operaciones del negocio dependen de definiciones claras. Sin ellas, los equipos discuten tras un incidente sobre qué era «bueno». Con ellas, puedes alinear entrega de servicios, soporte y dependencias de socios alrededor del mismo marcador.

Elige indicadores que coincidan con el riesgo del negocio

No todos los servicios deben juzgarse solo por uptime. Objetivos relevantes para empresas incluyen:

- Disponibilidad: ¿Pueden los usuarios iniciar y completar un proceso de negocio?

- Latencia: ¿Es lo suficientemente rápido para cumplir expectativas de cliente y productividad interna?

- Corrección de datos: ¿Son precisos y consistentes los reportes, facturas, inventarios o decisiones de identidad?

Para plataformas de datos, «99.9% de uptime» aún puede significar un mes fallido si conjuntos de datos clave llegan tarde, incompletos o erróneos. Elegir indicadores correctos evita confianza falsa.

Presupuestos de error: equilibrar cambio y estabilidad

Un presupuesto de error es la cantidad permitida de «mala calidad» (tiempo de inactividad, solicitudes fallidas, pipelines retrasados) implícita en el SLO. Lo convierte en una herramienta de decisión:

- Si estás dentro del presupuesto, puedes lanzar cambios más rápido.

- Si quemas presupuesto demasiado rápido, frenas, arreglas problemas sistémicos y endureces prácticas de cambio.

Esto ayuda a proveedores empresariales a equilibrar compromisos de entrega con expectativas de uptime —sin depender de opiniones o jerarquía.

Cadencia de reporte y audiencia

El reporting efectivo se adapta:

- Ingenieros (diario/semanal): tendencias de SLI, principales contribuyentes al burn, arreglos accionables.

- Ejecutivos (mensual/trimestral): impacto al negocio, panorama de riesgo, necesidades de inversión.

- Socios (según acuerdo): SLOs compartidos, rendimiento de dependencias, preparación de escalamiento.

La meta no es más dashboards: es visibilidad consistente y alineada a contratos sobre si los resultados de fiabilidad soportan el negocio.

Observabilidad y respuesta a incidentes a escala empresarial

Configura starters de 'golden path'

Convierte tus stacks y valores predeterminados en starters reutilizables que tus equipos puedan usar.

Cuando el uptime forma parte de lo que los clientes compran, la observabilidad no puede ser un pensamiento tardío o un proyecto de «equipo de herramientas». A escala empresarial —especialmente en ecosistemas con socios y plataformas compartidas— una buena respuesta a incidentes empieza con ver el sistema tal como lo experimentan los operadores: de extremo a extremo.

Lo básico que realmente necesitas

Los equipos de alto rendimiento tratan logs, métricas, traces y comprobaciones sintéticas como un sistema coherente:

- Métricas te dicen qué cambió (latencia, tasa de error, saturación).

- Logs te dicen qué pasó (contexto, IDs, puntos de decisión).

- Traces te dicen dónde se rompió a través de servicios.

- Comprobaciones sintéticas te dicen qué siente el usuario (podemos iniciar sesión, pagar, sincronizar datos?).

La meta es respuestas rápidas a: «¿Está afectando a usuarios?», «¿Qué tan grande es el radio de explosión?» y «¿Qué cambió recientemente?».

Alertas accionables (y menos páginas ruidosas)

Los entornos empresariales generan señales infinitas. La diferencia entre alertas utilizables y no utilizables es si las alertas están ligadas a síntomas visibles por clientes y umbrales claros. Prefiere alertas sobre indicadores estilo SLO (tasa de error, latencia p95) en lugar de contadores internos. Cada page debe incluir: servicio afectado, impacto probable, principales dependencias y un primer paso diagnóstico.

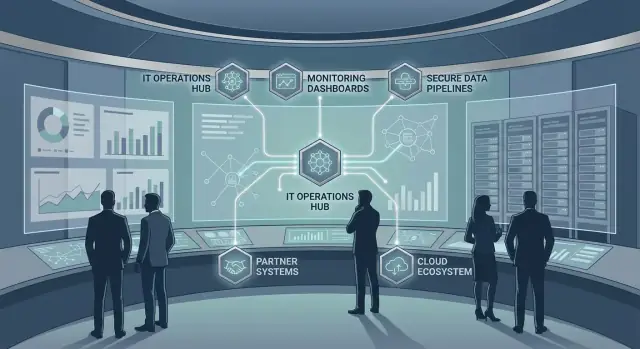

Mapas de servicio a través de fronteras de socios

Los ecosistemas fallan en las uniones. Mantén mapas de servicio que muestren dependencias —plataformas internas, proveedores, proveedores de identidad, redes— y hazlos visibles en dashboards y canales de incidentes. Aunque la telemetría de socios sea limitada, puedes modelar dependencias usando checks sintéticos, métricas de borde e IDs de petición compartidos.

Runbooks y on-call: automatizar vs documentar

Automatiza acciones repetitivas que reducen el tiempo para mitigar (rollback, desactivar feature flag, cambiar tráfico). Documenta decisiones que requieren juicio (comunicaciones a clientes, rutas de escalamiento, coordinación con socios). Un buen runbook es corto, probado en incidentes reales y actualizado como parte del seguimiento post‑incidente —no archivado en un cajón.

Control de cambios que protege el uptime mientras permite velocidad

Entornos empresariales soportados por Samsung SDS no pueden elegir entre «seguro» y «rápido». El truco es hacer del control de cambios un sistema predecible: los cambios de bajo riesgo fluyen rápido, mientras que los de alto riesgo reciben el escrutinio que merecen.

Moverse rápido con releases más pequeñas y reversibles

Los despliegues de gran alcance crean fallas de gran alcance. Los equipos mantienen alta fiabilidad lanzando en porciones pequeñas y reduciendo el número de cosas que pueden fallar a la vez.

Los feature flags separan «desplegar» de «activar», de modo que el código puede llegar a producción sin afectar inmediatamente a usuarios. Los despliegues canary (liberar a un subconjunto pequeño primero) dan una alerta temprana antes de que un cambio alcance a cada unidad de negocio, integración de socio o región.

Gobernanza que satisface a los auditores sin bloquear equipos

La gobernanza de releases no es solo papeleo: es cómo las empresas protegen servicios críticos y demuestran control.

Un modelo práctico incluye:

- Reglas claras de aprobación basadas en riesgo (rutinario vs de alto impacto)

- Segregación de funciones (quien escribe el cambio no es el único que lo aprueba)

- Pistas de auditoría automáticas desde la pipeline CI/CD y tickets ITSM

La meta es hacer que el «camino correcto» sea el más sencillo: aprobaciones y evidencias se capturan como parte de la entrega normal, no se ensamblan después.

Ventanas de cambio, periodos de bloqueo y calendarios de negocio

Los ecosistemas tienen puntos de estrés previsibles: cierre financiero de fin de mes, eventos minoristas pico, inscripción anual o grandes cutovers de socios. Las ventanas de cambio alinean despliegues con esos ciclos.

Los periodos de blackout deben ser explícitos y publicados, para que los equipos planifiquen con antelación en lugar de apresurar trabajo arriesgado el último día antes de un congelamiento.

No todos los cambios se pueden revertir limpiamente —especialmente cambios de esquema o integraciones entre compañías. Un control de cambios sólido requiere decidir de antemano:

- Ruta de rollback (cómo volver rápidamente a la versión anterior)

- Plan de «fail-forward» (cómo parchear de forma segura cuando rollback no es posible)

Cuando los equipos definen estas rutas, los incidentes se convierten en correcciones controladas en lugar de improvisaciones prolongadas.

Ingeniería de resiliencia: diseñar para fallar y recuperarse

Pon tu piloto en un dominio

Usa un dominio personalizado para compartir el piloto con las partes interesadas y probar flujos de trabajo reales.

La ingeniería de resiliencia parte de una suposición simple: algo fallará —una API upstream, un segmento de red, un nodo de BD o una dependencia de terceros que no controlas. En ecosistemas empresariales (donde operan proveedores tipo Samsung SDS), la meta no es «no tener fallos», sino fallos controlados con recuperación predecible.

Patrones de resiliencia que reducen el impacto al cliente

Algunos patrones rinden consistentemente a escala:

- Redundancia: múltiples instancias, zonas o regiones para que una falla no detenga el servicio.

- Load shedding: cuando la capacidad se excede, rechazar o aplazar trabajo no crítico (p. ej., informes en background) para mantener flujos críticos (pagos, captura de pedidos) vivos.

- Degradación elegante: ofrecer una experiencia más simple cuando las dependencias fallan —datos cacheados, modo solo lectura o funcionalidades limitadas— en lugar de una caída total.

La clave es definir qué viajes de usuario «deben sobrevivir» y diseñar mitigaciones específicas para ellos.

Recuperación ante desastres: elegir RTO/RPO por sistema

La planificación de DR se vuelve práctica cuando cada sistema tiene objetivos explícitos:

- RTO (Recovery Time Objective): cuán rápido debes restaurar el servicio.

- RPO (Recovery Point Objective): cuánta pérdida de datos (en tiempo) es aceptable.

No todo necesita los mismos números. Un servicio de autenticación puede requerir RTO de minutos y RPO casi cero, mientras que una pipeline analítica interna puede tolerar horas. Alinear RTO/RPO con impacto de negocio evita sobrecostes y protege lo crítico.

Replicación y compensaciones de consistencia

Para flujos críticos, las decisiones de replicación importan. La replicación síncrona minimiza pérdida de datos pero puede aumentar latencia o reducir disponibilidad durante problemas de red. La replicación asíncrona mejora rendimiento y uptime pero arriesga perder los últimos writes. Los buenos diseños hacen explícitos estos trade-offs y añaden controles compensatorios (idempotencia, trabajos de conciliación o estados «pendientes» claros).

Probar la recuperación, no solo construirla

La resiliencia solo cuenta si se ejercita:

- Ejercicios de failover para probar runbooks de DR y rutas de acceso

- Game days que simulan fallas de dependencias y sobrecarga

- Drills de caos en ámbitos seguros para validar degradación y reglas de shedding

Hazlos regularmente, mide tiempo de recuperación y alimenta los hallazgos a estándares de plataforma y ownership de servicio.

Seguridad y cumplimiento como requisitos de fiabilidad

Las fallas de seguridad y las brechas de cumplimiento no solo crean riesgo: generan tiempo de inactividad. En ecosistemas empresariales, una cuenta mal configurada, un servidor sin parchear o una pista de auditoría ausente puede desencadenar congelamientos de servicio, cambios de emergencia y outages que afectan a clientes. Tratar seguridad y cumplimiento como parte de la fiabilidad hace que «mantenerse arriba» sea un objetivo compartido.

Identidad y acceso entre organizaciones

Cuando múltiples subsidiarias, socios y proveedores se conectan a los mismos servicios, la identidad se convierte en un control de fiabilidad. SSO y federación reducen la dispersión de contraseñas y ayudan a que los usuarios obtengan acceso sin soluciones peligrosas. Igual de importante es el principio de menor privilegio: el acceso debe ser temporal, basado en roles y revisado regularmente para que una cuenta comprometida no pueda tumbar sistemas centrales.

Operaciones de seguridad que protegen el uptime

Las operaciones de seguridad pueden prevenir incidentes —o crearlos mediante interrupciones no planificadas. Alinea el trabajo de seguridad con la fiabilidad operativa haciéndolo predecible:

- Parches y remediación de vulnerabilidades en una cadencia publicada, con ventanas de mantenimiento claras

- Controles de endpoints probados por impacto de rendimiento antes de un despliegue amplio

- Verificación automatizada (health checks, canary groups) para que actualizaciones no degraden el servicio silenciosamente

Cumplimiento: logging, retención, privacidad y preparación para auditoría

Los requisitos de cumplimiento (retención, privacidad, trazas de auditoría) son más fáciles de cumplir cuando se diseñan en la plataforma. Logging centralizado con campos consistentes, políticas de retención aplicadas y exportaciones controladas por acceso evitan que las auditorías se conviertan en fuegos de última hora —y previenen momentos de «congelar el sistema» que interrumpen la entrega.

Riesgo de cadena de suministro y terceros

Las integraciones con socios amplían capacidad y radio de explosión. Reduce el riesgo de terceros con requisitos contractuales de seguridad, APIs versionadas, reglas claras de manejo de datos y monitorización continua de la salud de dependencias. Si un socio falla, tus sistemas deberían degradarse con gracia en vez de fallar de forma impredecible.

Cuando las empresas hablan de uptime, a menudo piensan en aplicaciones y redes. Pero para muchos flujos del ecosistema —facturación, cumplimiento, riesgo y reporting— la corrección de los datos es igual de crítica operativamente. Un «batch exitoso» que publique un identificador de cliente incorrecto puede provocar horas de incidentes downstream entre socios.

Datos maestro y calidad como superficie de fiabilidad

Los datos maestros (clientes, productos, proveedores) son el punto de referencia de todo lo demás. Tratarlo como una superficie de fiabilidad implica definir qué es «bueno» (completitud, unicidad, oportunidad) y medirlo continuamente.

Un enfoque práctico es rastrear un pequeño conjunto de indicadores de calidad orientados al negocio (por ejemplo, «% de pedidos mapeados a cliente válido») y alertar cuando derivan —antes de que los sistemas downstream fallen.

Pipelines a escala: batch, streaming y reprocesamiento seguro

Los pipelines por lotes son buenos para ventanas de reporting previsibles; el streaming es mejor para operaciones casi en tiempo real. A escala, ambos necesitan guardrails:

- Backpressure para evitar que un consumidor sobrecargado cree retrasos silenciosos a lo largo de la cadena

- Writes idempotentes e identificadores de ejecución claros para que el reprocesamiento no duplique registros

- Capacidad de replay para recuperar errores upstream sin arreglos manuales y riesgosos

Gobernanza: linaje, catálogo y stewardship

La confianza aumenta cuando los equipos pueden responder tres preguntas rápidamente: ¿De dónde vino este campo? ¿Quién lo usa? ¿Quién aprueba cambios?

Linaje y catalogación no son «proyectos de documentación»: son herramientas operativas. Combínalas con stewardship claro: dueños nombrados para datasets críticos, políticas de acceso definidas y revisiones ligeras para cambios de alto impacto.

Prevenir problemas de datos en el ecosistema con contratos

Los ecosistemas fallan en los bordes. Reduce incidentes relacionados con socios con contratos de datos: esquemas versionados, reglas de validación y expectativas de compatibilidad. Valida en ingestión, pone en cuarentena registros malos y publica retroalimentación de errores clara para que los problemas se corrijan en la fuente en lugar de parchearse downstream.

Organización y gobernanza: quién posee la fiabilidad de extremo a extremo

Inicia un piloto de fiabilidad

Pon en marcha 3 a 5 servicios rápidamente para validar SLOs, alertas y runbooks de incidentes.

La fiabilidad a escala empresarial suele fallar en las grietas: entre equipos, entre proveedores y entre «ejecutar» y «construir». La gobernanza no es burocracia por sí misma: es cómo haces explícita la propiedad para que los incidentes no se conviertan en debates de horas sobre quién debe actuar.

Elegir un modelo operativo (y ser honestos con los trade-offs)

Hay dos modelos comunes:

- Operaciones centralizadas: un equipo compartido opera muchos servicios. Esto puede estandarizar herramientas y prácticas rápidamente, pero corre el riesgo de crear una fábrica de tickets y ralentizar a los equipos de producto.

- Equipos alineados por producto: equipos que poseen servicios de extremo a extremo (construir + operar). Mejora la rendición de cuentas y el aprendizaje, pero requiere fuerte soporte de plataforma y expectativas consistentes.

Muchas empresas optan por un híbrido: equipos de plataforma proveen carreteras pavimentadas, mientras los equipos de producto poseen la fiabilidad de lo que entregan.

Catálogos de servicio y límites claros

Una organización confiable publica un catálogo de servicios que responde: ¿Quién es dueño de este servicio? ¿Cuáles son las horas de soporte? ¿Qué dependencias son críticas? ¿Cuál es la ruta de escalamiento?

Igualmente importantes son los límites de propiedad: qué equipo posee la base de datos, el middleware de integración, la identidad, las reglas de red y la monitorización. Cuando los límites son confusos, los incidentes se vuelven problemas de coordinación en vez de problemas técnicos.

Gestionar proveedores y socios como dependencias de primera clase

En entornos con muchos ecosistemas, la fiabilidad depende de contratos. Usa SLAs para compromisos hacia clientes, OLAs para handoffs internos y contratos de integración que especifiquen versionado, límites de tasa, ventanas de cambio y expectativas de rollback —para que los socios no puedan romperte sin querer.

Bucles de mejora continua

La gobernanza debe forzar el aprendizaje:

- Postmortems sin culpas con acciones rastreadas

- Gestión de problemas para eliminar causas recurrentes

- Planificación de capacidad ligada a eventos de negocio (picos, lanzamientos, migraciones)

Hecho correctamente, la gobernanza convierte la fiabilidad de «tarea de todos» en un sistema medible y con dueño.

Qué copiar para tu empresa: un plan pragmático de inicio

No necesitas «convertirte en Samsung SDS» para beneficiarte de los mismos principios operativos. La meta es convertir la fiabilidad en una capacidad gestionada: visible, medida y mejorada en pasos pequeños y repetibles.

1) Mapea lo que realmente ejecutas (y lo que depende de ello)

Empieza con un inventario de servicios que sea útil la próxima semana, no perfecto.

- Lista tus 20–50 servicios críticos para el negocio (portales de clientes, pipelines de datos, identidad, integraciones, jobs por lotes).

- Para cada servicio, registra: propietario, usuarios, horas pico, dependencias clave (BD, APIs, red, proveedores) y modos de falla conocidos.

- Crea un mapa de dependencias que destaque componentes compartidos con alto “radio de explosión” (SSO, colas de mensajes, almacenes de datos centrales).

Esto será la columna vertebral para priorización, respuesta a incidentes y control de cambios.

2) Elige unos pocos SLOs que el negocio reconozca

Selecciona 2–4 SLOs de alto impacto en distintas áreas de riesgo (disponibilidad, latencia, frescura, corrección). Ejemplos:

- «Checkout API: 99.9% de solicitudes exitosas por cada 30 días»

- «Inicio de sesión de empleado: p95 < 1s durante horas laborables»

- «Feed financiero diario: entregado antes de 07:00 con <0.1% de registros faltantes»

Rastrea presupuestos de error y úsalos para decidir cuándo pausar trabajo de nuevas funcionalidades, reducir volumen de cambios o invertir en correcciones.

3) Mejora la observabilidad antes de comprar más herramientas

La proliferación de herramientas a menudo oculta brechas básicas. Primero, estandariza qué significa «buena visibilidad»:

- Dashboards consistentes ligados a SLOs

- Alertas que solo alarman a humanos por problemas que afectan a usuarios

- Un conjunto mínimo de runbooks para los principales escenarios de falla

Si no puedes responder «qué se rompió, dónde y quién lo posee» en minutos, añade claridad antes de sumar proveedores.

4) Estandariza patrones de integración (especialmente para socios)

Los ecosistemas fallan en los bordes. Publica guías para socios que reduzcan la variabilidad:

- Patrones API aprobados (timeouts, reintentos, idempotencia)

- Reglas de versionado y deprecación

- Límites de tasa y comportamientos de fallback seguros

- Checklist de onboarding y contactos de escalamiento para incidentes

Trata los estándares de integración como un producto: documentado, revisado y actualizado.

Próximos pasos

Ejecuta un piloto de 30 días en 3–5 servicios y luego expande. Para más plantillas y ejemplos, ve a /blog.

Si modernizas cómo los equipos construyen y operan servicios, ayuda estandarizar no solo runtime y observabilidad, sino también el flujo de creación. Plataformas como Koder.ai (una plataforma conversacional de “vibe-coding”) pueden acelerar la entrega mientras mantienen controles empresariales —p. ej., usando planning mode antes de generar cambios y confiando en snapshots/rollback al experimentar. Si evalúas soporte gestionado o ayuda de plataforma, empieza con restricciones y resultados en /pricing (sin promesas: solo una forma de enmarcar opciones).