03 may 2025·8 min

Cómo la generación automática de pruebas complementa la lógica escrita por IA

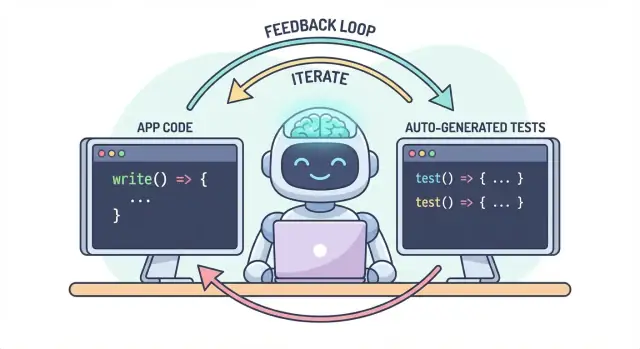

Descubre por qué las pruebas generadas automáticamente se complementan de forma natural con la lógica escrita por IA y cómo crear un flujo donde código, pruebas y comprobaciones de CI mejoren juntos.

Por qué el código generado por IA y las pruebas autogeneradas van juntas

La lógica de aplicación escrita por IA significa que las partes “funcionales” de tu base de código se redactan con ayuda de un asistente: nuevas funciones, pequeñas características, refactors, manejo de casos borde e incluso reescrituras de módulos existentes. Tú sigues decidiendo qué construir, pero la primera versión de la implementación suele llegar más rápido —y a veces con suposiciones que no notarás hasta más tarde.

La generación automática de pruebas es la capacidad complementaria en el lado de la verificación. En lugar de escribir cada prueba a mano, las herramientas pueden proponer casos de prueba y aserciones basadas en tu código, una especificación o patrones aprendidos de errores previos. En la práctica, esto puede ser algo como:

- “Dada esta firma de función y sus ramas, aquí hay pruebas que cubren entradas típicas, límites y rutas de error.”

- “Aquí hay pruebas de regresión que reproducen el fallo que vimos en producción.”

La expectativa clave: las pruebas generadas no son automáticamente “buenas”

Una prueba generada puede inducir a error: puede afirmar el comportamiento actual aunque ese comportamiento sea incorrecto, o puede pasar por alto reglas del producto que viven en la cabeza de las personas y en los comentarios de los tickets. Por eso la revisión humana importa. Alguien debe confirmar que el nombre de la prueba, la preparación y las aserciones reflejan la intención real —no solo lo que el código hace hoy.

Un flujo de trabajo, dos salidas

La idea central es simple: código y pruebas deberían evolucionar juntos como un solo flujo. Si la IA te ayuda a cambiar la lógica rápidamente, la generación automática de pruebas te ayuda a fijar el comportamiento esperado con la misma rapidez —así el siguiente cambio (humano o IA) tiene una definición ejecutable clara de “sigue siendo correcto”.

En la práctica, este enfoque de “salida emparejada” es más fácil de mantener cuando tu flujo de desarrollo ya se basa en chat. Por ejemplo, en Koder.ai (una plataforma vibe-coding para construir apps web, backend y móviles vía chat), es natural tratar “característica + pruebas” como un único entregable: describes el comportamiento, generas la implementación y luego generas y revisas las pruebas en el mismo bucle conversacional antes de desplegar.

El problema: programar más rápido puede significar equivocarse más rápido

El código escrito por IA puede sentirse como un superpoder: las funciones aparecen rápido, el boilerplate desaparece y los refactors que antes tomaban horas pueden hacerse antes de que se enfríe tu café. La pega es que la velocidad cambia la forma del riesgo. Cuando es más fácil producir código, también es más fácil introducir errores—a veces sutiles.

Modos comunes de fallo en la lógica escrita por IA

Los asistentes de IA son buenos generando implementaciones “razonables”, pero razonable no es lo mismo que correcto para tu dominio específico.

Los casos límite son las primeras víctimas. La lógica generada por IA suele manejar bien la ruta feliz y luego tropieza con condiciones de frontera: entradas vacías, problemas de zona horaria, redondeos, valores nulos, comportamiento de reintento o estados “esto nunca debería ocurrir” que ocurren en producción.

Las suposiciones equivocadas son otro problema frecuente. Un asistente puede inferir requisitos que no se indicaron (“los usuarios siempre están autenticados”, “los IDs son numéricos”, “este campo siempre está presente”), o puede implementar un patrón familiar que no coincide con las reglas de tu sistema.

Las regresiones silenciosas suelen ser las más costosas. Pides un cambio pequeño, el asistente reescribe un trozo de lógica y algo no relacionado se rompe —sin errores evidentes. El código aún compila, la UI carga, pero ahora una regla de precios, una comprobación de permisos o una conversión de datos está ligeramente mal.

Por qué las pruebas manuales no escalan con el código más rápido

Cuando los cambios de código se aceleran, las pruebas manuales se convierten en un cuello de botella y en una apuesta. O bien pasas más tiempo clicando (ralentizando la entrega) o pruebas menos (aumentando las fugas). Incluso los equipos de QA disciplinados no pueden cubrir manualmente todas las variantes cuando los cambios son frecuentes y de gran alcance.

Peor aún, las comprobaciones manuales son difíciles de repetir de forma consistente. Viven en la memoria de alguien o en una lista de verificación, y son fáciles de saltar cuando se aprietan los plazos—justo cuando el riesgo es mayor.

Las pruebas como red de seguridad y herramienta de comunicación

Las pruebas automatizadas crean una red de seguridad durable: convierten las expectativas en ejecutable. Una buena prueba dice: “Dadas estas entradas y este contexto, este es el resultado en el que confiamos.” Eso no es solo verificación; es comunicación para tu yo futuro, compañeros y hasta la propia IA.

Cuando existen pruebas, los cambios dan menos miedo porque la retroalimentación es inmediata. En lugar de descubrir problemas durante la revisión de código, en staging o por clientes, los encuentras minutos después del cambio.

Detectar problemas antes para reducir retrabajo

Cuanto antes se detecte un bug, más barato es arreglarlo. Las pruebas acortan el bucle de retroalimentación: sacan a la luz suposiciones desajustadas y casos límite omitidos mientras la intención aún está fresca. Eso reduce retrabajos, evita parches “fix-forward” y evita que la velocidad de la IA se convierta en churn impulsado por IA.

Cómo las pruebas crean un bucle de retroalimentación para la lógica escrita por IA

El código escrito por IA es más rápido cuando lo tratas como una conversación, no como una entrega única. Las pruebas son lo que hacen medible esa conversación.

El bucle “spec → code → tests” (en lenguaje sencillo)

-

Spec: Describes qué debe pasar (entradas, salidas, casos límite).

-

Code: La IA escribe la implementación que afirma coincidir con esa descripción.

-

Tests: Tú (o la IA) generas comprobaciones que prueban que el comportamiento es realmente cierto.

Repite este bucle y no solo producirás más código—estarás apretando continuamente la definición de “hecho”.

Las pruebas obligan a requisitos e interfaces más claros

Un requisito vago como “manejar usuarios inválidos de forma elegante” es fácil de pasar por alto en el código. Una prueba no puede ser vaga. Obliga a especificar:

- ¿Qué cuenta como “inválido”? ¿ID ausente, estado baneado, email malformado?

- ¿Qué significa “de forma elegante”? ¿Mensaje de error, código de estado, valor de reserva?

- ¿Cuál es la interfaz? Firma de función, forma de retorno, excepciones?

En cuanto intentas expresar esos detalles en una prueba, las partes poco claras salen a la luz de inmediato. Esa claridad mejora el prompt que das a la IA y a menudo conduce a interfaces más simples y estables.

Las pruebas generadas validan lo que el código afirma

El código de IA puede parecer correcto mientras oculta suposiciones. Las pruebas generadas son una manera práctica de verificar las afirmaciones que hace el código:

- “Esta función es pura” → prueba que no haya efectos externos.

- “Maneja casos límite” → prueba nulos, listas vacías, valores límite.

- “Compatible hacia atrás” → prueba entradas antiguas y salidas esperadas.

El objetivo no es confiar ciegamente en las pruebas generadas; es usarlas como escepticismo estructurado y rápido.

Las pruebas que fallan se convierten en el siguiente prompt

Una prueba que falla es retroalimentación accionable: señala una discrepancia específica entre la especificación y la implementación. En lugar de pedir a la IA “arréglalo”, puedes pegar el fallo y decir: “Actualiza el código para que esta prueba pase sin cambiar la API pública.” Eso convierte la depuración en una iteración enfocada en lugar de un juego de adivinanzas.

Dónde encaja la generación automática de pruebas en tu pirámide de pruebas

La generación automática de pruebas es más útil cuando apoya tu estrategia de pruebas existente —especialmente la clásica “pirámide de pruebas”. La pirámide no es una regla por sí sola; es una forma de mantener la retroalimentación rápida y confiable mientras sigues capturando fallos del mundo real.

La IA puede ayudarte a crear pruebas en cada capa, pero obtendrás mejores resultados cuando generes más de las pruebas baratas (base de la pirámide) y menos de las caras (cima). Ese equilibrio mantiene rápido tu pipeline de CI y protege la experiencia del usuario.

Pruebas unitarias: rápidas, focalizadas y muy generables

Las pruebas unitarias son comprobaciones pequeñas para funciones, métodos o módulos individuales. Se ejecutan rápido, no necesitan sistemas externos y son ideales para generar cobertura de casos límite con IA.

Un buen uso aquí es:

- Ejercitar la validación de entradas y valores límite “raros”

- Validar reglas de negocio (descuentos, permisos, transiciones de estado)

- Fijar correcciones de bugs con pruebas de regresión que son fáciles de olvidar

Dado que las pruebas unitarias tienen un alcance estrecho, son más fáciles de revisar y menos propensas a volverse frágiles.

Pruebas de integración: menos, pero de alto valor

Las pruebas de integración validan cómo las piezas funcionan juntas: tu API con la base de datos, un servicio llamando a otro, procesamiento de colas, autenticación, etc.

Las pruebas de integración generadas por IA pueden ser valiosas, pero requieren más disciplina:

- Configuración/limpieza clara para que las pruebas no filtren datos

- Entornos de prueba estables (contenedores, bases de datos de prueba, mocks cuando corresponda)

- Aserciones que se centren en resultados, no en detalles de implementación internos

Piensa en estas como comprobaciones de contrato que prueban que las costuras entre componentes siguen firmes.

Pruebas end-to-end: generar con moderación

Las pruebas E2E validan los flujos clave del usuario. También son las más caras: más lentas, más frágiles y más difíciles de depurar.

La generación automática de pruebas puede ayudar a redactar escenarios E2E, pero debes curarlos con rigor. Mantén un conjunto pequeño de caminos críticos (registro, checkout, flujo central) y evita intentar generar E2E para cada característica.

La recomendación práctica: generar una mezcla equilibrada

No busques generar todo. En su lugar:

- Genera muchas pruebas unitarias para mantener honesta la lógica escrita por IA a nivel de función

- Añade pruebas de integración dirigidas para proteger las costuras de mayor riesgo (BD, auth, pagos)

- Mantén una suite E2E mínima para los pocos recorridos de usuario que no puedes permitir que se rompan

Este enfoque mantiene la pirámide intacta—y convierte la generación automática de pruebas en un multiplicador de fuerza en lugar de una fuente de ruido.

Qué se puede generar: desde código, especificaciones y errores reales

La generación automática de pruebas no se limita a “escribe pruebas unitarias para esta función.” Los generadores más útiles tiran de tres fuentes: el código que tienes, la intención detrás y los fallos que ya has visto.

1) Desde la estructura del código: ejercitar comportamiento, no solo líneas

Dado una función o módulo, las herramientas pueden inferir casos de prueba a partir de entradas/salidas, ramas y rutas de excepción. Eso suele significar:

- Entradas de “ruta feliz” que deben producir un resultado conocido

- Valores límite (strings vacíos, cero, longitudes máximas)

- Cobertura de ramas (if/else)

- Manejo de errores (entradas inválidas, campos faltantes, timeouts)

Este estilo es ideal para rodear rápidamente la lógica escrita por IA con comprobaciones que confirmen lo que realmente hace hoy.

2) Desde requisitos: convertir la intención en ejemplos ejecutables

Si tienes criterios de aceptación, historias de usuario o tablas de ejemplo, los generadores pueden convertirlos en pruebas que se lean como la especificación. Esto suele tener más valor que las pruebas derivadas del código porque fija “lo que debe pasar”, no “lo que pasa ahora”.

Un patrón práctico: proporciona unos pocos ejemplos concretos (entradas + resultados esperados) y pide al generador que añada casos límite consistentes con esas reglas.

3) Desde informes de errores: reproducir primero, luego prevenir

La generación basada en bugs es la forma más rápida de construir una suite de regresión significativa. Alimenta los pasos para reproducir (o logs y una carga mínima) y genera:

- una prueba que falle con el comportamiento actual buggy, luego

- la misma prueba pasando una vez arreglado—protegiendo para siempre contra su reintroducción.

Pruebas snapshot/golden: útiles, con advertencia

Las pruebas snapshot pueden ser eficientes para salidas estables (UI renderizada, respuestas serializadas). Úsalas con cuidado: snapshots grandes pueden “aprobar” errores sutiles. Prefiere snapshots pequeños y focalizados y combínalos con aserciones sobre campos clave que deben ser correctos.

Elegir qué probar primero (sin hervir el océano)

Protege la lógica de la interfaz desde el principio

Publica una aplicación React con comportamiento más claro escribiendo pruebas junto a cada cambio.

La generación automática de pruebas es más efectiva cuando le das prioridades claras. Si la apuntas a todo el código y pides “todas las pruebas”, obtendrás ruido: muchas comprobaciones de bajo valor, cobertura duplicada y pruebas frágiles que ralentizan la entrega.

Comienza donde al negocio le dolería

Empieza por los flujos que serían más caros de romper—financiera, legal o reputacionalmente. Un filtro simple basado en riesgo mantiene el alcance realista y mejora la calidad rápidamente.

Enfócate primero en:

- Caminos críticos para el negocio (registro, checkout, flujos centrales) y áreas que cambian con frecuencia (features activas, refactors, integraciones nuevas).

- Dominios de alto riesgo: pagos, autenticación, integridad de datos, permisos/roles y cualquier cosa que afecte lo que los usuarios pueden ver o hacer.

Para cada flujo elegido, genera pruebas en capas: algunas pruebas unitarias rápidas para la lógica complicada, más una o dos pruebas de integración que confirmen que todo el camino funciona.

“Ruta feliz + principales casos límite” vence a combinaciones exhaustivas

Pide cobertura que coincida con fallos reales, no con permutaciones teóricas. Un buen conjunto inicial es:

- Una prueba de ruta feliz que pruebe el comportamiento esperado.

- Los principales casos límite que realmente te preocupan: entrada faltante/ inválida, tokens expirados, permisos insuficientes, conflictos de concurrencia y estado “vacío”.

Siempre puedes ampliar después según bugs, reportes de incidentes o feedback de usuarios.

Define “hecho” para que siga siendo hecho

Haz la regla explícita: una característica no está completa hasta que existan pruebas. Esa definición de hecho importa aún más con código escrito por IA, porque evita que “entrega rápida” se convierta silenciosamente en “regresiones rápidas”.

Si quieres que esto perdure, conéctalo a tu flujo (por ejemplo, exige pruebas relevantes antes del merge en tu CI) y enlaza la expectativa en la documentación del equipo (p. ej., /engineering/definition-of-done).

Patrones de prompting que producen mejores pruebas

La IA puede generar pruebas rápido, pero la calidad depende mucho de cómo pidas. El objetivo es guiar el modelo hacia pruebas que protejan el comportamiento —no pruebas que meramente ejecuten código.

Pon tu estándar de codificación directamente en el prompt

Comienza fijando la “forma” de las pruebas para que la salida coincida con tu repo.

Incluye:

- Lenguaje + framework de pruebas (p. ej., TypeScript + Jest, Python + pytest)

- Reglas de nomenclatura (p. ej.,

should_<behavior>_when_<condition>) - Ubicación y estructura de archivos (p. ej.,

src/ytests/, o__tests__/) - Convenciones (fixtures, factory helpers, librería de mocks)

Esto evita que el modelo invente patrones que tu equipo no usa.

Proporciona 1–2 ejemplos reales de prueba para imitar

Pega un archivo de prueba existente (o un pequeño extracto) y di explícitamente: “Imita este estilo.” Esto ancla decisiones como cómo arreglas los datos de prueba, cómo nombras variables y si prefieres pruebas basadas en tablas.

Si tu proyecto tiene helpers (p. ej., buildUser() o makeRequest()), incluye esos snippets también para que las pruebas generadas los reutilicen en lugar de reimplementar.

Pide aserciones significativas (no solo “se ejecuta”)

Sé explícito sobre qué es “bueno”:

- Aserta salidas y cambios de estado

- Verifica efectos secundarios (p. ej., escrituras en BD, eventos emitidos)

- Aserta tipos/mensajes de error cuando proceda

Una línea útil para el prompt: “Cada prueba debe contener al menos una aserción sobre comportamiento de negocio (no solo ‘no lanzó excepción’).”

Exige tests negativos y de borde

La mayoría de suites generadas se inclinan hacia la ruta feliz. Contrarresta pidiendo:

- Entradas inválidas y fallos esperados

- Valores límite (strings vacíos, cero, longitud máxima)

- Fallos de permisos/autorización

- Dependencias faltantes (p. ej., respuestas nulas, timeouts)

Un template práctico de prompt

Generate unit tests for <function/module>.

Standards: <language>, <framework>, name tests like <pattern>, place in <path>.

Use these existing patterns: <paste 1 short test example>.

Coverage requirements:

- Happy path

- Boundary cases

- Negative/error cases

Assertions must verify business behavior (outputs, state changes, side effects).

Return only the test file content.

Revisión humana: asegurarse de que las pruebas generadas realmente ayuden

De pruebas en verde al despliegue

Despliega y aloja tu app una vez que las pruebas pasen, sin cambiar tu flujo de trabajo.

La IA puede redactar muchas pruebas rápido, pero no puede ser la juez final de si esas pruebas representan tu intención. Una pasada humana es lo que convierte “pruebas que pasan” en “pruebas que nos protegen.” El objetivo no es criticar el estilo—es confirmar que la suite detectará regresiones significativas sin convertirse en una carga de mantenimiento.

Revisar por corrección y relevancia

Comienza haciéndote dos preguntas:

- ¿La prueba aserta un comportamiento que el producto realmente necesita?

- ¿Estarías contento si esta prueba fallara en un cambio futuro—porque habría marcado un problema real?

Las pruebas generadas a veces fijan comportamientos accidentales (detalles internos actuales) en lugar de la regla pretendida. Si una prueba parece una copia del código más que una descripción del resultado esperado, empújala hacia aserciones de mayor nivel.

Vigila la fragilidad (el silencioso asesino de productividad)

Fuentes comunes de tests frágiles son el sobre-mocking, timestamps codificados y valores aleatorios. Prefiere entradas deterministas y aserciones estables (por ejemplo, asertar una fecha parseada o un rango en vez de un raw Date.now() string). Si una prueba requiere mocks excesivos para pasar, puede estar testeando el cableado en lugar del comportamiento.

Asegúrate de que los fallos ocurran por la razón correcta

Una prueba “pasada” puede ser inútil si seguiría pasando aunque la feature esté rota (falsos positivos). Busca aserciones débiles como “no lanza” o chequear solo que una función fue llamada. Refuérzalas asertando salidas, cambios de estado, errores devueltos o datos persistidos.

Usa una checklist ligera de revisión de código

Una lista simple mantiene las revisiones consistentes:

- Legibilidad: nombres claros, setup mínimo, intención evidente

- Cobertura de intención: casos límite y rutas de error clave incluidos

- Mantenibilidad: evita sobreespecificar internals; mocking mínimo

- Calidad de señal: fallaría por una regresión real, no por refactors inocuos

Trata las pruebas generadas como cualquier otro código: haz merge solo de lo que estarías dispuesto a mantener en seis meses.

Hacer que perdure: comprobaciones de CI que mantengan honesto al código de IA

La IA puede ayudarte a escribir código rápido, pero la ganancia real es mantener ese código correcto con el tiempo. La forma más sencilla de “fijar” la calidad es hacer que las pruebas y comprobaciones se ejecuten automáticamente en cada cambio—para que las regresiones se detecten antes de llegar al usuario.

Un flujo práctico que funciona

Un flujo ligero que muchos equipos adoptan es:

- Generar o editar el código de la feature (asistido por IA o no).

- Generar pruebas para el nuevo comportamiento (y para el bug que acabas de arreglar).

- Ejecutar todo localmente para confirmar que estás en verde.

- Cometer código + pruebas juntos.

Ese último paso importa: el código escrito por IA sin pruebas tiende a desviarse. Con pruebas, estás registrando el comportamiento pretendido de una forma que CI puede hacer cumplir.

CI como la red de seguridad no negociable

Configura tu pipeline de CI para que se ejecute en cada pull request (y idealmente en merges a main). Como mínimo, debe:

- Instalar dependencias en un entorno limpio

- Ejecutar pruebas unitarias/de integración

- Fallar el build ante cualquier prueba fallida

Esto evita sorpresas de “funcionó en mi máquina” y detecta roturas accidentales cuando un compañero (o un prompt de IA posterior) cambia código en otra parte.

Añade algunas puertas de calidad (ligeras)

Las pruebas son esenciales, pero no lo captan todo. Añade puertas pequeñas y rápidas que complementen la generación de pruebas:

- Linting (estilo + errores comunes)

- Comprobaciones de tipos (cuando aplique)

- Formateo (para que los diffs sean legibles)

Mantén estas comprobaciones rápidas—si CI se siente lento o ruidoso, la gente buscará formas de evitarlo.

Planificación de coste y capacidad

Si amplías las ejecuciones de CI porque generas más pruebas, asegúrate de que tu presupuesto acompañe el nuevo ritmo. Si controlas minutos de CI, vale la pena revisar límites y opciones (ver /pricing).

Usar pruebas que fallan para guiar la siguiente iteración con IA

Una forma sorprendentemente efectiva de trabajar con código escrito por IA es tratar las pruebas que fallan como tu “siguiente prompt”. En lugar de pedir al modelo que “mejore la feature”, le das una falla concreta y dejas que esa falla constrinja el cambio.

El flujo: fallo → prompt → arreglo → repetir

- Ejecuta la suite (o CI) y captura un fallo. Copia el nombre de la prueba que falla y el mensaje de aserción/traza relevante.

- Pide a la IA que solucione solo ese fallo. Proporciona el contexto de código mínimo (la prueba que falla y la función/módulo bajo prueba), además de cualquier regla de negocio que pueda estar violando.

- Exige primero una prueba de regresión. Si el fallo viene de un informe de bug o producción, prompta a la IA para añadir o ajustar una prueba que reproduzca el bug antes de cambiar la implementación.

- Aplica el cambio mínimo que haga pasar la prueba. Vuelve a ejecutar las pruebas inmediatamente.

- Pasa al siguiente fallo. Un fallo a la vez mantiene la iteración concentrada y comprensible.

Patrón de prompting: mantenerlo pequeño y verificable

En lugar de:

- “Arregla la lógica de login y actualiza pruebas.”

Usa:

- “Esta prueba falla:

shouldRejectExpiredToken. Aquí está la salida del fallo y el código relevante. Actualiza la implementación para que esta prueba pase sin cambiar comportamiento no relacionado. Si hace falta, añade una prueba de regresión que capture el bug.”

Por qué esto reduce idas y venidas

Las pruebas que fallan eliminan la adivinanza. Definen qué significa “correcto” en forma ejecutable, así que no estás negociando requisitos por chat. También evitas ediciones extensas: cada prompt está acotado a un resultado medible, lo que hace la revisión humana más rápida y facilita detectar cuando la IA “arregló” el síntoma pero rompió otra cosa.

Aquí es donde un flujo estilo agente puede pagar dividendos: un agente se centra en el cambio mínimo del código, otro propone el ajuste mínimo de la prueba y tú revisas el diff. Plataformas como Koder.ai están pensadas para ese tipo de desarrollo iterativo y centrado en chat—haciendo que “pruebas como siguiente prompt” parezca el modo por defecto en lugar de una técnica especial.

Medir el éxito sin perseguir métricas de vanidad

Construye juntos, gana más

Invita a un compañero o recomienda a otros y sigue construyendo más rápido con ciclos de retroalimentación compartidos.

La generación automática de pruebas puede hacer que tu suite crezca de la noche a la mañana—pero “más grande” no es lo mismo que “mejor”. El objetivo es confianza: detectar regresiones temprano, reducir defectos en producción y mantener al equipo en movimiento.

Métricas que reflejan realmente la calidad

Comienza con señales que se mapeen a resultados que te importan:

- Tasa de builds exitosos (en main): si los merges se rompen con frecuencia, las pruebas generadas pueden ser demasiado frágiles o tus prompts están produciendo suposiciones incorrectas.

- Tasa de tests frágiles: controla con qué frecuencia las pruebas fallan y pasan al reejecutarlas. Una tasa frágil creciente es un impuesto sobre la confianza del desarrollador y hará que ignoren fallos.

- Tiempo para detectar regresiones: mide el tiempo desde introducir un bug hasta que una ejecución de CI lo detecta. Las pruebas generadas deberían acortar esa ventana.

Trata la cobertura como una pista, no como un número objetivo

La cobertura puede ser una alarma útil—especialmente para encontrar caminos no testeados—pero es fácil engañarla. Las pruebas generadas pueden inflar la cobertura mientras asertan muy poco (o lo incorrecto). Prefiere indicadores como:

- Aserciones por prueba (verificación somera, no KPI)

- Resultados de mutation testing (si lo usas)

- Si las pruebas fallan cuando rompes deliberadamente el comportamiento

Enfócate en “defectos atrapados antes del lanzamiento”

Si solo rastreas número de pruebas o cobertura, optimizarás por volumen. Rastrea defectos atrapados antes del lanzamiento: bugs hallados en CI, QA o staging que habrían llegado a los usuarios. Cuando la generación automática de pruebas funciona, ese número sube mientras los incidentes en producción bajan.

Programa limpieza para que las ganancias sean reales

Las suites generadas requieren mantenimiento. Pon una tarea recurrente en el calendario para:

- Eliminar pruebas redundantes que no añaden protección única

- Estabilizar o borrar pruebas frágiles

- Consolidar casos solapados en pruebas más claras que revelen intención

El éxito es un CI más calmado, retroalimentación más rápida y menos sorpresas—no un dashboard que luzca impresionante.

Errores comunes y un plan práctico de despliegue

La generación automática de pruebas puede elevar la calidad rápidamente—pero solo si la tratas como una ayuda, no como una autoridad. Las fallas más grandes suelen parecerse entre equipos, y son evitables.

Errores comunes a vigilar

La sobre-dependencia es la trampa clásica: las pruebas generadas pueden crear la ilusión de seguridad mientras pasan por alto los riesgos reales. Si la gente deja de pensar críticamente (“la herramienta escribió las pruebas, así que estamos cubiertos”), cometerás errores más rápido—solo con más checks verdes.

Otro problema frecuente es testear detalles de implementación en lugar del comportamiento. Las herramientas de IA suelen anclarse a nombres de métodos actuales, helpers internos o mensajes de error exactos. Esas pruebas se vuelven frágiles: los refactors las rompen aunque la feature siga funcionando. Prefiere pruebas que describan qué debe pasar, no cómo sucede.

Seguridad y privacidad: no filtrarlo todo

La generación de pruebas a menudo implica copiar código, trazas o logs en un prompt. Eso puede exponer secretos (API keys), datos de clientes o lógica propietaria.

Mantén los prompts y fixtures libres de información sensible:

- Redacta tokens, credenciales y URLs internas.

- Evita pegar logs de producción que puedan contener datos personales.

- Usa ejemplos sintéticos (cuentas falsas, IDs ficticios) para datos de prueba.

- Si debes compartir casos reales, minimiza y anonimizalos.

Si usas una plataforma AI hospedada, aplica la misma disciplina. Incluso cuando la plataforma soporte despliegues modernos y hospedaje por región, tus prompts y fixtures siguen siendo parte de tu postura de seguridad.

Un plan práctico de despliegue (que los equipos realmente siguen)

Comienza pequeño y hazlo rutinario:

- Elige un servicio o módulo con cambios frecuentes.

- Genera pruebas unitarias para los caminos de mayor riesgo (movimiento de dinero, permisos, transformaciones de datos).

- Añade una regla simple de CI: las nuevas features asistidas por IA deben incluir pruebas (ver /blog/ci-checks-for-ai-code).

- Exige una rápida checklist de revisión humana: “¿Esta prueba aserta comportamiento? ¿Fallaría por la razón correcta?”

- Rastrea regresiones prevenidas (no solo cobertura), luego expande a pruebas de integración cuando las unitarias se sientan estables.

La meta no es pruebas al máximo—es retroalimentación fiable que mantenga honesta la lógica escrita por IA.

Preguntas frecuentes

¿Por qué deben usarse juntos el código generado por IA y la generación automática de pruebas?

Porque la IA puede acelerar los cambios en la lógica de la aplicación, también puede aumentar la velocidad de suposiciones incorrectas y regresiones sutiles. Las pruebas generadas proporcionan una forma rápida y ejecutable de consolidar el comportamiento deseado, de modo que los cambios futuros (humanos o de IA) tengan retroalimentación inmediata cuando algo se rompe.

¿Son automáticamente confiables las pruebas generadas por IA?

No. Una prueba generada puede inadvertidamente “bendecir” el comportamiento actual incluso cuando ese comportamiento es incorrecto, o puede pasar por alto reglas de negocio que no están explícitas en el código. Trata las pruebas generadas como borradores y revisa nombres, configuración y aserciones para asegurarte de que reflejen la intención del producto.

¿Cuándo es más útil la generación automática de pruebas?

Úsala cuando necesites cobertura rápida y estructurada alrededor de lógica nueva o modificada —especialmente después de refactors asistidos por IA. Es más efectiva para:

- Casos límite y rutas de error a nivel unitario

- Pruebas de regresión basadas en un informe de fallo real

- Convertir criterios de aceptación en ejemplos ejecutables

¿Cómo encaja la generación de pruebas en la pirámide de pruebas?

Comienza por la capa de menor coste y mayor señal: las pruebas unitarias.

- Genera muchas pruebas unitarias para lógica complicada y límites

- Añade un conjunto más pequeño de pruebas de integración para las costuras de mayor riesgo (BD, autenticación, pagos)

- Mantén las pruebas E2E mínimas y curadas para los viajes de usuario críticos

¿Qué hace que una prueba generada sea de alta calidad (no solo alta cobertura)?

Apunta a pruebas enfocadas en el comportamiento que fallen por la razón correcta. Fortalece comprobaciones débiles mediante:

- Aserciones sobre salidas, cambios de estado, registros persistidos o eventos emitidos

- Inclusión de casos negativos/errores (entrada inválida, permisos denegados)

- Evitar aserciones que solo prueben “no se lanzó excepción”

¿Cómo evitar que las pruebas generadas se vuelvan inestables o frágiles?

Fuentes comunes de fragilidad son el exceso de mocks, marcas de tiempo codificadas, datos aleatorios y aserciones sobre llamadas a métodos internos. Prefiere entradas deterministas y resultados estables, y prueba el comportamiento público en lugar de detalles de implementación para que los refactors inocuos no rompan la suite.

¿Cuál es un flujo práctico para “especificación → código → pruebas” con IA?

Usa un bucle cerrado:

- Escribe/aclare la especificación (ejemplos + casos límite)

- Genera o edita la implementación

- Genera pruebas y ejecútalas de inmediato

- Comete código y pruebas juntos para que CI haga cumplir el comportamiento

Esto mantiene el “hecho” vinculado a expectativas ejecutables, no solo a comprobaciones manuales.

¿Cómo debes solicitar a la IA que genere mejores pruebas?

Incluye restricciones y contexto real del repo:

- Lenguaje + framework de pruebas y ubicaciones de archivos

- Convenciones de nombres y un ejemplo corto de prueba existente para imitar

- Cobertura requerida (ruta feliz, valores límite, casos negativos/errores)

- Una regla como “cada prueba debe asertar comportamiento del negocio, no solo ‘no se lanzó’”

Esto reduce patrones inventados y mejora la revisabilidad.

¿Qué riesgos de seguridad y privacidad conlleva la generación automática de pruebas?

Ten cuidado con lo que pegas en los prompts (código, logs, trazas). Evita filtrar:

- Claves API, tokens, credenciales

- Datos de clientes o identificadores de producción

- URLs internas o detalles propietarios

Usa fixtures sintéticos, redacta de forma agresiva y minimiza el contexto compartido a lo necesario para reproducir el comportamiento.

¿Cómo medir el éxito sin perseguir métricas vanidosas como el recuento de pruebas?

Mide señales que reflejen confianza, no volumen:

- Tasa de tests frágiles y la confiabilidad de CI

- Tiempo para detectar regresiones (qué tan rápido CI atrapa un cambio malo)

- Defectos capturados antes del despliegue vs incidentes en producción

Usa la cobertura como pista, y elimina periódicamente pruebas redundantes o de baja señal para mantener la suite manejable.