26 ago 2025·8 min

Guillermo Rauch, Vercel y Next.js: Simplificando el despliegue

Explora cómo Guillermo Rauch, Vercel y Next.js convirtieron el despliegue, el SSR y la infraestructura frontend en productos más simples para los equipos mainstream.

Explora cómo Guillermo Rauch, Vercel y Next.js convirtieron el despliegue, el SSR y la infraestructura frontend en productos más simples para los equipos mainstream.

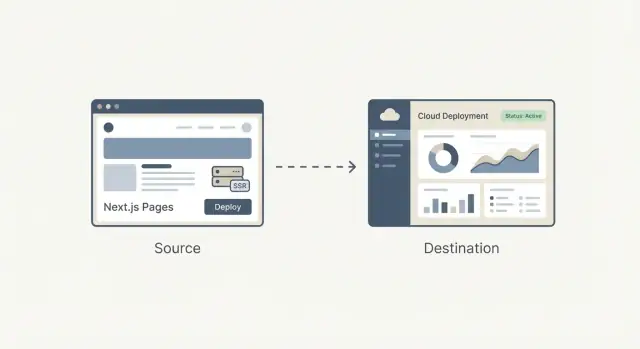

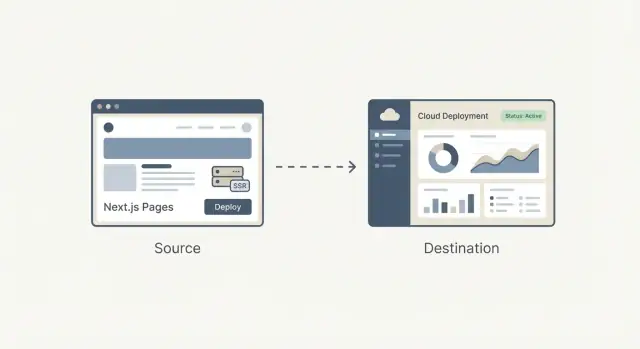

No hace tanto, lanzar una app web normalmente significaba: construirla, encontrar un host, conectarlo y mantenerlo en marcha. Incluso si tu código era sencillo, ponerlo en línea a menudo implicaba decisiones sobre servidores, cache, pipelines de build, certificados TLS y monitoreo. Nada de eso era glamuroso, pero era inevitable—y rutinariamente alejaba a los equipos del producto que intentaban lanzar.

El gran cambio es que el despliegue dejó de ser un proyecto técnico ocasional y se convirtió en un flujo de trabajo que repites todos los días. Los equipos querían URLs de vista previa para cada pull request, rollbacks que no requirieran trabajo de investigación, y un camino fiable desde el código local hasta producción.

Una vez que esas necesidades se volvieron comunes entre startups, agencias y empresas, el despliegue empezó a parecer menos ingeniería personalizada y más algo que podía empaquetarse: un producto con valores predeterminados claros, una interfaz, automatizaciones sensatas y resultados predecibles.

El renderizado del lado del servidor (SSR) añadió otra capa de complejidad. No es solo “servir archivos”; es “ejecutar código en el servidor para generar HTML, cachearlo de forma segura y actualizarlo sin romper a los usuarios.” Hacer SSR bien implicaba entender:

Esto era manejable para especialistas, pero fácil de configurar mal—y difícil de mantener conforme el proyecto crecía.

¿Entonces qué significa productizar la infraestructura frontend?

Significa convertir las partes desordenadas y propensas a errores de enviar un frontend—builds, despliegues, previews, manejo SSR/SSG, caching y entrega en el edge—en un sistema estándar, mayormente automático, que funcione igual en distintos proyectos.

En las secciones siguientes, la meta es práctica: entender qué se simplifica, qué se gana y qué sacrificios aceptas—sin necesitar convertirte en un experto en ops.

Guillermo Rauch es hoy conocido como el CEO de Vercel y una voz principal detrás de Next.js. Su influencia no es tanto una sola invención como una obsesión consistente: hacer que el desarrollo web se sienta “obvio” para las personas que construyen productos.

Rauch ha pasado gran parte de su carrera entregando herramientas para desarrolladores en público. Antes de Vercel, construyó y mantuvo proyectos open source populares (notablemente Socket.IO) y ayudó a crecer una cultura donde la documentación, los ejemplos y los valores predeterminados sensatos se tratan como parte del producto, no como un añadido.

Más tarde fundó ZEIT (renombrada a Vercel), una compañía enfocada en convertir el despliegue en un flujo de trabajo simplificado. Next.js, desarrollado originalmente dentro de ese ecosistema, se convirtió en el framework insignia que emparejaba una experiencia frontend moderna con características aptas para producción.

Una forma útil de entender el impacto de Rauch es por las decisiones que se repitieron:

Ese enfoque moldeó tanto el framework como la plataforma: Next.js animó a los equipos a adoptar SSR y generación estática sin aprender un manual operativo completamente nuevo, mientras que Vercel empujó el despliegue hacia un valor predeterminado predecible y repetible.

Es fácil convertir esta historia en una narrativa de una sola persona. Una interpretación más precisa es que Rauch ayudó a alinear un cambio más amplio ya en marcha: los equipos frontend querían iteración más rápida, menos transferencias y una infraestructura que no requiriera un especialista en ops para cada cambio.

Vercel y Next.js funcionan como un estudio de caso en pensamiento de producto porque empaquetaron esos deseos en valores predeterminados que los equipos mainstream realmente podían usar.

Next.js es un framework de React que te da un “kit completo de inicio” sobre React. Sigues construyendo componentes igual, pero Next.js añade las piezas que la mayoría de equipos termina ensamblando de todos modos: páginas, enrutamiento, formas de obtener datos y valores predeterminados de rendimiento aptos para producción.

Enrutamiento y páginas: En una app React pura, normalmente agregas una librería de router, decides convenciones de URL y conectas todo. Next.js convierte las URLs y las páginas en una característica de primera clase, de modo que la estructura de tu app se mapea naturalmente a las rutas.

Carga de datos: Las apps reales necesitan datos—listas de productos, cuentas de usuario, contenido de un CMS. Next.js proporciona patrones comunes para cargar datos en el servidor, en tiempo de build o en el navegador, sin obligar a cada equipo a inventar una configuración personalizada.

Valores predeterminados de rendimiento: Next.js incorpora optimizaciones prácticas—code splitting, manejo más inteligente de assets y opciones de renderizado—para que obtengas buena velocidad sin buscar un largo checklist de plugins.

Una app React simple a menudo es “React + un montón de decisiones”: librería de routing, configuración de build, herramientas para SSR/SSG (si se necesitan) y convenciones que solo existen en tu repositorio.

Next.js es más opinado: estandariza las decisiones comunes para que los desarrolladores nuevos entiendan el proyecto más rápido y los equipos pasen menos tiempo manteniendo la plomería.

Next.js puede sobrar si estás construyendo un sitio pequeño mayormente estático con unas pocas páginas, o una herramienta interna simple donde el SEO y el rendimiento inicial no son prioridades.

Si no necesitas múltiples opciones de renderizado, enrutamiento estructurado o carga de datos del lado servidor, una configuración ligera de React (o incluso nada de React) puede ser la opción más sencilla y económica.

Las apps modernas pueden parecer misteriosas porque “dónde se construye la página” cambia según el enfoque. Una forma simple de pensar en SSR, SSG y CSR es: ¿cuándo y dónde se crea el HTML?

Con SSR, el servidor genera el HTML por cada petición (o para muchas peticiones si se usa caché). Esto ayuda con SEO y puede hacer que la primera vista aparezca rápido—especialmente en dispositivos lentos—porque el navegador recibe contenido real temprano.

Un error común: SSR no es automáticamente más rápido. Si cada petición dispara llamadas lentas a la base de datos, SSR puede sentirse lento. La velocidad real suele venir del caching (en el servidor, CDN o edge) para que las visitas repetidas no reejecuten el trabajo.

Con SSG, las páginas se preconstruyen con anticipación (durante un paso de build) y se sirven como archivos estáticos. Esto es excelente para fiabilidad y coste, y a menudo entrega tiempos de carga muy buenos porque la página ya está “lista” antes de que llegue el usuario.

SSG brilla en páginas de marketing, docs y contenido que no cambia cada segundo. La compensación es la frescura: actualizar contenido puede requerir un rebuild o una estrategia de actualización incremental.

Con CSR, el navegador descarga JavaScript y construye la UI en el dispositivo del usuario. Esto puede ser perfecto para partes altamente interactivas y personalizadas (dashboards, editores), pero puede retrasar la primera vista significativa y complicar el SEO si el contenido no está disponible como HTML desde el inicio.

La mayoría de productos reales combinan modos: SSG para páginas de aterrizaje (SEO y velocidad), SSR para páginas dinámicas que aún necesitan contenido indexable (páginas de producto, listados) y CSR para experiencias con sesión.

Elegir bien se conecta directamente con resultados: SEO (descubribilidad), velocidad (conversión) y confiabilidad (menos incidentes, ingresos más estables).

Antes de que las plataformas hicieran que el despliegue pareciera un clic, lanzar una app web a menudo significaba armar tu propio mini “proyecto de infraestructura.” Incluso un sitio de marketing simple con un formulario dinámico podía convertirse en una cadena de servidores, scripts y servicios que tenían que permanecer perfectamente sincronizados.

Un setup común se veía así: aprovisionabas uno o varios servidores (o una VM), instalabas un servidor web y configurabas un pipeline CI que construía la app y copiaba artefactos por SSH.

Encima de eso, quizá configurabas un proxy inverso (como Nginx) para enrutar peticiones, terminar TLS y manejar compresión. Luego venía el caching: tal vez una configuración de CDN y reglas sobre qué páginas eran seguras para cachear y por cuánto tiempo.

Si necesitabas SSR, entonces operabas un proceso Node que había que iniciar, monitorizar, reiniciar y escalar.

Los problemas no eran teóricos—aparecían en cada release:

El desarrollo local oculta las partes desordenadas: tienes cache caliente, una versión diferente de Node, variables de entorno distintas y no hay patrones reales de tráfico.

Una vez desplegado, esas diferencias salen a la luz de inmediato—a menudo como desajustes SSR sutiles, secretos faltantes o reglas de enrutamiento que se comportan distinto tras un proxy.

Los setups avanzados (SSR, multi-región, entornos de preview seguros) eran posibles, pero demandaban tiempo operativo. Para muchos equipos pequeños, eso significaba conformarse con arquitecturas más simples—no porque fueran las mejores, sino porque la sobrecarga del despliegue era demasiado alta.

Vercel no solo automatizó el despliegue: lo empaquetó en un flujo de trabajo por defecto que se siente como parte de escribir código. La idea de producto es simple: desplegar no debería ser una tarea ops separada que programes; debería ser la consecuencia normal del desarrollo cotidiano.

“Git push para desplegar” suele describirse como un script elegante. Vercel lo trata más como una promesa: si tu código está en Git, es desplegable—de forma consistente, repetible y sin una lista de verificación de pasos manuales.

Esa diferencia importa porque cambia quién se siente con confianza para publicar. No necesitas un especialista para interpretar settings del servidor, reglas de cache o pasos de build cada vez. La plataforma convierte esas decisiones en valores predeterminados y guardarraíles.

Las deploys de preview son gran parte de por qué esto se siente como un flujo de trabajo, no como una herramienta. Cada pull request puede generar una URL compartible que coincide de cerca con el comportamiento en producción.

Diseñadores pueden revisar el espaciado y las interacciones en un entorno real. QA puede probar el build exacto que se publicaría. Product managers pueden navegar la funcionalidad y dejar feedback concreto—sin esperar un “push a staging” o pedirle a alguien que ejecute la rama localmente.

Cuando desplegar se vuelve frecuente, la seguridad se vuelve una necesidad diaria. Rollbacks rápidos significan que un mal release es una molestia, no un incidente.

La paridad de entornos—mantener previews, staging y producción comportándose de forma similar—reduce el problema de “funciona en mi máquina” que ralentiza a los equipos.

Imagina que publicas una nueva página de precios y un pequeño cambio en el flujo de registro. Con previews, marketing revisa la página, QA prueba el flujo y el equipo mergea con confianza.

Si los analytics muestran un problema tras el lanzamiento, haces rollback en minutos mientras lo arreglas—sin congelar todo el trabajo restante.

Un CDN (Content Delivery Network) es un conjunto de servidores alrededor del mundo que almacenan (y entregan) copias de los archivos de tu sitio—imágenes, CSS, JavaScript y, a veces, HTML—para que los usuarios los descarguen desde una ubicación cercana.

El caching es el libro de reglas sobre cuánto tiempo esas copias pueden reutilizarse. Un buen caching significa páginas más rápidas y menos hits a tu servidor origen. Un mal caching significa usuarios viendo contenido desactualizado—o que el equipo tenga miedo de cachear nada.

El edge es el siguiente paso: en lugar de solo servir archivos desde ubicaciones globales, puedes ejecutar pequeñas piezas de código cerca del usuario, en tiempo de petición.

Aquí es donde “infraestructura frontend sin el equipo ops” se vuelve real: muchos equipos obtienen distribución global y manejo inteligente de peticiones sin gestionar servidores en múltiples regiones.

Las funciones edge destacan cuando necesitas decisiones rápidas antes de servir una página:

Si tu sitio es mayormente estático, tiene bajo tráfico o tienes requisitos estrictos sobre exactamente dónde puede ejecutarse el código (por razones legales o de residencia de datos), el edge puede añadir complejidad sin un beneficio claro.

Ejecutar código en muchas ubicaciones puede complicar la observabilidad y la depuración: logs y trazas se distribuyen, y reproducir problemas que “solo fallan en una región” puede llevar tiempo.

También existe comportamiento específico del proveedor (APIs, límites, diferencias de runtime) que afecta la portabilidad.

Si se usa con criterio, las capacidades del edge permiten a los equipos ser “globales por defecto” en rendimiento y control—sin contratar un equipo ops para montarlo.

Un framework y una plataforma “encajan” cuando la plataforma entiende lo que el framework produce en tiempo de build y lo que necesita en tiempo de petición.

Eso permite que el host interprete la salida del build (archivos estáticos vs. funciones de servidor), aplique las reglas de enrutamiento correctas (rutas dinámicas, rewrites) y establezca un comportamiento de caché sensato (qué se puede cachear en el edge y qué debe ser fresco).

Cuando la plataforma conoce las convenciones del framework, mucho trabajo desaparece:

El beneficio neto es menos scripts a medida y menos sorpresas de despliegue “funciona en mi máquina”.

La desventaja es el lock-in por conveniencia. Si tu app depende de features específicas de la plataforma (APIs de funciones edge, reglas propietarias de caché, plugins de build), migrar más tarde puede implicar reescribir partes de tu routing, middleware o pipeline de despliegue.

Para mantener la portabilidad en mente, separa responsabilidades: deja la lógica de negocio nativa al framework, documenta cualquier comportamiento específico del host y prioriza estándares donde sea posible (headers HTTP, redirecciones, variables de entorno).

No asumas que hay una opción única. Compara plataformas según: flujo de despliegue, modos de renderizado soportados, control de caché, soporte edge, observabilidad, previsibilidad de precios y facilidad de salida.

Un pequeño proof-of-concept—desplegar el mismo repo a dos proveedores—suele revelar las diferencias reales más rápido que la documentación.

El rendimiento no es solo presumir en un test de velocidad. Es una característica de producto: páginas más rápidas reducen bounce y mejoran conversiones, y builds más rápidos permiten a los equipos desplegar con más frecuencia sin esperar.

Para usuarios, “rápido” significa que la página se vuelve usable pronto—especialmente en móviles de gama media y redes lentas. Para equipos, “rápido” significa que los despliegues terminan en minutos (o segundos) para que los cambios puedan ir a producción con confianza.

Vercel popularizó la idea de que puedes optimizar ambos al mismo tiempo haciendo del rendimiento parte del flujo de trabajo por defecto en lugar de un proyecto especial.

Un build tradicional suele reconstruirlo todo, incluso si cambiastes una línea en una página. Los builds incrementales buscan reconstruir solo lo que cambió—como actualizar un capítulo en un libro en vez de reimprimir todo.

El caching ayuda reutilizando resultados previamente calculados:

En Next.js, patrones como la regeneración estática incremental (ISR) encajan con esta mentalidad: sirve una página preconstruida y luego la actualiza en segundo plano cuando cambia el contenido.

Un presupuesto de rendimiento es un límite simple que acordáis—por ejemplo “mantener la página principal bajo 200KB de JavaScript” o “Largest Contentful Paint bajo 2.5s en móvil típico”. La idea no es la perfección; es evitar que la experiencia se degrade sin que nadie se dé cuenta.

Manténlo ligero y consistente:

Cuando la velocidad se trata como una característica, obtienes mejor experiencia de usuario y un ritmo de equipo más rápido—sin convertir cada release en un incidente de rendimiento.

La mayoría de herramientas no se vuelven mainstream porque son las más flexibles—ganan porque un usuario nuevo puede tener éxito rápido.

Los builders mainstream (equipos pequeños, agencias, desarrolladores de producto sin profunda experiencia infra) tienden a evaluar plataformas con preguntas sencillas:

Aquí es donde plantillas, documentación clara y flujos de “camino feliz” importan. Una plantilla que se despliega en minutos y demuestra enrutamiento, fetch de datos y autenticación suele ser más persuasiva que una matriz de features.

La documentación que muestra un enfoque recomendado (y explica cuándo desviarse) reduce el tiempo perdido en conjeturas.

Una larga lista de toggles puede parecer poderosa, pero obliga a cada equipo a volverse experto solo para tomar decisiones básicas. Los valores predeterminados sensatos reducen la carga cognitiva:

Cuando los valores predeterminados son correctos, los equipos pasan su tiempo en el producto en lugar de en la configuración.

Los builders del mundo real suelen empezar con patrones familiares:

Las mejores plantillas no solo “se ven bien”—codifican una estructura probada.

Dos errores se repiten:

Una buena curva de aprendizaje empuja a los equipos hacia un punto de partida claro y hace que las opciones avanzadas parezcan mejoras deliberadas, no tarea obligatoria.

Las plataformas de despliegue productizaron el camino de Git a producción. Hay una tendencia paralela río arriba: productizar el camino desde la idea a una base de código funcional.

Koder.ai es un ejemplo de esta dirección de “vibe-coding”: describes lo que quieres en una interfaz de chat y la plataforma usa un flujo agente-LLM para generar e iterar una aplicación real. Está pensada para web, servidor y móvil (React en frontend, Go + PostgreSQL en backend, Flutter en mobile), con características de shipping prácticas como exportación de código, despliegue/hosting, dominios personalizados, snapshots y rollback.

En la práctica, esto encaja naturalmente con el flujo que describe este artículo: acortar el ciclo intención → implementación → URL de preview → producción, manteniendo una salida (exportación de código) cuando superas los valores predeterminados.

Elegir una plataforma frontend no es solo escoger “dónde hospedar”. Es elegir el flujo de trabajo por defecto en el que vivirá tu equipo: cómo el código se convierte en una URL, cómo se revisan los cambios y cómo se gestionan las incidencias.

La mayoría de plataformas parecen similares en la homepage, luego divergen en los detalles de facturación. Compara las unidades que mapean a tu uso real:

Un consejo práctico: estima costes para un mes normal y para una “semana de lanzamiento”. Si no puedes simular ambos, te sorprenderá en el peor momento.

No necesitas ser experto en infra, pero deberías preguntar directamente:

Si tus clientes son globales, la cobertura regional y el comportamiento de caché pueden importar tanto como el rendimiento bruto.

Busca salvaguardas cotidianas en lugar de promesas vagas:

Usa esto como filtro rápido antes de una evaluación más profunda:

Elige la plataforma que reduzca las “decisiones de despliegue” que tu equipo debe tomar semanalmente—manteniendo suficiente control cuando importe.

La productización convierte las decisiones de despliegue y renderizado de trabajo de ingeniería a medida en valores predeterminados repetibles. Eso reduce la fricción en dos puntos que normalmente ralentizan a los equipos: publicar cambios y mantener el rendimiento predecible.

Cuando el camino commit → preview → producción está estandarizado, la iteración se acelera porque menos releases dependen de un especialista (o de una tarde afortunada de debugging).

Comienza con la superficie mínima que te da feedback:

Una vez que eso funcione, expande gradualmente:

Si quieres profundizar sin perderte, revisa patrones y estudios de caso en /blog y luego comprueba costos y límites en /pricing.

Si además experimentas con maneras más rápidas de pasar de requisitos a una base funcional (especialmente para equipos pequeños), Koder.ai puede ser útil como herramienta complementaria: genera una primera versión por chat, itera rápido con stakeholders y luego sigue el mismo camino productizado hacia previews, rollbacks y producción.

Las plataformas integradas optimizan la rapidez para lanzar y reducen decisiones operativas. La compensación es menos control de bajo nivel (infra personalizada, requisitos de cumplimiento únicos, redes a medida).

Elige el setup “más productizado” que aun cumpla tus restricciones—y mantén un plan de salida (arquitectura portable, pasos de build claros) para decidir desde una posición de fuerza, no de encierro.

Significa empaquetar las partes desordenadas de poner en producción un frontend —construcciones, despliegues, vistas previas, manejo SSR/SSG, caching y entrega global— en un flujo de trabajo repetible con valores predeterminados sensatos.

En la práctica, reduce la cantidad de scripts personalizados y el “conocimiento tribal” necesario para pasar de un commit a una URL de producción fiable.

Porque el despliegue dejó de ser un proyecto ocasional y pasó a ser un flujo de trabajo diario. Los equipos necesitaban:

Cuando estas necesidades se volvieron comunes, pudieron estandarizarse como una experiencia de producto en lugar de reinventarse por equipo.

SSR no es solo servir archivos; implica ejecutar código en el servidor para generar HTML y luego hacerlo rápido y seguro con caching y enrutamiento.

Las fuentes comunes de complejidad incluyen la configuración del runtime (Node/serverless), la invalidación de caché, los cold starts, headers/rewrites y asegurarse de que el comportamiento en producción coincida con el desarrollo local.

Piensa en términos de cuándo se crea el HTML:

Muchas aplicaciones mezclan modos: SSG para landing/docs, SSR para páginas dinámicas indexables y CSR para áreas muy interactivas y con sesión.

Una aplicación React “simple” normalmente acaba siendo “React + un montón de decisiones” (enrutador, configuración de build, estrategia de renderizado, convenciones). Next.js estandariza necesidades comunes:

Es más valioso cuando necesitas SEO, varios modos de renderizado o una estructura de aplicación consistente.

Si estás construyendo un sitio pequeño mayormente estático, una herramienta interna simple o cualquier cosa donde el SEO y el primer renderizado no sean prioridades, Next.js puede ser una sobrecarga innecesaria.

En esos casos, una configuración estática ligera (o una SPA más simple) puede ser más barata y fácil de mantener.

Las deploys de vista previa generan una URL compartible para cada pull request que emula el comportamiento de producción.

Eso mejora la colaboración porque:

También reduce sorpresas de última hora que solo aparecen en un entorno “staging”.

No necesariamente. SSR puede ser lento si cada petición dispara trabajo costoso (consultas a bases de datos, APIs lentas).

SSR se percibe rápido cuando va acompañado de un buen caching:

La mejora de velocidad suele venir de la estrategia de caché, no solo de SSR.

Las funciones edge ejecutan pequeñas piezas de código cerca del usuario, útiles para:

Pueden sobrar si tu sitio es mayormente estático, tiene poco tráfico o existen restricciones estrictas de residencia de datos/compliance. Además, la depuración puede complicarse: logs y fallos se distribuyen entre regiones.

La integración simplifica cosas como enrutamiento, vistas previas y caching porque el host entiende lo que el framework produce. El riesgo es el bloqueo por conveniencia.

Para mantener una vía de salida:

Una prueba práctica es desplegar el mismo repo en dos proveedores y comparar la fricción.