Qué significa “iterar” — y dónde encaja la IA

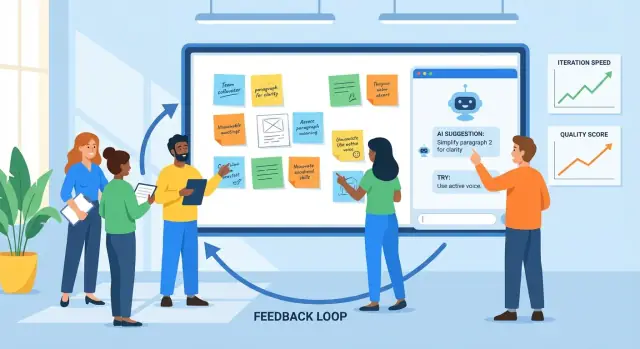

Iterar es la práctica de crear algo, recibir retroalimentación, mejorarlo y repetir el ciclo. Lo ves en diseño de producto (publicar una función, observar el uso, refinar), marketing (probar un mensaje, aprender, reescribir) y redacción (borrador, revisión, edición).

La retroalimentación es cualquier señal que te dice qué funciona y qué no: comentarios de usuarios, tickets de soporte, informes de errores, respuestas de encuestas, métricas de rendimiento, notas de interesados — incluso tu propia sensación tras usar la cosa. La mejora es lo que cambias con base en esas señales, desde ajustes pequeños hasta rediseños mayores.

Por qué importan los ciclos cortos

Los ciclos de retroalimentación más cortos suelen dar mejores resultados por dos razones:

- La calidad mejora más rápido: detectas malentendidos y fallos temprano, antes de que se extiendan a más páginas, pantallas o versiones.

- La velocidad aumenta sin adivinar: pasas menos tiempo debatiendo en abstracto y más tiempo aprendiendo a partir de evidencia real.

Un buen ritmo de iteración no es “moverse rápido y romper cosas”. Es “moverse en pasos pequeños y aprender deprisa”.

Dónde ayuda la IA (y dónde no)

La IA es útil dentro del bucle cuando hay mucha información y necesitas ayuda para procesarla. Puede:

- resumir la retroalimentación de muchas fuentes en temas

- detectar quejas repetidas, formulación confusa o detalles faltantes

- proponer versiones alternativas (texto, maquetas, enunciados de tareas) para considerar

- actuar como un segundo par de ojos para claridad, tono y consistencia

Pero la IA no puede reemplazar las decisiones centrales. No conoce tus objetivos de negocio, limitaciones legales o qué significa “bueno” para tus usuarios a menos que lo definas. Puede sugerir cambios con confianza que estén fuera de marca, sean arriesgados o basados en supuestos incorrectos.

Fija expectativas con claridad: la IA apoya el juicio. Tu equipo sigue eligiendo qué priorizar, qué cambiar, qué significa el éxito — y valida las mejoras con usuarios reales y datos reales.

El bucle básico de retroalimentación: un modelo práctico

Iterar es más fácil cuando todos siguen el mismo bucle y saben qué significa “hecho”. Un modelo práctico es:

borrador → retroalimentación → revisar → comprobar → publicar

Los equipos a menudo se atascan porque un paso es lento (revisiones), desordenado (retroalimentación dispersa en herramientas) o ambiguo (¿qué exactamente debe cambiar?). Usada deliberadamente, la IA puede reducir la fricción en cada punto.

Paso 1: Borrador (llegar a algo revisable)

El objetivo no es la perfección; es una primera versión sólida a la que otros puedan reaccionar. Un asistente con IA puede ayudarte a esbozar, generar alternativas o completar huecos para que llegues a “revisable” más rápido.

Donde más ayuda: convertir un brief tosco en un borrador estructurado y producir varias opciones (por ejemplo, tres titulares, dos flujos de onboarding) para comparar.

Paso 2: Retroalimentación (capturar y condensar)

La retroalimentación suele llegar en comentarios largos, hilos de chat, notas de llamadas y tickets de soporte. La IA es útil para:

- resumir temas repetidos (qué mencionan con frecuencia)

- agrupar la retroalimentación por tópico (precios, incorporación, tono, bugs)

- extraer preguntas y elementos “debe arreglarse” frente a “sería bueno tener”

El cuello de botella que eliminas: lectura lenta e interpretación inconsistente de lo que los revisores quisieron decir.

Paso 3: Revisar (convertir reacciones en cambios)

Aquí es donde los equipos pierden tiempo en retrabajo: la retroalimentación poco clara conduce a ediciones que no satisfacen al revisor y el bucle se repite. La IA puede sugerir ediciones concretas, proponer copias revisadas o generar una segunda versión que aborde explícitamente los temas de retroalimentación más importantes.

Paso 4: Comprobar (calidad antes de publicar)

Antes del lanzamiento, usa la IA como un segundo par de ojos: ¿la nueva versión introduce contradicciones, pasos faltantes, requisitos rotos o deriva de tono? El objetivo no es “aprobar” el trabajo; es detectar problemas evidentes temprano.

Paso 5: Publicar con una única fuente de verdad

La iteración se acelera cuando los cambios viven en un solo lugar: un ticket, doc o descripción de PR que registre (1) el resumen de retroalimentación, (2) las decisiones y (3) lo que cambió.

La IA puede ayudar a mantener esa “fuente única de verdad” redactando notas de actualización y alineando los criterios de aceptación con las decisiones más recientes. En equipos que construyen y publican software directamente (no solo docs), plataformas como Koder.ai también pueden acortar este paso al mantener planificación, implementación y despliegue estrechamente conectados — de modo que la narrativa de “qué cambió” permanezca cerca del lanzamiento real.

Recoger retroalimentación: qué puede procesar bien la IA

La IA solo puede mejorar aquello que le alimentes. La buena noticia es que la mayoría de equipos ya tienen mucha retroalimentación — solo que está repartida en distintos lugares y escrita en estilos diferentes. Tu trabajo es recogerla de forma consistente para que la IA pueda resumirla, detectar patrones y ayudarte a decidir qué cambiar a continuación.

Entradas de retroalimentación que funcionan especialmente bien

La IA es más potente con entradas desordenadas y textuales, incluidas:

- comentarios de usuarios (in-app, foros, chats)

- tickets de soporte y transcripciones de chat

- respuestas abiertas de encuestas

- reseñas en tiendas de apps y marketplaces

- notas de llamadas de ventas/CS y resúmenes de reuniones

- informes de errores y solicitudes de funciones desde equipos internos

No necesitas un formato perfecto. Lo que importa es capturar las palabras originales y una pequeña cantidad de metadatos (fecha, área del producto, plan, etc.).

De “un montón de citas” a temas y puntos de dolor

Una vez recopilada, la IA puede agrupar la retroalimentación en temas —confusión de facturación, fricción en el onboarding, integraciones faltantes, rendimiento lento— y mostrar qué se repite con mayor frecuencia. Esto importa porque el comentario más ruidoso no siempre es el problema más común.

Un enfoque práctico es pedir a la IA:

- una lista de temas con etiquetas cortas

- citas representativas por tema (para que lo puedas verificar)

- señales de frecuencia (p. ej., “mencionado en 18 tickets esta semana”)

- indicios de impacto (a quién afecta y qué bloquea)

Mantener el contexto para que las ideas sigan siendo relevantes

La retroalimentación sin contexto puede llevar a conclusiones genéricas. Adjunta contexto ligero junto a cada elemento, como:

- persona o tipo de cliente (usuario nuevo, admin, usuario avanzado)

- objetivo del usuario (“exportar un informe”, “invitar a compañeros”)

- restricciones (dispositivo, región, plan, requisitos de cumplimiento)

Incluso unos pocos campos consistentes hacen que la agrupación y los resúmenes de la IA sean mucho más accionables.

Privacidad y manejo de datos: lo básico

Antes del análisis, redacta información sensible: nombres, emails, teléfonos, direcciones, datos de pago y cualquier cosa confidencial en notas de llamadas. Prefiere la minimización de datos — comparte solo lo necesario para la tarea — y almacena las exportaciones crudas de forma segura. Si usas herramientas de terceros, confirma la política del equipo sobre retención y entrenamiento, y restringe el acceso al conjunto de datos.

Convertir la retroalimentación cruda en ideas claras y accionables

La retroalimentación cruda suele ser un montón de entradas desparejas: tickets de soporte, reseñas de apps, comentarios de encuestas, notas de ventas y hilos de Slack. La IA es útil aquí porque puede leer lenguaje “marrón” a escala y ayudarte a convertirlo en una lista corta de temas en los que realmente puedes trabajar.

1) De comentarios dispersos a categorías

Empieza alimentando a la IA un lote de retroalimentación (con datos sensibles eliminados) y pídele que agrupe los items en categorías consistentes como onboarding, rendimiento, precios, confusión de UI, bugs y solicitudes de funciones. El objetivo no es una taxonomía perfecta: es un mapa compartido que tu equipo pueda usar.

Un resultado práctico se parece a:

- Categoría: Confusión en el onboarding

- Qué intentan hacer los usuarios: Conectar cuenta, importar datos

- Bloqueadores observados: “No encontré el botón de importar”, “No estoy seguro si funcionó”

2) Añadir prioridades con un rubro sencillo

Una vez agrupada la retroalimentación, pide a la IA que proponga una puntuación de prioridad usando un rubro que puedas revisar:

- Impacto: ¿Cuánto afecta al éxito del usuario o a los ingresos?

- Frecuencia: ¿Con qué frecuencia aparece en las fuentes?

- Esfuerzo: ¿Qué tan difícil es arreglarlo (tiempo, dependencias)?

- Riesgo: ¿Qué probabilidad hay de romper algo o generar problemas de cumplimiento/soporte?

Puedes mantenerlo ligero (Alto/Medio/Bajo) o numérico (1–5). La clave es que la IA haga el primer pase y los humanos confirmen supuestos.

3) Resumir sin perder matices (mantener recibos)

Los resúmenes son peligrosos cuando borran el “por qué”. Un patrón útil es: resumen del tema + 2–4 citas representativas. Por ejemplo:

“Conecté Stripe pero no pasó nada — ¿se sincronizó?”

“El asistente de configuración saltó un paso y no supe qué hacer después.”

Las citas preservan el tono emocional y el contexto — y evitan que el equipo trate cada problema como idéntico.

4) Vigilar el sesgo: lo ruidoso no siempre es lo común

La IA puede sobreponderar lenguaje dramático o comentaristas repetidos si no la guías. Pídele que separe:

- Señales basadas en volumen (cuántos usuarios únicos lo mencionan)

- Señales basadas en severidad (qué tan grave es cuando ocurre)

Luego valida con datos de uso y segmentación. La queja de un usuario avanzado puede importar mucho — o puede reflejar un flujo de trabajo de nicho. La IA te ayuda a ver patrones, pero no puede decidir qué “representa a tus usuarios” sin tu contexto.

Usar la IA para generar versiones, no solo “la respuesta”

Aprovecha al máximo tu presupuesto

Gana créditos compartiendo lo que construyes o refiriendo a colegas a Koder.ai.

Una manera útil de pensar en una herramienta de IA es como un generador de versiones. En vez de pedir una única respuesta “mejor”, pide varias versiones plausibles que puedas comparar, mezclar y refinar. Esa mentalidad te mantiene al control y hace la iteración más rápida.

Esto es especialmente potente al iterar superficies de producto (flujos de onboarding, copy de UI, redacción de especificaciones). Por ejemplo, si construyes una herramienta interna o una app sencilla en Koder.ai, puedes usar el mismo enfoque de “generar múltiples versiones” para explorar distintas pantallas, flujos y requisitos en Modo Planificación antes de comprometerte — y luego confiar en snapshots y rollback para mantener los cambios rápidos seguros.

Da restricciones para que las variantes sean realmente comparables

Si pides “escríbeme esto”, a menudo obtendrás salida genérica. Mejor: define límites para que la IA explore opciones dentro de ellos.

Prueba especificar:

- Audiencia + intención: “Usuarios nuevos decidiendo si registrarse” vs. “Clientes existentes que necesitan tranquilidad.”

- Tono: amistoso, directo, formal, desenfadado (elige uno).

- Longitud: p. ej., “120–150 palabras” o “máx. 3 viñetas.”

- Formato: email, hero de landing, FAQ, nota de versión.

- Hechos que deben mantenerse: precios, fechas, garantías, limitaciones del producto.

- Evitar: afirmaciones prohibidas, lenguaje sensible, menciones a competidores.

Con restricciones, puedes generar “Versión A: concisa”, “Versión B: más empática”, “Versión C: más específica” sin perder precisión.

Genera múltiples opciones y luego elige (o combina)

Pide 3–5 alternativas de una vez y haz las diferencias explícitas: “Cada versión debe usar una estructura y línea de apertura distinta.” Eso crea contraste real, lo que ayuda a ver qué falta y qué resuena.

Un flujo práctico:

- Generar 3–5 versiones.

- Elegir las partes más fuertes (apertura de A, pruebas de C, CTA de B).

- Pedir a la IA que las fusione en un borrador, manteniendo los hechos que debes conservar.

Lista rápida: qué contiene un “buen borrador”

Antes de enviar un borrador a revisión o prueba, verifica que tenga:

- un objetivo claro (qué debe hacer/entender el lector)

- hechos clave preservados y consistentes

- una razón específica y creíble para importar (beneficio + prueba)

- una llamada a la acción principal

- lenguaje simple con mínimo jerga

- sin promesas sin fundamento ni superlativos vagos

Usada así, la IA no reemplaza el juicio — acelera la búsqueda de una versión mejor.

La IA como revisor: detectar problemas temprano

Antes de publicar un borrador — sea una especificación de producto, nota de versión, artículo de ayuda o página de marketing — una herramienta de IA puede actuar como un revisor rápido inicial. El objetivo no es sustituir el juicio humano; es sacar a la superficie problemas obvios para que tu equipo dedique tiempo a las decisiones difíciles, no a la limpieza básica.

Qué hacen bien las revisiones asistidas por IA

Las revisiones con IA son especialmente útiles para:

- Claridad: detectar oraciones largas, términos confusos o falta de contexto para un lector nuevo.

- Consistencia: comprobar nombres (etiquetas de funciones, mayúsculas), afirmaciones repetidas y contradicciones entre secciones.

- Tono: alinear la voz con tu audiencia (amistosa, directa, formal) y señalar frases que suenen a la defensiva o vagas.

- Completitud: señalar pasos faltantes, casos límite, prerrequisitos o huecos de “qué pasa después”.

Prompts prácticos de revisión que puedes reutilizar

Pega tu borrador y pide un tipo específico de crítica. Por ejemplo:

- “Revisa esto por huecos: ¿qué preguntas le quedarán a un usuario primerizo?”

- “Marca supuestos: ¿qué estoy asumiendo sobre el producto, el usuario o el flujo?”

- “Simplifica: reescribe cualquier oración de más de 25 palabras manteniendo el mismo sentido.”

- “Revisa inconsistencias: lista términos usados de formas distintas.”

Críticas por rol para ampliar la perspectiva

Una forma rápida de ampliar el enfoque es pedir al modelo que revise desde distintos roles:

- “Como cliente, ¿qué resulta confuso o riesgoso?”

- “Como soporte, ¿qué tickets podría generar esto?”

- “Como PM, ¿qué criterios de aceptación faltan?”

- “Como legal/compliance, ¿qué afirmaciones necesitan concretarse?”

Chequeo de seguridad: verifica los hechos

La IA puede criticar redacción con confianza y estar equivocada sobre detalles del producto. Trata los ítems factuales — precios, disponibilidad de funciones, garantías, fechas — como “necesitan verificación”. Mantén la costumbre de marcar afirmaciones con fuentes (enlaces a docs, tickets o decisiones) para que la versión final refleje la realidad, no una suposición creíble.

Convertir la retroalimentación en ediciones, tareas y criterios de aceptación

La retroalimentación cruda rara vez está lista para implementar. Suele ser emocional (“esto suena mal”), mixta (“me gusta pero…”) o poco especificada (“hacerlo más claro”). La IA puede ayudar a traducir eso en ítems de trabajo que tu equipo pueda ejecutar — manteniendo la retroalimentación original adjunta para justificar decisiones después.

Una plantilla simple que la IA puede completar

Pide a tu herramienta de IA reescribir cada pieza de retroalimentación usando esta estructura:

Problema → Evidencia → Cambio propuesto → Métrica de éxito

- Problema: ¿qué no está funcionando?

- Evidencia: ¿qué dijo/hizo el usuario? Incluye la cita, referencia de captura de pantalla o marca de la llamada.

- Cambio propuesto: ¿qué vas a cambiar? (un cambio por ítem).

- Métrica de éxito: ¿cómo sabrás que mejoró? (cualitativa o cuantitativa).

Esto obliga a la claridad sin “inventar” requisitos nuevos.

Convertir notas vagas en tareas acotadas

Ejemplo de retroalimentación:

“La página de checkout confunde y tarda demasiado.”

Salida asistida por IA (editada por ti):

- Problema: Los usuarios no entienden los pasos y abandonan durante el checkout.

- Evidencia: 6/20 entrevistados preguntaron “¿y ahora qué?”; la analítica muestra una caída del 38% entre Envío → Pago (10–20 dic.).

- Cambio propuesto: Añadir un indicador de progreso en 3 pasos y renombrar el botón principal de “Continuar” a “Continuar al pago.”

- Métrica de éxito: Reducir la caída Envío → Pago del 38% a ≤30% en 2 semanas.

Luego conviértelo en una tarea con límites:

Tarea: Añadir indicador de progreso + actualizar la etiqueta del botón en checkout.

Fuera de alcance: Cambiar proveedor de pagos, rediseñar todo el layout de checkout, reescribir todo el copy del producto.

Criterios de aceptación (hacerlo verificable)

Usa la IA para redactar criterios de aceptación y luego afínalos:

- El indicador de progreso aparece en móvil y escritorio.

- Los pasos reflejan el estado actual (Envío, Pago, Revisión).

- La etiqueta del botón se actualiza en pantallas de Envío y Pago.

- Sin cambios en precios, impuestos o procesamiento de pagos.

Mantener la trazabilidad de la retroalimentación

Guarda siempre:

- la retroalimentación original (cita/enlace de llamada/ticket)

- la tarea transformada por la IA

- la decisión final y la justificación

Esa trazabilidad protege la responsabilidad, evita decisiones por “la IA dijo” y acelera iteraciones futuras porque puedes ver qué cambió — y por qué.

Probar mejoras: experimentos que la IA puede acelerar

Planifica antes de construir

Mapea pantallas, flujos y requisitos antes de generar código, para que los cambios se mantengan controlados.

La iteración se vuelve real cuando pruebas un cambio contra un resultado medible. La IA puede ayudarte a diseñar experimentos pequeños y rápidos — sin convertir cada mejora en un proyecto de una semana.

Un modelo simple de experimento (que la IA puede ayudar a redactar)

Una plantilla práctica es:

- Hipótesis: Si cambiamos X, entonces Y mejorará porque Z.

- Variantes: Versión A (actual) vs. Versión B (un cambio intencional).

- Métrica de éxito: el número que usarás para decidir (tasa de apertura, activación, conversión, tiempo hasta primera acción).

- Audiencia + duración: a quién se le muestra y por cuánto tiempo.

Pide a la IA 3–5 hipótesis candidatas basadas en tus temas de retroalimentación (p. ej., “los usuarios dicen que la configuración es confusa”), y que las reescriba en declaraciones comprobables con métricas claras.

Ejemplos rápidos que la IA puede generar (y tú probar)

Asuntos de email (métrica: tasa de apertura):

- A: “Tu informe semanal está listo”

- B: “3 ideas sobre tu semana (2 minutos para leer)”

Mensaje de onboarding (métrica: tasa de finalización del paso 1):

- A: “¡Bienvenido! Vamos a configurar tu cuenta.”

- B: “Bienvenido: añade tu primer proyecto y verás resultados en menos de 5 minutos.”

Microcopy en un botón (métrica: tasa de clics):

- A: “Enviar”

- B: “Guardar y continuar”

La IA es útil porque puede producir varias variantes plausibles con rapidez — diferentes tonos, longitudes y proposiciones de valor — para que elijas un cambio claro para probar.

Guardarraíles: hacer la prueba interpretable

La velocidad es buena, pero mantén los experimentos legibles:

- Cambia una variable a la vez cuando sea posible. Si reescribes el titular y el botón y el layout, no sabrás qué funcionó.

- Mantén un control. Conserva siempre la Versión A.

- Define la métrica antes de mirar. Si no, encontrarás ganancias por casualidad.

Mide resultados, no impresiones

La IA puede decirte qué “suena mejor”, pero tus usuarios deciden. Usa la IA para:

- sugerir umbrales de éxito (p. ej., “publicaremos B si mejora CTR en ≥5%”)

- redactar una plantilla de resumen de resultados

- traducir hallazgos en la siguiente hipótesis

Así cada prueba te enseña algo, incluso cuando la nueva versión pierde.

Medir resultados y aprender de cada ciclo

La iteración funciona solo cuando puedes decir si el último cambio realmente ayudó. La IA puede acelerar el paso de “medición a aprendizaje”, pero no reemplaza la disciplina: métricas claras, comparaciones limpias y decisiones escritas.

Elegir métricas que encajen con el objetivo

Elige un pequeño conjunto de números que revisarás cada ciclo, agrupados por lo que intentas mejorar:

- Conversión: registros, inicios de prueba, finalización de checkout, CTR en un CTA clave

- Retención: tasa de retorno a 7/30 días, churn, compra repetida, reuso de una función

- Tiempo para completar: tiempo de onboarding, tiempo hasta primer valor, tiempo de resolución de soporte

- Tasa de error / calidad: envíos fallidos, informes de bugs, devoluciones, conteo de defectos en QA

- Satisfacción: CSAT, NPS, calificaciones en apps, sentimiento en tickets

La clave es la consistencia: si cambias definiciones de métricas cada sprint, los números no te enseñarán nada.

Deja que la IA resuma resultados — y señale dónde cambiaron

Una vez tengas lecturas de experimentos, dashboards o CSVs exportados, la IA es útil para convertirlos en narrativa:

- resumir qué se movió (y qué no) en lenguaje llano

- resaltar segmentos notables: nuevos vs. recurrentes, tipo de dispositivo, fuente de tráfico, región, plan, usuarios avanzados vs. casuales

- sacar correlaciones sorprendentes que valga la pena investigar (p. ej., conversión sube en general, pero baja en Safari móvil)

Un prompt práctico: pega tu tabla de resultados y pide al asistente que produzca (1) un párrafo resumen, (2) las mayores diferencias por segmento y (3) preguntas de seguimiento para validar.

Evitar certeza falsa

La IA puede hacer que los resultados suenen definitivos aunque no lo sean. Aún debes comprobar:

- Tamaño de muestra: cambios pequeños en muestras pequeñas suelen ser ruido.

- Estacionalidad y eventos externos: festivos, promociones, caídas, menciones en prensa.

- Cambios múltiples a la vez: si cambiaron tres cosas, puede que no sepas qué provocó el efecto.

Mantén un registro de aprendizaje ligero

Después de cada ciclo, escribe una entrada corta:

- Qué cambió (enlace al ticket o doc)

- Qué pasó (métricas + segmentos notables)

- Qué creemos que significa (tu mejor explicación)

- Qué intentaremos después (un seguimiento concreto)

La IA puede redactar la entrada, pero tu equipo debe aprobar la conclusión. Con el tiempo, este registro se vuelve tu memoria — así evitas repetir experimentos y empiezas a acumular victorias.

Hacer el proceso repetible: flujos que escalan

Haz de la iteración un hábito

Avancen más rápido como equipo manteniendo decisiones, desarrollos y lanzamientos en un solo lugar.

La velocidad está bien, pero la consistencia es lo que hace que la iteración sume. El objetivo es convertir “debemos mejorar esto” en una rutina que tu equipo pueda ejecutar sin héroes.

Patrones de flujo de trabajo ligeros

Un bucle escalable no necesita procesos pesados. Unos hábitos pequeños superan a un sistema complicado:

- Revisión semanal (30–60 minutos): elige 1–3 ítems para mejorar, revisa los cambios de la semana pasada y decide qué probar. Lleva resúmenes preparados por IA (temas, quejas principales, riesgos emergentes) para que la reunión sea productiva.

- Registro de cambios: mantiene una nota continua de qué cambió, por qué y qué esperas que ocurra. Un doc simple funciona; la clave es la consistencia.

- Notas de decisión: para cambios significativos, captura la decisión en cinco líneas: contexto, opciones consideradas, decisión, responsable, fecha. La IA puede redactarlas a partir de notas de reunión, pero tú confirmas el texto.

Plantillas de prompts + listas de verificación reutilizables

Trata los prompts como activos. Guárdalos en una carpeta compartida y versiona como otro trabajo.

Mantén una pequeña biblioteca:

- Plantillas de prompt para tareas recurrentes (resumir retroalimentación, proponer variantes, reescribir por tono, generar criterios de aceptación).

- Listas de verificación reutilizables para calidad (claridad, completitud, cumplimiento, voz de marca, accesibilidad). Pide a la IA que ejecute la checklist y destaque brechas; luego un humano verifica.

Una convención sencilla ayuda: “Tarea + Audiencia + Restricciones” (p. ej., “Notas de versión — no técnico — 120 palabras — incluir riesgos”).

Añade un paso de aprobación humana para salidas sensibles

Para todo lo que afecte la confianza o la responsabilidad —precios, textos legales, guías médicas o financieras— usa la IA para redactar y marcar riesgos, pero exige un aprobador nombrado antes de publicar. Haz explícito ese paso para que no se salte por presión de tiempo.

Nombres de versión que eviten confusión

La iteración rápida crea archivos desordenados si no etiquetas claramente. Usa un patrón predecible como:

FeatureOrDoc_Alcance_V#_YYYY-MM-DD_Propietario

Ejemplo: OnboardingEmail_NewTrial_V3_2025-12-26_JP.

Cuando la IA genera opciones, manténlas agrupadas bajo la misma versión (V3A, V3B) para que todos sepan qué se comparó y qué se publicó.

Errores comunes, controles de seguridad y uso responsable

La IA puede acelerar la iteración, pero también acelerar errores. Trátala como un compañero poderoso: útil, rápido y a veces seguro de sí mismo sin razón.

Modos de fallo comunes (y cómo evitarlos)

Confiar demasiado en la IA. Los modelos pueden producir textos, resúmenes o “insights” plausibles que no concuerdan con la realidad. Crea la costumbre de comprobar cualquier cosa que pueda afectar clientes, presupuestos o decisiones.

Prompts vagos generan trabajo vago. Si tu entrada es “mejora esto”, obtendrás ediciones genéricas. Especifica audiencia, objetivo, restricciones y qué significa “mejor” (más corto, más claro, on-brand, menos tickets, mayor conversión, etc.).

Sin métricas, no hay aprendizaje. Iterar sin medición es solo cambiar. Decide de antemano qué vas a seguir (tasa de activación, tiempo hasta primer valor, churn, temas de NPS, tasa de error) y compara antes/después.

Manejo de datos: protege a usuarios y empresa

No pegues información personal, de clientes o confidencial en herramientas salvo que la organización lo permita y entiendas políticas de retención/entrenamiento.

Regla práctica: comparte lo mínimo necesario.

- Elimina nombres, emails, teléfonos, direcciones, IDs de pedido y notas de texto libre que puedan contener datos sensibles.

- Resume internamente y luego pide al modelo que trabaje desde el resumen.

- Si necesitas analizar retroalimentación real, redacta primero y guarda los originales en tu sistema aprobado.

Alucinaciones: verifica hechos y fuentes

La IA puede inventar números, citas, detalles de funciones o frases de usuarios. Cuando la precisión importe:

- Pregunta por supuestos y grado de incertidumbre (“¿qué no tienes claro?”).

- Solicita enlaces a fuentes primarias solo cuando puedas verificarlos tú mismo.

- Contrasta con tus docs, analítica, changelog o sistema de soporte.

Lista de comprobación “antes de publicar”

Antes de publicar un cambio asistido por IA, haz un rápido repaso:

- Objetivo y métrica definidos (qué significa el éxito).

- PII/datos confidenciales eliminados de prompts y registros.

- Hechos verificados (afirmaciones, números, políticas, citas).

- Casos límite revisados (accesibilidad, tono, notas legales/compliance).

- Aprobación humana del responsable adecuado (PM, soporte, legal, marca).

- Plan de rollback si el cambio funciona peor.

Usada así, la IA sigue siendo un multiplicador del buen juicio — no su reemplazo.