Resumen: por qué importa la historia de OpenAI

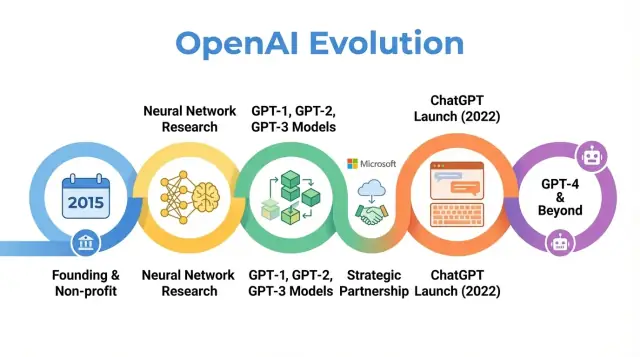

OpenAI es una empresa de investigación y despliegue de IA cuyo trabajo ha moldeado la forma en que se piensa sobre la inteligencia artificial, desde artículos científicos tempranos hasta productos como ChatGPT. Entender cómo evolucionó OpenAI —desde un pequeño laboratorio sin fines de lucro en 2015 hasta un actor central en la IA— ayuda a explicar por qué la IA moderna es como es hoy.

La historia de OpenAI no es solo una secuencia de lanzamientos de modelos. Es un estudio de caso sobre cómo misión, incentivos, avances técnicos y presión pública interactúan. La organización comenzó con un fuerte énfasis en la investigación abierta y el beneficio amplio, luego se reestructuró para atraer capital, formó una profunda alianza con Microsoft y lanzó productos usados por cientos de millones de personas.

Por qué importa esta historia

Rastrear la historia de OpenAI ilumina varias tendencias más amplias en IA:

-

Misión y valores: OpenAI se fundó con el objetivo declarado de asegurar que la inteligencia artificial general beneficie a toda la humanidad. Cómo se ha interpretado y revisado esa misión a lo largo del tiempo revela las tensiones entre metas idealistas y realidades comerciales.

-

Avances en investigación: La progresión desde proyectos tempranos hasta sistemas como GPT‑3, GPT‑4, DALL·E y Codex sigue un cambio más amplio hacia modelos fundacionales a gran escala que impulsan muchas aplicaciones actuales de IA.

-

Gobernanza y estructura: El paso de un puro nonprofit a una entidad de beneficio acotado, y la creación de mecanismos de gobernanza complejos, muestran las nuevas formas organizativas que se prueban para gestionar tecnologías poderosas.

-

Impacto público y escrutinio: Con ChatGPT y otros lanzamientos, OpenAI pasó de ser un laboratorio conocido principalmente en círculos de IA a un nombre de uso común, atrayendo atención sobre seguridad, alineación y regulación que ahora configuran debates políticos en todo el mundo.

Este artículo sigue el recorrido de OpenAI de 2015 hasta sus desarrollos más recientes, mostrando cómo cada fase refleja cambios más amplios en la investigación, la economía y la gobernanza de la IA —y qué podría significar eso para el futuro del campo.

Fundación de OpenAI: misión y equipo inicial

El momento de la IA en 2015

OpenAI se fundó en diciembre de 2015, en un momento en que el aprendizaje automático —especialmente el deep learning— mejoraba rápidamente pero todavía estaba lejos de la inteligencia general. Los benchmarks de reconocimiento de imágenes caían, los sistemas de voz mejoraban y empresas como Google, Facebook y Baidu invertían fuertemente en IA.

Crecía la preocupación entre investigadores y líderes tecnológicos de que la IA avanzada pudiera quedar controlada por un puñado de corporaciones o gobiernos. OpenAI se concibió como un contrapeso: una organización de investigación centrada en la seguridad a largo plazo y la amplia distribución de los beneficios de la IA, más que en una ventaja comercial estrecha.

Misión: AGI para el beneficio de todos

Desde el primer día, OpenAI definió su misión en términos de inteligencia artificial general (AGI), no solo en progreso incremental de machine learning. La declaración central fue que OpenAI trabajaría para asegurar que la AGI, si se creara, “beneficie a toda la humanidad”.

Esa misión tuvo varias implicaciones concretas:

- Priorizar la investigación en seguridad y preguntas de alineación a largo plazo

- Comprometerse a compartir investigación, código e ideas ampliamente cuando fuera posible

- Evitar una dinámica de carrera de ganador absoluto colaborando con otras instituciones

Los primeros posts públicos y la carta fundacional subrayaron tanto la apertura como la precaución: OpenAI publicaría gran parte de su trabajo, pero también consideraría el impacto social de liberar capacidades poderosas.

Fundadores, líderes tempranos y estructura

OpenAI comenzó como un laboratorio de investigación sin fines de lucro. Los compromisos iniciales de financiación se anunciaron en torno a 1.000 millones de dólares en apoyos prometidos, aunque eso fue un compromiso a largo plazo más que efectivo inmediato. Entre los patrocinadores iniciales figuraban Elon Musk, Sam Altman, Reid Hoffman, Peter Thiel, Jessica Livingston y YC Research, junto con apoyo de empresas como Amazon Web Services e Infosys.

El equipo de liderazgo combinó experiencia en startups, investigación y operaciones:

- Sam Altman – cofundador y presidente inicial de la junta (luego CEO)

- Elon Musk – cofundador y donante temprano, miembro de la junta en el período inicial

- Greg Brockman – ex CTO de Stripe, se incorporó como CTO y cofundador

- Ilya Sutskever – investigador líder en deep learning, se incorporó como científico jefe

- Wojciech Zaremba y John Schulman – cofundadores y líderes centrales de investigación

Esta mezcla de emprendimiento de Silicon Valley y investigación de primer nivel moldeó la cultura temprana de OpenAI: muy ambiciosa respecto a empujar la frontera de capacidades, pero organizada como un nonprofit orientado a un impacto global a largo plazo en lugar de la comercialización inmediata.

Era sin fines de lucro: investigación temprana y ciencia abierta

Cuando OpenAI se lanzó como laboratorio sin fines de lucro en 2015, su promesa pública era simple pero ambiciosa: avanzar la inteligencia artificial compartiendo tanto como fuera posible con la comunidad.

Abiertos por defecto

Los primeros años se definieron por una filosofía “abierto por defecto”. Se publicaban artículos con rapidez, el código solía liberarse y las herramientas internas se convirtieron en proyectos públicos. La idea era que acelerar el progreso científico ampliamente —y permitir el escrutinio— sería más seguro y beneficioso que concentrar capacidades dentro de una sola empresa.

Al mismo tiempo, la seguridad ya formaba parte de la conversación. El equipo discutía cuándo la apertura podría aumentar el riesgo de uso indebido y comenzó a bosquejar ideas para lanzamientos escalonados y revisiones de políticas, aunque esas ideas eran aún más informales que los procesos de gobernanza posteriores.

Áreas de investigación emblemáticas

El enfoque científico temprano de OpenAI abarcó varias áreas centrales:

- Aprendizaje por refuerzo (RL): Trabajos sobre agentes que dominaron juegos como Dota 2 y tareas de control complejo impulsaron algoritmos de RL, métodos de exploración y escalabilidad.

- Robótica: Experimentos con manos robóticas resolviendo tareas de manipulación mostraron cómo RL y simulación podían transferirse al mundo físico.

- Aprendizaje no supervisado y auto‑supervisado: Investigaciones sobre cómo los modelos pueden aprender a partir de grandes conjuntos de datos sin etiquetar, anticipando los modelos fundacionales posteriores.

Estos proyectos no buscaban tanto productos pulidos como probar qué era posible con deep learning, cómputo y regímenes de entrenamiento inteligentes.

Herramientas que moldearon una comunidad

Dos de los resultados más influyentes de esta era fueron OpenAI Gym y Universe.

- OpenAI Gym ofreció un conjunto común de entornos y benchmarks de RL. Estandarizó cómo los investigadores comparaban algoritmos y redujo drásticamente la barrera de entrada para nuevos laboratorios y estudiantes.

- Universe pretendía entrenar y evaluar agentes en una gran variedad de entornos de software existentes, desde juegos hasta aplicaciones web. Aunque Universe se retiró con el tiempo, cristalizó el interés en agentes de propósito general.

Ambos proyectos reflejaron el compromiso con infraestructura compartida en lugar de ventaja propietaria.

Cómo vieron OpenAI pares y medios

Durante este período sin fines de lucro, OpenAI fue retratada con frecuencia como un contrapeso motivado por la misión frente a los grandes laboratorios de IA de las tecnológicas. Sus pares valoraron la calidad de su investigación, la disponibilidad de código y entornos, y la disposición a participar en discusiones de seguridad.

La cobertura mediática enfatizó la combinación inusual de financiadores de alto perfil, una estructura no comercial y la promesa de publicar abiertamente. Esa reputación —como un laboratorio influyente, abierto y preocupado por consecuencias a largo plazo— fijó expectativas que después modelaron las reacciones a cada cambio estratégico de la organización.

Construyendo modelos potentes: de GPT‑1 a GPT‑3

El punto de inflexión en la historia de OpenAI fue su decisión de focalizarse en grandes modelos de lenguaje basados en transformadores. Este giro transformó a OpenAI de un laboratorio mayoritariamente centrado en investigación a una empresa conocida por modelos fundacionales sobre los que otros construyen.

GPT‑1 fue modesto según estándares posteriores —117 millones de parámetros, entrenado en BookCorpus— pero ofreció una prueba de concepto crucial.

En lugar de entrenar modelos separados para cada tarea de PLN, GPT‑1 mostró que un único modelo transformador, entrenado con un objetivo simple (predecir la siguiente palabra), podía adaptarse con un mínimo de ajuste fino a tareas como preguntas y respuestas, análisis de sentimiento y entailment textual.

Para la hoja de ruta interna de OpenAI, GPT‑1 validó tres ideas:

- La escala importa: modelos más grandes con más datos rinden mejor de forma sorprendentemente general

- Preentrenamiento + ajuste fino puede vencer a sistemas específicos por tarea

- Los transformadores son una arquitectura poderosa para el lenguaje

GPT‑2: capacidades y preocupaciones por uso indebido (2019)

GPT‑2 empujó la misma receta mucho más lejos: 1.500 millones de parámetros y un conjunto de datos web mucho mayor. Sus salidas eran a menudo sorprendentemente coherentes: artículos de varios párrafos, historias ficticias y resúmenes que, a simple vista, parecían escritos por humanos.

Esas capacidades generaron alarmas sobre posibles usos indebidos: propaganda automatizada, spam, acoso y noticias falsas a escala. En lugar de liberar el modelo completo de inmediato, OpenAI adoptó una estrategia de lanzamiento escalonado:

- Liberación inicial de un modelo más pequeño, con artículo técnico y ejemplos

- Continuar el red‑teaming interno y externo para explorar usos indebidos

- Liberación gradual de versiones más grandes a medida que OpenAI evaluaba riesgos

Este fue uno de los primeros ejemplos de alto perfil donde OpenAI vinculó explícitamente decisiones de despliegue con seguridad e impacto social, y moldeó cómo la organización pensó sobre divulgación, apertura y responsabilidad.

GPT‑3: escala, generalidad y la API (2020)

GPT‑3 escaló nuevamente —esta vez a 175.000 millones de parámetros. En lugar de confiar principalmente en el ajuste fino para cada tarea, GPT‑3 mostró aprendizaje “few‑shot” e incluso “zero‑shot”: el modelo podía a menudo realizar una tarea nueva simplemente a partir de instrucciones y unos pocos ejemplos en el prompt.

Ese nivel de generalidad cambió la forma en que tanto OpenAI como la industria pensaban sobre los sistemas de IA. En lugar de construir muchos modelos estrechos, un modelo grande podía servir como motor de propósito general para:

- Redacción publicitaria y generación de contenido

- Fragmentos de código y autocompletado

- Preguntas y respuestas, chat y aumento de búsqueda

Crucialmente, OpenAI decidió no publicar el código abierto de GPT‑3. El acceso se ofreció a través de una API comercial. Esta decisión marcó un giro estratégico:

- De publicar modelos a operarlos como servicio gestionado

- De laboratorio de investigación puro a proveedor de plataforma con clientes de pago

- De demos puntuales a un ecosistema de desarrolladores que construyen sobre los modelos de OpenAI

GPT‑1, GPT‑2 y GPT‑3 trazan un arco claro en la historia de OpenAI: escalar transformadores, descubrir capacidades emergentes, lidiar con seguridad y uso indebido, y sentar las bases comerciales que luego apoyarían productos como ChatGPT y el desarrollo continuado de GPT‑4 y más allá.

Reestructuración organizativa: OpenAI LP y el modelo de beneficio acotado

Para 2018, los líderes de OpenAI estaban convencidos de que permanecer como un pequeño laboratorio financiado por donaciones no sería suficiente para construir y dirigir con seguridad sistemas de IA muy grandes. Entrenar modelos de frontera ya requería decenas de millones de dólares en cómputo y talento, y las curvas de costo indicaban que lo siguiente sería mucho más costoso. Para competir por los mejores investigadores, escalar experimentos y asegurar acceso a infraestructura en la nube a largo plazo, OpenAI necesitaba una estructura que atrajera capital serio sin abandonar su misión original.

Por qué se creó OpenAI LP

En 2019, OpenAI lanzó OpenAI LP, una nueva sociedad limitada de “beneficio acotado”. El objetivo era desbloquear inversión externa de gran tamaño manteniendo la misión del nonprofit —asegurar que la AGI beneficie a toda la humanidad— en la cima de la jerarquía de toma de decisiones.

Las startups tradicionales financiadas por capital de riesgo rinden cuentas a accionistas que buscan retornos sin tope. Los fundadores de OpenAI temían que eso creara presión para priorizar beneficios sobre seguridad, apertura o despliegue cuidadoso. La estructura LP fue un compromiso: podía emitir participaciones parecidas a equity y recaudar dinero a gran escala, pero bajo un conjunto de reglas diferente.

Cómo funciona el modelo de beneficio acotado

En el modelo de beneficio acotado, inversionistas y empleados pueden obtener retornos sobre sus participaciones en OpenAI LP, pero solo hasta un múltiplo fijo de su inversión original (para inversores tempranos, a menudo citado hasta 100x, con topes menores en tramos posteriores). Una vez alcanzado ese tope, cualquier valor adicional creado debería fluir hacia la entidad sin fines de lucro matriz para ser usado conforme a su misión.

Esto contrasta con las startups típicas, donde el valor del equity puede, al menos teóricamente, crecer sin límite y donde maximizar el valor para los accionistas es la norma legal y cultural.

Relación entre el nonprofit y la LP

El nonprofit de OpenAI sigue siendo la entidad controladora. Su junta supervisa OpenAI LP y está mandatada para priorizar los intereses de la humanidad por encima de cualquier grupo particular de inversores o empleados.

Formalmente:

- El nonprofit posee la participación de control en OpenAI LP.

- La junta del nonprofit nombra al liderazgo clave y, en principio, puede anular decisiones que entren en conflicto con la misión.

- El deber fiduciario se enmarca alrededor de la carta del nonprofit, no de la optimización financiera pura.

Este diseño de gobernanza pretende dar a OpenAI la flexibilidad de financiación y contratación de una organización comercial, manteniendo el control orientado a la misión.

Debates y efecto en financiación y contratación

La reestructuración provocó debate dentro y fuera de la organización. Los partidarios argumentaron que era la única forma práctica de asegurar los miles de millones probablemente necesarios para la investigación de frontera sin renunciar por completo a la misión. Los críticos preguntaron si cualquier estructura que ofrezca grandes retornos podría realmente resistir la presión comercial y si los topes eran lo suficientemente bajos o claros.

En la práctica, OpenAI LP abrió la puerta a grandes inversiones estratégicas, la más notable con Microsoft, y permitió a la compañía ofrecer paquetes de compensación competitivos vinculados a potenciales revalorizaciones. Eso, a su vez, posibilitó que OpenAI ampliara sus equipos de investigación, ejecutara corridas de entrenamiento para modelos como GPT‑3 y GPT‑4, y construyera la infraestructura necesaria para desplegar sistemas como ChatGPT a escala global —todo manteniendo un vínculo formal de gobernanza con sus orígenes sin fines de lucro.

Alianza estratégica con Microsoft

Obtén créditos por referir

Invita a compañeros de equipo o amigos y gana créditos por referidos.

La inversión de 2019 y el acuerdo a largo plazo

En 2019, OpenAI y Microsoft anunciaron una asociación multianual que redefinió los roles de ambas compañías en IA. Microsoft invirtió aproximadamente 1.000 millones de dólares, combinando efectivo y créditos en Azure, a cambio de convertirse en el socio comercial preferente de OpenAI.

El acuerdo encajó con la necesidad de OpenAI de recursos masivos de cómputo para entrenar modelos cada vez más grandes, mientras daba a Microsoft acceso a IA de vanguardia que podía diferenciar sus productos y plataforma en la nube. En años posteriores, la relación se profundizó mediante financiamientos adicionales y colaboración técnica.

Azure como columna vertebral en la nube de OpenAI

OpenAI eligió Microsoft Azure como su plataforma en la nube principal por varias razones:

- Escala y hardware personalizado: Azure se comprometió a construir clústeres especializados con miles de GPU (y luego aceleradores personalizados) optimizados para entrenamiento a gran escala.

- Ingeniería conjunta: Ingenieros de OpenAI trabajaron estrechamente con equipos de Azure para optimizar redes, almacenamiento y orquestación específicamente para modelos de lenguaje grandes.

- Estructura financiera: La inversión y los créditos en la nube redujeron el costo inicial de experimentos que habrían sido prohibitivos en otros entornos.

Esto hizo de Azure el entorno por defecto para entrenar y servir modelos como GPT‑3, Codex y, más tarde, GPT‑4.

Co‑desarrollo de infraestructura de supercomputación

La asociación dio lugar a uno de los sistemas de supercomputación para IA más grandes del mundo, construido en Azure para las cargas de trabajo de OpenAI. Microsoft destacó estos clústeres como ejemplos emblemáticos de las capacidades de IA de Azure, mientras OpenAI los utilizó para impulsar tamaño de modelos, datos de entrenamiento y velocidad de experimentación.

Este esfuerzo de infraestructura conjunto difuminó la línea entre “cliente” y “socio”: OpenAI influyó en la hoja de ruta de IA de Azure, y Azure se afinó según las necesidades de OpenAI.

Licencias, productos y percepción pública

Microsoft obtuvo derechos de licencia exclusivos sobre algunas tecnologías de OpenAI, sobre todo GPT‑3. Eso permitió a Microsoft integrar los modelos de OpenAI en sus productos —Bing, Office, GitHub Copilot, Azure OpenAI Service— mientras que otras empresas accedían mediante la API de OpenAI.

Esa exclusividad alimentó el debate: los defensores dijeron que proporcionó la financiación y la distribución necesarias para escalar la IA poderosa de forma segura; los críticos temían que concentrara la influencia sobre modelos de frontera en una sola gran compañía tecnológica.

Al mismo tiempo, la asociación dio a OpenAI visibilidad masiva. El branding de Microsoft, las integraciones de producto y los canales de ventas empresariales ayudaron a mover los sistemas de OpenAI de demos de investigación a herramientas cotidianas usadas por millones, moldeando la percepción pública de OpenAI como un laboratorio independiente y al mismo tiempo un socio central de Microsoft en IA.

Avances más allá del texto: CLIP, DALL·E y Codex

A medida que los modelos de OpenAI mejoraron en comprender y generar lenguaje, el equipo se expandió a nuevas modalidades: imágenes y código. Este cambio amplió el trabajo de OpenAI más allá de la escritura y el diálogo hacia la creatividad visual y el desarrollo de software.

CLIP: conectar imágenes y lenguaje

CLIP (Contrastive Language–Image Pretraining), anunciado a inicios de 2021, fue un paso importante hacia modelos que entienden el mundo de manera más parecida a las personas.

En lugar de entrenar solo con imágenes etiquetadas, CLIP aprendió a partir de cientos de millones de pares imagen‑pie de foto extraídos de la web pública. Se entrenó para emparejar imágenes con sus descripciones textuales más probables y para distinguirlas de descripciones incorrectas.

Esto dio a CLIP habilidades sorprendentemente generales:

- Reconocer objetos y estilos sin entrenamiento específico por tarea

- Seguir prompts en lenguaje natural (p. ej., “una foto de un gato atigrado”) para clasificar imágenes

- Servir como columna vertebral visual flexible para otros sistemas

CLIP se convirtió en una base para trabajos generativos de imagen posteriores en OpenAI.

DALL·E y DALL·E 2: creatividad texto‑a‑imagen

DALL·E (2021) aplicó arquitecturas tipo GPT a imágenes, generando imágenes directamente a partir de prompts de texto: “un sillón con la forma de un aguacate” o “un letrero de tienda que diga ‘openai’”. Demostró que los modelos de lenguaje podían extenderse para producir imágenes coherentes y a menudo caprichosas.

DALL·E 2 (2022) mejoró notablemente resolución, realismo y control. Introdujo características como:

- Inpainting: editar partes de una imagen existente vía texto

- Outpainting: ampliar una imagen más allá de sus bordes originales

- Control de estilo y composición: dirigir la salida con prompts detallados

Estos sistemas cambiaron la forma en que diseñadores, publicistas, artistas y aficionados prototipan ideas, desplazando parte del trabajo creativo manual hacia una exploración iterativa guiada por prompts.

Codex y el futuro del desarrollo de software

Codex (2021) adaptó la familia GPT‑3 al código fuente, entrenando con grandes repositorios de código público. Puede traducir lenguaje natural en fragmentos funcionales para lenguajes como Python, JavaScript y muchos otros.

GitHub Copilot, construido sobre Codex, llevó esto a herramientas de desarrollo cotidianas. Los programadores empezaron a recibir funciones enteras, pruebas y boilerplate como sugerencias, usando comentarios en lenguaje natural como guía.

Para el desarrollo de software, Codex insinuó un cambio gradual:

- De escribir cada línea a supervisar y refinar borradores generados por la IA

- De memorizar sintaxis a centrarse en arquitectura, intención y revisión

Juntos, CLIP, DALL·E y Codex mostraron que el enfoque de OpenAI podía extenderse más allá del texto hacia visión y código, ampliando el impacto de su investigación en arte, diseño e ingeniería.

ChatGPT y el foco público

Lanza sin configuración extra

Lanza lo que construyas con opciones integradas de despliegue y alojamiento.

Lanzamiento y adopción explosiva

OpenAI lanzó ChatGPT como un “preview de investigación” gratuito el 30 de noviembre de 2022, anunciándolo en un breve post en el blog y un tuit en lugar de una campaña de producto masiva. El modelo se basó en GPT‑3.5 y se optimizó para diálogo, con salvaguardas que rechazaban algunas solicitudes dañinas o inseguras.

El uso se disparó casi de inmediato. Millones de personas se registraron en días, y ChatGPT se convirtió en una de las aplicaciones de consumo de más rápido crecimiento jamás vistas. Capturas de conversaciones inundaron las redes sociales mientras los usuarios probaban su capacidad para redactar ensayos, depurar código, redactar correos y explicar temas complejos en lenguaje sencillo.

Uso cotidiano en trabajo, escuela y hogar

El atractivo de ChatGPT surgió de su versatilidad más que de un caso de uso único.

En educación, estudiantes lo usaron para resumir lecturas, generar preguntas de práctica, traducir o simplificar artículos académicos y obtener explicaciones paso a paso de problemas de matemáticas o ciencia. Los docentes lo emplearon para diseñar sílabos, redactar rúbricas y crear materiales diferenciados, mientras las escuelas debatían si y cómo permitir su uso.

En el trabajo, profesionales pidieron a ChatGPT que redactara correos, textos de marketing e informes, bosquejara presentaciones, generara fragmentos de código, escribiera pruebas y sirviera como socio de lluvia de ideas para productos o estrategias. Freelancers y pequeñas empresas lo usaron como asistente de bajo costo para contenido y análisis.

En la vida diaria, las personas recurrieron a ChatGPT para planificar viajes, idear recetas con lo que tenían en la nevera, obtener explicaciones legales o médicas básicas (con la advertencia de consultar a un profesional) y aprender nuevas habilidades o idiomas.

De vista previa gratuita a ofertas de pago

La vista previa de investigación fue gratuita para reducir fricción y recopilar retroalimentación sobre fallos, usos indebidos y carencias. A medida que el uso creció, OpenAI afrontó costos de infraestructura altos y una demanda de acceso más fiable.

En febrero de 2023, OpenAI introdujo ChatGPT Plus, un plan de suscripción que ofrecía respuestas más rápidas, acceso prioritario en horas punta y acceso anticipado a nuevas funciones y modelos como GPT‑4. Esto creó una fuente de ingresos recurrente mientras mantenía una capa gratuita para acceso amplio.

Con el tiempo, OpenAI añadió opciones orientadas a empresas: acceso por API a los mismos modelos conversacionales, herramientas para integración en productos y flujos y ofertas como ChatGPT Enterprise y planes para equipos dirigidos a organizaciones que necesitan mayor seguridad, controles administrativos y cumplimiento.

Debate, regulación y preocupaciones éticas

La visibilidad repentina de ChatGPT intensificó debates de larga data sobre la IA.

Reguladores y políticos se preocuparon por privacidad, protección de datos y cumplimiento de leyes, especialmente en regiones como la Unión Europea. Algunas autoridades restringieron temporalmente o investigaron ChatGPT mientras evaluaban si la recolección y el procesamiento de datos cumplían la normativa.

Los educadores enfrentaron problemas de plagio e integridad académica, ya que estudiantes podían generar ensayos y tareas difíciles de detectar. Esto provocó prohibiciones o políticas estrictas en algunas escuelas, mientras otras ajustaron tareas hacia procesos, exámenes orales o trabajo en clase.

Éticos e investigadores alertaron sobre desinformación, dependencia excesiva en la IA para decisiones críticas, sesgo en respuestas y posibles impactos en empleos creativos y del conocimiento. También surgieron preguntas sobre datos de entrenamiento, derechos de autor y los derechos de artistas y escritores cuyo trabajo pudo haber influido en el comportamiento del modelo.

Para OpenAI, ChatGPT marcó un punto de inflexión: transformó la organización de un laboratorio centrado en investigación a una compañía en el centro de discusiones globales sobre cómo deben desplegarse, gobernarse e integrarse los modelos de lenguaje potentes en la vida cotidiana.

GPT‑4 y el avance de las capacidades de IA

De GPT‑3.5 a GPT‑4

OpenAI lanzó GPT‑4 en marzo de 2023 como un paso mayor respecto a GPT‑3.5, el modelo que inicialmente impulsó ChatGPT. GPT‑4 mejoró en razonamiento, seguir instrucciones complejas y mantener coherencia en conversaciones largas. También manejó mejor prompts matizados, como explicar cláusulas legales, resumir artículos técnicos o generar código a partir de requisitos ambiguos.

Comparado con GPT‑3.5, GPT‑4 redujo muchas fallas evidentes: era menos propenso a inventar fuentes cuando se le pedían citas, manejaba casos límite en matemáticas y lógica con más fiabilidad y producía salidas más consistentes ante consultas repetidas.

Multimodalidad y desempeño en benchmarks

GPT‑4 introdujo capacidades multimodales: además de texto, puede aceptar imágenes como entrada en algunas configuraciones. Esto habilita casos de uso como describir gráficos, leer notas manuscritas, interpretar capturas de pantalla de interfaces o analizar fotos para extraer información estructurada.

En benchmarks estandarizados, GPT‑4 superó significativamente a modelos previos. Alcanzó puntuaciones cercanas a percentiles superiores en exámenes profesionales simulados como el examen de abogado, el SAT y diversas pruebas avanzadas. También mejoró en benchmarks de codificación y razonamiento, reflejando habilidades más fuertes tanto en comprensión del lenguaje como en resolución de problemas.

Impacto en el ecosistema y desafíos pendientes

GPT‑4 se convirtió rápidamente en el núcleo de la API de OpenAI y alimentó una nueva oleada de productos de terceros: copilotos de productividad, asistentes de codificación, herramientas de soporte al cliente, plataformas educativas y aplicaciones verticales en campos como derecho, finanzas y salud.

A pesar de estos avances, GPT‑4 todavía alucina, puede ser inducido a generar salidas inseguras o sesgadas y carece de comprensión genuina o conocimiento actualizado. OpenAI centró grandes esfuerzos en investigación de alineación para GPT‑4 —usando técnicas como RLHF, red‑teaming y reglas de seguridad a nivel de sistema— pero enfatiza que el despliegue cuidadoso, la monitorización y la investigación continua son necesarios para gestionar riesgos y usos indebidos.

Seguridad, alineación y gobernanza en OpenAI

Desde sus primeros años, OpenAI presentó la seguridad y la alineación como núcleo de su misión, no como un complemento posterior a los lanzamientos de productos. La organización ha declarado consistentemente que su objetivo es construir sistemas de IA altamente capaces alineados con valores humanos y desplegarlos de forma que beneficien a todos, no solo a accionistas o socios tempranos.

La OpenAI Charter y prioridades declaradas

En 2018, OpenAI publicó la OpenAI Charter, que formalizó sus prioridades:

- Crear una AGI ampliamente beneficiosa y evitar usos que puedan dañar a la humanidad.

- Cooperar con otras instituciones de investigación y políticas en materia de seguridad.

- Estar dispuesto a asistir a otros proyectos si están más cerca de una AGI segura que OpenAI misma.

La Carta actúa como brújula de gobernanza, moldeando decisiones sobre direcciones de investigación, velocidad de despliegue y asociaciones externas.

Estructuras de seguridad, políticas y red‑teaming

A medida que los modelos se hicieron más capaces, OpenAI construyó funciones dedicadas de seguridad y gobernanza junto a sus equipos de investigación principales:

- Grupos de investigación en alineación y seguridad exploran cómo lograr que los modelos se comporten según la intención humana, incluso bajo presión o prompts adversariales.

- Equipos de política y gobernanza analizan impactos sociales, gestionan políticas de despliegue responsable e interactúan con gobiernos y organismos normativos.

- Programas de red‑teaming invitan a especialistas internos y expertos externos a poner a prueba modelos en busca de usos indebidos, sesgos, vulnerabilidades de seguridad y otros comportamientos dañinos antes del lanzamiento.

Estos grupos influyen en decisiones de lanzamiento, niveles de acceso y políticas de uso para modelos como GPT‑4 y DALL·E.

Técnicas: RLHF y más allá

Un enfoque técnico definitorio ha sido el reinforcement learning from human feedback (RLHF). Etiquetadores humanos revisan las salidas del modelo, las ordenan y entrenan un modelo de recompensa. Luego, el modelo principal se optimiza para producir respuestas más cercanas al comportamiento preferido por humanos, reduciendo salidas tóxicas, sesgadas o inseguras.

Con el tiempo, OpenAI ha complementado RLHF con técnicas adicionales: políticas de seguridad a nivel de sistema, filtros de contenido, ajustes finos para dominios específicos y herramientas de monitorización que pueden restringir o marcar usos de alto riesgo.

Colaboración externa y marcos públicos

OpenAI ha participado en marcos públicos de seguridad, como compromisos voluntarios con gobiernos, prácticas de reporte de modelos y estándares de seguridad para modelos de frontera. Ha colaborado con académicos, organizaciones de la sociedad civil e investigadores de seguridad en evaluaciones, red‑teaming y auditorías.

Estas colaboraciones, junto con documentos formales como la Carta y políticas de uso en evolución, conforman la columna vertebral del enfoque de OpenAI para gobernar sistemas de IA cada vez más potentes.

Controversias, críticas y tensiones internas

Gana créditos por contenido

Crea contenido sobre Koder.ai y recibe créditos para seguir construyendo.

El rápido ascenso de OpenAI ha estado acompañado de críticas y tensiones internas, muchas centradas en cuánto sigue la organización alineada con su misión original de beneficio amplio y seguro.

De la ciencia “abierta” a modelos cerrados

Al principio, OpenAI enfatizaba la publicación y el compartir. Con el aumento de capacidad de modelos como GPT‑2, GPT‑3 y GPT‑4, la compañía se desplazó hacia liberaciones limitadas, acceso por API y menos detalles técnicos públicos.

Los críticos argumentan que este movimiento contradice la promesa implícita del nombre “OpenAI”. Los defensores dentro de la compañía sostienen que retener pesos completos y detalles de entrenamiento es necesario para gestionar riesgos y preocupaciones de seguridad.

OpenAI ha respondido publicando evaluaciones de seguridad, fichas de sistema y documentos de política, manteniendo la propiedad de los pesos centrales. Presenta esto como un equilibrio entre apertura, seguridad y presión competitiva.

Poder, datos y comercialización

Al profundizar la asociación con Microsoft —integrando modelos en Azure y productos como Copilot— surgieron preocupaciones sobre concentración de cómputo, datos y poder de decisión.

Los críticos temen que unas pocas empresas controlen ahora los modelos general‑propósito más avanzados y la vasta infraestructura subyacente. Otros señalan que la comercialización agresiva (ChatGPT Plus, ofertas empresariales y licencias exclusivas) se aleja de la misión original de beneficio ampliamente compartido.

La dirección de OpenAI ha enmarcado los ingresos como necesarios para financiar investigación costosa, manteniendo una estructura de beneficio acotado y una carta que prioriza los intereses de la humanidad. También ha introducido programas como niveles de acceso gratuitos, asociaciones de investigación y algunas herramientas de código abierto para demostrar beneficio público.

Tensiones de liderazgo y salidas de alto perfil

Discrepancias internas sobre la velocidad de avance, el grado de apertura y la prioridad de la seguridad han aflorado repetidamente.

Dario Amodei y otros se marcharon en 2020 para fundar Anthropic, citando diferencias en visiones sobre seguridad y gobernanza. Posteriormente, dimisiones de investigadores clave en seguridad, incluida Jan Leike en 2024, destacaron públicamente preocupaciones de que objetivos de producto a corto plazo pudieran anteponerse al trabajo de seguridad a largo plazo.

La ruptura más visible ocurrió en noviembre de 2023, cuando la junta destituyó brevemente al CEO Sam Altman citando una pérdida de confianza. Tras una fuerte reacción de empleados y negociaciones con Microsoft y otras partes, Altman volvió, la junta fue reconstituida y OpenAI prometió reformas de gobernanza, incluida una nueva Comisión de Seguridad y Protección.

Estos episodios subrayaron que la organización aún lucha por reconciliar despliegue rápido, éxito comercial y responsabilidades declaradas sobre seguridad y beneficio amplio.

El papel evolutivo de OpenAI en el futuro de la IA

OpenAI ha pasado de un pequeño laboratorio de investigación a un proveedor central de infraestructura para IA, influyendo en cómo se construyen, regulan y entienden las nuevas herramientas.

En lugar de solo publicar modelos, OpenAI ahora opera una plataforma completa usada por startups, empresas y desarrolladores individuales. A través de APIs para modelos como GPT‑4, DALL·E y sistemas futuros, se ha convertido en:

- Una base técnica para productos en salud, educación, herramientas de desarrolladores e industrias creativas

- Un punto de referencia para benchmarks, mejores prácticas y funciones de seguridad que otros laboratorios adoptan o critican

Este rol de plataforma significa que OpenAI no solo avanza la investigación: establece los valores predeterminados para cómo millones de personas experimentan por primera vez la IA poderosa.

Moldeando investigación, industria y política

El trabajo de OpenAI impulsa a competidores y comunidades de código abierto a responder con nuevos modelos, métodos de entrenamiento y enfoques de seguridad. Esa competencia acelera el progreso mientras agudiza debates sobre apertura, centralización y comercialización de la IA.

Gobiernos y reguladores miran cada vez más las prácticas, informes de transparencia e investigaciones de alineación de OpenAI al redactar reglas para el despliegue de IA, evaluaciones de seguridad y uso responsable. Las conversaciones públicas sobre ChatGPT, GPT‑4 y sistemas futuros influyen fuertemente en cómo la sociedad imagina riesgos y beneficios de la IA.

Preguntas abiertas: poder, equidad y responsabilidad

A medida que los modelos crecen en capacidad, asuntos no resueltos sobre el papel de OpenAI se vuelven más importantes:

- ¿Qué grado de concentración es aceptable sobre quién controla los modelos de frontera?

- ¿Quién obtiene acceso temprano o preferente —y en qué condiciones?

- ¿Cómo se gobiernan los datos de entrenamiento, el impacto ambiental y las auditorías externas de seguridad?

- ¿Qué obligaciones tiene OpenAI con personas y países que no son clientes pero se ven afectados por sus tecnologías?

Estas preguntas determinarán si los sistemas de IA futuros amplifican las desigualdades existentes o contribuyen a reducirlas.

Cómo relacionarse con OpenAI hoy

Desarrolladores y empresas pueden:

- Construir sobre las APIs de OpenAI incorporando controles de seguridad independientes, red‑teaming y monitorización

- Combinar modelos de OpenAI con herramientas de código abierto para evitar dependencia excesiva en un único proveedor

- Participar en programas de retroalimentación, consultas de política y colaboraciones de investigación cuando sea posible

Las personas pueden:

- Aprender cómo funcionan los modelos, cuáles son sus limitaciones y cómo se usan los datos

- Usar herramientas de IA críticamente: verificar salidas, evitar la dependencia excesiva y reportar comportamientos dañinos

La influencia futura de OpenAI dependerá no solo de sus decisiones internas, sino de cómo gobiernos, competidores, sociedad civil y usuarios cotidianos elijan comprometerse, criticar y exigir responsabilidad sobre los sistemas que construye.