Por qué la claridad importa en cloud-native

Las herramientas cloud-native prometen velocidad y flexibilidad, pero también introducen vocabulario nuevo, piezas móviles nuevas y formas distintas de pensar la operación. Cuando la explicación es difusa, la adopción se ralentiza por una razón simple: la gente no puede conectar la herramienta con los problemas que realmente tiene. Los equipos dudan, los líderes posponen decisiones y los experimentos tempranos se convierten en pilotos a medias.

La claridad cambia esa dinámica. Una explicación clara convierte “Kubernetes explicado” de una frase de marketing a una comprensión compartida: qué hace Kubernetes, qué no hace y de qué es responsable tu equipo día a día. Una vez que ese modelo mental está en su sitio, las conversaciones se vuelven prácticas: sobre cargas de trabajo, fiabilidad, escalado, seguridad y los hábitos operativos necesarios para ejecutar sistemas en producción.

Por qué las buenas explicaciones aceleran la adopción

Cuando los conceptos se explican en lenguaje llano, los equipos:

- Evalúan los trade-offs más rápido (y dejan de considerar cada característica como obligatoria).

- Identifican los prerequisitos pronto (habilidades, propiedad, expectativas de on-call).

- Reducen el miedo a “romper producción” porque el sistema parece comprensible.

- Construyen alineamiento entre desarrolladores, ops, SRE y liderazgo.

En otras palabras, la comunicación no es algo deseable; es parte del plan de despliegue.

Qué aprenderás en este artículo

Este texto se centra en cómo el estilo de enseñanza de Kelsey Hightower hizo que conceptos clave de DevOps y fundamentos de Kubernetes resultaran accesibles —y cómo ese enfoque influyó en una adopción cloud-native más amplia. Te irás con lecciones aplicables dentro de tu propia organización:

- Cómo explicar decisiones de ingeniería de plataformas sin jerga.

- Cómo enseñar el “por qué” detrás de la excelencia operativa, no solo el “cómo”.

- Cómo el intercambio de conocimiento impulsado por la comunidad acelera la adopción en el mundo real.

El objetivo no es debatir herramientas. Es mostrar cómo la comunicación clara —repetida, compartida y mejorada por la comunidad— puede mover a una industria de la curiosidad al uso con confianza.

Quién es Kelsey Hightower (y por qué la gente le escucha)

Kelsey Hightower es una voz conocida en la educación sobre Kubernetes y en la comunidad cloud-native; su trabajo ha ayudado a muchos equipos a entender qué implica realmente la orquestación de contenedores —especialmente las partes operativas que la gente suele aprender a las malas.

Ha tenido visibilidad en roles prácticos y públicos: conferencias del sector, tutoriales y participando en la comunidad más amplia donde los practicantes comparten patrones, fallos y soluciones. En lugar de presentar Kubernetes como un producto mágico, su material tiende a tratarlo como un sistema que debes operar —uno con piezas móviles, trade-offs y modos reales de fallo.

Una voz que resuena con operadores (y principiantes)

Lo que destaca consistentemente es la empatía por las personas que están al cargo cuando algo se rompe: ingenieros on-call, equipos de plataforma, SREs y desarrolladores que intentan entregar mientras aprenden nueva infraestructura.

Esa empatía se nota en cómo explica:

- De qué es responsable Kubernetes (y de qué no).

- De dónde viene la complejidad (sistemas distribuidos, redes, identidad, actualizaciones).

- Cómo construir intuición en lugar de memorizar comandos.

También se aprecia en la forma de hablar con principiantes sin condescendencia. El tono suele ser directo, fundamentado y cuidadoso con las afirmaciones—más “esto es lo que pasa bajo el capó” que “esta es la única forma correcta”.

Trabajo observable por encima de la personalidad

No necesitas convertir a nadie en una mascota para ver el impacto. La evidencia está en el material mismo: charlas ampliamente referenciadas, recursos prácticos y explicaciones que reutilizan otros educadores y equipos de plataforma internos. Cuando la gente dice que “finalmente entendió” un concepto como planos de control, certificados o el arranque de un clúster, a menudo es porque alguien lo explicó con claridad —y muchas de esas explicaciones rastrean su estilo de enseñanza.

Si la adopción de Kubernetes es en parte un problema de comunicación, su influencia recuerda que la enseñanza clara también es una forma de infraestructura.

Kubernetes antes de que pareciera accesible

Antes de que Kubernetes se convirtiera en la respuesta por defecto a “¿cómo ejecutamos contenedores en producción?”, a menudo parecía un muro denso de vocabulario y suposiciones nuevas. Incluso equipos cómodos con Linux, CI/CD y servicios en la nube se encontraban haciendo preguntas básicas —y luego sintiendo que no deberían tener que hacerlas.

Confusión temprana: términos nuevos, modelos mentales nuevos

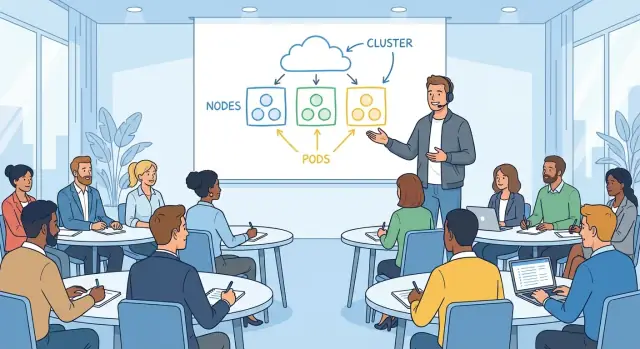

Kubernetes introdujo una forma distinta de pensar las aplicaciones. En lugar de “un servidor ejecuta mi app”, de repente existían pods, deployments, services, ingresses, controllers y clusters. Cada término sonaba simple por sí solo, pero su significado dependía de cómo se conectaba con el resto.

Un punto de fricción común era el desajuste de modelos mentales:

- “¿Dónde hago SSH?” (A menudo: no lo haces.)

- “¿En qué máquina está mi app?” (Puede cambiar.)

- “¿Por qué se reinició?” (Está diseñado para hacerlo.)

No se trataba solo de aprender una herramienta; era aprender un sistema que trata la infraestructura como algo fluido.

Miedos comunes: fiabilidad, seguridad y operaciones del día 2

La primera demo puede mostrar un contenedor escalando sin problemas. La ansiedad aparece después, cuando la gente imagina las preguntas operativas reales:

- ¿Qué pasa cuando falla un nodo?

- ¿Cómo gestionamos secretos de forma segura?

- ¿Quién tiene acceso a qué en el clúster?

- ¿Cómo parcheamos, actualizamos y revertimos sin romper producción?

Muchos equipos no temían al YAML: temían la complejidad oculta, donde los errores pueden ser silenciosos hasta un outage.

La brecha entre las promesas de marketing y la configuración real

Kubernetes se presentaba a menudo como una plataforma ordenada donde “simplemente despliegas” y todo está automatizado. En la práctica, llegar a esa experiencia requería decisiones: redes, almacenamiento, identidad, políticas, monitorización, logging y estrategia de actualizaciones.

Esa brecha creó frustración. La gente no estaba rechazando Kubernetes; reaccionaba a lo difícil que era conectar la promesa (“simple, portable, self-healing”) con los pasos necesarios para hacerla realidad en su entorno.

Un estilo de enseñanza pensado para ingenieros en activo

Kelsey Hightower enseña como alguien que ha estado on-call, ha visto una despliegue salir mal y aun así tuvo que entregar al día siguiente. El objetivo no es impresionar con vocabulario: es ayudarte a construir un modelo mental que puedas usar a las 2 a.m. cuando suene un pager.

Lenguaje llano, justo cuando lo necesitas

Un hábito clave es definir términos en el momento en que importan. En lugar de soltar un párrafo de vocabulario de Kubernetes al principio, explica un concepto en contexto: qué es un Pod en la misma frase que por qué agruparías contenedores, o qué hace un Service cuando la pregunta es “¿cómo encuentran las solicitudes mi app?”.

Este enfoque reduce la sensación de “voy atrasado” que muchos ingenieros tienen con temas cloud-native. No necesitas memorizar un glosario; aprendes siguiendo un problema hasta su solución.

Ejemplos concretos por encima de diagramas abstractos

Sus explicaciones suelen empezar con algo tangible:

- “Si este proceso muere, ¿qué lo reinicia?”

- “Si el nodo desaparece, ¿qué pasa con el tráfico?”

- “Si escalamos de 2 a 20 instancias, ¿cómo mantienen los clientes la conexión?”

Esas preguntas conducen de forma natural a los primitivos de Kubernetes, pero están ancladas en escenarios que los ingenieros reconocen de sistemas reales. Los diagramas ayudan, pero no son toda la lección: el ejemplo hace el trabajo pesado.

Respeto por la realidad operativa

Lo más importante: la enseñanza incluye las partes poco glamurosas: actualizaciones, incidentes y trade-offs. No es “Kubernetes lo hace fácil”, es “Kubernetes te da mecanismos: ahora debes operarlos”.

Eso significa reconocer restricciones:

- El desfasaje de versiones y la planificación de upgrades no son opcionales.

- La observabilidad no es una casilla; es cómo depuras fallos distribuidos.

- La carga on-call es parte del diseño del sistema, no un apéndice.

Por eso su contenido resuena con ingenieros en activo: trata la producción como aula y la claridad como una forma de respeto.

“Kubernetes the Hard Way”: aprender los fundamentos

Practica cambios seguros

Usa snapshots y rollback para ensayar despliegues sin miedo a romper tu sandbox.

“Kubernetes the Hard Way” es memorable no porque sea difícil por el puro hecho de serlo, sino porque te obliga a tocar las partes que la mayoría de los tutoriales ocultan. En lugar de pasar por un asistente de un servicio gestionado, montas un clúster pieza por pieza. Ese enfoque de “aprender haciendo” convierte la infraestructura de caja negra a un sistema que puedes razonar.

Cómo es aprender haciendo

El recorrido te hace crear los bloques constructivos tú mismo: certificados, kubeconfigs, componentes del plano de control, red y configuración de nodos trabajadores. Aunque nunca planees ejecutar Kubernetes así en producción, el ejercicio enseña de qué es responsable cada componente y qué puede fallar cuando está mal configurado.

No solo escuchas “etcd es importante”: ves por qué importa, qué guarda y qué pasa si no está disponible. No memorizarás solo “el API server es la puerta de entrada”: lo configuras y entiendes qué claves verifica antes de permitir peticiones.

Por qué empezar desde lo básico genera confianza

Muchos equipos se sienten incómodos adoptando Kubernetes porque no pueden decir qué ocurre bajo el capó. Construir desde lo básico invierte esa sensación. Cuando entiendes la cadena de confianza (certs), la fuente de la verdad (etcd) y la idea de bucle de control (controladores que reconcilian constantemente el estado deseado y el real), el sistema deja de ser misterioso.

Esa confianza es práctica: te ayuda a evaluar características de proveedores, a interpretar incidentes y a elegir valores por defecto sensatos. Puedes decir “sabemos qué está abstrayendo este servicio gestionado” en lugar de esperar que sea correcto.

Paso a paso reduce el miedo a la complejidad

Un buen tutorial descompone “Kubernetes” en pasos pequeños y comprobables. Cada paso tiene un resultado esperado claro: el servicio arranca, una comprobación de salud pasa, un nodo se une. El progreso es medible y los errores son locales.

Esa estructura baja la ansiedad: la complejidad se convierte en una serie de decisiones entendibles, no en un salto único al vacío.

Haciendo comprensibles los conceptos centrales de Kubernetes

Mucha confusión viene de tratar Kubernetes como un montón de características en lugar de una promesa simple: describes lo que quieres y el sistema intenta constantemente que la realidad coincida con ello.

Estado deseado (lo que quieres)

“Estado deseado” es simplemente tu equipo escribiendo el resultado que espera: ejecutar tres copias de esta app, exponerla en una dirección estable, limitar cuánto CPU puede usar. No es un runbook paso a paso.

Esa distinción importa porque refleja el trabajo operacional cotidiano. En lugar de “SSH al servidor A, arranca el proceso, copia la configuración”, declaras el objetivo y dejas que la plataforma gestione los pasos repetitivos.

Reconciliación (cómo se mantiene fiel)

La reconciliación es el bucle de comprobación y corrección continuo. Kubernetes compara lo que hay ahora con lo que pediste y, si algo se ha desviado —un app se cayó, un nodo desapareció, una configuración cambió— actúa para cerrar la brecha.

En términos humanos: es un ingeniero on-call que nunca duerme, re-aplicando continuamente el estándar acordado.

Aquí también ayuda separar conceptos de detalles de implementación. El concepto es “el sistema corrige la deriva”. La implementación puede implicar controladores, replica sets o estrategias de rollout —pero puedes aprender eso después sin perder la idea central.

Scheduling (dónde se ejecuta)

El scheduling responde a una pregunta práctica: ¿qué máquina debe ejecutar esta carga? Kubernetes mira capacidad disponible, restricciones y políticas, y coloca el trabajo en nodos.

Conectar los primitivos con tareas familiares hace que todo encaje:

- Pods son una unidad ejecutable (como un grupo de procesos).

- Deployments son “mantener N copias en marcha y actualizar de forma segura”.

- Services son “dame una forma estable de alcanzar la app, incluso cuando las instancias cambien”.

Si encuadras Kubernetes como “declara, reconcilia, coloca”, lo demás se vuelve vocabulario: útil, pero ya no misterioso.

Explicar operaciones sin intimidar

El lenguaje de operaciones puede sonar como una jerga privada: SLIs, presupuestos de error, “blast radius”, “planificación de capacidad”. Cuando la gente se siente excluida, asiente o evita el tema —ambos resultados conducen a sistemas frágiles.

El estilo de Kelsey hace que ops parezca ingeniería normal: un conjunto de preguntas prácticas que puedes aprender a formular, aunque seas nuevo.

Traducir ops a decisiones cotidianas

En lugar de presentar operaciones como “mejores prácticas” abstractas, tradúcelo a lo que tu servicio debe hacer bajo presión.

La fiabilidad se convierte en: ¿qué se rompe primero y cómo lo notaremos? La capacidad: ¿qué ocurre con el tráfico el lunes por la mañana? Los modos de fallo: ¿qué dependencia nos mentirá, hará timeout o devolverá datos parciales? La observabilidad: si un cliente se queja, ¿podemos responder “qué cambió” en cinco minutos?

Fraseadas así, las operaciones dejan de sonar a trivialidades y pasan a sentido común.

Hacer explícitos los trade-offs (y aceptables)

Las buenas explicaciones no afirman un único camino correcto: muestran el coste de cada elección.

Simplicidad vs. control: un servicio gestionado puede reducir el trabajo tedioso, pero limitar la sintonía fina.

Velocidad vs. seguridad: entregar rápido puede significar menos controles hoy y más tiempo debuggeando producción mañana.

Nombrar los trade-offs con claridad permite a los equipos discrepar de forma productiva sin avergonzar a nadie por “no entender”.

Normalizar preguntas, errores e iteración

Las operaciones se aprenden observando incidentes reales y casi-fallos, no memorizando terminología. Una cultura sana trata las preguntas como trabajo, no como debilidad.

Un hábito práctico: tras un incidente o una alerta alarmante, anotar tres cosas: qué esperabas que pasara, qué pasó realmente y qué señal te habría avisado antes. Ese pequeño ciclo convierte la confusión en runbooks mejores, dashboards más claros y rotaciones on-call más calmadas.

Si quieres que esta mentalidad se extienda, enséñala igual: palabras sencillas, trade-offs honestos y permiso para aprender en voz alta.

Cómo las explicaciones claras se extienden en una comunidad

Enseña y gana créditos

Publica lo que crees y gana créditos para más proyectos en Koder.ai.

Las explicaciones claras no solo ayudan a una persona a “entender”. Viajan. Cuando un orador o escritor hace que Kubernetes parezca concreto —mostrando qué hace cada pieza, por qué existe y dónde falla en la vida real— esas ideas se repiten en charlas de pasillo, se copian a docs internas y se re-enseñan en meetups.

Un vocabulario compartido que reduce fricción

Kubernetes tiene muchos términos que suenan familiares pero significan algo específico: cluster, node, control plane, pod, service, deployment. Cuando las explicaciones son precisas, los equipos dejan de hablar por encima del otro.

Algunos ejemplos:

- Un desarrollador dice “el Service está roto” y todos entienden si eso significa DNS, balanceo o selectors.

- Un SRE dice “el control plane está degradado” y el equipo sabe que no es lo mismo que “la app está caída”.

- Product oye “deployment” y aprende que es un objeto de Kubernetes, no solo “enviamos código”.

Ese alineamiento acelera la depuración, la planificación y la incorporación porque la gente pasa menos tiempo traduciendo.

La confianza vence a la ansiedad

Muchos ingenieros evitan Kubernetes al principio no porque no puedan aprenderlo, sino porque parece una caja negra. La enseñanza clara reemplaza el misterio por un modelo mental: “aquí habla con qué, aquí vive el estado, así se enruta el tráfico”.

Una vez que el modelo encaja, experimentar parece más seguro. La gente está más dispuesta a:

- levantar un clúster pequeño para probar ideas

- leer logs y eventos sin conjeturar

- hacer mejores preguntas en code reviews y canales de incidentes

El efecto dominó: charlas, meetups y documentación

Cuando una explicación es memorable, la comunidad la repite. Un diagrama o analogía sencilla se convierte en la forma por defecto de enseñar e influye en:

- presentaciones en meetups y conferencias (nuevos ponentes toman el encuadre)

- estilo de documentación open source (más “por qué” junto al “cómo”)

- runbooks internos y guías de incorporación (pasos y expectativas más claras)

Con el tiempo, la claridad se vuelve un artefacto cultural: la comunidad aprende no solo Kubernetes, sino cómo hablar de operarlo.

Cómo la comunicación influyó en la adopción industrial

La comunicación clara no solo hizo Kubernetes más fácil de aprender: cambió cómo las organizaciones decidían adoptarlo. Cuando los sistemas complejos se explican con términos claros, el riesgo percibido baja y los equipos pueden hablar de resultados en lugar de jerga.

Por qué importaba a los decisores

Ejecutivos y líderes de TI rara vez necesitan cada detalle de implementación, pero sí una historia creíble sobre trade-offs. Explicaciones directas sobre lo que Kubernetes es (y no es) ayudaron a enmarcar conversaciones sobre:

- Riesgo: qué puede romper, qué es estable y qué requiere un despliegue cuidadoso

- Coste y ROI: dónde la automatización reduce el trabajo tedioso, dónde aumentan las necesidades de personal y cuándo la estandarización paga

- Responsabilidad: quién opera clústeres, seguridad y expectativas de uptime

Cuando Kubernetes se presentó como bloques constructivos entendibles —en lugar de una plataforma mágica— las discusiones de presupuesto y calendario fueron menos especulativas. Eso facilitó ejecutar pilotos y medir resultados reales.

Cómo la educación apoyó la adopción

La adopción del sector no se difundió solo por pitches de proveedores; se extendió por la enseñanza. Charlas de alto valor, demos y guías prácticas crearon un vocabulario compartido entre empresas y roles.

Esa educación se tradujo típicamente en tres aceleradores de adopción:

- Programas de formación que redujeron el tiempo de incorporación para ingenieros y operadores

- Habilitación interna (docs, brown-bags, plantillas) que convirtieron conocimiento tribal en práctica reusable

- Campeones que podían explicar el “por qué” y el “cómo” a sus pares, no solo implementar el “qué”

Una vez que los equipos podían explicar conceptos como estado deseado, controladores y estrategias de rollout, Kubernetes pasó a ser discutible —y por tanto adoptable.

Donde la claridad no lo resuelve todo

Ni las mejores explicaciones sustituyen al cambio organizacional. La adopción de Kubernetes sigue exigiendo:

- Nuevas habilidades operativas (fiabilidad, respuesta a incidentes, higiene de seguridad)

- Propiedad clara de la plataforma y límites de servicio

- Tiempo para refactorizar procesos de entrega, no solo “instalar un clúster”

La comunicación hizo que Kubernetes fuera accesible; la adopción exitosa aún requiere compromiso, práctica e incentivos alineados.

Lecciones prácticas para equipos que adoptan Kubernetes

Prototipa la historia de la plataforma

Convierte tu idea en una app funcional en React y Go que puedas explicar de principio a fin.

La adopción suele fallar por razones ordinarias: la gente no puede predecir cómo funcionarán las operaciones del día 2, no saben qué aprender primero y la documentación asume que todos ya hablan “cluster”. La solución práctica es tratar la claridad como parte del plan de despliegue —no como algo secundario.

Construye dos rutas de aprendizaje (y di cuál es cada una)

La mayoría de los equipos mezcla “cómo usar Kubernetes” con “cómo operarlo”. Separa la habilitación en dos caminos explícitos:

- Camino para principiantes: conceptos centrales, cómo desplegar, cómo depurar una carga básica, qué es “bueno”.

- Camino de operador: ciclo de vida del clúster, upgrades, redes, límites de seguridad, backup/restore y respuesta a incidentes.

Coloca la división al inicio de tus docs para que las incorporaciones no empiecen accidentalmente por lo profundo.

Demuestra como si enseñaras un hábito, no un producto

Las demos deberían empezar con el sistema mínimo que funciona y añadir complejidad solo cuando sea necesario para responder a una pregunta real.

Empieza con un Deployment y un Service. Luego añade configuración, health checks y autoscaling. Solo cuando lo básico esté estable introduce ingress controllers, service meshes u operadores personalizados. La meta es que la gente conecte causa y efecto, no memorice YAML.

Escribe runbooks que expliquen el “por qué”, no solo el “haz esto”

Los runbooks que son listas de verificación puras se convierten en operaciones cargo-cult. Cada paso importante debería incluir una frase de justificación: qué síntoma aborda, cómo se ve el éxito y qué puede ir mal.

Por ejemplo: “Reiniciar el pod limpia un pool de conexiones atascado; si vuelve a ocurrir en 10 minutos, revisa latencia downstream y eventos del HPA.” Ese “por qué” permite improvisar cuando el incidente no encaja exactamente con el guion.

Mide comprensión, no asistencia

Sabrás que tu formación funciona cuando:

- Las mismas preguntas dejan de repetirse en Slack.

- El triage de incidentes es más rápido porque la gente comparte un modelo mental común.

- Los postmortems incluyen menos “no sabíamos dónde mirar”.

Mide esos resultados y ajusta docs y talleres en consecuencia. La claridad es un entregable: trátala como tal.

Una forma infrautilizada de hacer que Kubernetes y los conceptos de plataforma “encajen” es dejar que los equipos experimenten con servicios realistas antes de tocar entornos críticos. Eso puede ser crear una app de referencia interna pequeña (API + UI + base de datos) y usarla como ejemplo consistente en docs, demos y ejercicios de troubleshooting.

Plataformas como Koder.ai pueden ayudar porque permiten generar una app web funcional, servicio backend y modelo de datos desde una especificación conversacional, y luego iterar en un modo de planificación antes de que alguien se preocupe por el YAML perfecto. La idea no es reemplazar el aprendizaje de Kubernetes: es acortar el tiempo de idea → servicio en marcha para que tu formación se centre en el modelo operativo (estado deseado, rollouts, observabilidad y cambios seguros).

La vía más rápida para que la “plataforma” funcione en una compañía es hacerla comprensible. No necesitas que todo ingeniero sea experto en Kubernetes, pero sí necesitas vocabulario compartido y la confianza para depurar problemas básicos sin pánico.

Un marco repetible: definir, mostrar, practicar, solucionar

Definir: Empieza con una frase clara. Ejemplo: “Un Service es una dirección estable para un conjunto cambiante de Pods.” Evita soltar cinco definiciones a la vez.

Mostrar: Demuestra el concepto en el ejemplo más pequeño posible. Un archivo YAML, un comando, un resultado esperado. Si no puedes mostrarlo rápido, el alcance es demasiado amplio.

Practicar: Da una tarea corta que la gente pueda hacer (incluso en un sandbox). “Escala este Deployment y observa qué pasa con el endpoint del Service.” Aprender se afianza cuando las manos tocan las herramientas.

Solucionar: Termina rompiéndolo a propósito y recorriendo cómo pensarías. “¿Qué revisarías primero: events, logs, endpoints o network policy?” Aquí es donde crece la confianza operativa.

Analogías que ayudan (y cómo evitar que engañen)

Las analogías sirven para orientar, no para precisión. “Los Pods son ganado, no mascotas” puede explicar reemplazabilidad, pero también ocultar detalles importantes (workloads con estado, volúmenes persistentes, disruption budgets).

Buena regla: usa la analogía para introducir la idea y luego cambia rápido a los términos reales. “Es como X en un aspecto; aquí es donde deja de ser como X.” Esa frase evita malentendidos costosos más adelante.

Lista de comprobación para charlas internas útiles

Antes de presentar, valida cuatro cosas:

- Audiencia: ¿Para quién es—desarrolladores de apps, ingenieros on-call, nuevos hires?

- Objetivo: ¿Qué deben poder hacer en 30 minutos?

- Demo: Una demo que funcione, ensayada, con plan B.

- Siguientes pasos: Un doc, un runbook o un laboratorio guiado que puedan seguir mañana.

Construye una cultura de enseñar, no de poner puertas

La consistencia vence a la formación intensa ocasional. Prueba rituales ligeros:

- Horas de oficina semanales para “trae tu problema de clúster”.

- Brown-bags mensuales con un concepto y un ejemplo en vivo.

- Rotaciones de pair entre plataforma y equipos de producto durante incidentes.

Cuando enseñar se vuelve normal, la adopción es más tranquila y tu plataforma deja de sentirse una caja negra.