Qué se rompe cuando empiezas a vender a empresas

Vender a equipos pequeños trata sobre funciones y rapidez. Vender a empresas cambia la definición de “bueno”. Un corte, un error confuso de permisos o una auditoría faltante pueden deshacer meses de confianza.

La fiabilidad, en términos simples, significa tres cosas: la aplicación se mantiene en línea, los datos están seguros y el comportamiento es predecible. Esa última parte importa más de lo que parece. Los usuarios empresariales organizan su trabajo alrededor de tu sistema. Esperan el mismo resultado hoy, la próxima semana y después de la siguiente actualización.

Lo que suele fallar primero no es un único servidor. Es la brecha entre lo que construiste para unos pocos usuarios y lo que los grandes clientes dan por hecho. Traen más tráfico, más roles, más integraciones y más escrutinio de seguridad y cumplimiento.

Los puntos de tensión iniciales son previsibles. Las expectativas de disponibilidad saltan de “más o menos bien” a “debe ser aburridamente estable”, con un manejo de incidentes claro. La seguridad de los datos se convierte en un tema de nivel de dirección: copias de seguridad, recuperación, registros de acceso y propiedad. Los permisos se complican rápido: departamentos, contratistas y acceso con principio de mínimo privilegio. El cambio se vuelve arriesgado: las versiones necesitan retrocesos y una forma de evitar comportamientos sorpresa. El soporte deja de ser “útil” y pasa a ser parte del producto, con tiempos de respuesta y rutas de escalado.

Un cliente startup podría aceptar una interrupción de dos horas y una disculpa rápida. Un cliente empresarial puede necesitar un resumen de causa raíz, prueba de que no volverá a ocurrir y un plan para prevenir fallos similares.

Una lista de comprobación de preparación empresarial no trata de “software perfecto”. Trata de escalar sin romper la confianza, actualizando diseño de producto, hábitos de equipo y operaciones del día a día al mismo tiempo.

Diane Greene y la mentalidad VMware en una página

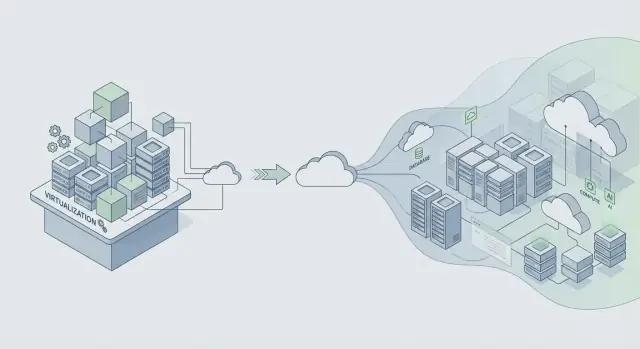

Diane Greene cofundó VMware en un momento en que TI empresarial afrontaba un trade-off doloroso: moverse rápido y arriesgarse a fallos, o mantenerse estable y aceptar cambios lentos. VMware fue importante porque hizo que los servidores se comportaran como bloques de construcción fiables. Eso permitió consolidación, actualizaciones más seguras y recuperación más rápida, sin pedir a cada equipo de aplicación que reescribiera todo.

La promesa central para las empresas es simple: estabilidad primero, funciones después. Las empresas sí quieren capacidades nuevas, pero las quieren sobre un sistema que siga funcionando durante parches, escalado y errores de rutina. Cuando un producto se vuelve crítico para el negocio, “lo arreglaremos la próxima semana” se convierte en ingresos perdidos, plazos incumplidos y problemas de cumplimiento.

La virtualización fue una herramienta práctica de fiabilidad, no solo un ahorro de costes. Creó límites de aislamiento. Una carga de trabajo podía fallar sin tumbar toda la máquina. También hizo la infraestructura más repetible: si puedes hacer snapshots, clonar y mover una carga, puedes probar cambios y recuperar más rápido cuando algo sale mal.

Esa mentalidad sigue vigente: diseña para el cambio sin tiempo de inactividad. Asume que los componentes fallarán, los requisitos cambiarán y las actualizaciones ocurrirán con carga real. Luego construye hábitos que hagan el cambio seguro.

Una forma rápida de describir la mentalidad VMware es aislar la falla para que un problema no se propague, tratar las actualizaciones como cosas rutinarias, hacer el rollback rápido y preferir comportamiento predecible sobre trucos ingeniosos. La confianza se construye con fiabilidad aburrida, día tras día.

Si construyes sobre plataformas modernas (o generas apps con herramientas como Koder.ai), la lección se mantiene: lanza funciones solo de formas que puedas desplegar, supervisar y deshacer sin romper las operaciones del cliente.

VMware creció en un mundo de software empaquetado donde “una versión” era un gran evento. Las plataformas cloud cambiaron el ritmo: cambios más pequeños que se envían con más frecuencia. Eso puede ser más seguro, pero solo cuando controlas el cambio.

La constante: el cambio es el principal riesgo para la fiabilidad

Ya sea que envíes un instalador empaquetado o despliegues en la nube, la mayoría de las interrupciones empiezan igual: llega un cambio, se rompe una suposición oculta y el radio de impacto es mayor de lo esperado. Las versiones más rápidas no eliminan el riesgo. Lo multiplican cuando faltan barreras de seguridad.

Los equipos que escalan con fiabilidad asumen que cada versión podría fallar y construyen el sistema para fallar de forma segura.

Un ejemplo simple: un cambio “inofensivo” en un índice de base de datos funciona en staging, pero en producción aumenta la latencia de escritura, provoca colas y hace que los timeouts parezcan errores de red aleatorios. Las versiones frecuentes te dan más oportunidades de introducir ese tipo de sorpresa.

La infraestructura compartida cambió los modos de fallo

Las apps de la era cloud suelen servir a muchos clientes en sistemas compartidos. Las configuraciones multi-tenant traen problemas nuevos que siguen aplicando el mismo principio: aislar fallos.

Los problemas de vecino ruidoso (el pico de un cliente ralentiza a otros) y las fallas compartidas (un mal despliegue afecta a todos) son la versión moderna de “un bug tumba el clúster”. Los controles son familiares, solo que aplicados de forma continua: despliegues graduales, controles por inquilino, límites de recursos (cuotas, límites de tasa, timeouts) y diseños que manejan fallos parciales.

La observabilidad es la otra constante. No puedes proteger la fiabilidad si no puedes ver lo que está pasando. Buenas trazas, métricas y logs te ayudan a detectar regresiones rápido, especialmente durante los despliegues.

El rollback tampoco es ya un movimiento raro de emergencia. Es una herramienta normal. Muchos equipos emparejan rollback con snapshots y pasos de despliegue más seguros. Plataformas como Koder.ai incluyen snapshots y rollback, lo que puede ayudar a deshacer cambios riesgosos rápido, pero el punto mayor es cultural: el rollback debe practicarse, no improvisarse.

Define objetivos de fiabilidad antes de escalar

Si esperas a definir la fiabilidad hasta que haya un trato empresarial sobre la mesa, acabarás discutiendo desde impresiones: “parece bien”. Los clientes grandes quieren promesas claras que puedan repetir internamente, como “la app permanece en línea” y “las páginas cargan lo suficientemente rápido en horas pico”.

Empieza con un pequeño conjunto de objetivos escritos en lenguaje simple. Dos que la mayoría de equipos puede acordar rápidamente son disponibilidad (cada cuánto el servicio es usable) y tiempo de respuesta (qué tan rápidas se sienten las acciones clave). Mantén los objetivos ligados a lo que hacen los usuarios, no a una métrica de servidor aislada.

Un presupuesto de errores hace que estos objetivos sean útiles en el día a día. Es la cantidad de fallo que puedes “gastar” en un periodo mientras sigues cumpliendo tu promesa. Cuando estás dentro del presupuesto, puedes asumir más riesgo en la entrega. Cuando lo agotas, el trabajo de fiabilidad pasa a priorizar sobre las nuevas funciones.

Para mantener los objetivos honestos, sigue pocas señales que se correspondan con impacto real: latencia en acciones principales, errores (peticiones fallidas, crashes, flujos rotos), saturación (CPU, memoria, conexiones a la base de datos, colas) y disponibilidad a lo largo del camino crítico de extremo a extremo.

Una vez fijados los objetivos, deben cambiar decisiones. Si una versión dispara errores, no debatas. Pausa, arregla o haz rollback.

Si usas una plataforma de desarrollo acelerado como Koder.ai para lanzar más rápido, los objetivos importan aún más. La velocidad solo es útil cuando está acotada por promesas de fiabilidad que puedes cumplir.

Hábitos de arquitectura que protegen la fiabilidad a escala

El salto de fiabilidad de “funciona para nuestro equipo” a “funciona para una Fortune 500” es sobre todo arquitectura. El cambio de mentalidad clave es simple: asume que partes de tu sistema fallarán en un día normal, no solo durante una gran caída.

Diseña para el fallo haciendo dependencias opcionales cuando sea posible. Si tu proveedor de facturación, servicio de correo o pipeline de analítica está lento, tu app principal debe seguir cargando, permitir el acceso y dejar que la gente haga el trabajo principal.

Los límites de aislamiento son tu mejor amigo. Separa la ruta crítica (login, flujos principales, escrituras a la base de datos principal) de las funciones agradables de tener (recomendaciones, feeds de actividad, exportaciones). Cuando las partes opcionales fallan, deben cerrarse sin arrastrar la parte crítica.

Algunos hábitos evitan fallos en cascada en la práctica:

- Pon timeouts estrictos en cada llamada de red.

- Reintenta solo operaciones que sean seguras de repetir y añade jitter para evitar tormentas de reintentos.

- Usa circuit breakers para que una dependencia en fallo no consuma todos tus workers o conexiones a la base de datos.

- Controla la carga con colas y backpressure para que los picos sean lentitud, no caídas.

- Prefiere degradación elegante: devuelve resultados parciales con un mensaje claro en lugar de un 500.

La seguridad de los datos es donde “lo arreglamos después” se convierte en tiempo de inactividad. Planifica backups, cambios de esquema y recuperación como si realmente los necesitaras, porque los necesitarás. Realiza simulacros de recuperación igual que haces simulacros de incendio.

Ejemplo: un equipo publica una app React con una API en Go y PostgreSQL. Un cliente empresarial importa 5 millones de registros. Sin límites, la importación compite con el tráfico normal y todo se ralentiza. Con las protecciones adecuadas, la importación pasa por una cola, escribe en lotes, usa timeouts y reintentos seguros, y puede pausarse sin afectar a los usuarios. Si construyes en una plataforma como Koder.ai, trata el código generado igual: añade estas protecciones antes de que clientes reales dependan de él.

Operaciones: la parte que la mayoría añade demasiado tarde

Los incidentes no son prueba de que fracasaste. Son un coste normal de operar software real para clientes reales, especialmente cuando el uso crece y los despliegues son más frecuentes. La diferencia es si tu equipo reacciona con calma y arregla la causa, o improvisa y repite el mismo fallo el mes siguiente.

Al principio, muchos productos dependen de unas pocas personas que “simplemente saben” qué hacer. Las empresas no aceptarán eso. Quieren respuesta predecible, comunicación clara y evidencia de que aprendes de los fallos.

Preparación de on-call (antes de que la necesites)

On-call tiene menos que ver con heroísmos y más con quitar la incertidumbre a las 2 a.m. Una configuración simple cubre la mayoría de lo que importan a los clientes grandes:

- Nombra un propietario primario para cada servicio.

- Mantén runbooks cortos para los modos de fallo principales.

- Define escalado: a quién llamar, cuándo y con qué rapidez.

- Ejecuta al menos un simulacro planificado.

- Mantén un lugar para verificar el estado actual y los cambios recientes.

Monitorización que importa

Si las alertas suenan todo el día, la gente las silencia y el único incidente real se pasa por alto. Vincula las alertas al impacto en el usuario: fallo en el inicio de sesión, aumento de la tasa de errores, latencia superando un umbral claro o trabajos en segundo plano acumulándose.

Tras un incidente, haz una revisión centrada en las correcciones, no en la culpa. Captura qué pasó, qué señales faltaron y qué guardrails habrían reducido el radio de impacto. Convierte eso en uno o dos cambios concretos, asigna un responsable y fija una fecha límite.

Estos básicos operativos separan una “app que funciona” de un servicio en el que los clientes pueden confiar.

Paso a paso: endurece tu app para clientes más grandes

Los clientes grandes rara vez piden nuevas funciones primero. Preguntan: “¿Podemos confiar en esto en producción, todos los días?” La forma más rápida de responder es seguir un plan de endurecimiento y producir pruebas, no promesas.

Un plan de endurecimiento práctico en 5 pasos

-

Lista lo que ya cumples vs lo que falta. Anota las expectativas empresariales que puedes respaldar hoy (objetivos de uptime, control de acceso, registros de auditoría, retención de datos, residencia de datos, SSO, horas de soporte). Marca cada ítem como listo, parcial o no todavía. Esto convierte la presión vaga en un backlog corto.

-

Añade seguridad en el despliegue antes de enviar más. A las empresas les importa menos con qué frecuencia despliegas y más si puedes hacerlo sin incidentes. Usa un entorno de staging que refleje producción. Usa feature flags para cambios riesgosos, despliegues canary para rodar gradualmente y un plan de rollback que puedas ejecutar rápido. Si construyes sobre una plataforma que soporta snapshots y rollback (Koder.ai lo hace), practica restaurar una versión anterior para que sea memoria muscular.

-

Prueba la protección de datos, y pruébala otra vez. Las copias no son una casilla marcada. Programa backups automáticos, define retenciones y realiza pruebas de restauración en calendario. Añade registros de auditoría para acciones clave (cambios de admin, exportaciones de datos, ediciones de permisos) para que los clientes puedan investigar y cumplir con requisitos.

-

Documenta soporte y respuesta a incidentes en lenguaje llano. Escribe una promesa de una página: cómo reportar un incidente, tiempos de respuesta esperados, quién comunica las actualizaciones y cómo haces los informes post-incident.

-

Haz una revisión de preparación con un plan realista de pruebas de carga. Elige un escenario similar a empresa y pruébalo de extremo a extremo: tráfico pico, base de datos lenta, un nodo que falla y un rollback. Ejemplo: un cliente importa 5 millones de registros un lunes por la mañana mientras 2,000 usuarios inician sesión y generan informes. Mide qué falla, arregla el cuello de botella principal y repite.

Haz estos cinco pasos y las conversaciones de ventas se vuelven más fáciles porque puedes mostrar tu trabajo.

Una historia realista de escalado: un nuevo cliente empresarial

Una app SaaS de tamaño medio tiene unos cientos de clientes y un equipo pequeño. Luego firma con su primer cliente regulado: un banco regional. El contrato incluye exigencias estrictas de uptime, controles de acceso rigurosos y la promesa de responder rápido preguntas de seguridad. Nada cambia en las funciones principales del producto, pero sí cambian las reglas sobre cómo ejecutarlo.

En los primeros 30 días, el equipo hace mejoras “invisibles” que los clientes sí notan. La monitorización pasa de “¿estamos arriba?” a “¿qué está roto, dónde y para quién?” Añaden dashboards por servicio y alertas ligadas al impacto en el usuario, no al ruido de CPU. Los controles de acceso se formalizan: autenticación más fuerte para acciones administrativas, roles revisados y acceso a producción registrado y limitado en el tiempo. La auditabilidad se convierte en un requisito de producto, con logs consistentes de fallos de login, cambios de permisos, exportaciones de datos y ediciones de configuración.

Dos semanas después, una versión va mal. Una migración de base de datos tarda más de lo esperado y empieza a provocar timeouts para un subconjunto de usuarios. Lo que evita que sea un incidente de varios días es la disciplina básica: un plan de rollback claro, un líder de incidente y un guion de comunicación.

Pausan el despliegue, desvían tráfico del camino lento y vuelven a la última versión conocida buena. Si tu plataforma soporta snapshots y rollback (Koder.ai lo hace), esto puede ser mucho más rápido, pero aún así necesitas un procedimiento practicado. Durante la recuperación, envían actualizaciones cortas cada 30 minutos: qué está afectado, qué se está haciendo y la próxima hora de revisión.

Un mes después, el “éxito” se ve aburrido en el mejor sentido. Las alertas son menos pero más relevantes. La recuperación es más rápida porque la propiedad está clara: una persona en on-call, una coordinando y una comunicando. El banco deja de preguntar “¿lo tienen bajo control?” y empieza a preguntar “¿cuándo ampliamos el rollout?”.

Trampas comunes que dañan la fiabilidad al crecer

El crecimiento cambia las reglas. Más usuarios, más datos y clientes más grandes significan que pequeñas brechas se convierten en interrupciones, incidentes ruidosos o largas hileras de soporte. Muchos de estos problemas parecen “aceptables” hasta la semana en que firmas tu primer gran contrato.

Las trampas que más aparecen:

- Desplegar rápido sin un botón seguro para deshacer. Si no puedes hacer rollback en minutos, cada despliegue es una operación de alto riesgo.

- Hacer de la fiabilidad “trabajo solo de ingenieros”. Las interrupciones también son problema de soporte y comunicación. Si soporte no tiene actualizaciones de estado claras, la solución técnica llega tarde para proteger la confianza.

- Ruido de alertas que entrena a la gente a ignorarlas. Si todo alerta, nada es urgente.

- Asumir que las copias implican que puedes restaurar. Las copias muestran que los datos se guardaron, no que puedes recuperar rápido.

- Funciones puntuales para empresas que debilitan el núcleo. Comportamientos personalizados, flags ocultos y despliegues especiales aumentan la superficie de pruebas y dificultan diagnosticar incidentes.

Un ejemplo simple: un equipo añade una integración personalizada para un gran cliente y la despliega como hotfix un viernes por la noche. No hay rollback rápido, las alertas ya son ruidosas y la persona on-call está adivinando. El bug es pequeño, pero la recuperación se alarga horas porque la ruta de restauración nunca se probó.

Si tu checklist de preparación empresarial solo tiene ítems técnicos, amplíalo. Incluye rollback, simulacros de restauración y un plan de comunicación que soporte pueda ejecutar sin ingeniería en la sala.

Lista de comprobación de preparación empresarial (chequeos rápidos)

Cuando los clientes grandes preguntan “¿Están listos para empresa?”, suelen preguntar una cosa: ¿podemos confiar en esto en producción? Usa esto como autoauditoría rápida antes de prometer nada en una llamada de ventas.

- Fiabilidad e incidentes definidos (no implicados). Tienes objetivos claros de uptime y rendimiento, monitorización con alertas y un proceso de incidentes que la gente realmente sigue.

- Fundamentos de seguridad aplicados por defecto. El acceso sigue el principio de mínimo privilegio, las acciones administrativas se registran y las claves y secretos tienen un responsable y plan de rotación.

- Los datos pueden recuperarse a propósito, no por suerte. Las copias se ejecutan automáticamente, la restauración se prueba con regularidad y puedes explicar migraciones y retención en lenguaje llano.

- Los despliegues son controlados y reversibles. Puedes hacer releases por etapas, retroceder rápido y tienes un proceso de aprobación simple (aunque sea una nota de cambio y una segunda revisión).

- Las promesas de soporte coinciden con la realidad. Tienes un flujo de soporte (recepción, severidad, tiempos de respuesta) y un propietario claro para escalaciones.

Antes de mostrar una demo, recopila pruebas que puedas señalar sin rodeos: capturas de monitorización que muestren tasa de error y latencia, un ejemplo redactado de un log de auditoría (“quién hizo qué, cuándo”), una nota corta de un ejercicio de restauración (qué restauraste y cuánto tardó) y una nota de una página sobre release y rollback.

Si construyes apps en una plataforma como Koder.ai, trata estas comprobaciones igual. Objetivos, evidencia y hábitos repetibles importan más que las herramientas usadas.

Próximos pasos: convierte la preparación en un hábito repetible

La preparación empresarial no es un empujón único antes de un gran acuerdo. Trátala como una rutina que mantiene tu producto estable bajo presión, incluso cuando los equipos, el tráfico y las expectativas crecen.

Convierte tu checklist en un plan de acción corto. Elige los 3 huecos principales que crean más riesgo, hazlos visibles y asigna responsables con fechas reales. Define “hecho” en términos claros (por ejemplo, “la alerta se dispara en 5 minutos” o “restauración probada de extremo a extremo”). Mantén una pequeña línea en tu backlog para bloqueadores empresariales para que el trabajo urgente no se entierre. Cuando cierres una brecha, escribe qué cambió para que los nuevos compañeros puedan repetirlo.

Crea un documento interno de preparación que reutilices para cada gran prospecto. Manténlo corto y actualízalo tras cada conversación seria con clientes. Un formato simple funciona bien: objetivos de fiabilidad, fundamentos de seguridad, manejo de datos, despliegue y rollback, y quién está de on-call.

Haz revisiones de fiabilidad mensuales ligadas a eventos reales, no a opiniones. Usa incidentes y casi fallos como agenda: qué falló, cómo lo detectaste, cómo recuperaste y qué evitará la repetición.

Si construyes con Koder.ai, incorpora la preparación en tu forma de lanzar. Usa Planning Mode temprano para mapear requisitos empresariales antes de comprometer builds, y apóyate en snapshots y rollback durante los despliegues para que las correcciones sigan siendo de bajo estrés a medida que tu proceso madura. Si quieres un lugar único para centralizar ese flujo de trabajo, koder.ai está diseñado para construir e iterar por chat mientras mantiene controles prácticos como exportación de código, despliegue y rollback al alcance.