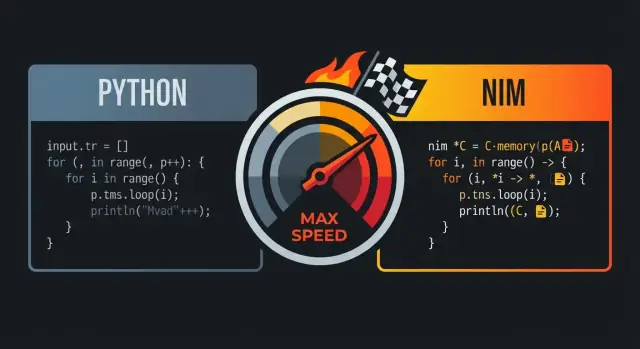

Por qué la gente compara a Nim con Python y C

A menudo comparan Nim con Python y C porque busca un punto intermedio: código que se lee como un lenguaje de scripting de alto nivel, pero que se compila en ejecutables nativos rápidos.

La promesa central: legibilidad y velocidad

A primera vista, Nim suele sentirse “pytónico”: indentación limpia, flujo de control directo y características de la biblioteca estándar que fomentan código claro y compacto. La diferencia clave es lo que sucede después de escribirlo: Nim está diseñado para compilar a código máquina eficiente en lugar de ejecutarse sobre un runtime pesado.

Para muchos equipos, esa combinación es lo importante: puedes escribir código que se parece a lo que prototiparías en Python, pero distribuirlo como un único binario nativo.

A quién le importa esto

Esta comparación resuena especialmente con:

- desarrolladores de Python que se topan con límites de rendimiento (tareas intensivas en CPU, bucles apretados, procesamiento de datos)

- equipos de producto que quieren iteración rápida sin depender de un runtime lento

- ingenieros que aprecian la velocidad de C pero no quieren la ceremonia de bajo nivel para el código diario

Qué significa “rendimiento al nivel de C” en la práctica

“Rendimiento al nivel de C” no significa que todo programa Nim iguale automáticamente a un C afinado manualmente. Significa que Nim puede generar código competitivo con C para muchas cargas de trabajo, especialmente donde importa la sobrecarga: bucles numéricos, parsing, algoritmos y servicios que requieren latencia predecible.

Suele haber mayores ganancias cuando eliminas la sobrecarga del intérprete, minimizas asignaciones y mantienes las rutas calientes de código simples.

Expectativas: la velocidad sigue dependiendo de las decisiones

Nim no arregla un algoritmo ineficiente, y puedes escribir código lento si asignas en exceso, copias estructuras grandes o ignoras el profiling. La promesa es que el lenguaje te da un camino desde código legible hasta código rápido sin reescribir todo en otro ecosistema.

El resultado: un lenguaje que se siente amigable como Python, pero que está dispuesto a acercarse al “metal” cuando el rendimiento importa de verdad.

Sintaxis tipo Python: código legible sin la sobrecarga

Nim se describe frecuentemente como “similar a Python” porque el código se ve y fluye de forma familiar: bloques por indentación, puntuación mínima y preferencia por construcciones de alto nivel y legibles. La diferencia es que Nim sigue siendo un lenguaje estáticamente tipado y compilado, así que obtienes esa superficie limpia sin pagar un “impuesto” de runtime.

Bloques por indentación y estructura limpia

Como Python, Nim usa indentación para definir bloques, lo que hace que el flujo de control sea fácil de escanear en revisiones y diffs. No necesitas llaves por todas partes y rara vez paréntesis salvo que mejoren la claridad.

let limit = 10

for i in 0..\u003climit:

if i mod 2 == 0:

echo i

Esa simplicidad visual importa cuando escribes código sensible al rendimiento: pasas menos tiempo peleando con la sintaxis y más tiempo expresando la intención.

Bloques familiares: bucles, slices, cadenas

Muchas construcciones cotidianas se parecen a lo que espera un usuario de Python.

- Bucles:

for sobre rangos y colecciones se siente natural.

- Slices: secuencias y cadenas soportan operaciones estilo slicing.

- Cadenas: el manejo de strings es directo, con una biblioteca estándar pensada para trabajo práctico.

let nums = @[10, 20, 30, 40, 50]

let middle = nums[1..3] # slice: @[20, 30, 40]

let s = "hello nim"

echo s[0..4] # "hello"

La diferencia clave con Python es lo que sucede bajo el capó: estas construcciones se compilan a código nativo eficiente en lugar de interpretarse en una VM.

Tipado estático que no estorba

Nim es fuertemente tipado estáticamente, pero confía mucho en la inferencia de tipos, por lo que no acabas escribiendo anotaciones verbosas solo para trabajar.

var total = 0 # inferido como int

let name = "Nim" # inferido como string

Cuando quieres tipos explícitos (APIs públicas, claridad o límites sensibles al rendimiento), Nim los soporta con limpieza—sin forzarlos en todas partes.

Errores y advertencias útiles del compilador

Una gran parte de la “legibilidad” es mantener el código seguro. El compilador de Nim es estricto en formas útiles: muestra desajustes de tipo, variables no usadas y conversiones cuestionables pronto, a menudo con mensajes accionables. Ese ciclo de retroalimentación ayuda a mantener el código tan simple como en Python mientras te beneficias de comprobaciones en tiempo de compilación.

Si te gusta la legibilidad de Python, la sintaxis de Nim te resultará familiar. La diferencia es que el compilador de Nim puede validar tus suposiciones y luego producir binarios nativos rápidos y predecibles—sin convertir tu código en mucho boilerplate.

Cómo compila Nim: del código fuente a binarios nativos

Nim es un lenguaje compilado: escribes archivos .nim y el compilador los transforma en un ejecutable nativo que puedes ejecutar directamente en tu máquina. La ruta más común es mediante el backend C de Nim (también puede apuntar a C++ u Objective-C), donde el código Nim se traduce a código fuente del backend y luego lo compila un compilador del sistema como GCC o Clang.

Qué significa realmente “binario nativo”

Un binario nativo se ejecuta sin una máquina virtual del lenguaje y sin un intérprete que recorra tu código línea a línea. Eso explica en buena parte por qué Nim puede sentirse de alto nivel y evitar muchos costes de runtime asociados a VM o intérpretes: el tiempo de arranque suele ser rápido, las llamadas de función son directas y los bucles calientes pueden ejecutarse cerca del hardware.

Oportunidades de optimización de programa completo

Como Nim compila por adelantado, la cadena de herramientas puede optimizar a través de todo el programa. En la práctica eso puede permitir mejor inlining, eliminación de código muerto y optimizaciones en tiempo de enlace (dependiendo de flags y del compilador C/C++). El resultado suelen ser ejecutables más pequeños y rápidos—especialmente en comparación con distribuir un runtime más el código fuente.

Flujo típico: compilar, ejecutar, distribuir

Durante el desarrollo sueles iterar con comandos como nim c -r yourfile.nim (compilar y ejecutar) o usar modos de construcción distintos para debug y release. Cuando toca distribuir, repartes el ejecutable producido (y las librerías dinámicas necesarias si las enlazaste). No hay un paso separado de “desplegar el intérprete”: tu salida ya es un programa que el SO puede ejecutar.

Poder en tiempo de compilación: hacer trabajo antes de ejecutar

Una de las mayores ventajas de Nim en velocidad es que puede hacer cierto trabajo en tiempo de compilación (a veces llamado CTFE: ejecución de funciones en tiempo de compilación). En términos sencillos: en lugar de calcular algo cada vez que corre tu programa, le pides al compilador que lo calcule una vez al construir el ejecutable y luego incrustes el resultado en el binario final.

Por qué importa el trabajo en compilación

El rendimiento en ejecución a menudo se come costos de “preparación”: construir tablas, parsear formatos conocidos, comprobar invariantes o precomputar valores que nunca cambian. Si esos resultados son previsibles a partir de constantes, Nim puede mover ese esfuerzo a la compilación.

Eso significa:

- menos tiempo de arranque (sin pasos de “warm-up”)

- menos asignaciones y ramas durante la ejecución

- rutas de código en tiempo de ejecución más simples (a menudo más fáciles de optimizar por el compilador)

Ejemplos prácticos

Generar tablas de búsqueda. Si necesitas una tabla para mapeo rápido (por ejemplo, clases de caracteres ASCII o un pequeño hash de strings conocidos), puedes generar la tabla en compilación y almacenarla como un array constante. El programa entonces hace búsquedas O(1) sin configuración.

Validar constantes temprano. Si una constante está fuera de rango (un puerto, un tamaño de buffer fijo, una versión de protocolo), puedes fallar la compilación en vez de enviar un binario que lo descubra en producción.

Precomputar constantes derivadas. Máscaras, patrones de bits o valores por defecto normalizados se pueden calcular una vez y reutilizar.

Nota de precaución: mantener la legibilidad

La lógica en tiempo de compilación es poderosa, pero sigue siendo código que alguien debe entender. Prefiere helpers pequeños y bien nombrados; añade comentarios explicando “por qué ahora” (tiempo de compilación) frente a “por qué más tarde” (tiempo de ejecución). Y prueba los helpers de compilación igual que pruebas funciones normales—para que las optimizaciones no se conviertan en errores difíciles de depurar al construir.

Las macros de Nim se entienden mejor como “código que escribe código” durante la compilación. En lugar de ejecutar lógica reflexiva en tiempo de ejecución (y pagar por ello en cada ejecución), puedes generar código Nim especializado una vez y luego distribuir el binario resultante y rápido.

Eliminar boilerplate (y comprobaciones en tiempo de ejecución)

Un uso común es reemplazar patrones repetitivos que de otro modo inflarían la base de código o añadirían sobrecarga por llamada. Por ejemplo, puedes:

- Generar funciones de serialización/deserialización para un tipo en vez de escribir campo a campo.

- Producir código de validación de entrada a partir de un esquema compacto, en lugar de tener un montón de

ifs por todo el programa.

- Construir dispatch optimizado (p. ej., mapear comandos a manejadores) sin tablas de búsqueda en tiempo de ejecución.

Como la macro se expande en código Nim normal, el compilador puede inlinear, optimizar y eliminar ramas muertas—así que la abstracción suele desaparecer en el ejecutable final.

Sintaxis específica de dominio (sin un compilador personalizado)

Las macros también permiten sintaxis DSL ligera. Los equipos la usan para expresar la intención claramente:

- Parsers rápidos: escribe una descripción declarativa tipo gramática y la macro emite código de parsing apretado.

- Serializadores: indica etiquetas/reglas de formato y genera empaquetado/desempaquetado.

- Mini-DSLs para ruteo, construcción de consultas SQL o mapeos de configuración.

Si se hace bien, el punto de llamada puede leerse como en Python—claro y directo—mientras compila a bucles eficientes y operaciones seguras con punteros.

Mantener las macros mantenibles

La metaprogramación puede volverse complicada si se convierte en un lenguaje oculto dentro del proyecto. Algunas reglas:

- Documenta lo que la macro genera y muestra un ejemplo pequeño del código expandido.

- Mantén las macros focalizadas: resuelven un problema claro en vez de transformarse en un “framework”.

- Prefiere genéricos/plantillas cuando sean suficientes; usa macros para transformaciones al nivel del AST cuando realmente haga falta.

Gestión de memoria: ARC/ORC y rendimiento predecible

Haz visible el perfilado

Crea una UI interna de benchmark para rastrear cambios de rendimiento con el tiempo.

La gestión de memoria por defecto de Nim es una gran razón por la que puede sentirse “pytónico” mientras se comporta como un lenguaje de sistemas. En lugar de un recolector trazador clásico que periódicamente recorre la memoria para encontrar objetos inalcanzables, Nim usa típicamente ARC (Automatic Reference Counting) u ORC (Optimized Reference Counting).

ARC/ORC vs GC trazador (a alto nivel)

Un GC trazador funciona en ráfagas: pausa el trabajo normal para recorrer objetos y decidir qué liberar. Ese modelo puede ser genial para ergonomía, pero las pausas pueden ser difíciles de predecir.

Con ARC/ORC, la mayoría de la memoria se libera justo cuando desaparece la última referencia. En la práctica, esto tiende a producir latencia más consistente y facilita razonar sobre cuándo se liberan recursos (memoria, ficheros, sockets).

Por qué la predictibilidad ayuda al rendimiento

El comportamiento de memoria predecible reduce “sorpresas” en ralentizaciones. Si las asignaciones y liberaciones ocurren de forma continua y local—en lugar de ciclos globales de limpieza ocasionales—el timing del programa es más fácil de controlar. Eso importa para juegos, servidores, herramientas CLI y cualquier cosa que deba mantenerse responsable.

También ayuda al compilador a optimizar: cuando las vidas útiles son claras, el compilador a veces puede mantener datos en registros o en la pila y evitar contabilidad extra.

Pila vs heap, lifetimes y copiar vs mover

A modo de simplificación:

- Valores en pila: de vida corta y baratos de crear; desaparecen cuando sale el scope.

- Valores en heap: viven más tiempo y pueden compartirse entre scopes, pero asignarlos cuesta más.

Nim te deja escribir código de alto nivel mientras te preocupas por las vidas útiles. Fíjate si estás copiando estructuras grandes (duplicando datos) o moviendo (transferir ownership sin duplicar). Evita copias accidentales en bucles calientes.

Consejos prácticos para evitar asignaciones innecesarias

Si quieres “velocidad tipo C”, la asignación más rápida es la que no haces:

- Reutiliza buffers (para strings, sequences, IO) en vez de recrearlos repetidamente.

- Prefiere actualizaciones in-place en rutas calientes.

- Construye datos incrementalmente con capacidad preasignada cuando sea posible.

Estos hábitos encajan bien con ARC/ORC: menos objetos en heap significa menos tráfico de conteo de referencias y más tiempo haciendo el trabajo real.

Estructuras de datos y layout: conseguir velocidad desde la simplicidad

Nim puede sentirse de alto nivel, pero su rendimiento suele depender de un detalle de bajo nivel: qué se asigna, dónde vive y cómo está dispuesto en memoria. Si eliges las formas de datos correctas, obtienes velocidad “gratis” sin escribir código ilegible.

Tipos por valor vs ref: dónde ocurren las asignaciones

La mayoría de tipos en Nim son tipos por valor por defecto: int, float, bool, enum y también object planos. Los tipos por valor suelen vivir inline (a menudo en la pila o embebidos dentro de otras estructuras), lo que mantiene los accesos de memoria compactos y previsibles.

Cuando usas ref (por ejemplo, ref object), estás añadiendo un nivel de indirección: el valor suele residir en el heap y manipulas un puntero. Eso puede ser útil para datos compartidos, de larga vida u opcionales, pero puede añadir sobrecarga en bucles calientes porque la CPU debe seguir punteros.

Regla práctica: prefiere object por valor para datos críticos en rendimiento; usa ref cuando realmente necesites semántica por referencia.

seq y string: convenientes, pero conoce los costes

seq[T] y string son contenedores dinámicos redimensionables. Son estupendos para programación cotidiana, pero pueden asignar y realocar conforme crecen. El patrón de coste a vigilar:

- Append puede desencadenar a veces un resize (copiando elementos existentes)

- Muchos

seqs o strings pequeños pueden crear muchos bloques separados en heap

Si conoces tamaños de antemano, pre-dimensiona (newSeq, setLen) y reutiliza buffers para reducir el churn.

Por qué importa el layout: un modelo mental sencillo de cache CPU

Las CPUs son más rápidas cuando leen memoria contigua. Un seq[MyObj] donde MyObj es un objeto por valor suele ser friendly para la cache: los elementos están uno junto a otro.

Pero un seq[ref MyObj] es una lista de punteros dispersos por el heap; iterarla implica saltos por memoria, lo que es más lento.

Consejos prácticos para rutas calientes

Para bucles apretados y código sensible al rendimiento:

- Prefiere

array (tamaño fijo) o seq de objetos por valor

- Mantén campos frecuentemente accedidos juntos en un solo

object

- Evita “cadenas de punteros” (

ref dentro de ref) salvo que sea necesario

Estas elecciones mantienen los datos compactos y locales—exactamente lo que prefieren las CPUs modernas.

Abstracciones que se “compilan” fuera

Despliega con confianza

Despliega y hospeda tu app; usa snapshots y rollback cuando los cambios fallen.

Una razón por la que Nim puede sentirse de alto nivel sin pagar gran coste de runtime es que muchas características están pensadas para transformarse en código de máquina directo. Escribes código expresivo; el compilador lo baja a bucles ajustados y llamadas directas.

Qué significa “abstracción de coste cero” en Nim

Una abstracción de coste cero es una característica que facilita la lectura o reutilización del código, pero no añade trabajo extra en tiempo de ejecución comparado con escribir la versión de bajo nivel a mano.

Un ejemplo intuitivo es usar una API estilo iterador para filtrar valores, mientras que el binario final contiene un bucle simple.

proc sumPositives(a: openArray[int]): int =

for x in a:

if x > 0:

result += x

Aunque openArray parezca flexible y de alto nivel, esto típicamente se compila a un recorrido indexado básico de memoria (sin la sobrecarga de objetos al estilo Python). La API es agradable, pero el código generado se parece mucho al bucle C obvio.

Inlining, genéricos y especialización (versión en lenguaje llano)

Nim suele inlinar procedimientos pequeños cuando ayuda, lo que significa que la llamada puede desaparecer y el cuerpo pegarse en el llamador.

Con genéricos, escribes una función que funciona para varios tipos. El compilador la especializa: crea una versión adaptada para cada tipo concreto que uses. Eso suele dar código tan eficiente como funciones escritas a mano sin duplicar la lógica.

APIs agradables que siguen siendo bucles ajustados

Patrones como ayudantes pequeños (mapIt, filterIt), tipos distinct y comprobaciones de rango pueden optimizarse cuando el compilador puede ver a través de ellos. El resultado final puede ser un único bucle con ramas mínimas.

La gran salvedad: abstracciones que fuerzan asignaciones

Las abstracciones dejan de ser “gratis” cuando crean asignaciones en heap o copias ocultas. Devolver secuencias nuevas repetidamente, construir strings temporales en bucles internos o capturar closures grandes puede introducir sobrecarga.

Regla práctica: si una abstracción asigna por iteración, puede dominar el tiempo de ejecución. Prefiere datos aptos para la pila, reutiliza buffers y vigila APIs que creen seqs o strings silenciosamente en rutas calientes.

Interoperabilidad con C: aprovechar velocidad y ecosistemas

Una razón práctica por la que Nim puede “sentirse” de alto nivel y ser rápido es que puede llamar a C directamente. En lugar de reescribir una biblioteca C probada, puedes importar sus definiciones de cabecera, enlazar la biblioteca compilada y llamar a las funciones casi como si fueran procedimientos Nim nativos.

Cómo es la FFI con C en Nim (a alto nivel)

La interfaz de Nim para llamadas externas se basa en describir las funciones y tipos C que quieras usar. En muchos casos puedes:

- declarar los símbolos C en Nim con

importc (apuntando al nombre C exacto), o

- usar herramientas que generen declaraciones Nim a partir de cabeceras C.

Después, el compilador Nim enlaza todo en el mismo binario nativo, por lo que la sobrecarga de la llamada es mínima.

Por qué importa: reutilizar sin reescribir

Esto te da acceso inmediato a ecosistemas maduros: compresión (zlib), primitivas criptográficas, códecs de imagen/audio, clientes de BD, APIs del SO y utilidades críticas de rendimiento. Mantienes la estructura legible y tipo-Python para la lógica de la app mientras apoyas en C lo que haga el trabajo pesado.

Peligros a vigilar: ownership y conversiones

Los errores en FFI suelen venir de expectativas desajustadas:

- Reglas de ownership: ¿Quién asigna y quién libera? Si una función C devuelve un puntero que debes liberar, necesitas un camino claro de liberación en Nim. Si C guarda un puntero que le pasaste, debes asegurar que la memoria siga viva.

- Strings y buffers: las strings de Nim no son C-strings. Convertir a

cstring es sencillo, pero debes asegurar terminación nula y lifetime. Para datos binarios, prefiere pares explícitos ptr uint8/longitud.

Un buen patrón es escribir una pequeña capa wrapper en Nim que:

- exponga procs y tipos idiomáticos de Nim,

- centralice conversiones y manejo de errores,

- oculte punteros crudos detrás de helpers estilo RAII (

defer, destructores) cuando corresponda.

Esto facilita las pruebas unitarias y reduce la probabilidad de que detalles de bajo nivel se filtren al resto del códigobase.

Caja de herramientas de rendimiento: modos de build, flags y perfilado

Nim puede sentirse rápido “por defecto”, pero el último 20–50% suele depender de cómo construyes y cómo mides. La buena noticia: el compilador expone controles de rendimiento de forma accesible incluso si no eres un experto en sistemas.

Modos de build que importan

Para obtener números reales de rendimiento, evita medir builds de depuración. Empieza con un build de release y añade checks solo cuando buscas bugs.

nim c -d:release --opt:speed myapp.nim

nim c -d:danger --opt:speed myapp.nim

nim c -d:release --opt:speed --passC:-march=native myapp.nim

Una regla sencilla: usa -d:release para benchmarks y producción, y reserva -d:danger cuando ya tengas confianza por tests.

Flujo de perfilado: medir primero, optimizar después

Un flujo práctico:

- Mide de extremo a extremo primero (tiempo real, memoria, throughput). Herramientas como

hyperfine o time suelen ser suficientes.

- Encuentra hotspots después. Nim soporta perfilado integrado (

--profiler:on) y funciona bien con profilers externos (Linux perf, Instruments en macOS, herramientas de Windows) porque produces binarios nativos.

- Optimiza las 1–2 funciones más calientes, y vuelve a medir. Si el hotspot se mueve, estás progresando.

Al usar profilers externos, compila con info de depuración para obtener trazas legibles y símbolos durante el análisis:

nim c -d:release --opt:speed --debuginfo myapp.nim

Micro-optimizaciones a evitar

Es tentador tocar detalles minúsculos (desenrollado manual de bucles, reordenar expresiones, “trucos” ingeniosos) antes de tener datos. En Nim, las mayores ganancias suelen venir de:

- elegir un algoritmo mejor,

- reducir asignaciones y copias,

- mejorar el layout de datos (usar secuencias contiguas cuando sea posible),

- reducir la sobrecarga en bucles críticos.

Benchmarks en CI y comprobaciones de regresión

Las regresiones de rendimiento son más fáciles de corregir si se detectan pronto. Un enfoque ligero es añadir una pequeña suite de benchmarks (por ejemplo, una tarea Nimble nimble bench) y ejecutarla en CI en un runner estable. Guarda líneas base (aunque sea en JSON simple) y falla el build si métricas clave se desvían más allá de un umbral permitido. Así evitas que “rápido hoy” se convierta en “lento el próximo mes” sin que nadie lo note.

Dónde brilla Nim (y dónde quizá no tanto)

Realiza un piloto rápido

Prueba Koder.ai en un proyecto pequeño relacionado con Nim antes de comprometerte con uno mayor.

Nim encaja bien cuando quieres código que se lea como un lenguaje de alto nivel pero que se distribuya como un único ejecutable rápido. Recompensa a equipos que se preocupan por rendimiento, simplicidad de despliegue y mantener dependencias bajo control.

Ajustes ideales

Para muchos equipos, Nim resulta excelente en software tipo producto—cosas que compilas, testas y distribuyes.

- CLIs y herramientas de desarrollador: distribuir un binario nativo, arranque rápido y baja sobrecarga de inicio.

- Herramientas y servicios de red: buen throughput y latencia predecible, manteniendo código legible.

- Herramientas y pipelines de juegos: conversores de assets, herramientas de build, editores y automatización donde la velocidad importa pero no quieres complejidad C/C++.

Casos a tener cautela

Nim puede ser menos ideal cuando el éxito depende de dinamismo en tiempo de ejecución más que de rendimiento compilado.

- Sistemas de plugins muy dinámicos: si esperas cargar y descargar muchas extensiones de terceros en tiempo de ejecución, el modelo compilado de Nim puede añadir fricción.

- Scripts rápidos y desechables: si tu flujo es “editar, ejecutar inmediatamente, tirar”, Python (o scripts de shell) puede ser más rápido para tareas pequeñas.

Consideraciones para el equipo

Nim es accesible, pero tiene curva de aprendizaje.

- Acordad convenciones de estilo temprano (layout de módulos, manejo de errores, nombres) para evitar que “cada uno escriba Nim a su manera”.

- Planifica el onboarding: pairing y una guía interna corta ayudan más que documentación extensa.

- Sé realista con huecos de ecosistema: hay librerías, pero no tendrás todo lo que hay en Python.

Enfoque de proyecto piloto

Elige un proyecto pequeño y medible—por ejemplo reescribir un paso lento de un CLI o una utilidad de red. Define métricas de éxito (tiempo de ejecución, memoria, tiempo de build, tamaño del despliegue), distribúyelo a una audiencia interna pequeña y decide en base a resultados, no a hype.

Si tu trabajo en Nim necesita una superficie de producto alrededor—un dashboard de administración, un runner de benchmarks o un gateway de API—herramientas como Koder.ai pueden ayudarte a montar esas piezas rápidamente. Puedes prototipar un frontend React y un backend Go + PostgreSQL, y luego integrar tu binario Nim como servicio vía HTTP, manteniendo el núcleo crítico en Nim y acelerando lo que está alrededor.

Lista práctica para obtener código tipo Python a velocidad tipo C

Nim gana su reputación de “Python-like pero rápido” combinando sintaxis legible con un compilador nativo optimizador, gestión de memoria predecible (ARC/ORC) y una cultura de atención al layout de datos y asignaciones. Si quieres los beneficios de velocidad sin convertir tu base de código en espagueti de bajo nivel, usa esta lista como flujo repetible.

Checklist orientada a velocidad (sin sacrificar claridad)

- Compila en serio: usa un build de release para mediciones reales.

- Empieza con

-d:release y considera --opt:speed.

- Activa optimizaciones en tiempo de enlace cuando corresponda (

--passC:-flto --passL:-flto).

- Elige estructuras de datos a propósito: prefiere representaciones simples y contiguas.

seq[T] es genial, pero los bucles apretados a menudo se benefician de arrays, openArray y evitar redimensiones innecesarias.- Mantén los datos calientes pequeños y juntos; menos punteros suelen significar menos fallos de cache.

- Sé consciente de las asignaciones: ARC/ORC ayuda, pero no puede eliminar trabajo que creas.

- Reutiliza buffers, prealoca con

newSeqOfCap y evita construir strings temporales en bucles.

- Vigila copias ocultas al hacer slices o concatenaciones.

- Deja que las abstracciones se compilen fuera: escribe código limpio y luego verifica que se optimiza.

- Prefiere iteradores/plantillas para expresividad, pero confirma que se inlinan en builds de release.

- Mide antes de “optimizar”: perfila para encontrar los verdaderos hotspots.

- Si eres nuevo en perfilado, mira /blog/performance-profiling-basics.

Próximos pasos: comprobarlo en tu máquina

- Prueba un micro-benchmark: elige una función que haga trabajo real (parsing, filtrado, cálculos) y compara builds debug vs release.

- Entrega una característica real: implementa un módulo pequeño de extremo a extremo y optimiza solo la ruta caliente (no todo el códigobase).

Si aún dudas entre lenguajes, /blog/nim-vs-python puede ayudar a encuadrar los trade-offs. Para equipos evaluando herramientas u opciones de soporte, también puedes consultar /pricing.