Cómo se ve una “arquitectura más limpia” en el trabajo asistido por IA

“Arquitectura más limpia” en este post no significa un framework concreto ni un diagrama perfecto. Significa que puedes explicar el sistema de forma simple, cambiarlo sin romper partes no relacionadas y verificar el comportamiento sin tests heroicos.

Una definición práctica: claridad, modularidad, testeabilidad

Claridad significa que el propósito y la forma del sistema son obvios desde una breve descripción: qué hace, quién lo usa, qué datos maneja y qué nunca debe hacer. En el trabajo asistido por IA, la claridad también significa que el modelo puede reformular los requisitos de vuelta a ti de una forma que aprobarías.

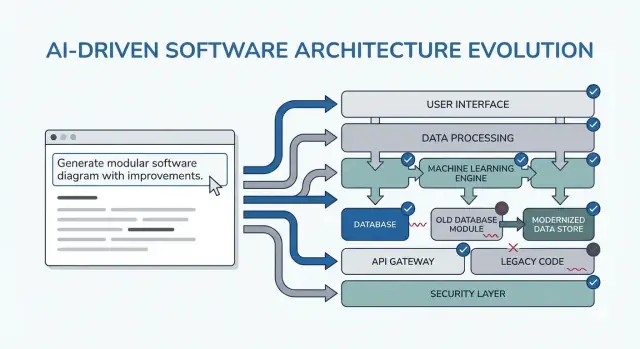

Modularidad significa que las responsabilidades tienen límites claros. Cada módulo tiene un trabajo, entradas/salidas y mínimo conocimiento de los internos de otros módulos. Cuando la IA genera código, la modularidad evita que esparza reglas de negocio por controladores, UI y acceso a datos.

Testeabilidad significa que la arquitectura hace que “probar que funciona” sea barato. Las reglas de negocio pueden testearse sin un sistema en ejecución completo, y las pruebas de integración se enfocan en unos pocos contratos en lugar de cada camino de código.

Por qué ocurren reescrituras (y por qué la IA puede amplificarlas)

Las reescrituras normalmente no son causadas por “mal código”: son causadas por restricciones faltantes, alcance vago y suposiciones ocultas. Ejemplos:

- Se construye una función para un tipo de usuario y luego descubres que hay tres roles y permisos distintos.

- Reglas de rendimiento, logging de auditoría o retención de datos aparecen tarde.

- Una API externa se comporta distinto a lo esperado, obligando a cambios por todas partes.

La IA puede acelerar este modo de fallo al producir salidas convincentes rápido, lo que facilita construir sobre cimientos frágiles.

Qué esperar de los patrones en esta guía

Los patrones que siguen son plantillas para adaptar, no prompts mágicos. Su objetivo real es forzar las conversaciones correctas temprano: aclarar restricciones, comparar opciones, documentar suposiciones y definir contratos. Si te saltas ese pensamiento, el modelo rellenará los huecos con gusto—y lo pagarás después.

Dónde encajan estos patrones en tu flujo

Los usarás a lo largo de todo el ciclo de entrega:

- Planificación: afinar requisitos y criterios de éxito

- Diseño: elegir límites, flujos de datos y contratos

- Codificación: mantener responsabilidades separadas a medida que crece la implementación

- Revisión: detectar riesgos y desajustes antes de que sean reescrituras

Si usas un flujo de vibe-coding (donde el sistema se genera e itera vía chat), estos checkpoints importan aún más. Por ejemplo, en Koder.ai puedes ejecutar un bucle en “modo planificación” para cerrar requisitos y contratos antes de generar React/Go/PostgreSQL, y luego usar snapshots/rollback para iterar de forma segura cuando cambian las suposiciones—sin convertir cada cambio en una reescritura.

Cómo usar patrones de prompting sin crear más trabajo

Los patrones de prompting son más valiosos cuando reducen la fricción en las decisiones. El truco es usarlos como checkpoints cortos y repetibles—antes de codificar, mientras diseñas y durante la revisión—para que la IA produzca artefactos reutilizables, no texto extra que tengas que filtrar.

Cuándo usar patrones

Antes de codificar: ejecuta un bucle de “alineación” para confirmar objetivos, usuarios, restricciones y métricas de éxito.

Durante el diseño: usa patrones que fuerzan compensaciones explícitas (p. ej., alternativas, riesgos, límites de datos) antes de implementar.

Durante la revisión: usa un prompt estilo checklist para detectar huecos (casos límite, monitorización, seguridad, rendimiento) mientras los cambios aún son baratos.

Reúne entradas primero (hazlo ligero)

Obtendrás mejor output con un paquete pequeño y consistente de entradas:

- Objetivos: qué significa “listo” (objetivos de latencia, resultados UX, límites de coste)

- Usuarios: roles, flujos clave y principales puntos de dolor

- Restricciones: stack tecnológico, plazos, requisitos de cumplimiento/seguridad

- Datos e integraciones: fuentes, propiedad, APIs, dependencias de terceros

Si no sabes algo, dilo explícitamente y pide a la IA que liste suposiciones.

En lugar de “explica el diseño”, solicita artefactos que puedas pegar en docs o tickets:

- Un registro de decisiones (opciones → pros/contras → elegido → por qué)

- Una tabla de componentes con responsabilidades y límites

- Un checklist para fiabilidad y pruebas

- Una descripción de diagrama simple (p. ej., texto Mermaid) que puedas renderizar después

Itera en bucles cortos con criterios de aceptación

Haz ciclos de 10–15 minutos: prompt → hojear → afinar. Siempre incluye criterios de aceptación (qué debe ser cierto para que el diseño sea aceptable), y pide a la IA que se auto-verifique contra ellos. Eso evita rediseños infinitos y hace que los patrones de las siguientes secciones sean rápidos de aplicar.

Patrón 1: Aclara los requisitos antes de cualquier diseño

La mayoría de las “reescrituras de arquitectura” no son causadas por diagramas malos—son causadas por construir lo correcto para el problema equivocado (o incompleto). Cuando usas un LLM temprano, no pidas primero una arquitectura. Pídele que exponga la ambigüedad.

El movimiento de prompting: convierte la incertidumbre en un checklist

Usa el modelo como entrevistador de requisitos. Tu objetivo es una especificación corta y priorizada que puedas confirmar antes de que alguien diseñe componentes, elija bases de datos o se comprometa con APIs.

Aquí tienes una plantilla de copiar y pegar que puedes reutilizar:

You are my requirements analyst. Before proposing any architecture, do this:

1) Ask 10–15 clarifying questions about missing requirements and assumptions.

- Group questions by: users, workflows, data, integrations, security/compliance, scale, operations.

2) Produce a prioritized scope list:

- Must-have

- Nice-to-have

- Explicitly out-of-scope

3) List constraints I must confirm:

- Performance (latency/throughput targets)

- Cost limits

- Security/privacy

- Compliance (e.g., SOC2, HIPAA, GDPR)

- Timeline and team size

4) End with: “Restate the final spec in exactly 10 bullets for confirmation.”

Context:

- Product idea:

- Target users:

- Success metrics:

- Existing systems (if any):

Qué buscar en la salida

Quieres preguntas que obliguen a tomar decisiones (no genéricos “cuéntame más”), además de una lista de must-have que realmente pueda cerrarse dentro de tu timeline.

Trata la reformulación de “10 viñetas” como un contrato: pégala en tu ticket/PRD, obtén un sí/no rápido de los stakeholders y solo entonces pasa a la arquitectura. Este paso evita la causa más común de refactors tardíos: construir características que nunca fueron realmente requeridas.

Patrón 2: Primero los recorridos de usuario, luego las elecciones técnicas

Cuando empiezas por herramientas (“¿Deberíamos usar event sourcing?”) a menudo terminas diseñando para la arquitectura en lugar del usuario. Un camino más rápido a una estructura limpia es pedirle a la IA que describa primero los recorridos de usuario en lenguaje claro y solo después traducir esos recorridos en componentes, datos y APIs.

Una plantilla simple de journey-first

Usa esto como punto de partida para copiar y pegar:

- Roles: user / admin / system

- Acciones clave: qué intenta lograr cada rol

- Casos límite: qué puede fallar (entrada inválida, permisos faltantes, finalización parcial)

Luego pide:

-

“Describe the step-by-step flow for each action in plain language.”

-

“Provide a simple state diagram or state list (e.g., Draft → Submitted → Approved → Archived).”

-

“List non-happy-path scenarios: timeouts, retries, duplicate requests, cancellations, and invalid inputs.”

Convertir recorridos en decisiones (sin adelantarse)

Una vez claros los flujos, puedes pedir a la IA que los mapee a decisiones técnicas:

- ¿Dónde necesitamos validación vs reglas de negocio?

- ¿Qué pasos requieren idempotencia (reintentos seguros)?

- ¿Qué datos deben ser almacenados, cuáles pueden derivarse y qué necesita rastro de auditoría?

Solo después pide un boceto de arquitectura (servicios/módulos, límites y responsabilidades) directamente vinculado a los pasos del flujo.

Convertir flujos en criterios de aceptación testeables

Finaliza pidiendo a la IA que convierta cada recorrido en criterios de aceptación que puedas probar:

- “Given/When/Then para cada paso y caso de fallo.”

- “¿Qué debe devolver o mostrar el sistema?”

- “¿Qué debe registrarse y qué debe desencadenar un reintento vs un error visible al usuario?”

Este patrón reduce reescrituras porque la arquitectura crece desde el comportamiento del usuario—no desde suposiciones sobre la tecnología.

Patrón 3: Registro de suposiciones para prevenir reescrituras sorpresa

La mayoría del rework de arquitectura no se debe a “mal diseño”—se debe a suposiciones ocultas que resultan ser falsas. Cuando pides una arquitectura a un LLM, a menudo rellenará los huecos con conjeturas plausibles. Un registro de suposiciones hace visibles esas conjeturas temprano, cuando los cambios son baratos.

Qué pedir al modelo que haga

Tu objetivo es forzar una separación clara entre hechos que proporcionaste y suposiciones que inventó.

Usa este patrón de prompt:

Template prompt

“Before proposing any solution: list your assumptions. Mark each as validated (explicitly stated by me) or unknown (you inferred it). For each unknown assumption, propose a fast way to validate it (question to ask, metric to check, or quick experiment). Then design based only on validated assumptions, and call out where unknowns could change the design.”

Mantenlo corto para que la gente realmente lo use:

- Assumption: …

- Status: validated / unknown

- Why it matters: qué decisión afecta

- How to validate: pregunta, comprobación o spike

- If wrong, likely change: qué rediseñarías

Disparadores “¿qué cambiaría tu respuesta?”

Añade una línea que obligue al modelo a decirte sus puntos de inflexión:

- “List 5 triggers: what would change your answer? (e.g., user volume, latency targets, compliance needs, data retention rules).”

Este patrón convierte la arquitectura en un conjunto de decisiones condicionales. No solo obtienes un diagrama: obtienes un mapa de lo que debe confirmarse antes de comprometerte.

Patrón 4: Compara múltiples arquitecturas antes de elegir una

Lanza cuando estés listo

Despliega y hospeda tu app cuando estés listo para compartir una versión funcional.

Las herramientas de IA son geniales produciendo un único “mejor” diseño—pero a menudo esa es solo la primera opción plausible. Una arquitectura más limpia suele aparecer cuando fuerzas una comparación temprano, mientras los cambios son baratos.

La plantilla de prompt central

Usa un prompt que requiera múltiples arquitecturas y una tabla de compensaciones estructurada:

Propose 2–3 viable architectures for this project.

Compare them in a table with criteria: complexity, reliability, time-to-ship, scalability, cost.

Then recommend one option for our constraints and explain why it wins.

Finally, list “what we are NOT building” in this iteration to keep scope stable.

Context:

- Users and key journeys:

- Constraints (team size, deadlines, budget, compliance):

- Expected load and growth:

- Current systems we must integrate with:

Por qué esto reduce reescrituras

Una comparación fuerza al modelo (y a ti) a sacar a la luz suposiciones ocultas: dónde vive el estado, cómo se comunican servicios, qué debe ser sincrónico y qué puede demorarse.

La tabla de criterios importa porque evita debates como “microservicios vs monolito” basados en opinión. Ancla la decisión a lo que realmente te importa: entregar rápido, reducir overhead operacional o mejorar fiabilidad.

Exigir recomendación y un límite

No aceptes “depende.” Pide una recomendación clara y las restricciones específicas que optimiza.

También insiste en “qué NO construimos.” Ejemplos: “No multi-region failover”, “No plugin system”, “No notificaciones en tiempo real.” Esto evita que la arquitectura se expanda silenciosamente para soportar features no comprometidas aún—y previene reescrituras sorpresa cuando el alcance cambia.

Patrón 5: Prompts para límites modulares y responsabilidades

La mayoría de las reescrituras ocurren porque los límites son vagos: todo “toca todo”, y un pequeño cambio se propaga por todo el código. Este patrón usa prompts que obligan a definir propiedad modular clara antes de debatir frameworks o diagramas de clases.

La idea central

Pide a la IA que defina módulos y responsabilidades, además de qué explícitamente no pertenece a cada módulo. Luego solicita interfaces (entradas/salidas) y reglas de dependencia, no un plan de construcción o detalles de implementación.

Plantilla de copiar y pegar

Usa esto cuando estés esbozando una nueva feature o refactorizando un área desordenada:

- Context: <one paragraph about the product/feature>

- Goal: Propose a modular architecture with 4–8 modules.

-

Lista módulos con:

- Propósito (1 frase)

- Responsabilidades (3–5 viñetas)

- No-responsabilidades (“NO maneja…”) (2–3 viñetas)

-

Para cada módulo, define solo interfaces:

- Entradas (eventos/requests/data)

- Salidas (respuestas/eventos/efectos secundarios)

- Superficie pública API (nombres de funciones o endpoints ok; no clases internas)

-

Reglas de dependencia:

- Dependencias permitidas (A → B)

- Dependencias prohibidas (A ↛ C) con razonamiento

- Dónde viven tipos compartidos (y qué nunca debe compartirse)

-

Prueba de cambio futuro: Dadas estos cambios probables: <list 3>, muestra qué módulo único debería absorber cada cambio y por qué.

Cómo luce una buena salida

Apuntas a módulos que puedas describir a un compañero en menos de un minuto. Si la IA propone un módulo “Utils” o pone reglas de negocio en controladores, empuja: “Mueve la toma de decisiones a un módulo de dominio y mantén los adaptadores delgados.”

Al terminar, tienes límites que sobreviven a nuevos requisitos—porque los cambios tienen un hogar claro y las reglas de dependencia previenen acoplamientos accidentales.

Patrón 6: Contratos de datos y API primero (evita rework de integración)

El retrabajo de integración a menudo no viene por “mal código”—viene por contratos poco claros. Si el modelo de datos y las formas de API se deciden tarde, cada equipo (o módulo) rellena los huecos de forma distinta, y pasas el siguiente sprint conciliando suposiciones desajustadas.

Comienza solicitando contratos antes de hablar de frameworks, bases de datos o microservicios. Un contrato claro se vuelve la referencia compartida que alinea UI, backend y pipelines de datos.

El prompt contract-first

Usa este prompt temprano con tu asistente de IA:

- Template: “Describe el modelo de datos, la propiedad y el ciclo de vida para cada entidad”

Después sigue inmediatamente con:

- Pide contratos de API con ejemplos (requests, responses, formas de error)

- Añade versionado y expectativas de compatibilidad hacia atrás

- Solicita reglas de validación y casos límite por campo

Cómo luce una buena salida

Quieres artefactos concretos, no prosa. Por ejemplo:

- Entidad:

Subscription

- Owner: Billing service

- Lifecycle: created on checkout → active → past_due → canceled (soft-delete after 90 days)

- Source of truth: billing DB; other services cache read-only copies

Y un boceto de API:

POST /v1/subscriptions

{

"customer_id": "cus_123",

"plan_id": "pro_monthly",

"start_date": "2026-01-01"

}

201 Created

{

"id": "sub_456",

"status": "active",

"current_period_end": "2026-02-01"

}

422 Unprocessable Entity

{

"error": {

"code": "VALIDATION_ERROR",

"message": "start_date must be today or later",

"fields": {"start_date": "in_past"}

}

}

Reglas de versionado y compatibilidad

Haz que la IA declare reglas como: “Los campos aditivos están permitidos sin bump de versión; renombrar requiere /v2; los clientes deben ignorar campos desconocidos.” Este paso evita cambios incompatibles silenciosos—y las reescrituras que siguen.

Patrón 7: Modos de fallo y checklist de fiabilidad

Planifica antes de construir

Usa el modo de planificación para convertir requisitos en contratos claros antes de generar código.

Las arquitecturas se reescriben cuando los diseños “happy path” se enfrentan al tráfico real, dependencias inestables y comportamiento de usuario inesperado. Este patrón convierte la fiabilidad en una salida de diseño explícita, no en un scramble post-lanzamiento.

Plantilla copiar/pegar

Usa esto con tu descripción de arquitectura elegida:

List failure modes; propose mitigations; define observability signals.

Para cada modo de fallo:

- ¿Qué lo desencadena?

- Impacto en el usuario (qué experimenta el usuario)

- Mitigación (diseño + operacional)

- Retries, idempotency, rate limits, timeouts consideraciones

- Observabilidad: logs/metrics/traces + umbrales de alerta

Qué pedir que cubra (no negociables)

Enfoca la respuesta nombrando las interfaces que pueden fallar: APIs externas, base de datos, colas, proveedor de auth y jobs en background. Luego exige decisiones concretas:

- Reintentos: cuándo reintentar, cuántos, estrategia de backoff y qué errores son retryables.

- Idempotencia: claves de idempotencia, ventanas de deduplicación y qué estado es seguro replayear.

- Rate limits: límites por usuario/IP/servicio, mensajes al cliente y protección server-side.

- Timeouts: por dependencia, presupuesto total de request y propagación de cancelaciones.

Salida: checklist de fiabilidad

Termina el prompt con: “Devuelve un checklist simple que podamos revisar en 2 minutos.” Un buen checklist incluye ítems como: timeouts por dependencia, retries acotados, idempotencia para acciones create/charge, control de presión/backpressure, ruta de degradación elegante definida.

Observabilidad ligada a acciones de usuario

Solicita eventos alrededor de momentos de usuario (no solo internos): “user_signed_up”, “checkout_submitted”, “payment_confirmed”, “report_generated”. Para cada uno, pide:

- Campos de log (user_id, request_id, idempotency_key)

- Métricas (tasa de éxito, latencia p95/p99, contador de reintentos)

- Traces (spans por llamada a dependencia)

Esto convierte la fiabilidad en un artefacto de diseño que puedes validar antes de que exista código.

Patrón 8: Planificación de slices MVP para reducir sobreconstrucción

Una forma común en que el diseño asistido por IA crea reescrituras es alentando arquitecturas “completas” demasiado pronto. La solución es simple: fuerza el plan a empezar por la porción más pequeña usable—una que entregue valor, pruebe el diseño y mantenga abiertas las opciones futuras.

La plantilla de prompt

Usa esto cuando sientas que la solución se expande más rápido que los requisitos:

Template: “Propose the smallest usable slice; define success metrics; list follow-ups.”

Pide al modelo que responda con:

- MVP slice: lo que incluye para lanzar algo real

- Success metrics: cómo sabrás que funcionó (usuario + técnico)

- Follow-ups: qué puede esperar sin bloquear el aprendizaje

Exige una hoja de ruta por fases (MVP → v1 → v2)

Añade: “Da una hoja de ruta por fases: MVP → v1 → v2, y explica qué riesgo reduce cada fase.” Esto mantiene ideas posteriores visibles sin forzarlas en la primera entrega.

Resultados de ejemplo que buscas:

- MVP valida el flujo central y una vía end-to-end delgada.

- v1 endurece fiabilidad y añade usabilidad imprescindible.

- v2 amplía alcance (más integraciones, roles avanzados, optimizaciones).

Exigir exclusiones explícitas para evitar expansión de alcance

La línea más poderosa en este patrón es: “Lista qué está explícitamente fuera del alcance para el MVP.” Las exclusiones protegen decisiones de arquitectura de complejidad prematura.

Buenas exclusiones:

- “No multi-region failover en MVP (log incidents; plan para v2).”

- “No plugin system todavía (mantener límites limpios, pero lanzar módulos fijos).”

- “Solo un proveedor de pagos; abstraer más tarde si hace falta.”

Convierte el plan en tickets con dependencias

Finalmente: “Convierte el MVP en tickets, cada uno con criterios de aceptación y dependencias.” Esto obliga a claridad y revela acoplamientos ocultos.

Un buen desglose de tickets suele incluir:

- Una vía end-to-end delgada “happy path”

- Modelo de datos mínimo + contrato API

- Manejo de errores y logging básico

- Un punto de integración (si hace falta) con fallback stubbed

Si quieres, enlaza esto directamente a tu flujo pidiendo al modelo salida en el formato de tu equipo (p. ej., campos estilo Jira) y mantén fases posteriores como backlog separado.

Patrón 9: Prompts test-first que moldean mejores diseños

Controla tu base de código

Exporta el código fuente cuando quieras tener control total sobre la app que generaste.

Una forma simple de evitar que la arquitectura se desvíe es forzar claridad mediante tests antes de pedir un diseño. Cuando pides a un LLM que comience con tests de aceptación, debe nombrar comportamientos, inputs, outputs y casos límite. Eso expone requisitos faltantes y empuja la implementación hacia límites modulares limpios.

Plantilla copiar/pegar

Usa esto como prompt “puerta” cuando vayas a diseñar un componente:

- Template: “Write acceptance tests first; then propose implementation. You must: (1) list assumptions, (2) name unit vs integration tests, (3) define test data and mocks vs real dependencies, (4) include a definition of done.”

Pide límites de pruebas que coincidan con módulos

Sigue con: “Agrupa las pruebas por responsabilidad de módulo (capa API, lógica de dominio, persistencia, integraciones externas). Para cada grupo, especifica qué se mockea y qué es real.”

Esto empuja al LLM lejos de diseños enmarañados donde todo toca todo. Si no puede explicar dónde empiezan las pruebas de integración, probablemente tu arquitectura aún no está clara.

Estrategia de datos de prueba: evita suites frágiles

Pide: “Propón un plan de datos de prueba: fixtures vs factories, cómo generar casos límite y cómo mantener tests deterministas. Lista qué dependencias pueden usar fakes en memoria y cuáles requieren servicio real en CI.”

A menudo descubrirás que una feature “simple” necesita un contrato, un dataset semilla o IDs estables—mejor detectarlo ahora que durante una reescritura.

Definición de done (para que el diseño se entregue)

Termina con un checklist ligero:

- Tests pasando (unit + integration) y cobertura significativa de casos de fallo

- Docs mínimos: uso, configuración y una nota corta de troubleshooting

- Monitorización/alertas para modos de fallo clave

- Plan de rollout (feature flag, pasos de migración, rollback)

Patrón 10: Prompts de revisión de diseño para detectar problemas temprano

Las revisiones de diseño no deben ocurrir solo después de que exista código. Con IA, puedes ejecutar una “revisión pre-mortem” sobre tu borrador de arquitectura (aunque sea solo unos párrafos y un diagrama en palabras) y obtener una lista concreta de debilidades antes de que se conviertan en reescrituras.

La plantilla de revisión central

Comienza con una postura de revisor directo y fuerza especificidad:

Prompt: “Act as a reviewer; list risks, inconsistencies, and missing details in this design. Be concrete. If you can’t evaluate something, say what information is missing.”

Pega tu resumen de diseño, restricciones (presupuesto, timeline, habilidades del equipo) y requisitos no funcionales (latencia, disponibilidad, cumplimiento).

Convierte feedback en una lista de acciones

Las revisiones fallan cuando el feedback es vago. Pide una lista priorizada de arreglos:

Prompt: “Give me a prioritized punch list. For each item: severity (Blocker/High/Medium/Low), why it matters, suggested fix, and the smallest validation step.”

Esto produce tareas listas para decisión en vez de un debate.

Cuantifica el riesgo de reescritura

Un mecanismo útil es un puntaje simple:

Prompt: “Assign a rewrite risk score from 1–10. Explain the top 3 drivers. What would reduce the score by 2 points with minimal effort?”

No buscas precisión; buscas surfacear las suposiciones más propensas a reescribir.

Termina con un “plan diff”

Finalmente, evita que la revisión expanda alcance:

Prompt: “Provide a diff plan: minimal changes needed to reach the target design. List what stays the same, what changes, and any breaking impacts.”

Si repites este patrón en cada iteración, tu arquitectura evoluciona mediante pasos pequeños y reversibles—mientras los grandes problemas se detectan temprano.

Un pack de prompts copiar/pegar y un flujo simple

Usa este pack como un flujo ligero que repites en cada feature. La idea es encadenar prompts para que cada paso produzca un artefacto que el siguiente puede reutilizar—reduciendo “contexto perdido” y reescrituras sorpresa.

El flujo de 6 pasos (encadena estos patrones)

- Requisitos (aclarar + restricciones)

- Opciones de arquitectura (comparar 2–3 enfoques)

- Límites (módulos + responsabilidades)

- Contratos (datos + APIs)

- Pruebas (aceptación test-first + tests clave)

- Revisión (modos de fallo + checklist de revisión)

En la práctica, los equipos suelen implementar esta cadena como una “receta de feature” repetible. Si construyes con Koder.ai, la misma estructura se mapea bien a un proceso de build guiado por chat: captura los artefactos en un lugar, genera la primera slice funcional y luego itera con snapshots para que los experimentos sean reversibles. Cuando el MVP esté listo, puedes exportar código fuente o desplegar/hostear con dominio personalizado—útil cuando quieres la velocidad de entrega asistida por IA sin bloquearte en un solo entorno.

Pack de prompts copiar/pegar (con guardrails)

SYSTEM (optional)

You are a software architecture assistant. Be practical and concise.

Guardrail: When you make a recommendation, cite the specific lines from *my input* you relied on by quoting them verbatim under “Input citations”. Do not cite external sources or general industry claims.

If something is unknown, ask targeted questions.

1) REQUIREMENTS CLARIFIER

Context: <product/system overview>

Feature: <feature name>

My notes: <paste bullets, tickets, constraints>

Task:

- Produce: (a) clarified requirements, (b) non-goals, (c) constraints, (d) open questions.

- Include “Input citations” quoting the exact parts of my notes you used.

2) ARCHITECTURE OPTIONS

Using the clarified requirements above, propose 3 architecture options.

For each: tradeoffs, complexity, risks, and when to choose it.

End with a recommendation + “Input citations”.

3) MODULAR BOUNDARIES

Chosen option: <option name>

Define modules/components and their responsibilities.

- What each module owns (and does NOT own)

- Key interfaces between modules

- “Input citations”

4) DATA & API CONTRACTS

For each interface, define a contract:

- Request/response schema (or events)

- Validation rules

- Versioning strategy

- Error shapes

- “Input citations”

5) TEST-FIRST ACCEPTANCE

Write:

- Acceptance criteria (Given/When/Then)

- 5–10 critical tests (unit/integration)

- What to mock vs not mock

- “Input citations”

6) RELIABILITY + DESIGN REVIEW

Create:

- Failure modes list (timeouts, partial failure, bad data, retries)

- Observability plan (logs/metrics/traces)

- Review checklist tailored to this feature

- “Input citations”

Si quieres un companion más profundo, ve a /blog/prompting-for-code-reviews. Si evaluas tooling o rollout en el equipo, /pricing es un siguiente paso práctico.