28 ago 2025·8 min

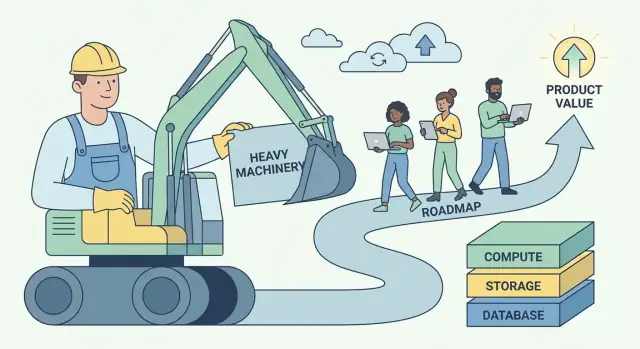

Playbook de Andy Jassy en AWS: convertir el trabajo pesado en valor

Cómo Andy Jassy moldeó AWS alrededor del “trabajo pesado no diferenciador” y lo convirtió en un modelo repetible para construir negocios y plataformas de software escalables.

Qué significa realmente “trabajo pesado no diferenciador"

“Trabajo pesado no diferenciador” es una idea simple con filo: es el trabajo que debes hacer para ejecutar tu software, pero que no hace que los clientes te elijan.

Incluye tareas como aprovisionar servidores, parchear bases de datos, rotar credenciales, configurar monitorización, gestionar failover, escalar capacidad y perseguir incidentes de producción causados por la infraestructura más que por el producto. Estos trabajos son reales, importantes y a menudo urgentes, pero rara vez crean una experiencia única para los usuarios.

Definición en lenguaje llano

Si una tarea es:

- Necesaria (no puedes evitarla si quieres fiabilidad)

- Repetible (cada equipo hace una versión similar)

- No es una ventaja competitiva (los clientes no pagarán más porque tú la hiciste internamente)

…es trabajo pesado no diferenciador.

Por qué la frase conectó con creadores y directivos

Los desarrolladores oyeron alivio en ella: permiso para dejar de tratar el trabajo operativo como una medalla de honor. Si todo el mundo está reinventando los mismos scripts de despliegue y runbooks de on-call, eso no es artesanía: es enfoque desperdiciado.

Los ejecutivos oyeron apalancamiento: esta categoría de trabajo es cara, escala mal con plantilla y genera riesgo. Reducirla mejora márgenes, fiabilidad y velocidad al mismo tiempo.

El patrón de negocio al que apunta esta idea

AWS popularizó un playbook repetible:

- Eliminar el trabajo repetitivo convirtiendo operaciones frágiles, equipo por equipo, en un servicio.

- Estandarizar las partes comunes para que la calidad sea consistente.

- Escalar mediante automatización e infraestructura compartida.

- Reinvertir los ahorros en mejores productos y entregas más rápidas.

Esto es más que infraestructura en la nube: es “pensamiento de plataforma” aplicado a cualquier negocio de software.

Qué esperar de este artículo

Traduciremos el concepto en señales prácticas que puedas ver en tu producto y equipo, mostraremos cómo los servicios gestionados y las plataformas internas empaquetan operaciones como producto, y cubriremos los tradeoffs reales (control, coste y lock-in). Te irás con un marco para decidir qué construir vs. comprar—y cómo convertir trabajo no diferenciador en valor de negocio compuesto.

La idea central de Andy Jassy: los clientes quieren construir, no vigilar

Andy Jassy fue uno de los líderes tempranos que ayudó a convertir las capacidades de infraestructura internas de Amazon en lo que se convirtió en AWS. Su trabajo no fue solo “vender servidores por internet.” Fue notar un problema repetible del cliente y empaquetar una solución que pudiera escalar a miles de equipos.

El verdadero dolor: las operaciones roban atención al producto

La mayoría de equipos de software no se levantan entusiasmados para parchear sistemas operativos, aprovisionar capacidad, rotar credenciales o recuperarse de un disco fallido. Hacen esas cosas porque deben: de lo contrario la app no funciona.

La idea central de Jassy fue que gran parte de este trabajo es necesario pero no diferenciador. Si gestionas un sitio de e‑commerce, una app fintech o una herramienta interna de RR. HH., tus clientes valoran tus funcionalidades: checkout más rápido, mejor detección de fraude, incorporación más fluida. Rara vez te recompensan por mantener una flota de servidores perfectamente afinada.

Así que la “vigilancia” de la infraestructura se convierte en un impuesto:

- Consume tiempo que podría dedicarse a enviar mejoras.

- Obliga a los equipos a contratar habilidades en las que no quieren especializarse.

- Aumenta el riesgo porque cada empresa vuelve a aprender las mismas lecciones operativas.

Por qué el momento importó

Esta idea llegó en un momento en que las exigencias crecían por todos lados:

- La escala de Internet hizo el tráfico impredecible; planear para picos era caro.

- Las startups necesitaban moverse rápido sin construir un equipo de centros de datos.

- TI empresarial enfrentaba presión para entregar más rápido mientras gestionaba seguridad y cumplimiento.

El principio no fue “mueve todo a la nube.” Fue más simple: elimina las cargas operativas repetibles para que los clientes puedan dedicar más energía a lo que los hace diferentes. Ese cambio—tiempo y atención de vuelta al desarrollo—se convirtió en la base de un negocio de plataforma.

Cómo detectar trabajo pesado en tu producto y equipo

El primer paso es separar el trabajo imprescindible (necesario para ejecutar un producto creíble) de la diferenciación (las razones por las que los clientes te eligen).

Lo imprescindible no es “sin importancia.” A menudo es crítico para la fiabilidad y la confianza. Pero rara vez crea preferencia por sí solo—especialmente cuando los competidores pueden alcanzar el mismo umbral.

Señales comunes de “trabajo pesado”

Si no estás seguro qué pertenece al cubo no diferenciador, busca trabajo que sea:

- Necesario, repetitivo y no negociable

- Costoso cuando falla, pero mayormente invisible cuando funciona

- Resuelto de maneras parecidas en muchas empresas

En equipos de software, esto suele incluir:

- Gestión de servidores o clusters

- Parcheo de seguridad y actualizaciones de dependencias

- Backups y ejercicios de recuperación ante desastres

- Autoescalado y planificación de capacidad

- Monitorización básica, logging y alertas

- Rotaciones de on-call para modos de fallo predecibles

Ninguno de estos es “malo.” La pregunta es si hacerlos tú mismo forma parte del valor de tu producto—o solo es el precio de entrada.

La prueba más sencilla: ¿los clientes pagarían por ello?

Una regla práctica es:

“¿Los clientes te pagarían por esto específicamente, o solo lo esperarían incluido?”

Si la respuesta es “solo se enfadarían si falta,” probablemente estés viendo trabajo pesado no diferenciador.

Una segunda prueba: si eliminaras este trabajo mañana adoptando un servicio gestionado, ¿tus mejores clientes aún te valorarían por lo que queda? Si la respuesta es sí, has encontrado un candidato para descargar, automatizar o productizar.

“No diferenciador” cambia según el mercado

Lo que es no diferenciador en una empresa puede ser propiedad intelectual en otra. Un proveedor de bases de datos puede diferenciarse por backup y replicación. Una fintech probablemente no debería hacerlo. Tu objetivo no es copiar el límite de otro: es trazar el tuyo según lo que tus clientes realmente premian.

Cuando mapeas tu roadmap y el trabajo operativo con esta lente, empiezas a ver dónde se gastan tiempo, talento y atención solo para mantener el statu quo.

Por qué esta idea crea enorme valor de negocio

“Trabajo pesado no diferenciador” no es solo un truco de productividad. Es un modelo de negocio: toma un problema que muchas empresas deben resolver, pero en el que nadie quiere diferenciarse, y conviértelo en un servicio por el que la gente paga gustosamente.

Los problemas comoditizados alimentan plataformas

Los mejores candidatos son necesidades con baja unicidad estratégica: aprovisionar servidores, parchear bases de datos, rotar credenciales, escalar colas, gestionar backups. Cada equipo los necesita, casi todos preferirían no construirlos, y la “respuesta correcta” es en gran medida similar entre empresas.

Esa combinación crea un mercado predecible: alta demanda, requisitos repetidos y métricas de éxito claras (uptime, latencia, cumplimiento, tiempo de recuperación). Una plataforma puede estandarizar la solución y seguir mejorándola con el tiempo.

Economías de escala: repartir costes fijos entre clientes

La excelencia operativa tiene grandes costes fijos—SREs, especialistas en seguridad, rotaciones de on-call, auditorías, herramientas de incidentes y monitorización 24/7. Cuando cada empresa construye esto a solas, esos costes se duplican miles de veces.

Una plataforma reparte esas inversiones fijas entre muchos clientes. El coste por cliente baja a medida que aumenta la adopción, mientras que la calidad puede subir porque el proveedor puede justificar una especialización más profunda.

El bucle de fiabilidad: la especialización compone el uptime y la seguridad

Cuando un equipo de servicio ejecuta el mismo componente para muchos clientes, ve más casos límite, detecta patrones más rápido y construye mejor automatización. Los incidentes se convierten en insumos: cada fallo endurece el sistema, mejora los playbooks y ajusta las guardrails.

La seguridad se beneficia de forma similar. Los equipos dedicados pueden invertir en modelado de amenazas, parcheo continuo y controles de cumplimiento que serían difíciles para un único equipo de producto mantener.

Poder de fijación de precios: uso + confianza + costes de cambio (con cuidado)

Las plataformas suelen ganar poder de precio mediante precios basados en uso: los clientes pagan en proporción al valor consumido y pueden empezar pequeño. Con el tiempo, la confianza se convierte en diferenciador—fiabilidad y seguridad hacen que el servicio sea la “opción segura por defecto”.

Los costes de cambio también aumentan a medida que las integraciones se profundizan, pero la versión más sana se gana en lugar de atrapar: mejor rendimiento, mejores herramientas, facturación más clara y menos incidentes. Eso mantiene a los clientes renovando incluso cuando existen alternativas. Para más sobre cómo aparece esto en empaquetado y monetización, consulta /pricing.

El patrón AWS: de primitivos a servicios gestionados

AWS no ganó ofreciendo “servidores en Internet.” Ganó tomando repetidamente un problema operativo duro, dividiéndolo en bloques más simples y luego recompensando esos bloques en servicios donde AWS gestiona el trabajo de día 2 por ti.

La escalera repetible: primitivo → servicio → servicio gestionado → plataforma

Piénsalo como una escalera de madurez:

- Primitivo: Ingredientes crudos que puedes ensamblar tú mismo (VMs, discos, redes)

- Servicio: Una API más opinada alrededor de una capacidad (almacenamiento de objetos, balanceo)

- Servicio gestionado: AWS opera escalado, parcheo, backups y recuperación (bases de datos, colas)

- Plataforma: Un portafolio donde los servicios se componen limpiamente, con identidad compartida, facturación, monitorización y políticas

Cada paso elimina decisiones, mantenimiento y el “¿y si falla a las 3 a.m.?” de responsabilidad del cliente.

Ejemplos AWS (mapeo conceptual)

AWS aplicó el mismo patrón en categorías clave:

-

Compute: Comienza con máquinas virtuales (EC2). Avanza a niveles superiores donde el despliegue y el escalado son por defecto (por ejemplo, contenedores gestionados/estilos serverless). El cliente se centra en código e intención de capacidad, no en el cuidado de hosts.

-

Almacenamiento: De discos y sistemas de archivos a almacenamiento de objetos (S3). La abstracción pasa de “gestionar volúmenes” a “put/get objetos”, mientras durabilidad, replicación y escalado son problema de AWS.

-

Bases de datos: De “instalar una BD en una VM” a bases de datos gestionadas (RDS, DynamoDB). Backups, parcheo, réplicas de lectura y failover dejan de ser runbooks personalizados y se convierten en configuración.

-

Mensajería: De colas hechas a mano y workers a mensajería gestionada (SQS/SNS). Semánticas de entrega, reintentos y ajuste de throughput se estandarizan para que los equipos construyan flujos de trabajo en lugar de infraestructura.

Por qué las abstracciones reducen la carga cognitiva

Los servicios gestionados reducen la carga cognitiva de dos maneras:

- Menos partes móviles que razonar. Tu diagrama arquitectónico se encoge de “instancias + scripts + cron + alertas + backups” a “servicio + ajustes”.

- Menos modos de fallo que debes poseer. Aún diseñas para resiliencia, pero ya no eres responsable por la mecánica de parcheo, clustering y recuperación rutinaria.

El resultado es incorporación más rápida, menos runbooks personalizados y operaciones más consistentes entre equipos.

Lista de comprobación (reusea esto en tu producto)

- ¿Qué están construyendo los clientes que es necesario pero no diferenciador?

- ¿Puedes convertir sus runbooks recurrentes en una API única y estable?

- ¿Qué tareas puedes hacer por defecto (backups, escalado, upgrades) en lugar de opcionales?

- ¿Se mueven los “bordes afilados” detrás de límites y guardrails sensatos?

- ¿Pueden varios equipos reutilizarlo sin conocimiento experto?

- ¿Se compone con el resto de tu sistema (identidad, monitorización, facturación, políticas)?

Empaquetar operaciones como producto

Lanza la primera versión más rápido

Crea un proyecto web, backend o móvil a partir de una instrucción clara y luego itera rápido.

Una forma útil de leer AWS es: no solo vende tecnología, vende operaciones. El “producto” no es solo un endpoint de API: es todo lo necesario para ejecutar esa capacidad de forma segura, predecible y a escala.

APIs vs autoservicio vs gestión completa

Una API te da bloques de construcción. Puedes aprovisionar recursos, pero todavía diseñas guardrails, monitorizas fallos, gestionas upgrades y respondes “¿quién cambió qué?”

Autoservicio añade una capa que los clientes pueden usar sin abrir tickets: consolas, plantillas, valores por defecto sensatos y aprovisionamiento automatizado. El cliente aún posee la mayor parte del trabajo de día 2, pero es menos manual.

Gestión completa es cuando el proveedor asume las responsabilidades continuas: parcheo, escalado, backups, failover y muchas clases de respuesta a incidentes. Los clientes se concentran en configurar qué quieren, no cómo se mantiene en funcionamiento.

Las funciones “aburridas” que los clientes no pueden vivir sin

Las capacidades de las que la gente depende a diario rara vez son llamativas:

- IAM y permisos: quién puede hacer qué y cómo se audita el acceso

- Facturación y visibilidad de costes: presupuestos, facturas, tags y alertas

- Cuotas y límites de tasa: protecciones que previenen accidentes y establecen expectativas claras

Esto no son misiones secundarias. Son parte de la promesa que los clientes compran.

Operaciones como característica de primera clase

Lo que hace que un servicio gestionado se sienta “real” es el paquete operativo alrededor: documentación clara, canales de soporte predecibles y límites de servicio explícitos. La buena documentación reduce la carga de soporte, pero más importante aún reduce la ansiedad del cliente. Límites publicados y procesos de cuotas convierten sorpresas en restricciones conocidas.

Cuando empaquetas operaciones como producto, no solo envías funcionalidades: envías confianza.

El diseño organizacional que hace que las plataformas funcionen

Una plataforma tiene éxito o fracasa menos por los diagramas de arquitectura y más por el diseño organizacional. Si los equipos no tienen clientes claros, incentivos y bucles de retroalimentación, la “plataforma” se convierte en una lista de opiniones en backlog.

Equipos internos como primeros clientes (dogfooding)

La forma más rápida de mantener una plataforma honesta es convertir a los equipos de producto internos en los primeros—y más ruidosos—clientes. Eso significa:

- Los equipos de plataforma entregan a equipos internos mediante las mismas interfaces y docs que verían los usuarios externos.

- La adopción se gana (por utilidad), no se impone (por política).

- Tickets de soporte, revisiones de incidentes y decisiones de roadmap tratan a los equipos internos como clientes reales, con SLAs claros.

El dogfooding fuerza claridad: si tus propios equipos evitan la plataforma, los externos también lo harán.

Modelos organizativos: central vs federado

Aparecen repetidamente dos patrones orgánicos:

Equipo de plataforma central: un equipo posee los bloques centrales (CI/CD, identidad, observabilidad, runtime, primitivos de datos). Esto es bueno para consistencia y economías de escala, pero puede convertirse en cuello de botella.

Modelo federado: un equipo central pequeño establece estándares y primitivos compartidos, mientras los equipos de dominio poseen “rebanadas de plataforma” (p. ej., plataforma de datos, plataforma ML). Esto mejora velocidad y ajuste al dominio, pero requiere gobernanza fuerte para evitar fragmentación.

Métricas que importan (y trampas de la plataforma)

Las métricas útiles son outcomes, no actividad:

- Lead time to production (qué tan rápido pueden entregar los equipos)

- Disponibilidad y tasa de incidentes de los servicios de la plataforma

- Coste por carga de trabajo (economía unitaria, no gasto total)

Trampas comunes incluyen incentivos desalineados (la plataforma juzgada por número de features, no por adopción), sobrediseño (construir para escala hipotética) y medir éxito por mandatos en lugar de uso voluntario.

El volante de crecimiento compuesto detrás de la plataforma

Planifica antes de construir

Usa el modo de planificación para trazar el trabajo antes de generar código.

Las plataformas crecen de forma distinta a productos puntuales. Su ventaja no es solo “más features”: es un bucle donde cada cliente nuevo hace la plataforma más fácil de operar, mejorar y más difícil de ignorar.

El volante en términos sencillos

Más clientes → más datos de uso reales → patrones más claros sobre qué falla, qué va lento, qué confunde → mejores valores por defecto y automatización → mejor servicio para todos → más clientes.

AWS se benefició de esto porque los servicios gestionados convierten el trabajo operativo en una capacidad compartida y repetible. Cuando los mismos problemas aparecen en miles de equipos (monitorización, parcheo, escalado, backups), el proveedor puede arreglarlos una vez y distribuir la mejora a todos los clientes.

Por qué la estandarización acelera la innovación

La estandarización a menudo se presenta como “menos flexibilidad”, pero para las plataformas es un multiplicador de velocidad. Cuando la infraestructura y las operaciones son consistentes—un conjunto de APIs, un enfoque de identidad, una forma de observar sistemas—los creadores dejan de reinventar lo básico.

Ese tiempo recuperado se convierte en innovación de nivel superior: mejores experiencias de producto, experimentos más rápidos y nuevas capacidades sobre la plataforma (no al lado). La estandarización también reduce la carga cognitiva para los equipos: menos decisiones, menos modos de fallo, incorporación más rápida.

La apuesta a largo plazo: componer a escala

Pequeñas mejoras se componen cuando se aplican a millones de peticiones y miles de clientes. Una reducción del 2% en la tasa de incidentes, un algoritmo de autoescalado ligeramente mejor o una configuración por defecto más clara no solo ayuda a una compañía: mejora la línea base de la plataforma.

Cómo la eliminación del trabajo pesado se traduce en envío más rápido

Eliminar trabajo pesado no diferenciador no solo ahorra horas: cambia el comportamiento de los equipos. Cuando el trabajo de “mantener las luces encendidas” se reduce, los roadmaps dejan de dominarse por tareas de mantenimiento (parchar servidores, rotar claves, vigilar colas) y empiezan a reflejar apuestas de producto: nuevas funcionalidades, mejor UX, más experimentos.

Efectos de segundo orden que se componen

Menos toil crea una reacción en cadena:

- La incorporación es más sencilla. Nuevos ingenieros pueden entregar en días en lugar de aprender un laberinto de runbooks internos.

- Los incidentes bajan—y son más simples. Menos sistemas a medida significa menos modos de fallo extraños y menos escaladas a las 3 a.m.

- Las releases se vuelven rutinarias. Los equipos pueden lanzar con más frecuencia porque despliegue, rollback y monitorización están estandarizados.

Velocidad vs. fricción: enviar vs. apagar incendios

La velocidad real es una cadencia constante de pequeñas releases predecibles. La fricción es movimiento sin progreso: correcciones urgentes, trabajo infra de emergencia y cambios “rápidos” que generan más deuda.

Eliminar trabajo pesado reduce la fricción porque elimina categorías enteras de trabajo que interrumpen repetidamente la entrega planificada. Un equipo que antes pasaba el 40% del tiempo reaccionando puede redirigir esa capacidad a features—y mantenerla allí.

Ejemplos prácticos en SaaS

Autenticación: En lugar de mantener almacenamiento de contraseñas, flujos MFA, manejo de sesiones y auditorías de cumplimiento, usa un proveedor de identidad gestionado. Resultado: menos incidentes de seguridad, despliegues SSO más rápidos y menos tiempo actualizando librerías de autenticación.

Pagos: Externaliza procesamiento de pagos, manejo de impuestos/VAT y chequeos de fraude a un proveedor especializado. Resultado: expansión regional más rápida, menos sorpresas por chargebacks y menos tiempo de ingeniería en casos límite.

Observabilidad: Estandariza en una pila gestionada de logging/métricas/tracing en lugar de dashboards caseros. Resultado: depuración más rápida, propiedad clara durante incidentes y confianza para desplegar con más frecuencia.

El patrón es simple: cuando las operaciones se convierten en un producto que consumes, el tiempo de ingeniería vuelve a construir lo que los clientes realmente pagan.

Tradeoffs: lock-in, control y coste

Eliminar trabajo pesado no es comida gratis. Los servicios gestionados al estilo AWS suelen intercambiar esfuerzo diario por acoplamiento más estrecho, menos perillas y facturas que pueden sorprenderte.

Los tres grandes tradeoffs

Lock-in del proveedor. Cuanto más dependes de APIs propietarias (colas, políticas IAM, motores de workflow), más difícil es moverte después. El lock-in no siempre es malo—puede ser el precio de la velocidad—pero debe elegirse deliberadamente.

Pérdida de control. Los servicios gestionados reducen tu capacidad de ajustar rendimiento, elegir versiones exactas o debuggear problemas profundos de infraestructura. Cuando ocurre una interrupción, puede que esperes el ritmo del proveedor.

Sorpresas de coste. La tarificación por consumo premia el uso eficiente, pero puede penalizar el crecimiento, arquitecturas charlatanas o valores por defecto “set-and-forget”. Los equipos a menudo descubren costes después del despliegue.

Cuándo es racional construir

Construir (o autoalojar) puede ser la decisión correcta cuando tienes requisitos únicos (latencia personalizada, modelos de datos especiales), escala masiva donde la economía unitaria cambia, o restricciones de cumplimiento/ubicación de datos que los servicios gestionados no pueden satisfacer.

Guardrails que te mantienen rápido sin quedar atrapado

Diseña límites de servicio: envuelve llamadas a proveedores detrás de tu propia interfaz para poder cambiar implementaciones.

Mantén un plan de portabilidad: documenta lo que sería más difícil de migrar y conserva un “mínimo viable de salida” (incluso si es lento).

Añade monitorización de costes temprano: presupuestos, alertas, etiquetado y revisiones regulares de los mayores consumidores.

Matriz de decisión copiables

| Pregunta | Preferir Gestionado | Preferir Construir/Autoalojar |

|---|---|---|

| ¿Es esto un diferenciador para los clientes? | No | Sí |

| ¿Podemos tolerar límites/opinionación del proveedor? | Sí | No |

| ¿Necesitamos cumplimiento/control especial? | No | Sí |

| ¿La velocidad al mercado es la prioridad principal? | Sí | No |

| ¿Es el coste predecible según nuestro patrón de uso? | Sí | No |

Un marco práctico para aplicar el patrón en cualquier negocio de software

Haz los experimentos más seguros

Usa snapshots y rollback para probar cambios sin miedo a romper tu línea base.

No necesitas operar una nube a hiperescala para usar el playbook de “eliminar trabajo pesado no diferenciador”. Cualquier equipo de software—SaaS, plataformas internas, productos de datos, incluso herramientas con mucho soporte—tiene trabajo recurrente que es caro, propenso a errores y no es un verdadero diferenciador.

Un método paso a paso (de toil a producto)

-

Lista el trabajo recurrente: Anota las tareas repetidas que la gente hace para mantener las cosas en marcha—despliegues manuales, triage de tickets, backfills de datos, solicitudes de acceso, handoffs de incidentes, scripts frágiles, checklists de “conocimiento tribal”.

-

Cuantifícalo: Para cada ítem, estima frecuencia, tiempo gastado y coste de fallo. Una puntuación simple funciona: horas/semana + severidad de errores + número de equipos afectados. Esto convierte el dolor vago en un backlog priorizado.

-

Estandariza el flujo: Antes de automatizar, define “la mejor manera”. Crea una plantilla, golden path o un conjunto mínimo de opciones soportadas. Reducir la variación suele ser la mayor ganancia.

-

Automatiza y empaqueta: Construye herramientas self‑serve (APIs, UI, runbooks‑as‑code) y trátalo como un producto: propiedad clara, versionado, documentación y modelo de soporte.

Una variante moderna de este enfoque son las plataformas “vibe-coding” que convierten el andamiaje repetitivo y la configuración de día 1 en un flujo guiado. Por ejemplo, Koder.ai permite a equipos crear apps web, backend y móviles desde una interfaz de chat (React en web, Go + PostgreSQL en backend, Flutter para móvil) y luego exportar código fuente o desplegar/hostear—útil cuando tu cuello de botella es pasar de idea a una base fiable sin rehacer el mismo wiring del proyecto cada vez.

Empieza con un flujo (y demuestra el bucle)

Elige un único flujo de alta frecuencia donde el éxito sea medible—despliegues, pipelines de datos o herramientas de soporte son buenos candidatos. Apunta a una victoria rápida: menos pasos, menos páginas, menos aprobaciones, recuperación más rápida.

Secuenciación: qué hacer primero

- Fiabilidad primero: Haz el proceso consistente y seguro.

- Funciones segundo: Añade capacidades que realmente pidan los usuarios.

- Optimización tercero: Ajusta coste y rendimiento después de que el uso se estabilice.

Conclusiones clave y próximos pasos

La lección reutilizable de la estrategia de Andy Jassy en AWS es simple: ganas haciendo que el trabajo común desaparezca. Cuando los clientes (o equipos internos) dejan de gastar tiempo en puesta en marcha, parcheo, escalado y vigilancia de incidentes, pueden dedicar ese tiempo a lo que realmente les diferencia—features, experiencias y nuevas apuestas.

La idea a mantener en primer plano

“Trabajo pesado no diferenciador” no es solo “trabajo duro.” Es trabajo que muchos equipos repiten, que debe hacerse para operar de forma fiable, pero que rara vez gana crédito único en el mercado. Convertir ese trabajo en un producto—especialmente un servicio gestionado—crea valor doble: bajas el coste de ejecutar software y aumentas la velocidad de entrega.

Elige una cosa para eliminar este trimestre

No empieces con una reescritura masiva de plataforma. Empieza con un dolor recurrente que aparece en tickets, páginas de on-call o desbordes de sprint. Buenos candidatos:

- Configuración de entornos que varía por equipo

- Releases y rollbacks manuales

- Revisiones de seguridad repetitivas por los mismos patrones

- Valores por defecto de escalado/monitorización que todos redescubren a la fuerza

Elige uno, define “hecho” en lenguaje claro (p. ej., “un nuevo servicio puede desplegarse con seguridad en 15 minutos”) y entrega la versión más pequeña que elimine el trabajo repetido.

Lecturas internas relacionadas

Si quieres más patrones prácticos sobre pensamiento de plataforma y decisiones construir‑vs‑comprar, revisa /blog. Si estás evaluando qué estandarizar frente a qué ofrecer como capacidad interna (o externa) de pago, /pricing puede ayudar a enmarcar empaquetado y niveles.

Próximo paso: un backlog simple de plataforma

Esta semana, haz tres cosas: audita dónde se pierde tiempo por trabajo operativo repetido, prioriza por frecuencia × dolor × riesgo, y construye un backlog de plataforma simple con 3–5 ítems que puedas entregar incrementalmente.