Qué significa “más fácil de reemplazar” en proyectos reales

"Más fácil de reemplazar" rara vez significa borrar toda una aplicación y empezar de cero. En equipos reales, el reemplazo ocurre a distintas escalas, y lo que significa "reescribir" depende de qué estés cambiando.

Reemplazar vs reescribir: qué está realmente sobre la mesa

Un reemplazo podría ser:

- Un módulo (reglas de facturación, generación de PDFs, plantillas de email)

- Un servicio (API de recomendaciones, worker en background)

- Una superficie front-end (una página, una área de funcionalidad o toda la UI)

- La reescritura completa de una app (raro, caro, a veces necesario)

Cuando la gente dice que una base de código es “más fácil de reescribir”, normalmente quiere decir que puedes reiniciar una porción sin deshacerlo todo, mantener el negocio en marcha y migrar de forma gradual.

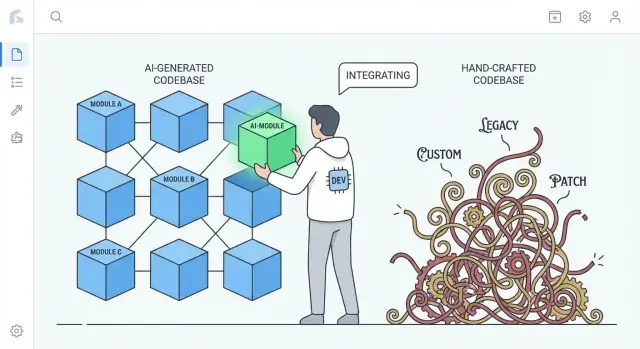

La comparación real: código generado por IA vs código fuertemente personalizado

Este argumento no es «el código de IA es mejor». Se trata de tendencias comunes.

- Código artesanal altamente personalizado puede acumular patrones únicos, abstracciones ingeniosas y mini-marcos propios dentro de la app. Eso puede ser ingeniería excelente, pero también crea un ecosistema privado que entienden solo unos pocos.

- Código generado por IA tiende a apoyarse en valores por defecto familiares: librerías mainstream, capas convencionales y patrones parecidos a los de muchos proyectos de referencia.

Esa diferencia importa en una reescritura: el código que sigue convenciones ampliamente entendidas suele poder reemplazarse por otra implementación convencional con menos negociación y menos sorpresas.

Poner expectativas: el código generado por IA puede ser desordenado

El código generado por IA puede ser inconsistente, repetitivo o con pocas pruebas. “Más fácil de reemplazar” no pretende decir que sea más limpio: significa que suele ser menos “especial”. Si un subsistema está construido con ingredientes comunes, cambiarlo puede ser más parecido a reemplazar una pieza estándar que a desensamblar una máquina personalizada.

Vista previa: por qué la estandarización reduce el coste de cambio

La idea central es simple: la estandarización reduce los costes de cambio. Cuando el código está compuesto por patrones reconocibles y costuras claras, puedes regenerar, refactorizar o reescribir piezas con menos miedo de romper dependencias ocultas. Las secciones siguientes muestran cómo se manifiesta esto en estructura, propiedad, pruebas y velocidad de ingeniería diaria.

Los patrones estándar reducen el coste de empezar de nuevo

Una ventaja práctica del código generado por IA es que suele usar por defecto patrones comunes y reconocibles: disposiciones de carpetas familiares, nombres previsibles, convenciones de frameworks mainstream y enfoques “de libro” para routing, validación, manejo de errores y acceso a datos. Incluso cuando el código no es perfecto, suele ser legible de la misma manera que muchos tutoriales y proyectos iniciales.

La familiaridad vence a la originalidad cuando necesitas reescribir

Las reescrituras son caras en gran parte porque las personas primero deben entender lo que existe. El código que sigue convenciones conocidas reduce ese tiempo de “decodificación”. Los ingenieros nuevos pueden mapear lo que ven a modelos mentales que ya tienen: dónde vive la configuración, cómo fluyen las peticiones, cómo se conectan las dependencias y dónde deben ir las pruebas.

Esto acelera tareas como:

- identificar costuras para reemplazo (módulos, servicios, endpoints)

- replicar comportamiento en una nueva implementación

- comparar antiguo y nuevo lado a lado sin traducir entre estilos

Por el contrario, bases de código muy artesanales reflejan a menudo un estilo profundamente personal: abstracciones únicas, mini-marcos propios, “pegamentos” ingeniosos o patrones específicos del dominio que solo tienen sentido con contexto histórico. Esas elecciones pueden ser elegantes, pero aumentan el coste de empezar de cero porque la reescritura debe primero reaprender la visión del autor.

Puedes imponer convenciones de cualquier modo

Esto no es magia exclusiva de la IA. Los equipos pueden (y deben) imponer estructura y estilo usando plantillas, linters, formatters y herramientas de scaffolding. La diferencia es que la IA tiende a producir “genérico por defecto”, mientras que los sistemas escritos por humanos a veces derivan hacia soluciones a medida si no se mantienen activamente las convenciones.

Menos “pegamento” a medida puede significar menos dependencias ocultas

Mucho del dolor de reescritura no lo causa la lógica principal del negocio. Lo causa el pegamento artesanal: helpers personalizados, micro-marcos caseros, metaprogramación y convenciones únicas que conectan todo en silencio.

Qué cuenta como “pegamento a medida”

El pegamento a medida es lo que no forma parte de tu producto, pero sin lo que tu producto no funciona. Ejemplos: un contenedor de inyección de dependencias casero, una capa de routing DIY, una clase base mágica que auto-registra modelos, o helpers que mutan estado global “por conveniencia”. Suele empezar como ahorro de tiempo y acabar siendo conocimiento imprescindible para cualquier cambio.

Por qué el pegamento único aumenta el acoplamiento (y el riesgo de reescritura)

El problema no es que exista pegamento, sino que se convierte en acoplamiento invisible. Cuando el pegamento es único para tu equipo, a menudo:

- Crea dependencias implícitas (las cosas funcionan solo porque los helpers se ejecutan en cierto orden)

- Extiende suposiciones por archivos (nombres pasan a ser comportamiento)

- Hace que refactors “simples” sean riesgosos (cambias el pegamento, rompes todo)

Durante una reescritura, este pegamento es difícil de replicar correctamente porque las reglas rara vez están escritas. Se descubren rompiendo producción.

Por qué el código generado por IA tiende a evitar la astucia extrema

Las salidas de IA suelen inclinarse hacia librerías estándar, patrones comunes y wiring explícito. Es menos probable que inventen un micro-marco cuando un módulo o un objeto de servicio directo servirá. Esa contención puede ser una ventaja: menos hooks mágicos significa menos dependencias ocultas, y eso facilita arrancar un subsistema y reemplazarlo.

El intercambio: verbosidad frente a astucia

El inconveniente es que el código “llano” puede ser más verboso: más parámetros, más tubería sencilla, menos atajos. Pero la verbosidad suele ser más barata que el misterio. Cuando decides reescribir, quieres código fácil de entender, fácil de borrar y difícil de malinterpretar.

Estructura predecible apoya reescrituras incrementales

"Estructura predecible" tiene menos que ver con la estética y más con la consistencia: las mismas carpetas, reglas de nombres y flujos de petición aparecen por todas partes. Los proyectos generados por IA suelen tender a defaults familiares — controllers/, services/, repositories/, models/ — con endpoints CRUD repetitivos y patrones de validación similares.

Esa uniformidad importa porque convierte una reescritura de precipicio a escalera.

Cómo se ve la predictibilidad

Ves patrones repetidos entre funcionalidades:

- Límites claros de carpetas (API → servicio → acceso a datos)

- Nomenclatura consistente (

UserService, UserRepository, UserController)

- Flujo CRUD similar (list → get → create → update → delete)

- Forma estándar para errores, logging y objetos request/response

Cuando cada funcionalidad está construida de la misma manera, puedes reemplazar una pieza sin tener que "reaprender" el sistema cada vez.

Intercambiar pieza por pieza

Las reescrituras incrementales funcionan mejor cuando puedes aislar una frontera y reconstruir detrás de ella. Las estructuras predecibles crean esas costuras naturalmente: cada capa tiene un trabajo estrecho, y la mayoría de llamadas pasan por un conjunto pequeño de interfaces.

Un enfoque práctico es el estilo “estrangulador”: mantiene la API pública estable y reemplaza internals gradualmente.

Ejemplo: reemplazar la capa de acceso a datos sin tocar la API

Supongamos que tu app tiene controllers que llaman a un servicio, y el servicio llama a un repositorio:

OrdersController → OrdersService → OrdersRepository

Quieres pasar de queries SQL directas a un ORM, o de una BD a otra. En una codebase predecible, el cambio puede contenerse:

- Crear

OrdersRepositoryV2 (nueva implementación)

- Mantener las firmas de método iguales (

getOrder(id), listOrders(filters))

- Cambiar el wiring en un solo lugar (inyección de dependencias o factory)

- Ejecutar tests y desplegar por característica

El controller y el service permanecen mayormente sin tocar.

Contraste: arquitecturas hechas a mano

Los sistemas altamente hechos a mano pueden ser excelentes —pero a menudo codifican ideas únicas: abstracciones custom, metaprogramación ingeniosa o comportamiento transversal escondido en clases base. Eso puede hacer que cada cambio requiera contexto histórico profundo. Con estructura predecible, la pregunta "¿dónde cambio esto?" suele ser directa, lo que hace factible reescrituras pequeñas semana a semana.

Menor “apego del autor” hace que borrar sea más aceptable

Un bloqueo silencioso en muchas reescrituras no es técnico: es social. Los equipos a menudo cargan con riesgo de propiedad, donde solo una persona entiende realmente cómo funciona el sistema. Cuando esa persona escribió grandes porciones a mano, el código puede sentirse como un artefacto personal: “mi diseño”, “mi solución ingeniosa”, “mi parche que salvó la release”. Ese apego hace que borrar sea emocionalmente costoso, incluso cuando es racional económicamente.

El código generado por IA puede reducir ese efecto. Como el borrador inicial puede venir de una herramienta (y suele seguir patrones familiares), el código se siente menos como una firma y más como una implementación intercambiable. La gente suele estar más cómoda diciendo “vamos a reemplazar este módulo” cuando no parece que se borre la artesanía de alguien —ni se cuestione su estatus en el equipo.

Por qué esto cambia el comportamiento frente a reescrituras

Cuando el apego del autor es menor, los equipos tienden a:

- Cuestionar el código existente con más libertad ("¿sigue siendo la mejor solución?")

- Borrar grandes secciones sin negociar orgullo o política

- Elegir regenerar o reemplazar antes que meses de parches cautelosos

- Difundir conocimiento más rápido, porque nadie trata el interior como territorio “privado”

Nota práctica

Las decisiones de reescritura deben seguir guiadas por coste y resultado: plazos de entrega, riesgo, mantenibilidad e impacto al usuario. "Es fácil borrar" es una propiedad útil, no una estrategia por sí sola.

Prompts y trazas de generación pueden funcionar como documentación

Lanza un piloto de módulo reemplazable

Crea una funcionalidad reemplazable en Koder.ai y comprueba qué tan rápido puedes sustituirla de forma segura.

Un beneficio infraestimado del código generado por IA es que los inputs a la generación pueden actuar como especificación viva. Un prompt, una plantilla y una configuración de generador pueden describir la intención en lenguaje natural: qué debe hacer la funcionalidad, qué restricciones importan (seguridad, rendimiento, estilo) y qué significa "hecho".

Prompts como especificaciones vivas

Cuando los equipos usan prompts repetibles (o bibliotecas de prompts) y plantillas estables, crean una pista de auditoría de decisiones que de otro modo serían implícitas. Un buen prompt puede indicar cosas que un mantenedor futuro normalmente tendría que adivinar:

- el flujo de usuario esperado y los casos límite

- convenciones de nombres y estructura de carpetas

- cómo deben manejarse y registrarse los errores

- qué debe probarse (y qué puede simularse)

Eso es diferente de muchas codebases hechas a mano, donde las elecciones de diseño claves están esparcidas por mensajes de commit, conocimiento tribal y convenciones no escritas.

Las trazas de generación ayudan a reproducir comportamiento

Si mantienes trazas de generación (prompt + modelo/version + inputs + pasos de post-procesado), una reescritura no parte de cero. Puedes reutilizar la misma checklist para recrear el mismo comportamiento bajo una estructura más limpia y luego comparar resultados.

En la práctica, esto puede convertir una reescritura en: “regenerar la funcionalidad X bajo nuevas convenciones y verificar paridad”, en vez de “ingeniería inversa para entender qué debía hacer la funcionalidad X”.

Advertencia importante: trata los prompts como código

Esto solo funciona si los prompts y configs se manejan con la misma disciplina que el código fuente:

- versionarlos en el repo (no en notas locales)

- requerir revisión para cambios

- registrar qué prompt/config generó qué módulos

Sin esto, los prompts se convierten en otra dependencia sin documentar. Con ello, pueden ser la documentación que a menudo desearían tener los sistemas hechos a mano.

Pruebas sólidas convierten reescrituras en ingeniería rutinaria

"Más fácil de reemplazar" no trata de si el código lo escribió una persona o una herramienta. Trata de si puedes cambiarlo con confianza. Una reescritura deja de ser un proyecto heroico cuando las pruebas te dicen, rápida y fiablemente, que el comportamiento se mantiene.

El código generado por IA puede ayudar aquí —cuando se le pide. Muchos equipos solicitan boilerplate de tests junto con las funcionalidades (unitarias básicas, tests de integración de ruta feliz, mocks simples). Esos tests pueden no ser perfectos, pero crean una red de seguridad inicial que suele faltar en sistemas hechos a mano donde las pruebas se pospusieron “para después”.

Prioriza tests de contrato en las costuras

Si quieres reemplazabilidad, enfoca el esfuerzo de testing en los puntos donde las partes se encuentran:

- APIs externas: requests, responses, códigos de error, reintentos, paginación

- Adapters: proveedores de pago, servicios de email, almacenamiento, colas

- Modelos de datos: migraciones, serialización, reglas de validación

Los tests de contrato aseguran lo que debe permanecer cierto aunque cambies los internals. Así puedes reescribir un módulo detrás de una API o reemplazar un adaptador sin re-discutir el comportamiento del negocio.

Usa cobertura como brújula, no como trofeo

Los números de cobertura pueden guiar dónde están los riesgos, pero perseguir 100% suele crear tests frágiles que bloquean refactors. En su lugar:

- Añade tests donde las fallas serían caras (dinero, pérdida de datos, confianza del usuario)

- Prefiere menos tests de mayor señal en vez de muchos superficiales

- Al reescribir, compara implementación vieja y nueva mediante los mismos tests de contrato

Con buenas pruebas, las reescrituras dejan de ser heroicas y pasan a ser pasos seguros y reversibles.

Los fallos comunes del código IA suelen ser fáciles de detectar y aislar

Escribe la especificación primero

Convierte tu prompt en un plan claro para que la regeneración parta de la intención y no de conjeturas.

El código generado por IA tiende a fallar de maneras previsibles. Con frecuencia verás lógica duplicada (el mismo helper reimplementado tres veces), ramas “casi iguales” que manejan casos límite de forma distinta, o funciones que crecen por acumulación a medida que el modelo añade parches. Nada de eso es ideal —pero tiene una ventaja: los problemas suelen ser visibles.

Los fallos obvios superan a los bugs sutiles y astutos

Los sistemas hechos a mano pueden ocultar complejidad detrás de abstracciones ingeniosas, micro-optimizaciones o comportamientos fuertemente acoplados que parecen correctos y pasan revisiones superficiales. Esos bugs duelen porque se ven bien.

El código de IA es más probable que sea claramente inconsistente: un parámetro ignorado en una rama, una validación en un archivo y no en otro, o estilos de manejo de error cambiando cada pocas funciones. Estas descoordinaciones destacan en revisiones y análisis estático y son más fáciles de aislar porque raramente dependen de invariantes intencionales profundas.

Candidatos a reescritura aparecen por repetición

La repetición es la señal. Cuando ves la misma secuencia de pasos reaparecer —parse input → normalize → validate → map → return— en endpoints o servicios, has encontrado una costura natural para reemplazar. La IA suele “resolver” una nueva petición reimprimiendo una solución previa con ajustes, lo que crea grupos de casi-duplicados.

Un enfoque práctico es marcar cualquier chunk repetido como candidato para extracción o reemplazo, especialmente cuando:

- Aparece en 3+ sitios con diferencias menores

- Las diferencias son principalmente manejo de casos límite o mensajes de error

- El código no tiene un único dueño claro y sigue parcheándose

Regla práctica: consolida repeticiones en un módulo probado

Si puedes nombrar el comportamiento repetido en una oración, probablemente debería ser un único módulo.

Reemplaza los fragmentos repetidos con un componente bien probado (utility, servicio compartido o función de librería), escribe tests que fijen los casos límite esperados y luego borra los duplicados. Has convertido muchas copias frágiles en un único lugar para mejorar —y un único lugar para reescribir más adelante si hace falta.

Legibilidad y consistencia pueden valer más que optimizaciones artesanales

El código generado por IA suele destacar cuando le pides optimizar para claridad en lugar de astucia. Con prompts y reglas de lint adecuadas, normalmente elige flujos de control familiares, nombres convencionales y módulos “aburridos” en vez de novedad. Eso puede ser una ganancia a largo plazo mayor que unos puntos porcentuales de rendimiento sacados por trucos manuales.

Por qué el código legible es más fácil de reescribir

Las reescrituras funcionan cuando nuevas personas pueden construir rápidamente un modelo mental correcto del sistema. Código legible y consistente reduce el tiempo para responder preguntas básicas como “¿Dónde entra esta petición?” y “¿Qué forma tiene este dato aquí?” Si cada servicio sigue patrones similares (layout, manejo de errores, logging, configuración), un equipo nuevo puede reemplazar una porción a la vez sin reaprender convenciones locales.

La consistencia también reduce el miedo. Cuando el código es predecible, los ingenieros pueden borrar y reconstruir partes con confianza porque la superficie es más sencillo de entender y el “radio de impacto” se siente menor.

El intercambio con hacks de rendimiento artesanales

El código altamente optimizado y hecho a mano puede ser difícil de reescribir porque las técnicas de rendimiento suelen filtrarse por todo: capas de caché custom, micro-optimizaciones, patrones de concurrencia caseros o acoplamientos a estructuras de datos específicas. Estas elecciones pueden ser válidas, pero a menudo crean restricciones sutiles que no son obvias hasta que algo falla.

Salvedad: el rendimiento sigue importando—mídelo

La legibilidad no es excusa para ser lento. La idea es ganarte el rendimiento con evidencia. Antes de una reescritura, captura métricas base (percentiles de latencia, CPU, memoria, coste). Después de reemplazar un componente, mide otra vez. Si el rendimiento empeora, optimiza el hot path específico—sin convertir toda la base de código en un rompecabezas.

Regenerar vs refactorizar vs reescribir: elegir el reseteo correcto

Cuando un código asistido por IA empieza a sentirse “mal”, no siempre necesitas una reescritura total. El mejor reseteo depende de cuánto del sistema esté equivocado frente a meramente desordenado.

Tres opciones de reseteo

Regenerar significa recrear una parte del código desde una especificación o prompt—a menudo empezando desde una plantilla o patrón conocido—y volver a aplicar puntos de integración (rutas, contratos, tests). No es “borrar todo”, es “reconstruir esta porción desde una descripción más clara”.

Refactorizar mantiene el mismo comportamiento pero cambia la estructura interna: renombrar, dividir módulos, simplificar condicionales, eliminar duplicación, mejorar tests.

Reescribir reemplaza un componente o sistema con una nueva implementación, generalmente porque el diseño actual no puede sanearse sin cambiar comportamiento, límites o flujos de datos.

Cuándo la regeneración es una gran opción

Regenerar brilla cuando el código es mayormente boilerplate y el valor está en interfaces más que en interiores ingeniosos:

- Pantallas CRUD y paneles de administración

- Adaptadores de API y capas de integración delgadas

- Scaffolding: routing, serializers, DTOs, validación simple, manejo de errores común

Si la especificación es clara y el límite del módulo está limpio, regenerar suele ser más rápido que desenredar cambios incrementales.

Cuándo regenerar es arriesgado (o falla)

Ten cuidado cuando el código encierre conocimiento de dominio ganado a pulso o restricciones de corrección sutiles:

- Reglas de negocio con muchísimos casos límite

- Concurrencia complicada (colas, locks, reintentos, idempotencia)

- Lógica de cumplimiento (auditoría, retención, privacidad)

En estas áreas, “casi correcto” puede ser costoso—la regeneración puede ayudar, pero solo si puedes probar equivalencia con tests fuertes y revisiones rigurosas.

Puertas de revisión y despliegues pequeños

Trata el código regenerado como una dependencia nueva: exige revisión humana, ejecuta la suite completa de tests y añade tests dirigidos a fallos que hayas visto antes. Despliega en porciones pequeñas—un endpoint, una pantalla, un adaptador—detrás de un flag o con rollout gradual si es posible.

Un defecto útil: regenerar la carcasa, refactorizar las costuras, reescribir solo donde las suposiciones siguen fallando.

Riesgos y guardarraíles para el código “reemplazable por diseño”

Mantén tu arquitectura simple

Genera una estructura convencional que puedas reescribir por secciones sin tener que reaprender integraciones personalizadas.

“Fácil de reemplazar” solo sigue siendo una ventaja si los equipos tratan el reemplazo como una actividad ingenieril, no como un botón de reset casual. Los módulos generados por IA pueden cambiarse más rápido—pero también pueden fallar más rápido si confiamos en ellos más de lo que los verificamos.

Riesgos clave a vigilar

El código generado por IA suele parecer completo aun cuando no lo está. Eso puede crear falsa confianza, especialmente cuando demos de ruta feliz pasan.

Otro riesgo es casos límite ausentes: entradas inusuales, timeouts, sutilezas de concurrencia y manejo de errores que no estaban en el prompt o en los datos de ejemplo.

Finalmente, existe incertidumbre de licencias/IP. Aunque el riesgo sea bajo en muchos contextos, los equipos deberían tener una política sobre fuentes y herramientas aceptables y cómo se rastrea la procedencia.

Guardarraíles que mantienen seguras las reescrituras

Pon el reemplazo detrás de las mismas puertas que cualquier otro cambio:

- Revisión de código con una lente explícita de “código generado”: claridad, modos de fallo, validación de inputs y logging.

- Cheques de seguridad (SAST, escaneo de dependencias, detección de secretos) y una regla de que el código generado no los puede eludir.

- Políticas de dependencia: preferir librerías conocidas; fijar versiones; evitar traer un nuevo framework solo porque un prompt lo sugirió.

- Trazas de auditoría: guarda prompts, versión de modelo/herramienta y notas de generación en el repo para que los cambios sean explicables más tarde.

Documenta los límites antes de intercambiar módulos

Antes de reemplazar un componente, escribe su límite e invariantes: qué entradas acepta, qué garantiza, qué nunca debe hacer (p. ej., “nunca eliminar datos de clientes”), y expectativas de rendimiento/latencia. Este “contrato” es lo que pruebas—independientemente de quién (o qué) escriba el código.

Una lista de verificación ligera

- Define contrato del módulo (inputs/outputs, invariantes).

- Añade/confirma tests para casos límite.

- Ejecuta escaneos de seguridad y dependencias.

- Revisa por legibilidad y manejo de fallos.

- Registra metadatos de prompt/herramienta.

- Despliega detrás de un flag y monitoriza.

Conclusiones prácticas y un plan simple para el siguiente paso

El código generado por IA suele ser más fácil de reescribir porque tiende a seguir patrones familiares, evita la personalización profunda y es más rápido de regenerar cuando cambian los requisitos. Esa predictabilidad reduce el coste social y técnico de borrar y sustituir partes del sistema.

El objetivo no es “tirar código”, sino hacer que reemplazar código sea una opción normal y de baja fricción—respaldada por contratos y tests.

Pasos de acción que puedes implementar esta semana

Empieza por estandarizar convenciones para que cualquier código regenerado o reescrito encaje en el mismo molde:

- Fija convenciones: formato, estructura de carpetas, nomenclatura, manejo de errores y forma de API. Escríbelas en un CONTRIBUTING.md corto.

- Añade tests de contrato en las costuras: enfócate en inputs/outputs de módulos y servicios (endpoints HTTP, mensajes de cola, capas de acceso a BD). Estos tests deben pasar aunque cambies la implementación.

- Rastrea prompts y especificaciones: guarda prompts, notas de requisitos y trazas de generación junto al código para que futuras reescrituras reproduzcan la intención, no solo el texto.

Si usas un flujo tipo "vibe-coding", busca herramientas que faciliten estas prácticas: guardar specs de "planning mode" junto al repo, capturar trazas de generación y soportar rollback seguro. Por ejemplo, Koder.ai está pensado alrededor de generación guiada por chat con snapshots y rollback, que encaja bien con un enfoque “reemplazable por diseño”: regenera una porción, mantiene el contrato estable y revierte rápido si fallan los tests de paridad.

Ejecuta un piloto pequeño de “módulo reemplazable”\n

Elige un módulo importante pero aislado—generación de informes, envío de notificaciones o un área CRUD—define su interfaz pública, añade tests de contrato, y permite regenerar/refactorizar/reescribir internals hasta que sea aburrido. Mide tiempo de ciclo, tasa de defectos y esfuerzo de revisión; usa esos resultados para establecer reglas del equipo.

Para operacionalizarlo, guarda una checklist en tu playbook interno (o compártela vía /blog) y convierte el trío "contratos + convenciones + trazas" en requisito para trabajo nuevo. Si evalúas soporte de herramientas, documenta qué necesitas de una solución antes de mirar /pricing.