OLTP vs OLAP: qué son (sin jerga)

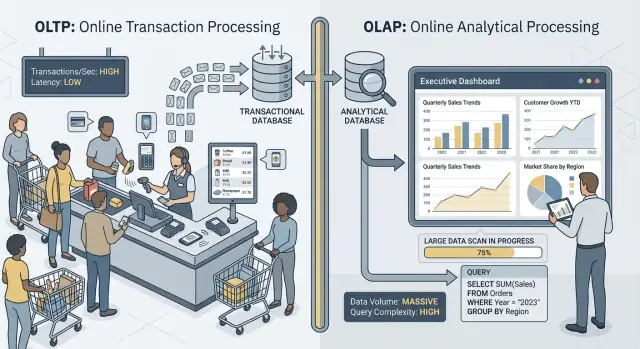

Cuando la gente dice “OLTP” y “OLAP”, hablan de dos formas muy distintas de usar una base de datos.

OLTP: la base de datos que hace funcionar el negocio

OLTP (Procesamiento de Transacciones en Línea) es la carga de trabajo detrás de las acciones diarias que deben ser rápidas y correctas cada vez. Piensa: “guardar este cambio ahora mismo”.

Las tareas típicas de OLTP incluyen crear un pedido, actualizar inventario, registrar un pago o cambiar la dirección de un cliente. Estas operaciones suelen ser pequeñas (unas pocas filas), frecuentes y deben responder en milisegundos porque una persona u otro sistema están esperando.

OLAP: la base de datos que explica el negocio

OLAP (Procesamiento Analítico en Línea) es la carga de trabajo que se usa para entender qué pasó y por qué. Piensa: “explorar muchos datos y resumirlos”.

Las tareas típicas de OLAP incluyen tableros, informes de tendencias, análisis por cohortes, predicciones y preguntas de “slice-and-dice” como: “¿Cómo cambió el ingreso por región y categoría de producto en los últimos 18 meses?” Estas consultas suelen leer muchas filas, realizar agregaciones pesadas y pueden ejecutarse durante segundos (o minutos) sin que eso se considere “incorrecto”.

Mismos datos, objetivos distintos — y necesidades distintas

La idea principal es simple: OLTP optimiza escrituras rápidas y consistentes y lecturas pequeñas, mientras que OLAP optimiza grandes lecturas y cálculos complejos. Debido a que los objetivos difieren, las mejores configuraciones de base de datos, índices, disposición del almacenamiento y enfoque de escalado suelen diferir también.

También fíjate en la palabra: rara vez, no nunca. Algunos equipos pequeños pueden compartir una base de datos por un tiempo, especialmente con volúmenes modestos y disciplina en las consultas. Las secciones siguientes cubren qué se rompe primero, patrones comunes de separación y cómo mover reporting fuera de producción de forma segura.

Ejemplos rápidos

- Checkout (OLTP): un cliente pulsa “Pagar” y tu app escribe un pedido, estado de pago y actualizaciones de inventario.

- Tablero de reporting (OLAP): un gerente abre un panel que agrega miles (o millones) de pedidos para mostrar tasa de conversión, valor medio del pedido y tendencias semanales.

Objetivos diferentes, métricas de éxito diferentes

OLTP y OLAP pueden “usar SQL”, pero se optimizan para cosas distintas — y eso se refleja en lo que cada uno considera éxito.

OLTP: velocidad, concurrencia y corrección

Los sistemas OLTP (transaccionales) impulsan operaciones diarias: flujos de checkout, actualizaciones de cuentas, reservas, herramientas de soporte. Las prioridades son sencillas:

- Respuestas rápidas para lecturas/escrituras pequeñas (piensa en milisegundos)

- Muchos usuarios concurrentes sin degradación

- Corrección y consistencia, porque un saldo incorrecto o un pedido duplicado es un problema real

El éxito a menudo se mide con métricas de latencia como p95/p99, tasa de errores y comportamiento bajo concurrencia pico.

OLAP: escaneo, agregación y flexibilidad

Los sistemas OLAP (analítica) responden preguntas como “¿Qué cambió este trimestre?” o “¿Qué segmento churned después del nuevo precio?” Estas consultas suelen:

- Escanear grandes cantidades de datos a través de muchas filas

- Realizar agregaciones (SUM, COUNT, percentiles) y joins

- Cambiar frecuentemente a medida que los analistas exploran y refinan preguntas

El éxito aquí se parece más a throughput de consultas, tiempo hasta insight y la capacidad de ejecutar consultas complejas sin afinar cada informe manualmente.

Por qué “un sistema para todo” crea concesiones

Cuando fuerzas ambas cargas en una base de datos, le pides que sea excelente a la vez en transacciones pequeñas y en grandes exploraciones. El resultado suele ser un compromiso: OLTP sufre latencias impredecibles, OLAP se limita para proteger producción y los equipos discuten sobre qué consultas están “permitidas”. Objetivos distintos merecen métricas de éxito distintas — y por lo general sistemas distintos.

Contención de recursos: cuando la analítica le quita recursos a las transacciones

Cuando OLTP (las transacciones diarias) y OLAP (reporting y análisis) corren en la misma base, compiten por recursos finitos. El resultado no es solo “reporting más lento”, sino checkouts más lentos, inicios de sesión atascados y fallos impredecibles en la app.

CPU y memoria: consultas largas vs consultas cortas

Las consultas analíticas tienden a ser largas y pesadas: joins entre tablas grandes, agregaciones, ordenamientos y agrupaciones. Pueden monopolizar núcleos de CPU y, tan importante, memoria para joins por hash y buffers de ordenamiento.

Mientras tanto, las consultas transaccionales son pequeñas y sensibles a la latencia. Si la CPU está saturada o la presión de memoria fuerza desalojos frecuentes, esas consultas pequeñas empiezan a esperar detrás de las grandes — incluso si cada transacción solo necesita unos pocos milisegundos.

E/S de disco: escaneos grandes vs muchas lecturas/escrituras pequeñas

La analítica suele provocar escaneos de tablas grandes y leer muchas páginas secuencialmente. OLTP hace lo contrario: muchas lecturas aleatorias pequeñas más escrituras constantes a índices y logs.

Al combinarlas, el subsistema de almacenamiento debe manejar patrones de acceso incompatibles. Las cachés que ayudaban a OLTP pueden quedar “lavadas” por los escaneos analíticos, y la latencia de escritura puede subir cuando el disco está ocupado transmitiendo datos para informes.

Presión en pools de conexión y colas

Unos pocos analistas ejecutando consultas amplias pueden acaparar conexiones durante minutos. Si tu aplicación usa un pool de tamaño fijo, las peticiones se ponen en cola esperando una conexión libre. Ese efecto de colas puede hacer que un sistema sano parezca roto: la latencia media puede lucir aceptable, pero las latencias en cola (p95/p99) se vuelven insoportables.

Lo que los usuarios notan

Desde fuera, esto aparece como timeouts, checkouts lentos, resultados de búsqueda tardíos y comportamiento inestable — a menudo “solo durante reporting” o “solo a fin de mes”. El equipo de app ve errores; el equipo de analítica ve consultas lentas; el problema real es la contención compartida debajo.

Disposición de datos e índices: necesidades opuestas

OLTP y OLAP no solo “usan la base de datos diferente”, sino que recompensan diseños físicos opuestos. Cuando intentas satisfacer ambos en un solo lugar, terminas con un compromiso caro y aún deficiente.

OLTP: optimizado para búsquedas selectivas rápidas

La carga transaccional está dominada por consultas cortas que tocan una porción diminuta de datos: buscar un pedido, actualizar una fila de inventario, listar los últimos 20 eventos de un usuario.

Eso empuja a los esquemas OLTP hacia almacenamiento orientado a filas e índices que soportan búsquedas puntuales y escaneos de rango pequeños (clave primaria, claves foráneas y algunos índices secundarios de alto valor). El objetivo es latencia predecible y baja —especialmente para escrituras.

OLAP: optimizado para escaneo, agrupación y resumen

La analítica a menudo necesita leer muchas filas y solo unas pocas columnas: “ingreso por semana por región”, “tasa de conversión por campaña”, “productos top por margen”.

Los sistemas OLAP se benefician de almacenamiento columnar (para leer solo las columnas necesarias), particionamiento (para podar datos antiguos/irrelevantes) y preagregación (vistas materializadas, rollups, tablas resumen) para que los informes no recalculen totales cada vez.

Por qué “indexar para todo” sale mal

Una reacción común es añadir índices hasta que cada dashboard sea rápido. Pero cada índice extra aumenta el coste de escritura: inserts, updates y deletes ahora tienen más estructuras que mantener. También aumenta el almacenamiento y puede ralentizar tareas de mantenimiento como vacuum, reindex y backups.

Planificadores de consultas y deriva de estadísticas (en palabras sencillas)

Las bases de datos eligen planes de consulta basándose en estadísticas —estimaciones de cuántas filas coincide un filtro, qué tan selectivo es un índice y cómo está distribuida la data. OLTP cambia los datos constantemente. A medida que las distribuciones cambian, las estadísticas pueden desviarse y el planificador puede escoger un plan que fue bueno ayer pero es lento hoy.

Si además mezclas consultas analíticas que escanean y hacen joins de tablas grandes, obtienes más variabilidad: el “mejor plan” es más difícil de predecir, y afinar para una carga a menudo empeora la otra.

Bloqueos, MVCC y efectos secundarios de mantenimiento

Aunque tu base de datos “soporte concurrencia”, mezclar reporting pesado con transacciones en vivo genera ralentizaciones sutiles difíciles de predecir —y aún más difíciles de explicar a un cliente viendo un checkout girando.

Las consultas largas aún crean problemas de locking

Las consultas al estilo OLAP suelen escanear muchas filas, unir múltiples tablas y ejecutarse durante segundos o minutos. Mientras tanto pueden mantener locks (por ejemplo en objetos de esquema, o cuando necesitan ordenar/agrupar en estructuras temporales) y frecuentemente aumentan la contención de locks de forma indirecta al mantener muchas filas “en juego”.

Incluso con MVCC (control de concurrencia por múltiples versiones), la base debe rastrear múltiples versiones de la misma fila para que lectores y escritores no se bloqueen entre sí. Eso ayuda, pero no elimina la contención —especialmente cuando las consultas tocan tablas calientes que las transacciones actualizan constantemente.

MVCC tiene un coste oculto: la limpieza se complica

MVCC significa que las versiones antiguas de filas permanecen hasta que la base puede borrarlas de forma segura. Un informe de larga duración puede mantener abierto un snapshot antiguo, lo que impide que la limpieza recupere espacio.

Eso afecta a:

- Vacuum/garbage collection: la limpieza no puede eliminar tuplas/versiones muertas tan rápido.

- Bloat/fragmentación: el almacenamiento crece, los índices se vuelven menos eficientes y las cachés pierden utilidad.

- Presión de compactación: algunos motores responden haciendo más trabajo en background, lo que roba I/O y CPU a las transacciones.

El resultado es un doble golpe: el reporting hace que la base trabaje más y que el sistema se vuelva más lento con el tiempo.

Los niveles de aislamiento amplifican la variabilidad de latencia

Las herramientas de reporting a menudo piden aislamiento más fuerte (o ejecutan accidentalmente en una transacción larga). Un aislamiento alto puede aumentar esperas por locks y la cantidad de versionado que el motor debe gestionar. Desde el lado OLTP, esto se ve como picos impredecibles: la mayoría de pedidos escribe rápido, pero unos pocos se quedan atascados.

Ejemplo práctico: el reporte de fin de mes ralentiza pedidos

Al cierre de mes, finanzas ejecuta una consulta “ingresos por producto” que escanea pedidos y líneas de pedido de todo el mes. Mientras corre, las escrituras de nuevos pedidos se siguen aceptando, pero vacuum no puede recuperar versiones antiguas y los índices churnean. La API de pedidos empieza a ver timeouts ocasionales —no porque esté “caída”, sino porque la contención y el overhead de limpieza empujan la latencia por encima de tus límites.

Picos de carga e impredecibilidad de la latencia

Planifica tu arquitectura de informes

Planifica pasos de réplica, data warehouse o CDC sin poner en riesgo el rendimiento en producción.

Los sistemas OLTP viven y mueren por la predictibilidad. Un checkout, ticket de soporte o actualización de saldo no está “mayormente bien” si va rápido el 95% del tiempo —los usuarios notan los momentos lentos. OLAP, en cambio, suele ser explosivo: unas pocas consultas pesadas pueden estar inactivas horas y de pronto consumir mucha CPU, memoria y E/S.

Los picos ocurren por razones normales de negocio

El tráfico analítico tiende a agruparse alrededor de rutinas:

- Tableros de “standup” matinal donde muchas personas refrescan los mismos gráficos

- Informes programados que se disparan al inicio de la hora

- Cierres de mes/trimestre que provocan escaneos y joins largos

Mientras tanto, el tráfico OLTP suele ser más constante. Cuando ambas cargas comparten una base, esos picos analíticos se traducen en latencia impredecible para las transacciones —timeouts, páginas lentas y reintentos que añaden aún más carga.

Por qué límites y programación ayudan pero no solucionan la incompatibilidad

Puedes reducir el daño con tácticas como ejecutar informes de noche, limitar concurrencia, imponer timeouts de sentencias o establecer topes de coste por consulta. Son buenos guardarraíles, especialmente para “reporting en producción”.

Pero no eliminan la tensión fundamental: las consultas OLAP están diseñadas para usar muchos recursos para responder grandes preguntas, mientras que OLTP necesita pequeños fragmentos de recursos todo el día. En el momento en que un refresco inesperado, una consulta ad-hoc o un backfill se cuela, la base compartida queda expuesta otra vez.

El problema del vecino ruidoso

En infraestructura compartida, un usuario o job analítico “ruidoso” puede monopolizar caché, saturar disco o presionar el scheduling de CPU —sin hacer nada “mal”. La carga OLTP se convierte en daño colateral, y lo más difícil es que las fallas parecen aleatorias: picos de latencia en lugar de errores claros y repetibles.

Complejidad operativa: backups, seguridad y planificación de capacidad

Mezclar OLTP y OLAP no solo crea dolores de cabeza de rendimiento —también complica las operaciones del día a día. La base se convierte en una “caja de todo” y cada tarea operativa hereda los riesgos combinados de ambas cargas.

Backups, restauraciones y recuperación de desastres se vuelven más lentos

Las tablas analíticas tienden a crecer en anchura y rapidez (más historial, más columnas, más agregados). Ese volumen extra cambia tu historia de recuperación.

Un backup completo toma más, consume más almacenamiento y aumenta la probabilidad de que pierdas la ventana de respaldo. Las restauraciones son peores: cuando necesitas recuperarte rápido, restauras no solo los datos transaccionales que la app necesita, sino también grandes conjuntos analíticos que no son necesarios para poner el negocio en marcha. Las pruebas de DR también duran más, por lo que se hacen con menos frecuencia —justo lo contrario de lo deseable.

La planificación de capacidad se vuelve adivinanza

El crecimiento transaccional suele ser predecible: más clientes, más pedidos, más filas. El crecimiento analítico es a menudo irregular: un nuevo dashboard, una política de retención distinta o un equipo que decide guardar “un año más” de eventos crudos.

Cuando conviven, es difícil responder:

- ¿Crecemos porque el producto tiene éxito o porque los reportes almacenan más historial?

- ¿Necesitamos almacenamiento rápido para transacciones o más almacenamiento barato para analítica?

Esa incertidumbre conduce a sobreaprovisionamiento (pagar por capacidad que no necesitas) o subaprovisionamiento (caídas sorpresa).

Aplicar guardarraíles es más difícil de hacer justo

En una base compartida, una consulta “inocente” puede convertirse en incidente. Terminarás añadiendo guardarraíles como timeouts, cuotas de carga, ventanas programadas o reglas de gestión de carga. Ayudan, pero son frágiles: la app y los analistas compiten por los mismos límites y un cambio de políticas para un grupo puede romper al otro.

La seguridad y el control de accesos se complican

Las aplicaciones suelen necesitar permisos estrechos y específicos. Los analistas a menudo requieren acceso de solo lectura amplio, a veces a muchas tablas, para explorar y validar. Poner ambos en una misma base aumenta la presión para conceder privilegios más amplios “solo para que el informe funcione”, elevando el radio de impacto de errores y ampliando quién puede ver datos sensibles.

Escalado y coste: terminas pagando doble (o peor)

Inicia una app transaccional rápido

Crea una app React + Go desde el chat, lista para cargas transaccionales.

Intentar ejecutar OLTP y OLAP en la misma base suele parecer más barato —hasta que empiezas a escalar. El problema no es solo el rendimiento: es que la forma “correcta” de escalar cada carga te empuja hacia infraestructuras distintas, y combinarlas fuerza compromisos caros.

Escalar OLTP está impulsado por escrituras (y suele ser doloroso)

Los sistemas transaccionales están limitados por las escrituras: muchas actualizaciones pequeñas, latencia estricta y picos que se deben absorber inmediatamente. Escalar OLTP comúnmente significa escalar verticalmente (más CPU, discos más rápidos, más memoria) porque las cargas con muchas escrituras no se reparten fácilmente.

Cuando se alcanzan límites verticales, toca fragmentación (sharding) u otros patrones de escalado de escritura. Eso añade sobrecarga de ingeniería y suele requerir cambios cuidadosos en la aplicación.

Escalar OLAP está impulsado por cómputo (y suele ser elástico)

Las cargas analíticas escalan distinto: escaneos largos, agregaciones pesadas y mucho throughput de lectura. Los sistemas OLAP típicamente escalan añadiendo cómputo distribuido, y muchos setups modernos separan cómputo de almacenamiento para poder aumentar la potencia de consultas sin duplicar datos.

Si OLAP comparte la base OLTP, no puedes escalar analítica de forma independiente. Escalas toda la base —aunque las transacciones estén bien.

La factura oculta: pagar recursos de nivel OLTP para analítica

Para mantener rápidas las transacciones mientras se ejecutan reportes, los equipos sobreaprovisionan la base de producción: cabeza extra de CPU, almacenamiento de alta gama y máquinas más grandes “por si acaso”. Eso significa que pagas precios OLTP para soportar comportamiento OLAP.

Separar reduce el sobreaprovisionamiento porque cada sistema puede dimensionarse para su trabajo: OLTP para escrituras de baja latencia, OLAP para lecturas pesadas y bursty. El resultado suele ser más barato en global —aunque sean “dos sistemas”— porque dejas de pagar capacidad transaccional premium para ejecutar reporting en producción.

Arquitecturas comunes que mantienen OLTP y OLAP separados

La mayoría de equipos separa la carga transaccional (OLTP) de la analítica (OLAP) añadiendo un segundo sistema orientado a lectura en lugar de forzar una sola base a hacer ambas cosas.

Patrón 1: réplica de lectura para reporting

Un primer paso común es una réplica de lectura (o follower) de la base OLTP, donde las herramientas BI ejecutan consultas.

Pros: cambios mínimos en la app, SQL familiar, rápido de poner en marcha.

Contras: sigue siendo el mismo motor y esquema, por lo que informes pesados pueden saturar CPU/E/S de la réplica; algunos reportes requieren características no soportadas en réplicas; y el retraso de replicación puede significar que los números estén minutos (o más) desfasados. El lag también genera conversaciones confusas del tipo “¿por qué no coincide con producción?” durante incidentes.

Mejor encaje: equipos pequeños, volumen de datos modesto, “casi en tiempo real” es deseable pero no crítico, y las consultas de reporting están controladas.

Patrón 2: data warehouse / base de analítica dedicada

Aquí, OLTP se mantiene optimizado para escrituras y lecturas puntuales, mientras que la analítica va a un data warehouse (o base columnar) diseñada para escaneos, compresión y grandes agregaciones.

Pros: rendimiento OLTP predecible, dashboards más rápidos, mejor concurrencia para analistas y afinado de coste/rendimiento más claro.

Contras: ahora operas otro sistema y necesitas un modelo de datos (a menudo star schema) amigable para analítica.

Mejor encaje: crecimiento de datos, muchos stakeholders, reporting complejo o requisitos estrictos de latencia OLTP.

Patrón 3: canalización basada en CDC hacia analítica

En lugar de ETL periódico, transmites cambios usando CDC (captura de datos de cambio) desde el log OLTP hacia el warehouse (a menudo con ELT).

Pros: datos más frescos con menor carga sobre OLTP, procesamiento incremental más sencillo y mejor auditabilidad.

Contras: más partes móviles y manejo cuidadoso de cambios de esquema.

Mejor encaje: volúmenes mayores, necesidad de frescura alta y equipos listos para pipelines de datos.

Mover datos de tu base transaccional (OLTP) a un sistema de analítica (OLAP) es menos “copiar tablas” y más construir una canalización fiable y de bajo impacto. El objetivo es simple: la analítica obtiene lo que necesita sin poner en riesgo el tráfico de producción.

ETL vs ELT (versión en lenguaje llano)

ETL (Extract, Transform, Load) significa que limpias y reestructuras los datos antes de que aterricen en el warehouse. Es útil cuando el almacenamiento en el warehouse es caro de computar o quieres control estricto de lo que se guarda.

ELT (Extract, Load, Transform) carga datos casi crudos primero y luego transforma dentro del warehouse. Suele ser más rápido de montar y más fácil de evolucionar: puedes mantener el historial “fuente de verdad” y ajustar transformaciones cuando cambian los requisitos.

Una regla práctica: si la lógica de negocio cambia con frecuencia, ELT reduce retrabajo; si la gobernanza exige solo datos curados, ETL puede encajar mejor.

Fundamentos de CDC: capturar cambios sin consultas pesadas

Change Data Capture (CDC) transmite inserts/updates/deletes desde OLTP (a menudo desde el log de la base) hacia tu sistema analítico. En lugar de escanear tablas grandes repetidamente, CDC te permite mover solo lo que cambió.

Lo que habilita:

- Reporting casi en tiempo real sin lecturas grandes sobre producción

- Reejecuciones y backfills cuando necesitas reconstruir tablas analíticas

- Trazabilidad histórica (quién cambió qué y cuándo), si almacenas eventos de cambio

Frescura de datos: real-time vs near-real-time vs diario

La frescura es una decisión de negocio con coste técnico.

- Tiempo real (segundos): mejor para dashboards operacionales, pero lo más difícil de mantener estable; pequeños fallos en la pipeline se notan de inmediato.

- Casi en tiempo real (minutos): un punto intermedio común —buena para la toma de decisiones sin complejidad extrema.

- Lotes diarios: lo más sencillo y barato, ideal para reporting financiero donde “ayer” está bien.

Define un SLA claro (por ejemplo: “los datos están hasta 15 minutos retrasados”) para que los interesados sepan qué significa “fresco”.

Controles de calidad de datos que evitan fallos silenciosos

Las pipelines suelen romper silenciosamente —hasta que alguien nota que los números no cuadran. Añade comprobaciones ligeras para:

- Cambios de esquema: nuevas columnas, renombrados o cambios de tipo que pueden nulificar datos.

- Eventos que llegan tarde: pedidos o pagos que aparecen horas después; maneja con una “ventana de lookback”.

- Desduplicación: reintentos y replays pueden duplicar conteos; usa IDs estables y cargas idempotentes.

Estas salvaguardas mantienen la analítica fiable y protegen el OLTP.

Cuando compartir una base puede ser aceptable

Recomienda a un compañero y gana

Invita a compañeros y gana créditos a medida que se unan nuevos usuarios.

Mantener OLTP y OLAP juntos no es automáticamente “malo”. Puede ser sensato temporalmente cuando la aplicación es pequeña, el reporting es limitado y puedes imponer límites estrictos para que la analítica no sorprenda a tus clientes con checkouts lentos, pagos fallidos o timeouts.

Situaciones donde puede funcionar

Apps pequeñas con analítica liviana y límites estrictos de consultas suelen funcionar en una sola base —especialmente al principio. La clave es ser honesto sobre lo que “liviano” significa: unos pocos dashboards, conteos modestos y un techo claro en tiempo de ejecución y concurrencia.

Para un conjunto limitado de reportes recurrentes, vistas materializadas o tablas resumen pueden reducir el coste de analítica. En vez de escanear transacciones crudas, precomputas totales diarios, resúmenes por categoría o rollups por cliente. Eso mantiene la mayoría de consultas cortas y predecibles.

Si los usuarios toleran números retrasados, ventanas de reporting fuera de pico ayudan. Programa trabajos pesados de noche o en periodos de baja carga y considera un rol dedicado de reporting con permisos y límites de recursos más estrictos.

Guardarraíles que deberías añadir

- Fija timeouts de sentencia y cancela consultas fuera de control.

- Limita la concurrencia para usuarios de reporting.

- Monitoriza p95/p99 de latencia para transacciones centrales por separado del reporting.

Señales claras de que es hora de dividir

Si ves latencia de transacción en aumento, incidentes recurrentes durante ejecuciones de informes, agotamiento del pool de conexiones o historias de “una consulta tumbó producción”, ya superaste la zona segura. Ahí separar bases (o al menos usar réplicas) deja de ser una optimización y se vuelve higiene operativa básica.

Checklist práctico de migración: de compartido a separado

Mover la analítica fuera de la base de producción es menos un “gran reescrito” y más hacer visible el trabajo, fijar objetivos y migrar por pasos controlados.

1) Inventario de lo que realmente pasa hoy

Empieza con evidencia, no suposiciones. Extrae una lista de:

- Endpoints/consultas OLTP principales por frecuencia y p95/p99 (checkout, login, crear pedido, etc.)

- Reportes/dashboards OLAP principales por tiempo de ejecución, volumen de escaneo y prioridad de negocio

Incluye analítica “oculta”: SQL ad-hoc desde herramientas BI, exportes programados y descargas CSV.

2) Define objetivos: SLOs OLTP y frescura analítica

Escribe los objetivos que vas a optimizar:

- SLOs OLTP: latencia p95/p99, tasa de error y throughput pico que debes sostener

- Frescura analítica: cuánto retraso es aceptable (5 minutos, 1 hora, al día siguiente), más tiempo para reconstruir si la pipeline falla

Esto evita debates tipo “está lento” vs “está bien” y ayuda a elegir la arquitectura correcta.

3) Elige un camino de separación

Escoge la opción más simple que cumpla objetivos:

- Réplica de lectura: más rápida de adoptar para reporting con muchas lecturas, pero puede sufrir por consultas caras y lag.

- Warehouse: ideal para escaneos grandes, muchos joins e historial largo; suele ser el hogar correcto para BI.

- Canalización CDC (ETL/ELT): mejor cuando necesitas analítica casi en tiempo real sin golpear producción

4) Despliegue seguro (paralelo primero)

- Valida definiciones (zonas horarias, reembolsos, “usuario activo”, etc.) para que los números coincidan.

- Ejecuta dashboards viejos y nuevos en paralelo durante un ciclo completo de negocio.

- Haz el corte informe por informe, empezando por las consultas más problemáticas.

- Bloquea el acceso directo a “reporting en producción” una vez que los interesados confíen en la nueva fuente.

5) Añade guardarraíles para no retroceder

Configura monitorización de lag de réplicas/delays de pipeline, tiempos de ejecución de dashboards y gasto en warehouse. Añade presupuestos de consulta (timeouts, límites de concurrencia) y conserva un playbook de incidentes: qué hacer cuando la frescura falla, las cargas suben o métricas clave divergen.

Nota práctica si construyes la app

Si estás en fases tempranas y avanzando rápido, el mayor riesgo es construir analítica directamente en la misma ruta de base que las transacciones críticas (por ejemplo, consultas de dashboard que se vuelven “críticas para producción”). Una forma de evitarlo es diseñar la separación desde el inicio —aunque empieces con una réplica modesta— y meterla en tu checklist arquitectónico.

Plataformas como Koder.ai pueden ayudar: puedes prototipar el lado OLTP (app React + servicios Go + PostgreSQL) y esbozar el límite reporting/warehouse en modo planificación antes de lanzar. Conforme el producto crece, puedes exportar código fuente, evolucionar el esquema y añadir componentes CDC/ELT sin convertir “reporting en producción” en un hábito permanente.