Qué son los runtimes de JavaScript y por qué importan

JavaScript es el lenguaje. Un runtime de JavaScript es el entorno que hace útil el lenguaje fuera del navegador: incorpora un motor de JavaScript (como V8) y lo rodea con las características del sistema que las apps reales necesitan: acceso a archivos, red, temporizadores, gestión de procesos y APIs para criptografía, streams y más.

Si el motor es el “cerebro” que entiende JavaScript, el runtime es todo el “cuerpo” que puede hablar con tu sistema operativo y con Internet.

Dónde aparecen los runtimes

Los runtimes modernos no sirven solo para servidores web. Alimentan:

- Servidores y APIs (apps backend tradicionales)

- Herramientas CLI (formatters, herramientas de build, scripts de automatización)

- Funciones en el edge (código ejecutándose cerca de los usuarios, a menudo con límites más estrictos)

- Apps de escritorio (a menudo mediante frameworks que empaquetan un runtime)

El mismo lenguaje puede ejecutarse en todos esos sitios, pero cada entorno tiene distintas restricciones: tiempo de arranque, límites de memoria, límites de seguridad y APIs disponibles.

Por qué existen múltiples runtimes (y siguen cambiando)

Los runtimes evolucionan porque los desarrolladores buscan distintos compromisos. Algunos priorizan la máxima compatibilidad con el ecosistema existente de Node.js. Otros apuntan a valores predeterminados de seguridad más estrictos, mejor ergonomía para TypeScript o arranques en frío más rápidos para herramientas.

Aunque dos runtimes compartan el mismo motor, pueden diferir dramáticamente en:

- APIs integradas y soporte de estándares

- Enfoque para la gestión de paquetes

- Modelo de permisos y sandboxing

- Experiencia de herramientas (testing, formateo, bundling)

Qué significa realmente “competir”

La competencia no es solo velocidad. Los runtimes compiten por adopción (comunidad y difusión), compatibilidad (qué tanto del código existente “funciona tal cual”) y confianza (postura de seguridad, estabilidad, mantenimiento a largo plazo). Esos factores determinan si un runtime se vuelve una elección por defecto o una herramienta de nicho que usas solo en proyectos concretos.

Un recorrido rápido por runtimes populares

Cuando la gente dice “runtime de JavaScript”, suelen referirse a “el entorno que ejecuta JS fuera (o dentro) del navegador, más las APIs que usas para construir cosas”. El runtime que elijas moldea cómo lees archivos, arrancas servidores, instalas paquetes, manejas permisos y depuras problemas en producción.

Ejemplos comunes que escucharás

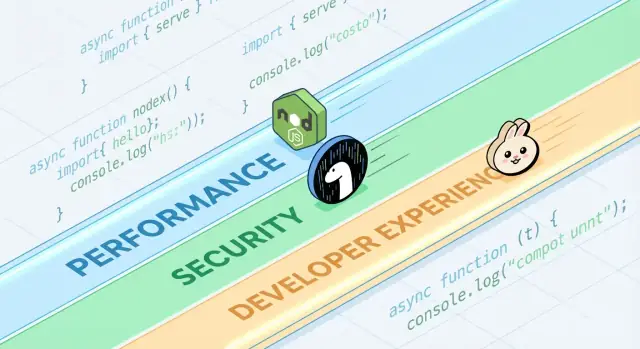

Node.js es el estándar de largo recorrido para JavaScript en servidor. Tiene el ecosistema más amplio, herramientas maduras y un gran impulso comunitario.

Deno se diseñó con valores modernos: soporte de TypeScript de primera clase, una postura de seguridad más fuerte por defecto y un enfoque de biblioteca estándar más “baterías incluidas”.

Bun se centra mucho en la velocidad y la comodidad del desarrollador, empaquetando un runtime rápido con una cadena de herramientas integrada (instalación de paquetes y testing) destinada a reducir el trabajo de configuración.

Runtimes de navegador (Chrome, Firefox, Safari) siguen siendo los runtimes de JS más comunes en general. Están optimizados para trabajo de UI y traen APIs web como DOM, fetch y almacenamiento, pero no ofrecen acceso directo al sistema de archivos como los runtimes de servidor.

Qué comparten los runtimes

La mayoría empareja un motor de JavaScript (a menudo V8) con un event loop y un conjunto de APIs para red, temporizadores, streams y más. El motor ejecuta el código; el event loop coordina trabajo asíncrono; las APIs son lo que realmente llamas a diario.

Qué difiere (y por qué importa en el día a día)

Las diferencias aparecen en características integradas (como manejo de TypeScript incorporado), herramientas por defecto (formateador, linter, runner de tests), compatibilidad con las APIs de Node y modelos de seguridad (por ejemplo, si el acceso a archivos/red es irrestricto o está controlado por permisos). Por eso la elección del runtime no es abstracta: afecta lo rápido que puedes iniciar un proyecto, qué seguro puedes ejecutar scripts y lo doloroso (o fluido) que es desplegar y depurar.

Rendimiento: las métricas por las que compiten los runtimes

“Rápido” no es un solo número. Un runtime puede verse increíble en una gráfica y ordinario en otra, porque optimizan para distintas definiciones de velocidad.

Latencia vs throughput

La latencia es qué tan rápido termina una sola petición; el throughput es cuántas peticiones puedes completar por segundo. Un runtime afinado para arranques de baja latencia y respuestas rápidas puede sacrificar throughput pico bajo alta concurrencia, y viceversa.

Por ejemplo, una API que sirve búsquedas de perfil de usuario se preocupa por la latencia cola (p95/p99). Un job por lotes que procesa miles de eventos por segundo se preocupa más por throughput y eficiencia en estado estable.

Tiempo de arranque en frío (serverless y CLIs)

Cold start es el tiempo desde “nada está corriendo” hasta “listo para trabajar”. Importa mucho para funciones serverless que escalan a cero y para herramientas CLI que los usuarios ejecutan con frecuencia.

Los cold starts se ven influenciados por la carga de módulos, la transpile de TypeScript (si la hay), la inicialización de APIs integradas y cuánto trabajo hace el runtime antes de que tu código se ejecute. Un runtime puede ser muy rápido una vez caliente, pero sentirse lento si tarda en arrancar.

Rendimiento de I/O: red, sistema de archivos, streams

La mayor parte del JavaScript del lado servidor está limitado por I/O: peticiones HTTP, llamadas a bases de datos, lectura de archivos, streaming de datos. Aquí, el rendimiento suele depender de la eficiencia del event loop, la calidad de los bindings de I/O asíncrono, implementaciones de streams y cómo se maneja el backpressure.

Diferencias pequeñas—como la rapidez con que el runtime parsea cabeceras, agenda temporizadores o vacía escrituras—pueden traducirse en ganancias reales en servidores web y proxies.

Trabajo ligado a CPU: fortalezas y límites del motor

Tareas intensivas en CPU (parsing, compresión, procesamiento de imágenes, crypto, analítica) estresan el motor de JavaScript y el compilador JIT. Los motores pueden optimizar caminos calientes, pero JavaScript tiene límites para cargas numéricas sostenidas.

Si el trabajo ligado a CPU domina, el “runtime más rápido” puede ser el que facilite mover bucles calientes a código nativo o usar worker threads sin complejidad.

Verificación de benchmarks (y trampas comunes)

Los benchmarks pueden ser útiles, pero son fáciles de malinterpretar—especialmente cuando se tratan como tablas de clasificación universales. Un runtime que “gana” una gráfica puede seguir siendo más lento para tu API, tu pipeline de build o tu trabajo de procesamiento de datos.

Microbenchmarks vs aplicaciones reales

Los microbenchmarks suelen probar una operación minúscula (como parsear JSON, regex o hashing) en un bucle cerrado. Eso ayuda a medir un ingrediente, no la comida completa.

Las apps reales gastan tiempo en cosas que los microbenchmarks ignoran: esperas de red, llamadas a bases de datos, I/O de archivos, overhead de frameworks, logging y presión de memoria. Si tu carga es mayormente I/O-bound, un bucle de CPU un 20% más rápido puede no mover tu latencia end-to-end en absoluto.

Los resultados cambian según la carga, el SO y las versiones

Pequeñas diferencias de entorno pueden invertir resultados:

- Forma de la carga: muchas peticiones pequeñas vs pocas grandes; streaming vs buffering.

- SO y hardware: Linux vs macOS; diferentes CPUs; límites de contenedores.

- Versiones de runtime y dependencias: actualizaciones del motor, diferencias de libc y cambios en librerías pueden dominar.

Cuando veas una captura de benchmark, pregunta qué versiones y flags se usaron—y si coinciden con tu entorno de producción.

Efectos de warm-up (JIT) y cachés

Los motores de JavaScript usan compilación JIT: el código puede correr más lento al inicio y luego acelerar cuando el motor “aprende” caminos calientes. Si un benchmark mide solo los primeros segundos, puede premiar cosas equivocadas.

La caché también importa: caché de disco, caché DNS, keep-alive HTTP y cachés a nivel de aplicación pueden hacer que ejecuciones posteriores parezcan mucho mejores. Eso puede ser real, pero debe controlarse.

Diseñar pruebas justas y repetibles

Apunta a benchmarks que respondan a tus preguntas, no a las de otro:

- Mide end-to-end: incluye framework + middleware típico + tamaños de payload reales.

- Separa frío vs caliente: registra arranque, primera petición y estado estable.

- Ejecuta varias pruebas: reporta mediana y varianza, no solo la mejor corrida.

- Bloquea el entorno: fija versiones, aísla CPU y documenta comandos.

Si necesitas una plantilla práctica, captura tu arnés de pruebas en un repositorio y enlázalo desde la documentación interna (o en /blog/runtime-benchmarking-notes) para que los resultados sean reproducibles más tarde.

Bajo el capó: motores, APIs y modelos de ejecución

Experimenta con una reversión sencilla

Itera sobre un prototipo de forma segura con instantáneas y reversiones cuando los experimentos salgan mal.

Cuando la gente compara Node.js, Deno y Bun, a menudo hablan de características y benchmarks. Debajo, la “sensación” de un runtime la moldean cuatro piezas grandes: el motor de JavaScript, las APIs integradas, el modelo de ejecución (event loop + planificadores) y cómo se enlaza el código nativo.

Motores: V8, JavaScriptCore y por qué importan

El motor es la parte que parsea y ejecuta JavaScript. V8 (usado por Node.js y Deno) y JavaScriptCore (usado por Bun) hacen optimizaciones avanzadas como compilación JIT y garbage collection.

En la práctica, la elección del motor puede influir en:

- Tiempo de arranque y comportamiento de memoria (qué tan rápido un proceso se vuelve útil)

- Rendimiento del “código caliente” tras optimizaciones

- Qué características de bajo nivel llegan primero (algunos motores introducen nuevas capacidades de JS antes que otros)

APIs integradas: más que “¿puedo fetch?”

Los runtimes modernos compiten en cuán completa se siente su biblioteca estándar. Tener incorporados fetch, Web Streams, utilidades URL, APIs de archivos y crypto puede reducir la proliferación de dependencias y hacer el código más portable entre servidor y navegador.

La trampa: el mismo nombre de API no siempre significa comportamiento idéntico. Diferencias en streaming, timeouts o watch de archivos pueden afectar apps reales más que la velocidad bruta.

Modelos de ejecución: loops de eventos, planificadores y bindings nativos

JavaScript es de una sola hebra en la capa superior, pero los runtimes coordinan trabajo en background (red, I/O, temporizadores) mediante un event loop y planificadores internos. Algunos runtimes apoyan fuertemente bindings nativos (código compilado) para I/O y tareas críticas de rendimiento, mientras otros enfatizan interfaces estándar web.

WebAssembly: cuándo ayuda

WebAssembly (Wasm) es útil cuando necesitas computación rápida y predecible (parsing, procesamiento de imágenes, compresión) o quieres reutilizar código de Rust/C/C++. No va a acelerar mágicamente servidores I/O-bound típicos, pero puede ser una gran herramienta para módulos CPU-intensivos.

Seguridad: predeterminados, permisos y la realidad de la cadena de suministro

“Seguro por defecto” en un runtime de JavaScript suele significar que el runtime asume código no confiable hasta que explícitamente concedas acceso. Eso revierte el modelo tradicional del lado servidor (donde los scripts a menudo pueden leer archivos, llamar a la red e inspeccionar variables de entorno por defecto) hacia una postura más cautelosa.

A la vez, muchos incidentes reales comienzan antes de que tu código corra—dentro de tus dependencias y del proceso de instalación—así que la seguridad a nivel de runtime debe ser una capa más, no la estrategia completa.

Solicitudes de permiso y listas de permitidos

Algunos runtimes pueden restringir capacidades sensibles mediante permisos. La versión práctica de esto es una lista de permitidos:

- Sistema de archivos: permitir lectura/escritura sólo a rutas específicas (por ejemplo, un directorio de configuración)

- Red: permitir solicitudes salientes solo a hosts/puertos aprobados

- Variables de entorno: exponer sólo claves específicas en lugar de todo el env del proceso

Esto puede reducir fugas accidentales de datos (como enviar secretos a un endpoint inesperado) y limitar el radio de impacto cuando ejecutas scripts de terceros—especialmente en CLIs, herramientas de build y automatización.

El sandbox tiene límites

Los permisos no son una protección mágica. Si das acceso de red a “api.miempresa.com”, una dependencia comprometida aún puede exfiltrar datos a ese mismo host. Y si permites leer un directorio, confías en todo lo que hay dentro. El modelo te ayuda a expresar intención, pero aún necesitas vetar dependencias, usar lockfiles y revisar cuidadosamente lo que permites.

Predeterminados seguros en APIs comunes

La seguridad también vive en pequeños predeterminados:

- TLS/HTTPS: validación de certificados sensata y configuraciones modernas por defecto

- HTTP: comportamiento de redirección seguro y control claro sobre headers/cookies

- APIs de crypto: primitivas modernas con interfaces difíciles de usar incorrectamente

La compensación es fricción: predeterminados más estrictos pueden romper scripts heredados o añadir flags que debes mantener. La mejor elección depende de si valoras la conveniencia para servicios de confianza o las guías de protección al ejecutar código de confianza mixta.

Riesgos de la cadena de suministro que no puedes ignorar

Los ataques a la cadena de suministro suelen explotar cómo se descubren e instalan paquetes:

- Typosquatting: un paquete malicioso nombrado con un carácter de diferencia respecto a uno popular (p. ej.,

expresss).

- Dependency confusion: se publica un paquete público con el mismo nombre que uno interno, engañando al instalador para que traiga la versión pública.

- Mantenedores comprometidos: una toma de cuenta que publica una actualización “legítima” con código inyectado.

Estos riesgos afectan a cualquier runtime que descargue paquetes desde un registro público—así que la higiene importa tanto como las características del runtime.

Lockfiles, checks de integridad y procedencia

Los lockfiles fijan versiones exactas (y dependencias transitivas), haciendo las instalaciones reproducibles y reduciendo actualizaciones sorpresa. Los checks de integridad (hashes registrados en el lockfile o metadatos) ayudan a detectar manipulación durante la descarga.

La procedencia es el siguiente paso: poder responder “¿quién construyó este artefacto, desde qué código fuente y con qué flujo de trabajo?” Aunque no adoptes herramienta de procedencia completa aún, puedes aproximarla:

- preferir paquetes bien mantenidos con prácticas de publicación transparentes,

- evitar dependencias Git sin fijar en builds de producción,

- requerir tags/releases en lugar de instalar desde commits aleatorios.

Flujos de trabajo de auditoría y actualización que funcionen

Trata el trabajo de dependencias como mantenimiento rutinario:

- ejecuta auditorías automáticas en CI en cada pull request,

- agenda ventanas regulares de actualización (semanales/quincenales) para evitar migraciones masivas,

- revisa changelogs en saltos mayores y releases relacionados con seguridad.

Políticas de equipo que no ralenticen la entrega

Reglas ligeras rinden mucho:

- bloquear nuevas dependencias a menos que haya una necesidad clara y un responsable,

- restringir scripts de instalación cuando sea posible (son un vector de ejecución común),

- usar un registro privado o paquetes con scope para nombres internos y reducir confusiones.

La buena higiene es menos sobre perfección y más sobre hábitos consistentes y aburridos.

Compatibilidad y ecosistema como ventajas competitivas

El rendimiento y la seguridad atraen titulares, pero la compatibilidad y el ecosistema suelen decidir qué se despliega realmente. Un runtime que hace correr tu código existente, soporta tus dependencias y se comporta igual en distintos entornos reduce riesgo más que cualquier característica aislada.

La compatibilidad afecta a la seguridad y mantenimiento

La compatibilidad no es solo conveniencia. Menos reescrituras significa menos oportunidades de introducir bugs sutiles y menos parches puntuales que acabarás olvidando actualizar. Los ecosistemas maduros también suelen tener modos de fallo conocidos: librerías comunes han sido auditadas más, problemas están documentados y las mitigaciones son más fáciles de encontrar.

Por otro lado, la “compatibilidad a cualquier precio” puede mantener patrones heredados (como accesos a archivos/red demasiado amplios), así que los equipos siguen necesitando límites claros y buena higiene de dependencias.

Capas de compatibilidad con Node vs APIs estándar web

Los runtimes que intentan ser compatibles con Node.js pueden ejecutar la mayoría del JavaScript del lado servidor inmediatamente, lo cual es una ventaja práctica enorme. Las capas de compatibilidad pueden suavizar diferencias, pero también pueden ocultar comportamientos específicos del runtime—especialmente en filesystem, networking y resolución de módulos—volviendo la depuración más difícil cuando algo se comporta distinto en producción.

Las APIs estándar web (como fetch, URL y Web Streams) empujan el código hacia la portabilidad entre runtimes e incluso entornos edge. La contrapartida: algunos paquetes diseñados para Node asumen internos de Node y no funcionarán sin shims.

Ecosistema npm: fortalezas e inconvenientes

La mayor fortaleza de npm es simple: lo tiene casi todo. Esa amplitud acelera la entrega, pero también incrementa la exposición al riesgo de la cadena de suministro y a la proliferación de dependencias. Incluso cuando un paquete es “popular”, sus dependencias transitivas pueden sorprenderte.

Cuando “funciona en todas partes” vence a las nuevas características

Si tu prioridad es despliegues predecibles, contratación más fácil y menos sorpresas de integración, “funciona en todas partes” suele ser la característica ganadora. Las capacidades nuevas del runtime son emocionantes, pero la portabilidad y un ecosistema probado pueden ahorrarte semanas a lo largo de la vida de un proyecto.

Experiencia de desarrollador: herramientas, tipos y depuración

Convierte la checklist en acciones

Convierte tu checklist de decisión de runtime en un proyecto piloto concreto que puedas ejecutar.

La experiencia de desarrollador es donde los runtimes ganan o pierden en silencio. Dos runtimes pueden ejecutar el mismo código y, sin embargo, sentirse totalmente distintos cuando configuras un proyecto, persigues un bug o intentas lanzar un servicio pequeño rápidamente.

Soporte TypeScript: integrado vs “trae tu propia herramienta”

TypeScript es un buen litmus para la DX. Algunos runtimes lo tratan como entrada de primera clase (puedes ejecutar archivos .ts con poca ceremonia), mientras otros esperan una cadena de herramientas tradicional (tsc, un bundler o un loader) que configures.

Ningún enfoque es universalmente “mejor”:

- El soporte integrado reduce la configuración y puede estandarizar predeterminados en un equipo.

- Las herramientas configuradas te dan más control sobre tsconfig, targets y salida—útil para librerías y monorepos grandes.

La pregunta clave es si la historia de TypeScript del runtime encaja con cómo tu equipo realmente entrega código: ejecución directa en dev, builds compilados en CI o ambos.

Bundling, transpile y defaults de testing

Los runtimes modernos cada vez incluyen herramientas opinadas: bundlers, transpilers, linters y runners de pruebas que funcionan out of the box. Eso puede eliminar el impuesto de “elige tu propia pila” en proyectos pequeños.

Pero los predeterminados solo suman a la DX cuando son predecibles:

- ¿Puedes cambiar fácilmente formatos de salida (ESM/CJS), targets y dependencias externas?

- ¿El runner de tests se integra bien con coverage y CI?

- ¿La configuración es mínima y se mantiene estable entre versiones?

Si empiezas servicios con frecuencia, un runtime con buenos integrados y buena documentación puede ahorrar horas por proyecto.

Depuración: stack traces, sourcemaps e inspectores

La depuración es donde el pulido del runtime se vuelve obvio. Stack traces de alta calidad, manejo correcto de sourcemaps y un inspector que “simplemente funcione” determinan qué tan rápido entiendes fallos.

Busca:

- Errores claros que apunten a tu código fuente (no al código generado)

- Stack traces asíncronos fiables

- Buena integración con editores e inspectores estilo Chrome DevTools

Plantillas y scaffolding que eliminan fricción

Los generadores de proyectos pueden ser subestimados: una plantilla limpia para una API, CLI o worker a menudo marca el tono de un codebase. Prefiere scaffolds que creen una estructura mínima pero lista para producción (logging, manejo de env, tests), sin encerrarte en un framework pesado.

Si necesitas inspiración, ve guías relacionadas en /blog.

Como flujo práctico, los equipos a veces usan Koder.ai para prototipar un servicio pequeño o CLI en distintos “estilos de runtime” (Node-first vs APIs estándar web) y luego exportar el código generado para una medición real. No sustituye las pruebas en producción, pero puede acortar el tiempo desde la idea hasta una comparación ejecutable cuando evalúas trade-offs.

Las elecciones de gestión de paquetes moldean la DX

La gestión de paquetes es donde la “experiencia del desarrollador” se vuelve tangible: velocidad de instalación, comportamiento del lockfile, soporte para workspaces y qué tan fiable es la reconstrucción en CI. Los runtimes cada vez tratan esto como una característica de primera clase.

Gestores de paquetes nativos del runtime y objetivos de rendimiento

Node.js históricamente dependió de herramientas externas (npm, Yarn, pnpm), lo cual es fortaleza (elección) y fuente de inconsistencia entre equipos. Runtimes más nuevos ofrecen opiniones: Deno integra la gestión de dependencias vía deno.json (y soporta paquetes npm), mientras Bun empaqueta un instalador rápido y su propio lockfile.

Estas herramientas nativas suelen optimizar por menos rondas de red, caching agresivo e integración estrecha con el cargador de módulos del runtime—útil para cold starts en CI y para onboarding de nuevos compañeros.

Monorepos, workspaces y nociones básicas de cache

La mayoría de equipos eventualmente necesitan workspaces: paquetes internos compartidos, versiones de dependencias consistentes y reglas de hoisting predecibles. npm, Yarn y pnpm soportan workspaces, pero se comportan distinto en uso de disco, layout de node_modules y deduplicación. Eso afecta tiempo de instalación, resolución en el editor y bugs de “funciona en mi máquina”.

El cache importa igual. Un buen punto de partida es cachear el store del gestor de paquetes (o la caché de descargas) más pasos de instalación basados en lockfile, y mantener scripts deterministas. Si quieres algo simple, documenta el proceso junto a tus pasos de build en /docs.

Publicación y consumo: qué necesitan los equipos saber

La publicación interna de paquetes (o consumir registros privados) te obliga a estandarizar auth, URLs de registro y reglas de versionado. Asegura que tu runtime/herramientas soporten las mismas convenciones de .npmrc, checks de integridad y expectativas de procedencia.

Preocupaciones de migración: cambios en lockfile y ajustes en CI

Cambiar de gestor de paquetes o adoptar un instalador integrado al runtime típicamente cambia lockfiles y comandos de instalación. Planea la avalancha de PRs, actualiza imágenes de CI y alinea un lockfile “fuente de verdad”—si no, estarás depurando deriva de dependencias en vez de entregar features.

Elegir un runtime según el caso de uso (no por el hype)

Crea una API para pruebas de rendimiento

Crea una pequeña API desde el chat y úsala como objetivo realista de prueba de rendimiento de extremo a extremo.

Elegir un runtime de JavaScript es menos sobre “el más rápido en la gráfica” y más sobre la forma de tu trabajo: cómo despliegas, con qué necesitas integrarte y cuánto riesgo puede asumir tu equipo. Una buena elección es la que reduce fricción para tus restricciones.

Workloads serverless y en el edge

Aquí, el cold-start y el comportamiento bajo concurrencia importan tanto como el throughput bruto. Busca:

- Tiempo de arranque (qué tan rápido una función empieza a atender peticiones)

- Modelo de aislamiento (procesos vs isolates/ejecución estilo worker)

- Disponibilidad de APIs (

fetch, streams, crypto) en la plataforma objetivo

Node.js es ampliamente soportado por proveedores; las APIs estándar web y el modelo de permisos de Deno pueden ser atractivos cuando están disponibles; la velocidad de Bun puede ayudar, pero confirma soporte de plataforma y compatibilidad edge antes de comprometerte.

Herramientas CLI y automatización

Para utilidades de línea de comandos, la distribución puede dominar la decisión. Prioriza:

- Builds en binario único y instalaciones predecibles

- Comportamiento cross-platform (macOS, Windows, Linux)

- Arranque rápido y buena ergonomía para desarrolladores

El tooling integrado y la distribución fácil de Deno son fuertes para CLIs. Node.js es sólido cuando necesitas la amplitud de npm. Bun puede ser genial para scripts rápidos, pero valida el empaquetado y el soporte en Windows para tu audiencia.

Contenedores y servicios de larga ejecución

En contenedores, la estabilidad, comportamiento de memoria y observabilidad suelen pesar más que los benchmarks de titular. Evalúa uso de memoria en estado estable, comportamiento del GC bajo carga y madurez de herramientas de depuración/perfilado. Node.js tiende a ser el “valor seguro” para servicios de larga vida por madurez del ecosistema y familiaridad operacional.

Las limitaciones del equipo vencen a la novedad

Elige el runtime que encaje con las habilidades existentes del equipo, librerías y operaciones (CI, monitoreo, respuesta a incidentes). Si un runtime fuerza reescrituras, nuevos flujos de depuración o prácticas de dependencias poco claras, cualquier ganancia en rendimiento puede borrarse por el riesgo de entrega.

Si tu objetivo es lanzar features de producto más rápido (no debatir runtimes), considera dónde realmente encaja JavaScript en tu stack. Por ejemplo, Koder.ai se centra en construir aplicaciones completas vía chat—frontends web en React, backends en Go con PostgreSQL y móviles en Flutter—así que los equipos a menudo reservan las “decisiones de runtime” para los puntos donde Node/Deno/Bun realmente importan (herramientas, scripts edge o servicios JS existentes), mientras siguen avanzando con una base lista para producción.

Lista de verificación y próximos pasos

Elegir un runtime es menos sobre escoger un “ganador” y más sobre reducir riesgo mientras mejoras resultados para tu equipo y producto.

Una lista corta

- Pruebas de rendimiento: ¿conoces tus 3 principales cuellos de botella (tiempo de arranque, throughput de peticiones, trabajo intensivo en CPU, latencia de I/O)? ¿Puedes reproducirlos localmente y en CI?

- Necesidades de seguridad: ¿necesitas un modelo de permisos (acceso a archivos/red/env), sandboxing más estricto o controles impulsados por cumplimiento?

- Prioridades de DX: ¿qué fricción te cuesta más hoy: setup de TypeScript, depuración, hot reload, tooling de tests o empaquetado para despliegue?

Preguntas antes de cambiar de runtime

- ¿Qué problema resolvemos: coste, latencia, velocidad de desarrollo o seguridad?

- ¿Qué partes de nuestro sistema son sensibles al runtime (funciones edge, CLIs, APIs, jobs en background)?

- ¿Estamos atados a un comportamiento del ecosistema de paquetes (addons nativos, scripts postinstall, expectativas CommonJS/ESM)?

- ¿Cuál es nuestro plan de rollback si una dependencia o integración de plataforma se comporta distinto?

- ¿Quién será responsable de las actualizaciones del runtime y del seguimiento de cambios incompatibles?

Un plan piloto práctico

Empieza pequeño y medible:

- Escoge un servicio o herramienta interna con entradas/salidas claras (p. ej., un handler de webhooks, un CLI, un worker pequeño).

- Define métricas de éxito: latencia p95, memoria, CPU, tiempo de build, cold start y tiempo de corrección por desarrollador.

- Ejecuta el piloto en dos entornos: staging y un canario en producción (si es factible).

- Compara resultados, documenta sorpresas y itera (ajusta configs, elecciones de dependencias) antes de considerar una migración más amplia.

Si quieres acortar el bucle de retroalimentación, puedes prototipar el servicio y el arnés de benchmark rápidamente en Koder.ai, usar Planning Mode para delinear el experimento (métricas, endpoints, payloads) y luego exportar el código para que las mediciones finales se ejecuten en el entorno que controlas.

Dónde aprender más

Consulta fuentes primarias y señales continuas:

- Documentación oficial y notas de compatibilidad de Node.js, Deno y Bun

- Notas de lanzamiento y changelogs (vigila correcciones de seguridad y cambios incompatibles)

- Avisos de seguridad y feeds CVE relevantes para tus dependencias

- Issue trackers comunitarios para detectar casos reales límite

Si quieres una guía más profunda sobre cómo medir runtimes de forma justa, ve /blog/benchmarking-javascript-runtimes.