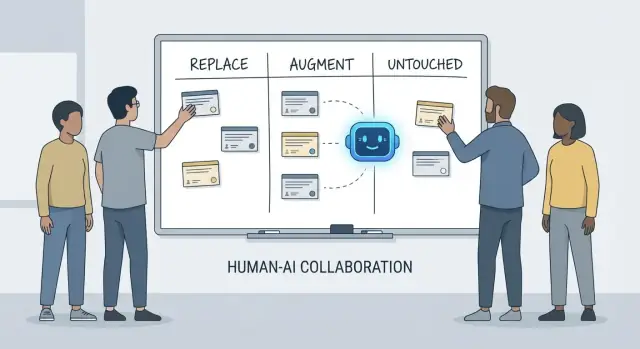

Reemplazar, Aumentar, Intacto: Un marco simple

Las conversaciones sobre lo que “la IA hará con los desarrolladores” se vuelven confusas rápido porque a menudo mezclamos herramientas con responsabilidades. Una herramienta puede generar código, resumir un ticket o sugerir pruebas. Una responsabilidad es de lo que el equipo sigue siendo responsable cuando la sugerencia está equivocada.

Este artículo usa un marco simple—reemplazar, aumentar, intacto—para describir el trabajo diario en equipos reales con plazos, código heredado, incidentes en producción y stakeholders que esperan resultados fiables.

Qué significa “reemplazar” (y qué no)

Reemplazar significa que la IA puede completar la tarea de extremo a extremo la mayor parte del tiempo con guardarraíles claros, y el rol humano pasa a supervisión y comprobaciones puntuales.

Los ejemplos suelen ser trabajos acotados: generar boilerplate, traducir código entre lenguajes, redactar casos de prueba repetitivos o producir documentación de primera pasada.

Reemplazar no significa no responsabilidad humana. Si la salida rompe producción, filtra datos o viola estándares, sigue siendo responsabilidad del equipo.

Qué significa “aumentar”

Aumentar significa que la IA hace al desarrollador más rápido o más exhaustivo, pero no termina el trabajo de forma fiable sin juicio humano.

Este es el caso común en la ingeniería profesional: obtendrás borradores útiles, enfoques alternativos, explicaciones rápidas o una lista corta de bugs probables—pero un desarrollador aún decide qué es correcto, seguro y apropiado para el producto.

Qué queda “intacto”

Intacto significa que la responsabilidad central sigue siendo liderada por humanos porque requiere contexto, compensaciones y rendición de cuentas que no se comprimen bien en prompts.

Piensa en: negociar requisitos, elegir restricciones a nivel de sistema, manejar incidentes, fijar barras de calidad y tomar decisiones donde no hay una única respuesta “correcta”.

Por qué las responsabilidades son la unidad de análisis

Las herramientas cambian rápido. Las responsabilidades cambian despacio.

Así que en lugar de preguntar “¿Puede una IA escribir este código?”, pregunta “¿Quién se hace responsable del resultado?” Ese enfoque mantiene las expectativas ancladas en precisión, fiabilidad y responsabilidad—cosas que importan más que las demos impresionantes.

Qué entendemos por “responsabilidades del desarrollador”

Cuando la gente pregunta qué “reemplaza” la IA en desarrollo, a menudo se refieren a tareas: escribir una función, generar pruebas, redactar documentación. Sin embargo, los equipos no envían tareas, envían resultados. Ahí es donde importan las responsabilidades del desarrollador.

El paquete habitual de responsabilidades

El trabajo de un desarrollador suele abarcar más que tiempo de codificación:

- Entrega: convertir una idea vaga en software funcional que se envía a tiempo.

- Calidad: corrección, mantenibilidad y prevención de regresiones.

- Seguridad y privacidad: valores seguros por defecto, manejo de datos y conciencia de amenazas.

- Operaciones: mantener servicios funcionando, entender modos de fallo y responder a incidentes.

- Comunicación: alinearse con producto, diseño, soporte y otros ingenieros.

Estas responsabilidades se sitúan a lo largo de todo el ciclo de vida—from “¿qué deberíamos construir?” hasta “¿es seguro?” y “¿qué pasa a las 3 a. m. cuando se rompe?”.

Por qué es más que una lista de verificación

Cada responsabilidad es en realidad muchas decisiones pequeñas: qué casos límite importan, qué métricas indican salud, cuándo recortar alcance, si una corrección es segura para enviar, cómo explicar una compensación a stakeholders. La IA puede ayudar a ejecutar piezas de este trabajo (redactar código, proponer pruebas, resumir logs), pero la responsabilidad es sobre poseer el resultado.

Dónde fallan los traspasos

Las rupturas suelen ocurrir en los límites de traspaso:

- “QA lo detectará” (pero nadie definió qué significa calidad).

- “Seguridad lo revisará” (pero el diseño ya fijó elecciones arriesgadas).

- “Operaciones lo manejará” (pero el servicio no fue construido para ser operable).

Cuando la propiedad no está clara, el trabajo cae en las grietas.

Derechos de decisión: quién decide vs. quién ejecuta

Una forma útil de hablar de responsabilidades son los derechos de decisión:

- ¿Quién decide requisitos, compensaciones y riesgo aceptable?

- ¿Quién ejecuta implementación y verificación?

La IA puede acelerar la ejecución. Los derechos de decisión—y la responsabilidad por los resultados—siguen necesitando un nombre humano al lado.

Los asistentes de programación con IA son realmente útiles cuando el trabajo es predecible, de bajo riesgo y fácil de verificar. Piénsalos como un compañero junior rápido: genial para producir una primera pasada, pero aún requiere instrucciones claras y una comprobación cuidadosa.

En la práctica, algunos equipos usan cada vez más plataformas de “vibe-coding” (como Koder.ai) para acelerar estos trozos reemplazables: generar scaffolds, conectar flujos CRUD y producir borradores iniciales de código de UI y backend desde chat. La clave es la misma: guardarraíles, revisión y propiedad clara.

Boilerplate de bajo riesgo

Mucho tiempo de desarrollador se va en scaffolding de proyectos y en conectar cosas. La IA a menudo puede generar:

- archivos y carpetas iniciales (controladores, rutas, DTOs)

- “código pegamento” repetitivo entre capas

- endpoints CRUD simples que siguen un patrón establecido

El guardarraíl aquí es la consistencia: asegúrate de que coincide con tus convenciones existentes y no invente nuevos patrones o dependencias.

Refactorizaciones y migraciones mecánicas

Cuando un cambio es mayormente mecánico—renombrar un símbolo en todo el código, reformatear o actualizar un uso de API sencillo—la IA puede acelerar el trabajo rutinario.

Aun así, trátalo como una edición masiva: ejecuta la suite de pruebas completa, revisa los diffs por cambios de comportamiento no intencionados y evita que “mejore” cosas más allá del refactor solicitado.

Borradores de documentación (requieren revisión)

La IA puede redactar READMEs, comentarios inline y entradas de changelog basándose en código y notas de commits. Esto puede acelerar la claridad, pero también puede generar inexactitudes con tono de certeza.

Mejor práctica: usa la IA para estructura y redacción, y luego verifica cada afirmación—especialmente pasos de setup, valores por defecto y casos límite.

Generación básica de pruebas como punto de partida

Para funciones puras y bien especificadas, las pruebas unitarias generadas por IA pueden proporcionar cobertura inicial y recordarte casos límite. El guardarraíl es la propiedad: tú eliges qué importa, añades aserciones que reflejen requisitos reales y aseguras que las pruebas fallen por las razones correctas.

Resúmenes de hilos y logs

Cuando tienes hilos largos de Slack, tickets o registros de incidentes, la IA puede convertirlos en notas concisas y acciones. Manténlo anclado proporcionando todo el contexto y luego verifica hechos clave, timestamps y decisiones antes de compartir.

Trabajo que la IA principalmente aumenta: más rápido, no terminado

Los asistentes de programación con IA rinden mejor cuando ya sabes lo que quieres y necesitas ayuda para avanzar más rápido. Pueden reducir el tiempo dedicado a “teclear” y sacar contexto útil, pero no eliminan la necesidad de propiedad, verificación y juicio.

Acelerar la implementación (una primera pasada sólida)

Dado un spec claro—entradas, salidas, casos límite y restricciones—la IA puede redactar una implementación inicial razonable: boilerplate, mapeo de datos, handlers de API, migraciones o un refactor directo. La ganancia es momentum: obtienes algo ejecutable rápidamente.

La pega es que el código de primera pasada a menudo pasa por alto requisitos sutiles (semántica de errores, restricciones de rendimiento, compatibilidad hacia atrás). Trátalo como el borrador de un interno: útil, pero no autoritativo.

Proponer opciones—con compensaciones que debes validar

Cuando eliges entre enfoques (p. ej., caché vs. batching, locking optimista vs. pesimista), la IA puede proponer alternativas y listar compensaciones. Esto es valioso para la lluvia de ideas, pero las compensaciones deben comprobarse contra la realidad de tu sistema: forma del tráfico, necesidades de consistencia, restricciones operativas y convenciones del equipo.

Comprensión de código y navegación por la base de código

La IA también es buena explicando código desconocido, señalando patrones y traduciendo “¿qué hace esto?” a lenguaje llano. Junto con herramientas de búsqueda, puede ayudar a responder “¿Dónde se usa X?” y generar una lista de impacto de sitios de llamada, configs y pruebas a revisar.

Ergonomía del desarrollador: mejores bucles de retroalimentación

Espera mejoras prácticas de calidad de vida: mensajes de error más claros, pequeños ejemplos y snippets listos para pegar. Reducen fricción, pero no sustituyen revisiones cuidadosas, ejecuciones locales y pruebas dirigidas—especialmente para cambios que afectan a usuarios o sistemas en producción.

Comprensión del producto y requisitos: aún liderado por humanos

La IA puede ayudarte a redactar y refinar requisitos, pero no puede decidir de forma fiable qué deberíamos construir o por qué importa. La comprensión del producto está arraigada en contexto: objetivos de negocio, dolor del usuario, restricciones organizativas, casos límite y el coste de equivocarse. Esas entradas viven en conversaciones, historia y rendición de cuentas—cosas que un modelo puede resumir, pero no poseer.

Convertir objetivos vagos en algo construible

Las peticiones iniciales suelen sonar como “mejorar el onboarding” o “reducir tickets de soporte”. El trabajo del desarrollador es traducir eso en requisitos claros y criterios de aceptación.

Esa traducción es mayormente trabajo humano porque depende de preguntas de sondeo y juicio:

- ¿Qué segmento de usuarios optimizamos y qué comportamiento debe cambiar?

- ¿Qué cuenta como “hecho” y cómo lo mediremos?

- ¿Qué restricciones son innegociables (privacidad, rendimiento, plazos)?

La IA puede sugerir métricas o redactar criterios de aceptación, pero no sabrá qué restricciones son reales a menos que alguien las proporcione—y no hará pushback cuando una petición sea auto-contradictoria.

Compensaciones y gestión de expectativas

El trabajo de requisitos es donde emergen compensaciones incómodas: tiempo vs. calidad, velocidad vs. mantenibilidad, nuevas funciones vs. estabilidad. Los equipos necesitan a una persona que haga explícitos los riesgos, proponga opciones y alinee a los stakeholders sobre las consecuencias.

Un buen spec no es solo texto; es un registro de decisiones. Debe ser comprobable e implementable, con definiciones precisas (entradas, salidas, casos límite y modos de fallo). La IA puede ayudar a estructurar el documento, pero la responsabilidad de la corrección—y de decir “esto es ambiguo, necesitamos una decisión”—sigue siendo humana.

Diseño de sistemas y decisiones de arquitectura

El diseño de sistemas es donde “qué debemos construir” se convierte en “sobre qué lo construimos y qué pasará cuando las cosas fallen”. La IA puede ayudarte a explorar opciones, pero no puede asumir las consecuencias.

Elegir una arquitectura que encaje con la realidad

Escoger entre monolito, monolito modular, microservicios, serverless o plataformas gestionadas no es un examen con una única respuesta correcta. Es un problema de ajuste: escala esperada, límites de presupuesto, time-to-market y habilidades del equipo.

Un asistente puede resumir patrones y sugerir arquitecturas de referencia, pero no sabrá que tu equipo rota el on-call semanalmente, que contratar es lento o que el contrato del proveedor de base de datos vence el próximo trimestre. Esos detalles a menudo deciden si una arquitectura tiene éxito.

Hacer las compensaciones explícitas

Buena arquitectura son mayormente compensaciones: simplicidad vs. flexibilidad, rendimiento vs. coste, velocidad hoy vs. mantenibilidad después. La IA puede producir listas de pros/cons rápidamente, lo cual es útil—especialmente para documentar decisiones.

Lo que no puede hacer es fijar prioridades cuando las compensaciones duelen. Por ejemplo, “aceptamos respuestas ligeramente más lentas para mantener el sistema más simple y operable” es una elección de negocio, no puramente técnica.

Límites, propiedad de datos y modos de fallo

Definir fronteras de servicio, quién posee qué datos y qué pasa durante fallos parciales requiere contexto operativo y de producto profundo. La IA puede ayudar a idear modos de fallo (“¿qué pasa si el proveedor de pagos cae?”), pero necesitas humanos para decidir el comportamiento esperado, el mensaje al cliente y el plan de rollback.

APIs que se mantengan usables

Diseñar APIs es diseñar un contrato. La IA puede generar ejemplos y detectar inconsistencias, pero debes decidir versionado, compatibilidad hacia atrás y qué estás dispuesto a soportar a largo plazo.

Decidir cuándo no construir (o cuándo borrar)

Quizá la decisión arquitectónica más importante es decir “no”—o borrar una función. La IA no puede medir el coste de oportunidad ni el riesgo político. Los equipos sí, y deberían hacerlo.

Depuración y análisis de la causa raíz en la práctica

La depuración es donde la IA a menudo impresiona—y donde puede desperdiciar más tiempo en silencio. Un asistente puede escanear logs, señalar rutas de código sospechosas o sugerir una corrección que “parece correcta”. Pero el análisis de causa raíz no es solo generar explicaciones; es demostrar una.

La IA puede sugerir; tú confirmas la causa raíz

Trata la salida de la IA como hipótesis, no como conclusión. Muchos bugs tienen múltiples causas plausibles, y la IA tiende a escoger una historia ordenada que encaje con el fragmento de código que pegaste, no con la realidad del sistema en ejecución.

Un flujo de trabajo práctico es:

- Pedir a la IA posibles causas y qué evidencia las distinguiría.

- Reproducir el problema y recoger esa evidencia.

- Solo entonces aceptar una solución (y verificar que realmente elimina la condición de fallo).

Reproducción y recolección de evidencia siguen siendo lideradas por humanos

Reproducir de forma fiable es una superpotencia de depuración porque convierte un misterio en una prueba. La IA puede ayudarte a escribir un repro mínimo, redactar un script diagnóstico o proponer logging adicional, pero tú decides qué señales importan: IDs de petición, tiempos, diferencias de entorno, feature flags, forma de los datos o concurrencia.

Cuando los usuarios reportan síntomas (“la app se congeló”), todavía necesitas traducir eso a comportamiento del sistema: qué endpoint se atascó, qué timeouts saltaron, qué señales del error-budget cambiaron. Eso requiere contexto: cómo se usa el producto y qué es “normal”.

Evitar explicaciones “plausibles pero equivocadas”

Si una sugerencia no se puede validar, asume que está equivocada hasta probar lo contrario. Prefiere explicaciones que hagan una predicción comprobable (p. ej., “esto solo ocurrirá con payloads grandes” o “solo después del calentamiento de cache”).

Parchear, revertir o rediseñar?

Incluso después de encontrar la causa, queda la decisión difícil. La IA puede bosquejar compensaciones, pero los humanos eligen la respuesta:

- Parche rápido para detener el sangrado.

- Revertir para restaurar comportamiento conocido bueno.

- Rediseñar si el fallo revela un desajuste más profundo (rendimiento, modelo de datos o supuestos).

El análisis de causa raíz es, en última instancia, responsabilidad: asumir la explicación, la solución y la confianza de que no volverá.

Revisión de código: el juicio y los estándares no se automatizan

La revisión de código no es solo una lista de comprobación para estilo. Es el momento en que el equipo decide qué está dispuesto a mantener, soportar y por lo que será responsable. La IA puede ayudarte a ver más, pero no puede decidir qué importa, qué encaja con la intención del producto o qué compensaciones acepta tu equipo.

En qué es buena la IA en revisiones

Los asistentes pueden actuar como un segundo par de ojos incansable. Pueden rápidamente:

- Señalar bugs probables, patrones sospechosos, chequeos nulos faltantes o manejo inseguro de strings.

- Sugerir nombres más claros, refactors o un flujo de control más simple.

- Detectar formateo inconsistente o duplicación obvia.

- Generar preguntas de revisión (“¿Qué pasa si esta API devuelve una lista vacía?”).

Usada así, la IA acorta el tiempo entre “abrí el PR” y “noté el riesgo”.

Qué requiere todavía juicio humano

Revisar la corrección no es solo si el código compila. Los humanos conectan los cambios con el comportamiento real del usuario, las restricciones de producción y el mantenimiento a largo plazo.

Un revisor aún necesita decidir:

- Qué enviar: la IA puede listar problemas, pero no elegir cuáles son bloqueantes.

- Legibilidad y mantenimiento: el código “técnicamente correcto” puede ser confuso, frágil o difícil de extender.

- Casos límite y diferencias de entorno: muchos fallos son “funciona en mi máquina”—configuración, peculiaridades de datos, concurrencia o timing de despliegue. La IA no puede inferir tu realidad de ejecución.

- Estándares e intención: solo el equipo conoce sus convenciones y tolerancia al riesgo. Un cambio puede ser código limpio y aun así ser el comportamiento equivocado.

Un flujo práctico: la IA como co-revisor

Trata la IA como un segundo revisor, no como aprobador final. Pídele una pasada dirigida (chequeos de seguridad, casos límite, compatibilidad hacia atrás) y luego toma la decisión humana sobre alcance, prioridad y si el cambio se alinea con estándares del equipo e intención del producto.

Estrategia de pruebas y propiedad de la calidad

Los asistentes con IA pueden generar pruebas rápidamente, pero no poseen la calidad. Una suite de pruebas es un conjunto de apuestas sobre qué puede romperse, qué nunca debe romperse y qué estás dispuesto a enviar sin probar cada caso límite. Esas apuestas son decisiones de producto e ingeniería—todavía tomadas por personas.

La IA puede redactar pruebas; los humanos fijan los objetivos

Los asistentes son buenos generando esqueleto de pruebas unitarias, mockeando dependencias y cubriendo comportamientos “happy path” desde una implementación. Lo que no hacen con fiabilidad es decidir qué cobertura importa.

Los humanos definen:

- Qué módulos necesitan cobertura profunda porque son críticos o cambian con frecuencia.

- Qué significa “hecho” para un refactor arriesgado vs. una corrección pequeña.

- Cuándo invertir en pruebas de regresión vs. monitoreo y planes de rollback.

Elegir la mezcla correcta de tipos de prueba

La mayoría de los equipos necesitan una estrategia por capas, no “más pruebas”. La IA puede ayudar a escribir muchas de estas, pero la selección y los límites son liderados por humanos:

- Pruebas unitarias para reglas de negocio y casos límite complejos.

- Pruebas de integración para interacciones con BD/colas/servicios.

- Pruebas end-to-end para recorridos críticos de usuario (pocas, estables, de alto valor).

- Pruebas de contrato para mantener compatibilidad entre equipos/servicios.

- Pruebas de rendimiento para proteger latencia y coste bajo carga.

Evitar tests inestables y falsa confianza

Las pruebas generadas por IA suelen reflejar demasiado el código, creando aserciones frágiles o setups sobre-mockeados que pasan aunque el comportamiento real falle. Los desarrolladores evitan eso mediante:

- Probar comportamiento observable, no detalles internos de implementación.

- Mantener datos deterministas y controlar tiempo, aleatoriedad y llamadas de red.

- Revisar fallos para decidir: bug real, bug de prueba o problema de entorno.

Alinear la estrategia con riesgo y cadencia de despliegue

Una buena estrategia coincide con cómo envías cambios. Lanzamientos más rápidos requieren comprobaciones automáticas más fuertes y caminos de rollback claros; lanzamientos más lentos pueden permitirse validación pre-merge más pesada. El propietario de la calidad es el equipo, no la herramienta.

Medir los resultados que importan

La calidad no es un porcentaje de cobertura. Mide si las pruebas mejoran resultados: menos incidentes en producción, recuperación más rápida y cambios más seguros (reverts más pequeños, despliegues con más confianza). La IA puede acelerar el trabajo, pero la responsabilidad queda en los desarrolladores.

Seguridad, privacidad y cumplimiento

El trabajo de seguridad es menos sobre generar código y más sobre tomar compensaciones bajo restricciones reales. La IA puede sacar listas de control y errores comunes, pero la decisión de riesgo queda en el equipo.

El modelado de amenazas necesita contexto

El modelado de amenazas no es un ejercicio genérico—lo que importa depende de prioridades de negocio, usuarios y modos de fallo. Un asistente puede sugerir amenazas típicas (inyección, auth rota, configuraciones inseguras), pero no sabrá qué es realmente costoso para tu producto: suplantación de cuentas vs. fuga de datos vs. interrupción del servicio, ni qué activos son legalmente sensibles.

Riesgos específicos de la app no son patrones genéricos

La IA reconoce antipatróns conocidos, pero muchos incidentes vienen de detalles específicos de la app: un caso límite de permisos, un endpoint admin “temporal” o un flujo que accidentalmente elude aprobaciones. Esos riesgos requieren leer la intención del sistema, no solo el código.

Secretos, permisos y retención son decisiones intencionales

Las herramientas pueden recordarte que no hardcodees claves, pero no pueden poseer la política completa:

- Dónde viven los secretos (vault, CI, runtime) y cómo rotan.

- Roles de mínimo privilegio y revisiones de acceso.

- Retención de datos: qué guardas, cuánto y quién puede exportarlo.

Dependencias y riesgo de la cadena de suministro

La IA puede marcar librerías desactualizadas, pero los equipos necesitan prácticas: fijar versiones, verificar procedencia, revisar dependencias transitivas y decidir cuándo aceptar riesgo vs. invertir en remediación.

Cumplimiento y auditorías requieren evidencia

Cumplimiento no es “añadir cifrado”. Son controles, documentación y rendición de cuentas: logs de acceso, rastro de aprobaciones, procedimientos de incidentes y prueba de que los seguiste. La IA puede generar plantillas, pero los humanos deben validar la evidencia y firmar—porque eso es lo que miran auditores (y clientes).

Operaciones, fiabilidad y respuesta a incidentes

La IA puede hacer el trabajo de ops más rápido, pero no asume la propiedad. La fiabilidad es una cadena de decisiones bajo incertidumbre, y el coste de una mala decisión suele ser mayor que el de una decisión lenta.

Dónde ayuda la IA en el día a día

La IA es útil para redactar y mantener artefactos operativos—runbooks, checklists y playbooks “si X entonces Y”. También puede resumir logs, agrupar alertas similares y proponer hipótesis iniciales.

Para trabajo de fiabilidad, eso se traduce en iteración más rápida sobre:

- dashboards de monitorización y descripciones de alertas.

- notas de capacidad y heurísticas de escalado.

- plantillas de reporting de error budget.

Son grandes aceleradores, pero no son el trabajo en sí.

Las partes que siguen siendo humanas

Los incidentes rara vez siguen el guion. Los ingenieros on-call tratan señales poco claras, fallos parciales y compensaciones desordenadas mientras corre el reloj. La IA puede sugerir causas probables, pero no puede decidir con fiabilidad si avisar a otro equipo, deshabilitar una función o aceptar impacto al cliente para preservar integridad de datos.

La seguridad del despliegue es otra responsabilidad humana. Las herramientas pueden recomendar rollbacks, feature flags o despliegues graduales, pero los equipos deben escoger la ruta más segura según el contexto del negocio y el radio de blast.

Postmortems: aprender es el objetivo

La IA puede redactar cronologías y extraer eventos clave de chat, tickets y monitorización. Los humanos siguen haciendo las partes críticas: decidir qué es “bueno”, priorizar correcciones y hacer cambios que prevengan repeticiones (no solo el mismo síntoma).

Si tratas a la IA como copiloto para papeleo operativo y búsqueda de patrones—no como un comandante de incidentes—ganarás velocidad sin renunciar a la responsabilidad.

Comunicación de equipo, mentoría y propiedad

La IA puede explicar conceptos con claridad y bajo demanda: “¿Qué es CQRS?”, “¿Por qué ocurre este deadlock?”, “Resume este PR.” Eso ayuda a que los equipos avancen más rápido. Pero la comunicación en el trabajo no es solo transferir información: es construir confianza, establecer hábitos compartidos y asumir compromisos en los que la gente confía.

Onboarding: más que documentación

Los desarrolladores nuevos no solo necesitan respuestas; necesitan contexto y relaciones. La IA puede ayudar resumiendo módulos, sugiriendo rutas de lectura y traduciendo jerga. Los humanos siguen enseñando qué importa aquí: qué compensaciones prefiere el equipo, qué es “bueno” en esta base de código y con quién hablar cuando algo suena raro.

Alineación entre roles

La fricción de proyecto suele aparecer entre roles: producto, diseño, QA, seguridad, soporte. La IA puede redactar notas de reunión, proponer criterios de aceptación o reformular feedback con un tono más neutro. Las personas aún deben negociar prioridades, resolver ambigüedades y notar cuando un stakeholder “acepta” sin realmente aceptar.

Definición de hecho y límites de propiedad

Los equipos fallan cuando la responsabilidad es difusa. La IA puede generar checklists, pero no puede imponer responsabilidad. Los humanos deben definir qué significa “hecho” (pruebas? docs? plan de rollout? monitorización?), y quién es responsable después del merge—especialmente cuando el código generado por IA oculta complejidad.

Checklist: IA responsable en los flujos de trabajo del equipo

- Revela el uso de IA cuando afecta decisiones, estimaciones o código redactado.

- Verifica hechos: links, APIs, afirmaciones de seguridad y “mejores prácticas” antes de compartir.

- Mantén los prompts libres de secretos (claves, datos de clientes, detalles de incidentes).

- Trata las salidas de la IA como borradores; asigna un propietario humano para cada decisión.

- Escribe normas de equipo: cuándo se permite IA, cuándo no, y revisar expectativas.

- Prefiere cambios pequeños y revisables—evita refactors masivos “a la IA”.