Empieza por el problema: ¿Qué trabajo manual estás rastreando?

Antes de dibujar pantallas o elegir una base de datos, aclara qué intentas medir. El objetivo no es “rastrear todo lo que hacen los empleados”. Es capturar trabajo manual con suficiente fiabilidad para decidir qué automatizar primero—basado en evidencia, no en opiniones.

Define el trabajo manual en términos simples

Anota las actividades recurrentes que ahora se hacen a mano (copiar/pegar entre sistemas, volver a introducir datos, revisar documentos, perseguir aprobaciones, conciliar hojas de cálculo). Para cada actividad, describe:

- Qué la desencadena (una nueva orden, un correo, una fecha límite semanal)

- Cómo se ve “hecho” (enviado, verificado, pagado, enviado)

- Dónde sucede (qué herramientas, carpetas, bandejas de entrada)

Si no puedes describirlo en dos frases, probablemente estás mezclando varios flujos de trabajo.

Identifica a los usuarios objetivo (y sus incentivos)

Una app de rastreo tiene éxito cuando sirve a todos los que tocan el trabajo—no solo a quien quiere el informe.

- Operadores / personal de primera línea: necesitan registro rápido con mínima interrupción.

- Líderes de equipo: necesitan visibilidad de cuellos de botella y excepciones.

- Gerentes: necesitan señales para priorizar automatización y dotación.

- Finanzas: necesita números creíbles para coste, ROI y presupuestos.

- TI / equipo de automatización: necesita entradas limpias para construir automatizaciones con seguridad.

Espera motivaciones diferentes: los operadores quieren menos trabajo administrativo; los gerentes quieren predictibilidad; TI quiere requisitos estables.

Decide qué resultados medirás

Rastrear solo es útil si se conecta con resultados. Elige un conjunto pequeño que puedas calcular de forma consistente:

- Tiempo ahorrado: minutos manuales base por tarea, luego comparar tras cambios.

- Errores reducidos: recuentos de retrabajo, correcciones, comprobaciones fallidas.

- Tiempo de respuesta: desde el disparador hasta la finalización, incluyendo estados de espera.

- Cumplimiento / auditabilidad: evidencia de que se siguieron los pasos requeridos (quién, qué, cuándo).

Aclara qué no es la app

Define límites pronto para evitar construir un monstruo accidental.

Esta app normalmente no es:

- Un reemplazo completo de ERP

- Un sistema de tickets integral

- Una herramienta de vigilancia de la plantilla

Puede complementar esos sistemas—y a veces reemplazar una parte estrecha—si esa es tu intención explícita. Si ya usas tickets, tu app de rastreo podría simplemente adjuntar datos estructurados de “esfuerzo manual” a los ítems existentes (ver /blog/integrations).

Elige los flujos y fija un alcance claro

Una app de rastreo gana o pierde por su foco. Si intentas capturar cada “cosa ocupada” que la gente hace, recogerás datos ruidosos, frustrarás a los usuarios y aun así no sabrás qué automatizar primero. Empieza con un alcance pequeño y explícito que se pueda medir con consistencia.

Elige los primeros 3–5 flujos

Selecciona flujos comunes, repetibles y ya dolorosos. Un buen conjunto de inicio suele cubrir distintos tipos de esfuerzo manual, por ejemplo:

- Copiar/pegar entre sistemas (p. ej., CRM → hoja de cálculo → correo)

- Entrada y reformateo de datos (p. ej., facturas, actualizaciones de cliente)

- Aprobaciones (p. ej., descuentos, reembolsos, solicitudes de acceso)

- Conciliaciones (p. ej., emparejar pagos, comprobaciones de inventario)

- Informes (p. ej., actualizaciones semanales armadas a mano)

Define qué cuenta como “trabajo manual”

Escribe una definición simple que todos puedan aplicar de la misma forma. Por ejemplo: “Cualquier paso en el que una persona mueve, comprueba o transforma información sin que un sistema lo haga automáticamente.” Incluye ejemplos y algunas exclusiones (p. ej., llamadas con clientes, escritura creativa, gestión de relaciones) para que la gente no registre todo.

Establece límites que eviten la expansión del alcance

Sé explícito sobre dónde empieza y termina el flujo:

- Departamentos/equipos incluidos (y excluidos)

- Regiones y canales (teléfono, correo, presencial)

- Sistemas involucrados (y cualquier sistema que no integrarás todavía)

Acuerda una ventana de medición

Decide cómo se registrará el tiempo: por tarea, por turno o por semana. “Por tarea” da la mejor señal para automatizar, pero “por turno/semana” puede ser un MVP práctico si las tareas están demasiado fragmentadas. Lo clave es la consistencia, no la precisión.

Mapea el proceso actual antes de diseñar nada

Antes de elegir campos, pantallas o paneles, consigue una imagen clara de cómo ocurre el trabajo hoy. Un mapa ligero descubrirá qué debes rastrear y qué puedes ignorar.

Construye un mapa de flujo simple

Empieza con un flujo único y escríbelo en línea recta:

Disparador → pasos → entregas → resultado

Sé concreto. “La solicitud llega a una bandeja compartida” es mejor que “La entrada ocurre”. Para cada paso, anota quién lo hace, qué herramienta usa y qué significa “hecho”. Si hay entregas (de Sales a Ops, de Ops a Finanzas), destácalas explícitamente—las entregas son donde el trabajo desaparece.

Captura dónde ocurren demoras y retrabajo

Tu app de rastreo debe resaltar la fricción, no solo la actividad. Al mapear el flujo, marca:

- Espera por información faltante (detalles del cliente, adjuntos, confirmación)

- Aprobaciones (quién aprueba, cuánto suele tardar, qué se rechaza)

- Restricciones de acceso al sistema (permisos, colas, límites de tasa)

- Bucles de retrabajo (tarea vuelve a un paso anterior)

Estos puntos de demora se convertirán en campos de alto valor (por ejemplo, “razón de bloqueo”) y en candidatos prioritarios para automatizar.

Identifica las fuentes de verdad

Lista los sistemas en los que la gente confía para completar el trabajo: hilos de correo, hojas de cálculo, herramientas de tickets, unidades compartidas, apps legacy, mensajes de chat. Cuando múltiples fuentes no coinciden, anota cuál “gana”. Esto es esencial para futuras integraciones y para evitar duplicar la entrada de datos.

Documenta variabilidad y excepciones

La mayor parte del trabajo manual es desordenado. Anota las razones comunes por las que las tareas se desvían: términos especiales de cliente, documentos faltantes, reglas regionales, aprobaciones puntuales. No intentas modelar todos los casos límite—solo registra las categorías que explican por qué una tarea tardó más o requirió pasos adicionales.

Diseña los datos que necesitas capturar (sin exceso)

Un rastreador de trabajo manual gana o pierde por una cosa: si la gente puede registrar trabajo rápidamente generando al mismo tiempo datos accionables. El objetivo no es “recoger todo”. Es capturar la estructura mínima para detectar patrones, cuantificar impacto y convertir dolor repetido en candidatos de automatización.

Empieza con un conjunto pequeño y reutilizable de entidades

Mantén tu modelo de datos central simple y consistente entre equipos:

- Work Item: la cosa que se procesa (orden, solicitud, ticket, reclamo). Incluye un ID de referencia externo si existe.

- Process y : dónde está el trabajo (p. ej., “Reembolsos” → “Validar recibo”). Los pasos te ayudan a sacar a la luz cuellos de botella sin analítica compleja.

Esta estructura soporta tanto el registro diario como el análisis posterior sin obligar a los usuarios a responder un cuestionario largo.

El tiempo es esencial para priorizar automatizaciones, pero debe ser fácil:

- Temporizador inicio/parada para quienes hacen trabajo enfocado.

- Entrada manual cuando las tareas ocurren en ráfagas cortas.

- Ediciones por lotes para acciones repetitivas (“Hice esto 12 veces hoy”).

Si el tiempo se siente “vigilado”, la adopción cae. Preséntalo como una forma de eliminar trabajo administrativo, no de controlar a las personas.

Captura el “por qué manual” con categorías ligeras

Añade un campo obligatorio que explique por qué el trabajo no fue automatizado:

- Falta de integración

- Requisito de política/cumplimiento

- Reglas poco claras/casos límite

- Limitaciones de herramienta o mala UX

Usa un dropdown corto más una nota opcional. El dropdown permite informes; la nota da contexto para excepciones.

Almacena resultados estructurados (para que los logs sean accionables)

Cada Task debería terminar con algunos resultados consistentes:

- Estado (completado, bloqueado, escalado)

- Tipo de error (si aplica)

- Conteo de retrabajo (0, 1, 2+)

- Notas de finalización (breves, opcionales)

Con estos campos puedes cuantificar desperdicio (retrabaJo), identificar modos de fallo (tipos de error) y construir un backlog de automatización creíble a partir de trabajo real—no opiniones.

Si registrar un work item se siente más lento que hacer el trabajo, la gente lo omitirá—o introducirá datos vagos que no sirven. La meta de UX es simple: capturar el detalle mínimo útil con la menor fricción.

Pantallas imprescindibles (mantenlas simples)

Comienza con un conjunto pequeño de pantallas que cubran el ciclo completo:

- Intake de tarea: forma rápida para añadir trabajo (entrada manual o “crear desde plantilla”).

- Cola de trabajo: lista priorizada con filtros (nuevo, en progreso, bloqueado, hecho).

- Detalle del work item: contexto, estado, notas y una “siguiente acción” clara.

- Captura de tiempo/evidencia: temporizador inicio/parada, entrada rápida de duración, adjuntar archivos o pegar enlaces.

- Informes: vista ligera de volumen, tiempo gastado y principales razones/resultados.

Hazlo rápido: menos clics, más flujo

Diseña para velocidad más que para completitud. Usa atajos de teclado para acciones comunes (crear item, cambiar estado, guardar). Proporciona plantillas para trabajo repetido para que los usuarios no reescriban las mismas descripciones y pasos.

Cuando sea posible, usa edición en sitio y valores por defecto sensatos (p. ej., asignar automáticamente al usuario actual, establecer “iniciado en” cuando abran un item).

Campos guiados que estandarizan los datos

El texto libre es útil, pero no se agrega bien. Añade campos guiados que hagan el reporting fiable:

- Dropdowns para razón, resultado, tipo de error y canal (correo/chat/teléfono).

- Campos obligatorios solo cuando evitan ambigüedad—no “porque podemos”.

Fundamentos de accesibilidad que no debes saltarte

Haz la app legible y usable para todos: alto contraste, etiquetas claras (no solo placeholders), estados de foco visibles para navegación por teclado y diseños móviles para registro rápido en movimiento.

Permisos, aprobaciones y auditabilidad

Si tu app guía decisiones de automatización, la gente debe confiar en los datos. Esa confianza se rompe cuando cualquiera puede editar todo, las aprobaciones no están claras o no hay rastro de cambios. Un modelo de permisos simple más una traza de auditoría ligera resuelven la mayoría de los problemas.

Define roles claros (y mantenlos simples)

Comienza con cuatro roles que mapeen cómo se registra el trabajo:

- Contributor: registra trabajo (tiempo, pasos, evidencia) y edita sus borradores.

- Reviewer/Approver: valida entradas, pide aclaraciones, aprueba o rechaza.

- Manager: ve la actividad del equipo, resuelve disputas y puede anular aprobaciones cuando hace falta.

- Admin: configura workflows, permisos, retención e integraciones.

Evita reglas personalizadas por usuario al principio; el acceso por roles es más fácil de explicar y mantener.

Reglas de edición tras la presentación

Decide qué campos son “hechos” frente a “notas” y bloquea los hechos una vez revisados.

Un enfoque práctico:

- Los contributors pueden editar borradores libremente.

- Tras la presentación, los contributors solo pueden editar campos no críticos (p. ej., descripción) hasta que empiece la revisión.

- Después de la aprobación, las ediciones de entradas de tiempo, estado del workflow, coste o evidencia adjunta deberían limitarse a reviewers/managers y, idealmente, requerir un motivo.

Esto mantiene los informes estables y permite correcciones legítimas.

Traza de auditoría que responda “¿quién cambió qué?”

Añade un registro de actividad para eventos clave: cambios de estado, ajustes de tiempo, aprobaciones/rechazos, evidencia añadida/eliminada y cambios de permisos. Guarda al menos: actor, marca temporal, valor antiguo, valor nuevo y (opcional) un comentario corto.

Hazlo visible en cada registro (por ejemplo, una pestaña “Actividad”) para que las disputas no se conviertan en arqueología de Slack.

Retención y manejo de evidencia

Define reglas de retención pronto: cuánto tiempo conservar logs y evidencias relacionadas (imágenes, archivos, enlaces). Muchos equipos usan 12–24 meses para logs y menos para adjuntos voluminosos.

Si permites subidas, trátalas como parte de la historia de auditoría: versiona archivos, registra eliminaciones y restringe el acceso por rol. Esto importa cuando una entrada se convierte en base para un proyecto de automatización.

Arquitectura técnica para un MVP práctico

Un MVP práctico debe ser fácil de construir, fácil de cambiar y aburrido de operar. El objetivo no es predecir tu plataforma futura de automatización—es capturar evidencia de trabajo manual con mínima fricción.

Una base simple y escalable

Empieza con una distribución sencilla:

- Cliente web (UI en navegador)

- API (lógica de negocio + validación)

- Base de datos (registros estructurados)

- Almacenamiento de archivos (capturas, PDFs, correos exportados como archivos)

Esta separación mantiene la UI rápida de iterar mientras la API sigue siendo la fuente de la verdad.

Elige componentes probados

Escoge un stack que tu equipo pueda lanzar rápido con buena comunidad. Combinaciones comunes:

- Frontend: React o Vue

- Backend: Node (Express/Nest), Django o Rails

- Base de datos: Postgres

- Almacenamiento de archivos: almacenamiento compatible con S3 (o equivalente gestionado)

Evita tecnologías exóticas temprano—tu mayor riesgo es la incertidumbre del producto, no el rendimiento.

Si quieres acelerar el MVP sin encerrarte, una plataforma de tipo "vibe-coding" como Koder.ai puede ayudarte a pasar de una especificación escrita a una app React con API en Go y PostgreSQL—vía chat—manteniendo la opción de exportar el código fuente, desplegar/hostear y revertir con snapshots. Eso es útil para herramientas internas donde los requisitos cambian después del primer piloto.

Define la API alrededor de acciones de usuario

Diseña endpoints que reflejen lo que los usuarios hacen, no cómo se ven tus tablas. Capacidades típicas “en forma de verbo”:

- Crear un work item (task/case)

- Registrar tiempo (inicio/parada o duración + notas)

- Adjuntar evidencia (subida de archivo + descripción corta)

- Cambiar estado (p. ej., New → In Progress → Done)

Esto facilita soportar futuros clientes (móvil, integraciones) sin reescribir el núcleo.

POST /work-items

POST /work-items/{id}/time-logs

POST /work-items/{id}/attachments

POST /work-items/{id}/status

GET /work-items?assignee=me\u0026status=in_progress

Planifica importación/exportación CSV desde el día uno

Incluso los primeros usuarios preguntarán: “¿Puedo subir lo que ya tengo?” y “¿Puedo sacar mis datos?”. Añade:

- Importación CSV para migración inicial o creación masiva

- Exportación CSV para reporting, auditorías y confianza

Reduce la reentrada, acelera el onboarding y evita que tu MVP parezca una herramienta sin salida.

Integraciones que reducen el esfuerzo de registro

Si tu app depende de que la gente recuerde registrar todo, la adopción decaerá. Un enfoque práctico es empezar por la entrada manual (para que el flujo esté claro) y luego añadir conectores solo donde realmente quitan esfuerzo—especialmente para trabajo de alto volumen y repetitivo.

Dónde las integraciones ayudan más

Busca pasos donde la gente ya deja rastro en otro sitio. Integraciones de “baja fricción” comunes incluyen:

- Ingesta de correo: reenviar mensajes a una dirección especial para crear o actualizar un work item.

- Hojas de cálculo: importar filas (o sincronizar) desde la hoja que los equipos ya mantienen.

- Notificaciones Slack/Teams: avisos rápidos (“registra el resultado”) y actualizaciones de estado cuando un item se aprueba o reasigna.

- Webhooks: recibir eventos de otras herramientas (envío de formularios, actualizaciones de tickets, fallos de pago) para crear un borrador automáticamente.

Usa identificadores únicos para conectar puntos

Las integraciones se complican si no puedes emparejar items entre sistemas. Crea un identificador único (p. ej., MW-10482) y guarda IDs externos junto a él (ID de mensaje de correo, clave de fila de hoja de cálculo, ID de ticket). Muestra ese identificador en notificaciones y exportaciones para que la gente pueda referenciar el mismo item en todos lados.

Diseña para automatización parcial (no todo o nada)

El objetivo no es eliminar humanos de inmediato—es reducir escritura y evitar retrabajo.

Prellena campos desde integraciones (solicitante, asunto, marcas temporales, adjuntos), pero permite anulación humana para que el registro refleje la realidad. Por ejemplo, un correo puede sugerir una categoría y esfuerzo estimado, mientras la persona confirma el tiempo real y el resultado.

Una buena regla: las integraciones deberían crear borradores por defecto, y los humanos deberían “confirmar y enviar” hasta que confíes en el mapeo.

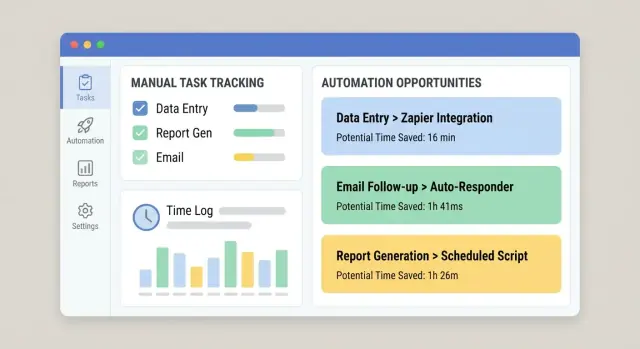

Convierte logs en un backlog de automatización

Rastrear trabajo manual solo vale si se traduce en decisiones. La meta de tu app debe ser convertir logs crudos en una lista priorizada de oportunidades de automatización—tu “backlog de automatización”—fácil de revisar en una reunión semanal de ops o mejora.

Crea criterios de puntuación que la gente confíe

Empieza con una puntuación simple y explicable para que los stakeholders vean por qué algo sube a la cima. Un conjunto práctico de criterios:

- Volumen: cuántas veces ocurre (por día/semana/mes)

- Tiempo por tarea: minutos medianos por finalización (no el máximo)

- Tasa de errores: con qué frecuencia hay retrabajo, correcciones o escalados

- Impacto de negocio: coste, impacto al cliente, riesgo de cumplimiento, incumplimiento de SLA

- Factibilidad: claridad de reglas, acceso a sistemas, estabilidad de entradas, número de excepciones

Muestra la puntuación junto a los números subyacentes para que no parezca una caja negra.

Genera un “backlog de automatización” desde la actividad real

Añade una vista dedicada que agrupe logs en “work items” repetibles (por ejemplo: “Actualizar dirección de cliente en Sistema A y confirmar en Sistema B”). Ordena automáticamente por puntuación y muestra:

- Tiempo total gastado (últimos 30/90 días)

- Tendencia de frecuencia

- Equipos/roles principales implicados

- Puntos de fallo comunes (donde los usuarios marcan “bloqueado” o “retrabaJo”)

Etiqueta patrones repetidos para hallar lo automatizable

Haz las etiquetas ligeras: tags de un clic como sistema, tipo_de_entrada y tipo_excepción. Con el tiempo, esto revela patrones estables (buenos para automatizar) frente a casos límite desordenados (mejor para formación o corrección de procesos).

Añade una estimación básica de ROI

Una estimación simple es suficiente:

ROI (tiempo) = (tiempo ahorrado × frecuencia) − suposición de mantenimiento

Para mantenimiento, usa una estimación fija de horas mensuales (p. ej., 2–6 h/mes) para que los equipos comparen oportunidades de forma consistente. Esto mantiene el backlog centrado en impacto, no en opiniones.

Los paneles solo son útiles si responden preguntas reales: “¿Dónde estamos gastando tiempo?” “¿Qué nos está frenando?” y “¿Realmente ayudó nuestro último cambio?” Diseña reportes alrededor de decisiones, no de gráficos de vanidad.

Empieza con vistas para líderes

A la mayoría de los líderes no les interesan todos los detalles—quieren señales claras. Una base práctica incluye:

- Horas gastadas en trabajo manual, desglosadas por equipo, workflow y categoría

- Procesos manuales principales (ordenados por tiempo total, frecuencia o ambos)

- Tiempo de ciclo (desde inicio hasta finalización) y dónde se espera el tiempo

- Retrabajo (items reabiertos, devueltos o editados tras la presentación)

Haz cada tarjeta clicable para que un líder pueda pasar del titular a qué lo está causando.

Muestra tendencias y comparaciones antes/después

Una semana puede engañar. Añade líneas de tendencia y filtros de fecha sencillos (últimos 7/30/90 días). Cuando cambies un flujo—por ejemplo, añadiendo una integración o simplificando un formulario—haz fácil comparar antes vs. después.

Un enfoque ligero: guarda un “marcador de cambio” (fecha y descripción) y muestra una línea vertical en los gráficos. Eso ayuda a conectar mejoras con intervenciones reales en lugar de suposiciones.

Evita métricas engañosas

Rastrear trabajo manual mezcla datos duros (timestamps, conteos) y entradas más blandas (tiempo estimado). Etiqueta métricas claramente:

- Medido: capturado automáticamente (inicio/fin, número de items)

- Reportado: introducido por usuarios (tiempo gastado, códigos de razón)

- Derivado: calculado (tiempo de ciclo, tasa de retrabajo)

Si el tiempo es estimado, indícalo en la UI. Mejor ser honesto que parecer preciso y estar equivocado.

Permite profundizar hasta los work items

Cada gráfico debería permitir “mostrar los registros”. El drill-down genera confianza y acelera la acción: los usuarios filtran por workflow, equipo y rango de fechas y luego abren los work items subyacentes para ver notas, entregas y bloqueos comunes.

Vincula los paneles a la vista de “backlog de automatización” para que los mayores sumideros de tiempo se conviertan en candidatos mientras el contexto sigue fresco.

Fundamentos de seguridad y fiabilidad

Si tu app captura cómo se hace el trabajo, reunirá rápido detalles sensibles: nombres de clientes, notas internas, adjuntos y “quién hizo qué cuándo”. Seguridad y fiabilidad no son extras—perderás confianza (y adopción) sin ellas.

Protege datos con mínimo privilegio

Empieza con acceso por roles que coincida con responsabilidades reales. La mayoría de usuarios solo deberían ver sus propios logs o los de su equipo. Limita poderes de admin a un grupo pequeño y separa “puede editar entradas” de “puede aprobar/exportar datos”.

Para subidas de archivos, asume que cada adjunto es no confiable:

- Escanea subidas (o utiliza un proveedor que lo haga).

- Almacena archivos en object storage privado, no en el filesystem del servidor web.

- Usa URLs firmadas de corta duración para descarga.

Defensas básicas de la app

No necesitas seguridad empresarial para lanzar un MVP, pero sí lo básico:

- Autenticación (SSO si es posible; si no, contraseña fuerte + MFA).

- Limitación de tasa en login y endpoints de escritura para reducir abuso.

- Validación de entrada en servidor para cada campo, especialmente texto libre e IDs.

- Backups regulares con procedimiento de restauración probado (un backup que no puedes restaurar no cuenta).

Logging útil (sin filtrar secretos)

Captura eventos del sistema para troubleshooting y auditoría: inicios de sesión, cambios de permisos, aprobaciones, trabajos de importación y integraciones fallidas. Mantén logs estructurados y buscables, pero no almacenes secretos—nunca escribas tokens API, contraseñas o contenidos completos de adjuntos en los logs. Redacta campos sensibles por defecto.

Preparación para cumplimiento (si aplica)

Si manejas PII, decide pronto:

- Reglas de retención (cuánto conservar logs y archivos).

- Flujos de exportación y eliminación para solicitudes de acceso.

- Dónde se almacena la data y quién puede acceder.

Estas decisiones afectan tu esquema, permisos y backups—es más fácil planificarlas ahora que adaptarlas después.

Plan de despliegue, adopción y mejora continua

Una app de rastreo gana o pierde por la adopción. Trata el despliegue como un lanzamiento de producto: empieza pequeño, mide comportamiento e itera rápido.

Empieza con un piloto enfocado

Pilota con un equipo—idealmente uno que ya sufra por trabajo manual y tenga un flujo claro. Mantén el alcance estrecho (uno o dos tipos de trabajo) para poder apoyar a los usuarios de cerca y ajustar la app sin afectar a toda la organización.

Durante el piloto, recoge feedback en el momento: un botón “Algo fue difícil” tras registrar y una reunión semanal de 15 minutos. Cuando la adopción se estabilice, expande al siguiente equipo con patrones de trabajo similares.

Define métricas de éxito temprano

Fija objetivos simples y visibles para que todos sepan qué es “bueno”:

- % de trabajo registrado (cobertura)

- Calidad de datos (p. ej., campos obligatorios completados, menos entradas “Otro”)

- Reducción de horas manuales (auto-reportadas o inferidas por menos tareas repetidas)

Muestra estos en un dashboard interno y revísalos con líderes de equipo.

Facilita aprender haciendo

Incluye guía en la app donde la gente se atasque:

- Ejemplos bajo cada campo (“Buena descripción: ‘Conciliar factura #1842’”)

- Tooltips para categorías y etiquetas

- Un onboarding corto la primera vez que alguien registra (2–3 pasos máx.)

Mantén la mejora continua (y visible)

Establece una cadencia de revisión (mensual funciona bien) para decidir qué automatizar y por qué. Usa los datos del log para priorizar: tareas de alta frecuencia + alto tiempo primero, con dueños claros y impacto esperado.

Cierra el ciclo mostrando resultados: “Porque registraste X, automatizamos Y.” Esa es la forma más rápida de mantener a la gente registrando.

Si iteras rápido entre equipos, considera herramientas que soporten cambios rápidos sin desestabilizar la app. Por ejemplo, el modo de planificación de Koder.ai te ayuda a esbozar alcance y flujos antes de generar cambios, y los snapshots/rollback hacen más seguro ajustar workflows, campos y permisos según aprendes del piloto.