Qué hace un sitio web de registro de experimentación de producto

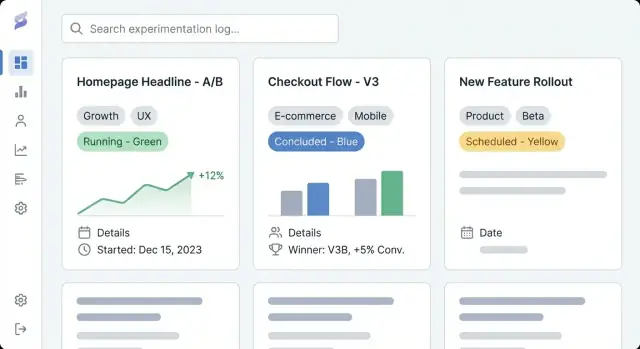

Un sitio web de registro de experimentación de producto es un lugar compartido para documentar cada experimento que ejecuta tu equipo: pruebas A/B, pruebas de precios, ajustes de onboarding, feature flags, experimentos de email e incluso ideas “fallidas” que aun así enseñaron algo. Piénsalo como un repositorio de experimentos y un registro de aprendizaje de producto combinado: un registro de lo que probaste, por qué lo probaste, qué pasó y qué decidiste después.

Por qué los equipos usan uno

La mayoría de los equipos ya tienen fragmentos de seguimiento de experimentos repartidos en documentos, paneles y hilos de chat. Un sitio dedicado de seguimiento de experimentos reúne esos artefactos en un historial navegable.

Los resultados prácticos son:

- Visibilidad: cualquiera puede ver rápidamente qué se está ejecutando ahora, qué se lanzó, qué se detuvo y qué está planificado—sin buscar por herramientas.

- Repetibilidad: los equipos pueden reutilizar plantillas de experimentos, evitar volver a probar la misma hipótesis y copiar métodos probados (segmentación, métricas, duración).

- Aprendizaje compartido: los resultados y el contexto permanecen disponibles mucho después de que termina un proyecto, para que nuevos compañeros entiendan decisiones pasadas y construyan sobre ellas.

Qué obtendrás con esta guía

Esta guía se centra en cómo construir un sitio web que haga que la documentación de experimentos sea fácil de crear y fácil de usar. Cubriremos cómo planear la estructura y navegación, definir un modelo de datos para las entradas de experimentos (para que las entradas sean consistentes), crear plantillas de página legibles, configurar el etiquetado y la búsqueda para descubrimiento rápido, y elegir el enfoque de implementación adecuado (CMS vs app personalizada).

Al final tendrás un plan claro para un sitio de documentación de pruebas A/B que soporte el trabajo diario de producto—capturando hipótesis, métricas e informes de resultados, y decisiones de manera buscable, fiable y útil con el tiempo.

Definir objetivos, audiencia y nivel de acceso

Antes de elegir herramientas o diseñar plantillas de experimentos, aclara por qué existe este sitio de seguimiento de experimentos y a quién sirve. Un registro de experimentación de producto solo es útil si coincide con cómo tus equipos realmente toman decisiones.

Establece objetivos claros (cómo se ve “bueno”)

Escribe 2–4 resultados medibles para el repositorio de experimentos. Definiciones de éxito comunes incluyen:

- Descubrimiento más rápido: la gente puede encontrar documentación relevante de pruebas A/B en minutos, no horas.

- Menos pruebas duplicadas: los equipos ven lo que ya se probó y evitan volver a ejecutar la misma idea.

- Mejores decisiones: métricas e informes de resultados más consistentes, con vínculos claros entre hipótesis, cambios y resultados.

Estos objetivos deberían influir en todo lo que venga después: qué campos exiges en cada entrada, cuán estricto es tu flujo de trabajo y qué tan avanzada debe ser tu taxonomía y búsqueda.

Identifica usuarios principales y sus necesidades

Lista tus audiencias primarias y lo que necesitan hacer en el registro de aprendizaje de producto:

- Producto: revisar experimentos pasados, comparar resultados, reutilizar patrones exitosos.

- Diseño: entender qué cambios se probaron y por qué; revisar capturas o especificaciones.

- Ingeniería: confirmar detalles de implementación, guardrails y restricciones técnicas.

- Liderazgo: revisar impacto y calidad del aprendizaje sin leer cada detalle.

- Soporte/Equipos de atención al cliente: saber qué cambió y qué decir a los usuarios.

Una manera simple de validar esto: pregunta a cada grupo “¿Qué pregunta quieres que se responda en 30 segundos?” y luego asegúrate de que tus plantillas de experimento y el diseño de página soporten esa respuesta.

Elige un modelo de acceso: interno, público o mixto

Decide temprano si tu CMS para registros de experimentos debe ser:

- Solo interno: ideal para métricas sensibles, detalles de roadmap o datos de usuarios.

- Público: útil para transparencia y contratación, pero requiere revisión y redacción más estrictas.

- Mixto: un registro privado interno más un subconjunto público curado.

Si eliges acceso mixto, define qué está permitido en las entradas públicas (por ejemplo, sin métricas crudas, segmentos anonimizados, sin nombres de características no lanzadas) y quién aprueba la publicación. Esto evita reprocesos más adelante cuando el equipo quiera compartir aprendizajes externamente.

Planifica la estructura del sitio y la navegación

Un registro de experimentación solo funciona si la gente puede encontrar el experimento correcto en menos de un minuto. Antes de elegir herramientas o pantallas, decide cómo navegará alguien tu sitio cuando no sabe exactamente lo que busca.

Elige una navegación superior clara

Mantén la navegación principal limitada y predecible. Un punto de partida práctico es:

- Experimentos (tu repositorio de experimentos)

- Playbooks (guías prácticas, plantillas de experimentos, checklists)

- Métricas (definiciones, responsables, notas de seguimiento)

- Equipos (quién está ejecutando qué)

Si “Métricas” parece demasiado, puedes enlazarla desde Experimentos al principio y expandirla después.

Escoge tu lógica de organización principal

Decide la “forma” principal para navegar. La mayoría de los registros funcionan mejor con una vista principal y el resto manejado por filtros:

- Por área de producto (por ejemplo, Checkout, Búsqueda, Onboarding)

- Por etapa del embudo (Adquisición → Activación → Retención)

- Por equipo (Growth, Core, Mobile)

Elige la que tus stakeholders ya usan en las conversaciones. Todo lo demás puede ser etiquetas (por ejemplo, plataforma, tema de hipótesis, segmento, tipo de experimento).

Planifica URLs, migas y rutas “volver a la lista”

Haz URLs legibles y estables para que la gente pueda compartirlas en Slack y tickets:

/experiments/2025-12-checkout-free-shipping-threshold

Añade migas como Experimentos → Checkout → Umbral de envío gratuito para evitar callejones sin salida y mantener la exploración intuitiva.

Crea un inventario de contenidos ligero

Lista lo que publicarás en el día uno frente a lo que vendrá después: experimentos recientes, playbooks principales, un glosario de métricas básico y páginas de equipo. Prioriza entradas que se referencien con frecuencia (pruebas de alto impacto, plantillas canónicas y definiciones de métricas usadas en informes de resultados).

Diseña el modelo de datos para entradas de experimento

Un registro útil no es solo una lista de enlaces: es una base de datos de aprendizajes. El modelo de datos es la “forma” de esa base de datos: qué almacenas, cómo se relacionan las entradas y qué campos deben estar presentes para que los experimentos sean comparables con el tiempo.

Tipos de contenido principales (qué almacenarás)

Empieza con un pequeño conjunto de tipos que coincidan con cómo trabajan los equipos:

- Experimento: el registro principal (qué probaste y qué pasó).

- Métrica: una medición definida que reutilizas entre experimentos (por ejemplo, tasa de activación, churn, ingresos por usuario).

- Insight: un aprendizaje reutilizable que puede sobrevivir a una prueba (por ejemplo, “eliminar fricción en el paso 2 aumenta la finalización”).

- Decisión: qué se eligió después de los resultados (lanzar, iterar, revertir o archivar).

Mantenerlos separados evita que cada experimento invente nuevos nombres de métricas o entierre decisiones en texto libre.

Campos mínimos para cada entrada de experimento

Haz que la “entrada mínima viable” sea fácil de completar. Como mínimo, exige:

- Título (claro, específico)

- Hipótesis (qué esperabas y por qué)

- Responsable (una sola persona responsable)

- Fecha de inicio / Fecha de fin (o fechas planificadas)

- Estado (desde un conjunto estándar)

Campos opcionales pero valiosos: audiencia objetivo, asignación de tráfico, tipo de prueba (A/B, multivariante) y enlaces a tickets o diseños.

Campos de resultados que capturan el aprendizaje

Los resultados son donde los registros suelen fallar, así que estandarízalos:

- Métrica primaria (seleccionada desde tu lista de Métricas)

- Impacto (dirección + magnitud; incluye unidades)

- Notas de confianza (explicación en lenguaje llano sobre certeza, salvedades, calidad de datos)

- Evidencia de soporte (capturas, gráficos o un resumen corto de lo que se revisó)

Si permites adjuntos, deja un lugar consistente para capturas para que los lectores sepan dónde mirar.

Relaciones y estados

Modela relaciones explícitamente para que el descubrimiento y los informes funcionen después:

- Experimentos ↔ Métricas (primaria + secundarias)

- Experimentos ↔ Funciones/Áreas (qué parte del producto cambió)

- Experimentos ↔ Responsables/Equipos (responsabilidad y enrutamiento)

Estandariza estados para que la ordenación y los dashboards sean significativos: propuesto, en ejecución, concluido, lanzado, archivado. Esto evita que “hecho”, “completo” y “terminado” se conviertan en tres estados distintos.

Crea plantillas de página que faciliten la lectura de experimentos

Buenas plantillas convierten “notas de alguien” en un registro compartido que toda la compañía puede escanear, confiar y reutilizar. El objetivo es la consistencia sin que los autores sientan que rellenan papeleo.

Página de detalle del experimento: secciones recomendadas (en orden)

Comienza con la información que un lector necesita para decidir si seguir leyendo.

- Resumen (TL;DR): un párrafo: qué cambiaste, a quién afectó y el resultado.

- Estado y metadatos clave: estado, responsable, equipo, fechas de inicio/fin, enlace a PRD/ticket (

/docs/...) y métrica primaria.

- Hipótesis: una sola afirmación comprobable (evita objetivos vagos como “mejorar el engagement”).

- Diseño: variantes, segmentación, asignación, guardrails y supuestos de duración.

- Resultados: métrica primaria primero, luego métricas secundarias/guardrails, con una interpretación en lenguaje llano.

- Decisión: lanzar/iterar/revertir, además de qué cambió en el producto.

- Aprendizajes y seguimientos: qué aprendiste, preguntas abiertas y próximos experimentos.

- Apéndice: capturas, fragmentos SQL, gráficos crudos y enlaces.

Página de lista: campos y controles para escaneo rápido

Tu página índice debería comportarse como un dashboard. Incluye filtros para estado, equipo, etiqueta, rango de fechas y plataforma; ordenación por actualizado recientemente, fecha de inicio y (si puedes cuantificarlo) impacto; y campos de escaneo rápido como estado, responsable, fechas y una línea con el resultado.

Plantillas para coherencia entre equipos

Crea una plantilla por defecto más variantes opcionales (p. ej., “Prueba A/B”, “Prueba de precios”, “Experimento de onboarding”). Prefill de encabezados, texto de ejemplo y campos obligatorios para que los autores no empiecen desde una página en blanco.

Compatible con móvil y legible para notas largas

Usa un diseño de columna única, interlineado generoso y tipografía clara. Mantén los hechos clave en un bloque de resumen pegajoso (donde tenga sentido) y haz las tablas desplazables horizontalmente para que los resultados sean legibles en móviles.

Configura etiquetado y taxonomía para descubrimiento rápido

Agrega gobernanza ligera

Define roles, aprobaciones y estados para que las entradas no queden a medias.

Un registro de experimentación solo es útil si la gente puede encontrar aprendizajes relevantes rápido. El etiquetado y la taxonomía convierten un montón de páginas en algo que puedes explorar, filtrar y reutilizar.

Empieza con una estrategia de etiquetas pequeña y predecible

Define un puñado de grupos de etiquetas que coincidan con cómo el equipo busca. Una base práctica es:

- Área del producto (por ejemplo, Onboarding, Checkout, Notificaciones)

- Tipo de hipótesis (por ejemplo, reducción de fricción, sensibilidad al precio, señal de confianza)

- Métrica primaria (por ejemplo, tasa de activación, tasa de conversión, retención)

- Segmento (por ejemplo, nuevos usuarios, PYMES, solo móvil)

Mantén el número de grupos limitado. Demasiadas dimensiones confunden y fomentan etiquetado inconsistente.

Evita la proliferación de etiquetas con reglas de nombrado

Las etiquetas sin control rápidamente se convierten en “signup”, “sign-up” y “registration”. Crea un vocabulario controlado:

- Elige un formato (singular vs plural, mayúsculas, uso de acrónimos).

- Define quién puede crear etiquetas nuevas y cómo se aprueban.

- Añade descripciones cortas para etiquetas ambiguas (qué significa y cuándo usarla).

Un enfoque simple es una página de “registro de etiquetas” que el equipo mantiene (p. ej., /experiment-tags) más una revisión ligera durante la redacción del experimento.

Usa campos estructurados para lo que no debería ser texto libre

Las etiquetas son buenas para descubrimiento, pero algunos atributos deberían ser campos estructurados para mantenerse consistentes:

- Estado (Propuesto, En ejecución, Lanzado, Detenido)

- Equipo/Responsable (elegir desde una lista)

- Tipo de experimento (A/B, multivariante, holdout)

Los campos estructurados permiten filtros y dashboards fiables, mientras que las etiquetas capturan matices.

Soporta enlaces cruzados: experimentos relacionados y similares

Ayuda a los lectores a saltar entre trabajos conectados. Añade secciones como Experimentos relacionados (misma función o métrica) y Hipótesis similares (misma suposición probada en otro lugar). Puede ser manual al principio y luego automatizarse con reglas de “etiquetas compartidas” para sugerir vecinos.

Elige entre un CMS y una aplicación personalizada

Esta decisión marca el techo de lo que puede llegar a ser tu registro. Un CMS te permite publicar rápido, mientras que una app personalizada puede convertir el registro en un sistema integrado para la toma de decisiones.

Cuando un CMS es suficiente

Un CMS encaja cuando tu necesidad principal es documentación consistente y legible de pruebas A/B con estructura ligera.

Usa un CMS si quieres:

- Publicación simple: crear, editar, revisar y publicar entradas como artículos

- Experiencia de editor familiar para PMs, diseñadores y marketing

- Permisos integrados (quién puede redactar vs aprobar vs publicar)

- Etiquetado y categorías básicas sin reglas complejas

Un patrón típico: un headless CMS (contenido en el CMS, presentado por tu sitio) emparejado con un generador de sitios estáticos. Esto mantiene el repositorio rápido, fácil de alojar y apto para colaboradores no técnicos.

Cuando encaja una construcción personalizada

Una app personalizada tiene sentido cuando el registro debe conectarse directamente a tus datos de producto y herramientas internas.

Considera una app personalizada si necesitas:

- Integraciones profundas (feature flags, herramientas analíticas, data warehouse, gestión de tickets)

- Búsqueda y filtrado avanzados (vistas guardadas por equipo, métrica, plataforma, nivel de confianza)

- Reglas de flujo (campos obligatorios, aprobaciones por responsable de área, cambios automáticos de estado)

- Informes y resultados automatizados (extraer resultados en vez de copiar capturas)

Si quieres prototiparlo rápido, una plataforma de “vibe-coding” como Koder.ai puede ser un atajo práctico: puedes describir el modelo de datos (experimentos, métricas, decisiones), las plantillas de página y los flujos en chat, luego iterar sobre una app funcional en React + Go + PostgreSQL, con despliegue/hosting, exportación de código fuente y snapshots/rollback para cambios seguros.

Decide tu “fuente de la verdad”

Sé explícito sobre dónde vive la información del experimento.

- Si el CMS es la fuente de la verdad, tus enlaces analíticos y resúmenes de resultados deberían apuntar a la entrada del CMS.

- Si la base de datos/app es la fuente de la verdad, el sitio web debería ser una capa de vista sobre registros estructurados, con comentarios narrativos almacenados por separado (opcionalmente en un CMS).

Anótalo temprano—si no, los equipos acabarán con entradas duplicadas entre docs, hojas de cálculo y herramientas, y el registro dejará de ser confiable.

Elige la pila tecnológica y el hosting

Convierte tu plantilla en una app

Genera una interfaz React, backend en Go y esquema PostgreSQL a partir de tu especificación.

Tu registro no necesita tecnología exótica. La mejor pila es la que tu equipo pueda operar con confianza, mantener seguro y evolucionar sin fricción.

Sitio estático vs renderizado en servidor vs SPA

Un sitio estático (páginas preconstruidas) suele ser la opción más simple: rápido, barato de alojar y bajo mantenimiento. Funciona bien si los experimentos son mayormente de solo lectura y las actualizaciones se hacen vía CMS o pull requests.

Una app renderizada en servidor encaja cuando necesitas control de acceso más fuerte, filtros dinámicos o vistas por equipo sin lógica cliente compleja. También es más fácil aplicar permisos a nivel servidor.

Una SPA puede ofrecer interacciones muy reactivas para filtros y dashboards, pero añade complejidad en SEO, autenticación y carga inicial. Elígela solo si realmente necesitas experiencias tipo app.

Si construyes una app personalizada, decide también si quieres un pipeline convencional o un enfoque acelerado. Por ejemplo, Koder.ai puede generar la base (UI en React, API en Go, esquema en PostgreSQL) desde una especificación escrita, útil cuando iteras con múltiples stakeholders.

Fundamentos de hosting que evitan sorpresas dolorosas

Prioriza fiabilidad (uptime, monitorización, alertas) y copias de seguridad (automatizadas, con restores probados). Mantén entornos separados: al menos staging para probar cambios en taxonomía, plantillas y permisos antes de producción.

Autenticación y áreas privadas

La mayoría de equipos termina necesitando SSO (Okta, Google Workspace, Azure AD), además de roles (lector, editor, admin) y áreas privadas para aprendizajes sensibles (ingresos, datos de usuarios, notas legales). Planifícalo temprano para no re-arquitectar después.

Básicos de rendimiento que no puedes ignorar

Usa caching (CDN y cache de navegador), mantén páginas ligeras y optimiza medios (imágenes comprimidas, lazy loading cuando corresponda). La velocidad importa porque la gente no usará un registro que se sienta lento—especialmente cuando buscan una prueba pasada en una reunión.

Implementa búsqueda, filtros y vistas guardadas

Un registro de experimentación se vuelve realmente útil cuando la gente puede encontrar “esa prueba” en segundos—sin saber el título exacto.

Búsqueda en el sitio vs servicio externo de búsqueda

La búsqueda interna (integrada en tu CMS o base de datos) suele ser suficiente cuando tienes unos cientos de experimentos, un equipo pequeño y necesidades simples como buscar títulos, resúmenes y etiquetas. Es más fácil de mantener y evita configurar un proveedor adicional.

Un servicio de búsqueda externo (como Algolia/Elastic/OpenSearch) merece la pena cuando tienes miles de entradas, necesitas resultados ultrarrápidos, tolerancia a errores tipográficos y sinónimos (p. ej., “checkout” = “purchase”), o un ranking avanzado para mostrar lo más relevante primero. También ayuda si tu contenido abarca múltiples fuentes (docs + registro + wiki).

Filtros imprescindibles que coincidan con cómo trabaja la gente

La búsqueda sola no basta. Añade filtros que reflejen la toma de decisiones real:

- Estado: propuesto, en ejecución, pausado, concluido, lanzado, invalidado

- Rango de fechas: inicio, fin y última actualización

- Responsable y equipo: quién puede responder rápido

- Etiquetas: área funcional, segmento de audiencia, tipo de hipótesis

- Métrica primaria (y opcionalmente guardrails): ayuda a comparar experimentos similares

Haz los filtros combinables (p. ej., “Concluido + Últimos 90 días + Equipo Growth + Métrica Activación”).

Vistas guardadas que la gente realmente reutiliza

Las vistas guardadas convierten preguntas recurrentes en respuestas con un clic:

- En ejecución (estado = en ejecución)

- Alto impacto (lift por encima de un umbral, o decisión = lanzar)

- Recientemente concluidos (terminados en los últimos 30 días)

Permite que los equipos fijen vistas compartidas en la navegación y que las personas guarden vistas personales.

Haz los resultados escaneables en la vista de lista

En los resultados, muestra un snippet corto: hipótesis, variante, audiencia y el resultado principal. Resalta las palabras coincidentes en título y resumen, y muestra algunos campos clave (estado, responsable, métrica primaria) para que los usuarios decidan sin tener que abrir múltiples páginas.

Define flujo de trabajo, propiedad y gobernanza

Un gran sitio de seguimiento no son solo páginas y etiquetas—es un proceso compartido. Una propiedad clara y un flujo de trabajo ligero evitan entradas a medio terminar, resultados faltantes y “decisiones misteriosas” meses después.

Roles y permisos

Empieza decidiendo quién puede crear, editar, revisar y publicar entradas. Un modelo simple funciona para la mayoría:

- Autores (PMs, analistas, diseñadores): crear borradores y actualizar resultados

- Revisores (datos/analítica, investigación, ingeniería): verificar métricas, instrumentación e interpretación

- Aprobadores (líder de producto o consejo de experimentación): confirmar decisión y plan de rollout

- Publicadores (opcional): revisión final de formato y redacciones

Mantén los permisos consistentes con tus decisiones de acceso (público vs interno vs restringido). Si soportas experimentos privados, exige un responsable explícito para cada entrada.

Checklist editorial (qué significa “hecho”)

Define un checklist corto que todo experimento debe cumplir antes de publicarse:

- Hipótesis específica y falsable (qué cambia, para quién, dirección esperada)

- Métrica primaria definida (nombre exacto, fuente, ventana de cálculo)

- Guardrails listados (p. ej., ingresos, tasa de error, tickets de soporte)

- Decisión de rollout documentada (lanzar, iterar, parar) con la justificación

Este checklist puede ser una sección obligatoria en tus plantillas de experimento.

Historial de versiones y notas de cambio

Trata las entradas como documentos vivos. Habilita historial de versiones y exige breves notas de cambio para actualizaciones materiales (corrección de métricas, corrección de análisis, reversión de decisión). Esto mantiene la confianza alta y facilita auditorías.

Decide de antemano cómo almacenarás información sensible:

- Redacciones para nombres de clientes, términos de socios o detalles de seguridad

- Notas privadas visibles solo para un grupo restringido

- Páginas divididas: un resumen público más una página restringida con “análisis y datos”

La gobernanza no necesita ser pesada. Solo explícita.

Añade analítica y medición respetuosa con la privacidad

Compensa costos mientras construyes

Obtén créditos compartiendo contenido de Koder.ai o invitando a compañeros con tu enlace de referido.

Un registro es útil si la gente lo encuentra, confía y reutiliza. Analíticas ligeras te ayudan a detectar dónde funciona y dónde falla—sin convertir el sitio en una herramienta de vigilancia.

Rastrea uso sin sobre-coleccionar

Empieza con algunas señales prácticas:

- Búsquedas más frecuentes y búsquedas sin resultados: si la gente busca “prueba de precios” y no hay nada, tu taxonomía o nombres necesitan trabajo.

- Experimentos más vistos y etiquetas más visitadas: revelan qué le importa al equipo y qué áreas requieren mejores plantillas.

- Enlaces rotos y 404s: los registros suelen referenciar specs, dashboards o tickets; los enlaces rotos reducen la confianza rápido.

Si tu herramienta de analítica lo permite, desactiva el registro de IP y evita identificadores a nivel de usuario. Prefiere reportes agregados a nivel de página.

Mide la salud del contenido (calidad, no clics)

Las métricas de uso no te dirán si las entradas están completas. Añade comprobaciones de “salud de contenido” que reporten sobre el propio repositorio:

- Campos requeridos faltantes (p. ej., hipótesis, métrica primaria, decisión, responsable)

- Estados obsoletos (p. ej., en ejecución por 90+ días)

- Resultados desactualizados (p. ej., TBD después de la fecha de decisión)

Esto puede ser tan simple como un reporte semanal desde tu CMS/base de datos o un script pequeño que marque entradas. El objetivo es hacer visibles las brechas para que los responsables las corrijan.

Básicos de privacidad para entradas de experimento

Los reportes de experimentos casi nunca deberían contener datos personales. Mantén las entradas libres de:

- nombres, emails, IDs de usuario, replays de sesión, logs de eventos crudos

- capturas que contengan información personal

Enlaza a dashboards agregados en vez de incrustar datasets crudos y almacena análisis sensibles en sistemas aprobados.

Añade un descargo de interpretación claro

Los resultados de pruebas A/B son fáciles de interpretar mal fuera de contexto. Añade un descargo corto en tu plantilla de experimento (y/o en el pie de página) que indique que:

- los resultados dependen de la población definida, el periodo y la instrumentación

- los umbrales de confianza/significancia varían por equipo

- las decisiones deben referenciar la métrica primaria documentada y los guardrails

Esto mantiene el registro honesto y reduce el uso mecánico de resultados pasados.

Prepárate para el lanzamiento, la migración y el mantenimiento continuo

Un gran registro no está “listo” cuando el sitio está en producción. El valor real aparece cuando los equipos confían en él, lo mantienen al día y aún encuentran aprendizajes seis meses después.

Migra experimentos existentes (sin caos)

La mayoría empieza con hojas de cálculo, presentaciones o documentos dispersos. Elige un lote piloto pequeño (por ejemplo, los experimentos del último trimestre) y mapea cada campo de origen a tu nueva plantilla.

Si puedes, importa en bloque: exporta hojas a CSV y luego usa un script o el importador del CMS para crear entradas en el nuevo formato. Para documentos, migra primero los campos resumen clave (objetivo, cambio, resultados, decisión) y enlaza al archivo original para detalle soporte.

Haz una revisión de calidad antes del lanzamiento

Realiza una pasada enfocada en consistencia, no en perfección. Problemas comunes a corregir:

- Etiquetas duplicadas o casi duplicadas (p. ej., onboarding vs on-boarding)

- Responsables faltantes (cada experimento necesita un nombre, no solo “equipo”) y fechas faltantes

- Estados inconsistentes (borrador, en ejecución, detenido, lanzado, invalidado) y resultados poco claros

También es buen momento para acordar campos obligatorios para lo que se marque como completado.

Checklist de lanzamiento

Antes de anunciarlo, verifica:

- Permisos: quién puede ver, quién puede editar y quién puede publicar

- Indexación de búsqueda: las páginas principales y etiquetas deben ser descubribles

- Redirecciones: si reemplazas un espacio/wiki viejo, configura redirecciones para preservar enlaces

- Backups: confirma copias automáticas y una prueba de restauración (aunque sea simple)

Ritmo de mantenimiento post-lanzamiento

Establece una rutina ligera: limpieza mensual (borradores obsoletos, resultados faltantes) y revisión trimestral de taxonomía (fusionar etiquetas, añadir categorías con cuidado).

Siguientes pasos opcionales

Cuando lo básico esté estable, considera integraciones: enlazar automáticamente experimentos a trackers de issues o traer contexto analítico para que cada entrada apunte al dashboard exacto usado en el informe de resultados.

Si evolucionas hacia una app personalizada, también puedes iterar en “modo planificación” primero—escribiendo flujos, campos obligatorios y reglas de aprobación—luego implementarlos. Plataformas como Koder.ai soportan este ciclo iterativo de construcción y refinamiento (con despliegues, snapshots y rollback) para que tu registro madure sin una reconstrucción pesada.