Definir objetivos, preguntas y métricas de éxito

Antes de rastrear nada, decide qué significa “adopción” para tu producto. Si te saltas este paso, recopilarás muchos datos—y aún así discutirás en reuniones sobre lo que “significa”.

Define “adopción” en términos claros

La adopción normalmente no es un único momento. Elige una o más definiciones que coincidan con cómo se entrega el valor:

- Uso: un usuario prueba la funcionalidad al menos una vez (útil en lanzamientos nuevos).

- Uso repetido: el usuario la vuelve a usar dentro de una ventana temporal (útil para flujos que forman hábitos).

- Valor alcanzado: el usuario obtiene el resultado que la funcionalidad pretende permitir (a menudo la mejor señal).

Ejemplo: para “Búsquedas guardadas”, la adopción podría ser creó una búsqueda guardada (uso), la ejecutó 3+ veces en 14 días (repetición) y recibió una alerta y hizo clic (valor alcanzado).

Lista las decisiones que debe soportar tu tracking

Tu tracking debe responder preguntas que lleven a la acción, como:

- ¿Qué debemos mejorar porque se usa pero no entrega valor?

- ¿Qué debemos retirar porque añade complejidad con baja adopción?

- ¿Qué debemos promocionar porque aumenta retención o conversiones?

Escribe estas preguntas como declaraciones de decisión (p. ej., “Si la activación baja tras el release X, revertimos los cambios de onboarding.”).

Equipos distintos necesitan vistas distintas:

- Producto (PM): adopción por segmento, impacto post-release, hitos de valor.

- Growth/Marketing: lift de campaña, embudos de conversión, re-engagement.

- Soporte/Success: qué funcionalidades correlacionan con menos tickets o mayores renovaciones.

- Ingeniería: salud de la instrumentación, cambios en volumen de eventos, marcadores de release.

Establece métricas de éxito y cadencia

Elige un pequeño conjunto de métricas para revisar semanalmente, más una verificación ligera tras cada despliegue. Define umbrales (p. ej., “Tasa de adopción ≥ 25% entre usuarios activos en 30 días”) para que los reportes impulsen decisiones, no debates.

Mapea los datos que necesitas: usuarios, funcionalidades, eventos, resultados

Antes de instrumentar, decide qué “cosas” describirá tu sistema de analítica. Si defines bien estas entidades, tus informes seguirán siendo entendibles a medida que el producto evoluciona.

Comienza con las entidades centrales

Define cada entidad en lenguaje llano y luego tradúcela a IDs que puedas almacenar:

- Usuario: una persona que usa la app (puede empezar anónima y luego autenticarse).

- Cuenta / workspace: el cliente que paga o el contenedor de equipo al que pertenecen varios usuarios.

- Sesión: una visita acotada en el tiempo (útil para engagement y troubleshooting; opcional según el producto).

- Funcionalidad: una capacidad nombrada cuya adopción quieres medir (a menudo un conjunto de eventos, no un solo clic).

- Evento: una acción u ocurrencia del sistema que puedes registrar (p. ej.,

project_created, invite_sent).

- Resultado: el hito de valor que quieres que alcancen usuarios/cuentas (p. ej., “primer informe compartido”, “suscripción activada”).

Apunta las propiedades mínimas que necesitas para cada evento: user_id (o ID anónimo), account_id, timestamp y algunas atributos relevantes (plan, rol, dispositivo, feature flag, etc.). Evita volcarlo todo “por si acaso”.

Elige las vistas de adopción que soportarás

Selecciona los ángulos de reporte que encajen con tus objetivos de producto:

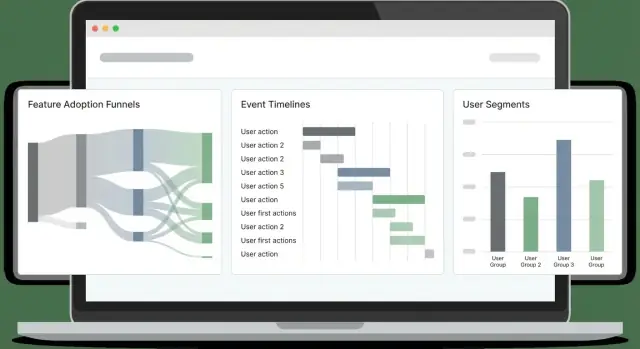

- Embudos (activación paso a paso)

- Cohortes (grupos por fecha de signup, plan, canal)

- Retención (¿vuelven y repiten acciones clave?)

- Rutas (secuencias comunes antes/después de un hito)

- Tiempo hasta primer valor (cuánto tardan en alcanzar el primer resultado significativo)

Tu diseño de eventos debería facilitar estos cálculos.

Sé explícito sobre el alcance: solo web al principio, o web + móvil desde el día cero. El tracking multiplataforma es más sencillo si estandarizas nombres de eventos y propiedades pronto.

Por último, fija objetivos innegociables: impacto en rendimiento de la página, latencia de ingestión (qué tan frescos deben ser los dashboards) y tiempo de carga del panel. Estas restricciones guiarán las elecciones posteriores en tracking, almacenamiento y consultas.

Diseña un esquema de tracking de eventos que se mantenga consistente

Un buen esquema de tracking no trata de “rastrearlo todo”, sino de hacer que los eventos sean predecibles. Si los nombres y propiedades derivan, los dashboards se rompen, los analistas dejan de confiar en los datos y los ingenieros dudan al instrumentar.

Empieza con una convención clara de nombres

Elige un patrón simple y repetible y cúmplelo. Una elección común es verbo_sustantivo:

viewed_pricing_pagestarted_trialenabled_featureexported_report

Usa pasado consistentemente (o presente consistentemente), y evita sinónimos (clicked, pressed, tapped) a menos que realmente signifiquen cosas distintas.

Define propiedades requeridas (el “contrato”)

Cada evento debería llevar un pequeño conjunto de propiedades requeridas para que puedas segmentar, filtrar y hacer joins de forma fiable más tarde. Como mínimo, define:

user_id (nullable para usuarios anónimos, pero presente cuando se conoce)account_id (si tu producto es B2B/multi-seat)timestamp (generado por el servidor cuando sea posible)feature_key (identificador estable como "bulk_upload")plan (p. ej., free, pro, enterprise)

Estas propiedades facilitan el tracking de adopción y la analítica de comportamiento porque no tendrás que adivinar qué falta en cada evento.

Permite propiedades opcionales—con precaución

Los campos opcionales añaden contexto, pero son fáciles de abusar. Propiedades típicas opcionales:

device, os, browserpage, referrerexperiment_variant (o ab_variant)

Mantén las propiedades opcionales consistentes entre eventos (mismos nombres de clave, mismos formatos de valor) y documenta los “valores permitidos” cuando sea posible.

Versiona tu esquema y escribe una especificación de instrumentación

Asume que tu esquema evolucionará. Añade un event_version (p. ej., 1, 2) y actualízalo cuando cambie el significado o las propiedades requeridas.

Finalmente, escribe una spec de instrumentación que liste cada evento, cuándo se dispara, propiedades requeridas/opcionales y ejemplos. Mantén ese doc en control de código junto a tu app para que los cambios de esquema se revisen como código.

Resolver identidad: vistas anónimas, autenticadas y a nivel de cuenta

Si tu modelo de identidad es frágil, tus métricas de adopción estarán ruidosas: los embudos no coincidirán, la retención parecerá peor y los “usuarios activos” se inflarán por duplicados. El objetivo es soportar tres vistas a la vez: visitantes anónimos, usuarios autenticados y actividad por cuenta/workspace.

Anónimos vs identificados (y cuándo vincular)

Inicia cada dispositivo/sesión con un anonymous_id (cookie/localStorage). En el momento en que un usuario se autentica, vincula ese historial anónimo a un user_id identificado.

Vincula identidades cuando el usuario haya probado la propiedad de la cuenta (login exitoso, verificación por magic link, SSO). Evita vincular con señales débiles (email tecleado en un formulario) a menos que lo separes claramente como “pre-auth”.

Login, logout y cambio de cuenta sin romper métricas

Trata las transiciones de auth como eventos:

login_success (incluye user_id, account_id y el anonymous_id actual)logoutaccount_switched (de account_id → account_id)

Importante: no cambies la cookie anónima al hacer logout. Si la rotas, fragmentarás sesiones e inflarás usuarios únicos. En su lugar, conserva el anonymous_id estable, pero deja de adjuntar user_id tras el logout.

Reglas de merge de identidad (y evitar doble contabilización)

Define reglas de merge explícitas:

- Merge de usuario: prefiere un

user_id interno estable. Si debes hacer merge por email, hazlo server-side y solo para emails verificados. Mantén un rastro de auditoría.

- Merge de cuenta: usa un

account_id/workspace_id estable generado por tu sistema, no un nombre mutable.

Al fusionar, escribe una tabla de mapeo (antiguo → nuevo) y aplícala consistentemente en tiempo de consulta o mediante un job de backfill. Esto evita que “dos usuarios” aparezcan en cohortes.

Almacena claves estables

Envía y guarda:

anonymous_id (estable por navegador/dispositivo)user_id (estable por persona)account_id (estable por workspace)

Con estas tres claves puedes medir comportamiento pre-login, adopción por usuario y adopción a nivel de cuenta sin doble contabilizar.

Elegir tracking cliente vs servidor (y mezclarlos)

Dónde rastreas eventos cambia lo que puedes confiar. Los eventos en navegador te dicen lo que la gente intentó hacer; los eventos server te dicen lo que realmente sucedió.

Tracking cliente (navegador)

Usa tracking cliente para interacciones de UI y contexto que solo tienes en el navegador. Ejemplos típicos:

- Vistas de página/pantalla, clics en botones, cambios de pestañas, apertura/cierre de modales

- Momentos de “visto la funcionalidad” (p. ej., se abrió la página de ajustes)

- Contexto cliente: URL, referrer, UTMs, tipo de dispositivo, tamaño de viewport, idioma

Agrupa eventos para reducir tráfico: haz cola en memoria, vacía cada N segundos o al alcanzar N eventos, y también vacía en visibilitychange/page hide.

Tracking server (APIs y jobs)

Usa tracking server para cualquier evento que represente un outcome completado o una acción sensible a facturación/seguridad:

- Funcionalidad habilitada/deshabilitada guardada con éxito

- Invitación aceptada, pago realizado, export generado

- Jobs en background: sync terminado, informe entregado, email enviado

El tracking server suele ser más exacto porque no se bloquea por ad blockers, recargas o conectividad inestable.

Enfoque recomendado: híbrido por defecto

Un patrón práctico es: trackear intento en el cliente y éxito en el servidor.

Por ejemplo, emite feature_x_clicked_enable (cliente) y feature_x_enabled (servidor). Luego enriquece eventos server con contexto cliente pasando un context_id (o request ID) del navegador a la API.

Fiabilidad: reintentos, backoff, buffer offline

Añade resiliencia donde es más probable que se pierdan eventos:

- Cliente: persiste una cola pequeña en

localStorage/IndexedDB, reintenta con backoff exponencial, limita reintentos y deduplica por event_id.

- Servidor: reintenta en fallos transitorios, usa una cola interna y asegura idempotencia para que un reintento no doble cuente.

Esta mezcla te da detalle conductual rico sin sacrificar métricas de adopción fiables.

Planifica la arquitectura del sistema: ingestión, almacenamiento y consulta

Mantén la propiedad total del código

Genera, revisa y exporta el código fuente para que tu equipo mantenga la propiedad del pipeline a largo plazo.

Una app de analítica de adopción de funcionalidades es principalmente una pipeline: captura eventos con fiabilidad, almacénalos barato y consúltalos lo suficientemente rápido como para que la gente confíe y use los resultados.

Componentes centrales (y por qué importan)

Comienza con un set simple y separable de servicios:

- Collector endpoint: un servicio HTTP pequeño que recibe eventos (desde navegador, móvil o backend). Mantenlo rápido y minimal—valida lo básico, añade timestamps del servidor y responde pronto.

- Cola/stream: amortigua picos de tráfico y desacopla ingestión del procesamiento (Kafka, Kinesis, Pub/Sub, SQS).

- Workers: consumen el stream para enriquecer, deduplicar, validar esquema y enrutar datos al almacenamiento.

- Almacén analítico: optimizado para datos de eventos append-only grandes (ClickHouse, BigQuery, Snowflake, Redshift).

- API: expone endpoints de consulta consistentes para dashboards (embudos, cohortes, retención) y permisos.

- UI: dashboards y herramientas de exploración; mantenla separada para poder cambiar la lógica de almacenamiento/consulta sin reescribir frontend.

Si quieres prototipar rápido una app interna de analítica web, una plataforma vibe-coding como Koder.ai puede ayudarte a levantar la UI del dashboard (React) y un backend (Go + PostgreSQL) desde una spec conversacional—útil para conseguir un “slice” funcional antes de endurecer la pipeline.

Almacenamiento: eventos raw vs agregados

Usa dos capas:

- Eventos raw append-only para auditoría y re-procesado. Trátalos como la fuente de la verdad.

- Agregados/vistas materializadas para velocidad (DAU por funcionalidad, pasos del embudo, tablas de cohortes). Las vistas materializadas son útiles cuando las mismas consultas se ejecutan constantemente.

Tiempo real vs batch (elige según decisiones)

Elige la frescura que tu equipo realmente necesita:

- Near real-time (segundos/minutos) si monitorizas lanzamientos, caídas de onboarding o outages.

- Batch diario para reporting de tendencias, adopción semanal y resúmenes ejecutivos—más barato y a menudo más simple.

Muchas equipos hacen ambas cosas: contadores en tiempo real para “qué está pasando ahora” y jobs nocturnos que recomputan métricas canónicas.

Plan de escalado: particionado y crecimiento

Diseña para crecer desde temprano particionando:

- Por tiempo (diario/mensual) para mantener consultas acotadas y políticas de retención sencillas.

- Por cuenta/tenant para soportar permisos B2B y rendimiento.

- Opcionalmente por tipo de evento si pocos eventos de alto volumen dominan.

También planifica retención (p. ej., 13 meses raw, agregados más largos) y una ruta de replay para arreglar bugs reprocesando eventos en lugar de parchear dashboards.

Modelado de datos para eventos y consultas analíticas rápidas

Buena analítica empieza con un modelo que responda preguntas comunes rápido (embudos, retención, uso de funciones) sin convertir cada consulta en un proyecto de ingeniería.

Elige una estrategia de base de datos en dos niveles

La mayoría rinde mejor con dos almacenes:

- Relacional (Postgres/MySQL) para metadata “estable” que cambia despacio: usuarios, cuentas, catálogo de features, control de acceso y configuración.

- Columnar/warehouse (ClickHouse/BigQuery/Snowflake) para eventos de alto volumen, donde necesitas scans y agregaciones rápidas.

Esta separación mantiene tu BD de producto ligera y hace que las consultas analíticas sean más baratas y rápidas.

Define las tablas núcleo (y mantenlas aburridas)

Un baseline práctico:

- raw_events: una fila por evento (

event_name, timestamp, user_id/anonymous_id, session_id, account_id, properties JSON, source).

- users: perfil de usuario + identificadores actuales.

- accounts: entidad compañía/organización para rollups B2B.

- feature_catalog: lista canónica de funcionalidades (key, display_name, categoría, estado de lifecycle).

- sessions: límites de sesión (inicio/fin, dispositivo, referrer) para análisis de comportamiento.

- aggregates: métricas precomputadas diarias/semanales (p. ej., DAU, feature_active_users, recuentos de pasos del embudo).

En el warehouse, desnormaliza lo que consultas a menudo (p. ej., copia account_id onto events) para evitar joins costosos.

Controla coste y velocidad con retención + particionado

Particiona raw_events por tiempo (diario es común) y opcionalmente por workspace/app. Aplica retención por tipo de evento:

- Mantén eventos producto de alto nivel más tiempo (meses/años).

- Expira eventos de debug ruidosos rápidamente.

Esto evita que el “crecimiento infinito” se convierta silenciosamente en tu mayor problema analítico.

Construye checks de calidad en el modelo

Trata los checks de calidad como parte del modelado, no como limpieza posterior:

- Propiedades requeridas faltantes (p. ej.,

feature_key).

- Timestamps malos (fechas futuras, problemas de zona horaria).

- Eventos duplicados (reintentos, instrumentación doble).

Almacena resultados de validación (o una tabla de eventos rechazados) para monitorizar la salud de la instrumentación y arreglar problemas antes de que los dashboards se desvíen.

Calcula métricas de adopción: embudos, cohortes, retención y rutas

Pasa de la especificación al despliegue

Despliega y hospeda tu app web de analítica rápidamente, luego itera a medida que los equipos la usan.

Cuando tus eventos fluyen, el siguiente paso es convertir clicks crudos en métricas que respondan: “¿Esta funcionalidad se está adoptando realmente, y por quién?” Enfócate en cuatro vistas que funcionan juntas: embudos, cohortes, retención y rutas.

Embudos: adopción como secuencia (no un solo clic)

Define un embudo por funcionalidad para ver dónde abandonan los usuarios. Un patrón práctico:

- Descubrimiento → el usuario ve el punto de entrada de la funcionalidad (botón, menú, banner)

- Primer uso → la primera interacción significativa (p. ej.,

feature_used)

- Uso repetido → un segundo uso dentro de una ventana razonable (p. ej., 7 días)

- Acción de valor → el outcome que prueba el valor (export generado, automatización habilitada, informe compartido)

Mantén los pasos del embudo ligados a eventos de confianza y nómbralos consistentemente. Si “primer uso” puede suceder de múltiples maneras, trátalo como un paso con condiciones OR (p. ej., import_started OR integration_connected).

Cohortes: compara homogéneos

Las cohortes te ayudan a medir mejoras en el tiempo sin mezclar usuarios viejos y nuevos. Cohortes comunes:

- Usuarios nuevos por semana (semana de signup)

- Usuarios activados (alcanzaron tu evento de activación)

- Usuarios retenidos (volvieron y hicieron algo significativo)

- Power users (alta frecuencia o acciones avanzadas)

Mide tasas de adopción dentro de cada cohorte para ver si onboarding o cambios de UI recientes ayudan.

Retención: “vuelven y siguen usándolo?”

La retención es más útil cuando la ligas a una funcionalidad, no solo a “aperturas de app”. Defínela como repetir el evento núcleo de la funcionalidad (o la acción de valor) en Día 7/30. También mide “tiempo hasta el segundo uso”—a menudo es más sensible que la retención cruda.

Segmentación y rutas: quién adopta y cómo llegan

Desglosa métricas por dimensiones que expliquen comportamiento: plan, rol, industria, dispositivo y canal de adquisición. Los segmentos suelen revelar que la adopción es fuerte en un grupo y cercana a cero en otro.

Añade análisis de rutas para encontrar secuencias comunes antes y después de la adopción (p. ej., usuarios que adoptan suelen visitar pricing, luego docs, luego conectan una integración). Usa esto para afinar el onboarding y eliminar callejones sin salida.

Construye dashboards que la gente use realmente

Los dashboards fallan cuando intentan servir a todos con una única “vista maestra”. En su lugar, diseña un pequeño conjunto de páginas enfocadas que coincidan con cómo distintos roles toman decisiones, y haz que cada página responda una pregunta clara.

Comienza con páginas específicas por audiencia

Un overview ejecutivo debería ser un chequeo rápido de salud: tendencia de adopción, usuarios activos, funcionalidades principales y cambios desde el último release. Un deep dive de funcionalidad debe ser para PMs e ingenieros: dónde empiezan los usuarios, dónde abandonan y qué segmentos se comportan distinto.

Una estructura simple que funciona bien:

- Resumen: tendencia de adopción, tendencia de retención y algunos KPIs principales

- Página de funcionalidad: embudo, retención por cohorte y frecuencia de uso para una funcionalidad

- Explorador de segmentos: compara planes, regiones o tamaños de workspace lado a lado

Facilita la exploración (sin ensuciar todo)

Incluye gráficos de tendencia para el “qué”, desgloses por segmento para el “quién” y drill-down para el “por qué”. El drill-down debe permitir ver usuarios o workspaces de ejemplo (con permisos adecuados), para que los equipos validen patrones e investiguen sesiones reales.

Mantén filtros consistentes entre páginas para que los usuarios no tengan que reaprender controles. Los filtros más útiles para tracking de adopción son:

- Rango de fechas

- Plan / tier

- Atributos de workspace/cuenta (tamaño, industria)

- Región

- Versión de la app (o canal de release)

Compartir, exportar y vistas guardadas

Los dashboards forman parte del flujo de trabajo cuando la gente puede compartir exactamente lo que ve. Añade:

- Exportar a CSV para análisis rápidos en hojas de cálculo

- Compartir con una vista guardada linkable (filtros + estado de gráficos + segmento seleccionado)

- Resúmenes programados por email/Slack que apunten a la vista guardada

Si construyes esto en una app de analítica de producto, considera una página /dashboards con vistas “Pinned” para que los stakeholders aterricen siempre en los pocos reportes que importan.

Añade alertas, anomalías y marcadores de release

Los dashboards son buenos para explorar, pero los equipos suelen enterarse de problemas cuando un cliente se queja. Las alertas cambian eso: aprendes de una rotura minutos después y puedes relacionarlo con lo que cambió.

Define reglas de alerta que coincidan con fallos reales

Empieza con pocas alertas de alta señal que protejan tu flujo central de adopción:

- Caída súbita en primer uso (p. ej., eventos “Feature X: first_use” por hora abajo un 40% vs baseline). Esto suele indicar regresión UI, cambio de permisos o bug de instrumentación.

- Pico de errores (errores cliente, API 4xx/5xx o eventos

feature_failed). Incluye umbrales absolutos y basados en tasa (errores por 1,000 sesiones).

- Eventos ausentes tras un release (el recuento de eventos cae a casi cero). Esto detecta instrumentación rota rápido—especialmente tras refactors.

Mantén definiciones de alertas legibles y versionadas (incluso un YAML en tu repo) para que no se conviertan en conocimiento tribal.

Detección de anomalías: empieza simple

La detección básica de anomalías puede ser muy efectiva sin ML complejo:

- Compara valores actuales con una media móvil (p. ej., últimos 7 días, misma hora del día).

- Añade conciencia de estacionalidad donde importe (día de semana vs fin de semana, horario laboral vs noche).

- Usa una regla de volumen mínimo para que métricas de bajo tráfico no llenen de spam.

Marcadores de release: una línea temporal de “qué cambió”

Añade un stream de marcadores de release dentro de los gráficos: despliegues, rollouts de feature flags, cambios de pricing, tweaks de onboarding. Cada marcador debe incluir timestamp, propietario y una nota corta. Cuando las métricas cambien, verás inmediatamente causas probables.

Enrutamiento, horas silenciosas y ownership

Envía alertas a email y canales tipo Slack, pero soporta horas silenciosas y escalado (aviso → page) para problemas severos. Cada alerta necesita un owner y un enlace al runbook (incluso una breve /docs/alerts) describiendo qué revisar primero.

Privacidad, consentimiento y control de acceso

Planifica el seguimiento correctamente

Usa Planning Mode para mapear eventos clave, propiedades y checks de QA antes de instrumentar.

Los datos analíticos se convierten rápidamente en datos personales si no tienes cuidado. Trata la privacidad como parte del diseño de tracking, no como un asunto legal posterior: reduce riesgos, genera confianza y evita re-trabajos dolorosos.

Consentimiento: recoge solo lo que acepten

Respeta requisitos de consentimiento y permite optar fuera donde haga falta. En la práctica, tu capa de tracking debe comprobar una bandera de consentimiento antes de enviar eventos y poder parar el tracking en mitad de sesión si el usuario cambia de opinión.

Para regiones con reglas más estrictas, considera “features con consentimiento”:

- Carga librerías analíticas solo tras el consentimiento (no solo “dejar de enviar”).

- Almacena la decisión de consentimiento con timestamp y versión, para probar lo que el usuario aceptó.

- Ofrece una UI de preferencias en la configuración de la app.

Minimiza datos sensibles (y mantenlos fuera de eventos)

Minimiza datos sensibles: evita emails raw en eventos; usa hashes/IDs opacos. Los payloads deben describir comportamiento (qué pasó), no identidad (quién es la persona). Si necesitas conectar eventos a una cuenta, envía un user_id/account_id interno y guarda el mapeo en tu BD con controles de seguridad.

También evita recopilar:

- Campos de texto libre (suelen contener info personal accidental)

- URLs completas que puedan incluir tokens o query params

- Cualquier cosa que no querrías que aparezca en una captura de pantalla

Sé transparente: documentación y página de privacidad clara

Documenta qué recopilas y por qué; enlaza a una página de privacidad clara. Crea un “diccionario de tracking” ligero que explique cada evento, su propósito y periodo de retención. En la UI del producto, enlaza a /privacy y mantenlo legible: qué rastreas, qué no y cómo optar por salir.

Control de acceso: limita quién ve datos a nivel de usuario

Implementa control por roles para que solo equipos autorizados vean datos a nivel usuario. La mayoría solo necesita dashboards agregados; reserva vistas raw para un grupo pequeño (p. ej., data/product ops). Añade logs de auditoría para exports y búsquedas de usuarios, y aplica límites de retención para que datos viejos expiren automáticamente.

Bien hecho, los controles de privacidad no ralentizarán el análisis—harán tu sistema más seguro, claro y fácil de mantener.

Plan de rollout, QA y mantenimiento a largo plazo

Lanzar analítica es como lanzar una funcionalidad: quieres un release pequeño y verificable, luego iteración continua. Trata el trabajo de tracking como código de producción con owners, revisiones y tests.

Empieza pequeño con “eventos dorados”

Comienza con un conjunto ajustado de eventos dorados para una área de funcionalidad (por ejemplo: Feature Viewed, Feature Started, Feature Completed, Feature Error). Deben mapear directamente a preguntas que el equipo hará semanalmente.

Mantén el scope intencionadamente estrecho: menos eventos permiten validar la calidad rápido y aprender qué propiedades necesitas realmente (plan, rol, source, variante) antes de escalar.

Valida tracking en staging y producción

Usa una checklist antes de declarar el tracking como “hecho”:

- El evento se dispara una vez (sin doble tracking por refresh, reintentos o cambios de ruta SPA)

- Propiedades requeridas presentes y tipadas consistentemente

- PII excluida o correctamente enmascarada

- Eventos recibidos dentro de la latencia esperada

- Identidades vinculadas correctamente (anónimo → autenticado)

Añade consultas de ejemplo que puedas ejecutar en staging y producción. Ejemplos:

- “Contar eventos por nombre en los últimos 30 minutos” (detectar eventos faltantes/extras)

- “Top 20 valores de propiedad para

feature_name” (cazar typos como Search vs search)

- “Tasa de completado = Completed / Started por versión de app” (detectar regresiones tras releases)

Flujo QA de instrumentación para cada release

Haz que la instrumentación sea parte del proceso de release:

- Cambio de tracking en el mismo PR que el cambio UI/API

- Revisor comprueba nombres/propiedades contra el esquema

- QA verifica eventos en staging con una cuenta de test conocida

- Nota de release incluye cambios de tracking (nuevos eventos, propiedades renombradas)

Mantenimiento a largo plazo (esquema, backfills, docs)

Planifica el cambio: depreca eventos en lugar de borrarlos, versiona propiedades cuando cambie su significado y programa auditorías periódicas.

Cuando añades una propiedad requerida o arreglas un bug, decide si necesitas un backfill (y documenta la ventana de tiempo donde los datos son parciales).

Finalmente, mantiene una guía ligera de tracking en tus docs y enlázala desde dashboards y plantillas de PR. Un buen punto de partida es una checklist corta como /blog/event-tracking-checklist.