Qué explica esta historia (y por qué importa)

Solomon Hykes es el ingeniero que ayudó a convertir una idea de larga data —aislar software para que se ejecute igual en cualquier parte— en algo que los equipos pudieran usar día a día. En 2013, el proyecto que presentó al mundo se convirtió en Docker, y rápidamente cambió la forma en que las empresas envían aplicaciones.

En esa época, el dolor era simple y familiar: una app funcionaba en el portátil de un desarrollador, luego se comportaba diferente en la máquina de un compañero y después fallaba en staging o producción. Estos “entornos inconsistentes” no solo eran molestos: ralentizaban los lanzamientos, dificultaban reproducir bugs y generaban traspasos interminables entre desarrollo y operaciones.

El problema que Docker resolvió (en términos simples)

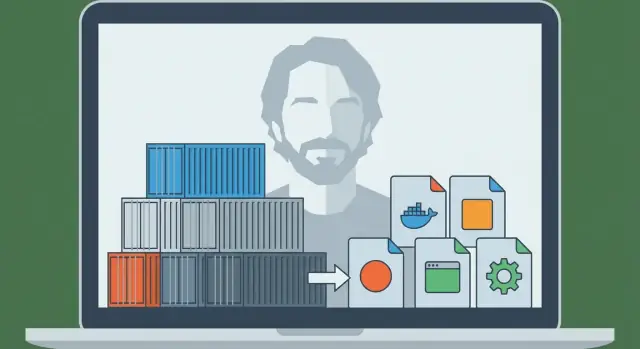

Docker dio a los equipos una forma repetible de empaquetar una aplicación junto con las dependencias que espera—para que la app pueda ejecutarse igual en un portátil, en un servidor de pruebas o en la nube.

Por eso la gente dice que los contenedores se convirtieron en la “unidad predeterminada de empaquetado y despliegue”. En términos sencillos:

- Unidad de empaquetado: lo que construyes y almacenas (una imagen de contenedor)

- Unidad de despliegue: lo que ejecutas en un entorno (un contenedor)

En lugar de desplegar “un ZIP más una wiki con pasos de configuración”, muchos equipos despliegan una imagen que ya incluye lo que la app necesita. El resultado son menos sorpresas y lanzamientos más rápidos y predecibles.

Lo que obtendrás de esta historia

Este artículo mezcla historia con conceptos prácticos. Aprenderás quién es Solomon Hykes en este contexto, qué introdujo Docker en el momento adecuado y la mecánica básica—sin asumir conocimientos profundos de infraestructura.

También verás dónde encajan los contenedores hoy: cómo se conectan a CI/CD y flujos DevOps, por qué herramientas de orquestación como Kubernetes se volvieron importantes después, y qué no arreglan los contenedores por sí solos (especialmente en temas de seguridad y confianza).

Al final, deberías poder explicar—con claridad y confianza—por qué “entregar como contenedor” se convirtió en una suposición por defecto para el despliegue moderno de aplicaciones.

Antes de Docker: por qué era tan difícil enviar apps

Antes de que los contenedores fueran mainstream, llevar una aplicación del portátil de un desarrollador a un servidor era a menudo más doloroso que escribir la propia app. A los equipos no les faltaba talento: les faltaba una forma fiable de mover “lo que funciona” entre entornos.

“Funciona en mi máquina” era un problema real

Un desarrollador podía ejecutar la app perfectamente en su equipo y verla fallar en staging o producción. No porque el código cambiara, sino porque el entorno sí. Diferentes versiones del sistema operativo, bibliotecas faltantes, archivos de configuración ligeramente distintos o una base de datos con valores por defecto distintos podían romper la misma compilación.

Conflictos de dependencias e instrucciones de instalación infinitas

Muchos proyectos dependían de instrucciones de instalación largas y frágiles:

- instalar este runtime de lenguaje

- compilar ese paquete del sistema

- fijar una versión específica de una librería

- establecer variables de entorno en el lugar correcto

Aunque se escribieran con cuidado, estas guías envejecían rápido. Un compañero que actualizara una dependencia podía romper la incorporación de todos los demás.

Peor aún, dos apps en el mismo servidor podrían requerir versiones incompatibles del mismo runtime o librería, forzando a los equipos a soluciones incómodas o a máquinas separadas.

Empaquetado y despliegue estaban separados—y no encajaban

“Empaquetado” a menudo significaba producir un ZIP, un tarball o un instalador. “Despliegue” implicaba otro conjunto de scripts y pasos en el servidor: aprovisionar la máquina, configurarla, copiar archivos, reiniciar servicios y rezar para que nada más en el servidor se viera afectado.

Esas dos preocupaciones rara vez coincidían limpiamente. El paquete no describía completamente el entorno que necesitaba, y el proceso de despliegue dependía mucho de que el servidor objetivo estuviera preparado “justo como toca”.

La pieza que faltaba: una unidad portátil

Lo que los equipos necesitaban era una única unidad portátil que viajara con sus dependencias y se ejecutara de forma consistente en portátiles, servidores de prueba y producción. Esa presión—configuración repetible, menos conflictos y despliegues previsibles—preparó el terreno para que los contenedores se convirtieran en la forma por defecto de enviar aplicaciones.

Solomon Hykes y el nacimiento de Docker (línea de tiempo a alto nivel)

Docker no empezó como un gran plan para “cambiar el software para siempre”. Surgió del trabajo de ingeniería práctico liderado por Solomon Hykes mientras construían un producto de plataforma como servicio. El equipo necesitaba una forma repetible de empaquetar y ejecutar aplicaciones en distintas máquinas sin las habituales sorpresas de “funciona en mi máquina”.

Antes de que Docker fuera un nombre conocido, la necesidad subyacente era sencilla: enviar una app con sus dependencias, ejecutarla de forma fiable y repetirlo muchas veces para muchos clientes.

El proyecto que se convirtió en Docker surgió como una solución interna—algo que hacía los despliegues predecibles y los entornos consistentes. Cuando el equipo se dio cuenta de que el mecanismo de empaquetado y ejecución era útil más allá de su producto, lo publicaron.

Esa publicación fue importante porque convirtió una técnica privada de despliegue en una cadena de herramientas compartida que toda la industria pudo adoptar, mejorar y estandarizar.

“Docker” vs. “contenedores”: no es lo mismo

Es fácil confundirlos, pero son distintos:

- Contenedores es el concepto: procesos aislados que usan características del SO (como namespaces y cgroups en Linux) para ejecutar apps con sus dependencias.

- Docker (el proyecto y luego la empresa) fue la experiencia productizada que hizo los contenedores accesibles para desarrolladores cotidianos.

Los contenedores existían en varias formas antes de Docker. Lo que cambió es que Docker empaquetó el flujo en un conjunto amigable de comandos y convenciones: construir una imagen, ejecutar un contenedor, compartirlo con alguien más.

Hitos que cambiaron el trabajo diario de los desarrolladores

Algunos pasos bien conocidos empujaron a Docker de “interesante” a “predeterminado”:

- Un formato simple de construcción (Dockerfile) hizo que empaquetar una app fuera como escribir una receta en lugar de mantener docs frágiles.

- Un artefacto estándar (la imagen) permitió que los equipos trataran los entornos como entregables versionados.

- Compartir fácil vía registros habilitó flujos de “pull y run” entre portátiles, servidores CI y producción.

- Ecosistema y esfuerzos de estandarización ayudaron a que las imágenes y runtimes fueran menos dependientes de un único proveedor y más como una interfaz común de la industria.

El resultado práctico: los desarrolladores dejaron de debatir cómo replicar entornos y empezaron a enviar la misma unidad ejecutable en todas partes.

Contenedores 101: qué son (y qué no son)

Los contenedores son una forma de empaquetar y ejecutar una aplicación para que se comporte igual en tu portátil, en la máquina de un compañero y en producción. La idea clave es aislamiento sin un equipo nuevo completo.

Contenedores vs máquinas virtuales (modelo mental simple)

Una máquina virtual (VM) es como alquilar un apartamento entero: tienes tu propia puerta, tus propias utilidades y tu propia copia del sistema operativo. Por eso las VMs pueden ejecutar distintos tipos de SO lado a lado, pero son más pesadas y suelen tardar más en arrancar.

Un contenedor es como alquilar una habitación cerrada dentro de un edificio compartido: traes tus muebles (código de la app + librerías), pero las utilidades del edificio (el kernel del SO host) se comparten. Sigues teniendo separación de otras habitaciones, pero no inicias un SO completo cada vez.

Cómo aíslan las apps los contenedores (conceptualmente)

En Linux, los contenedores se apoyan en características de aislamiento que:

- dan a los procesos su propia “vista” del sistema (así la app A no ve los archivos y procesos de la app B)

- limitan y contabilizan recursos como CPU y memoria (para que una app ruidosa no deje sin recursos a las demás)

No necesitas conocer los detalles del kernel para usar contenedores, pero ayuda saber que aprovechan funciones del SO—no son magia.

Por qué gustan tanto

Los contenedores se hicieron populares porque son:

- Livianos: más pequeños que imágenes de VM porque no incluyen un SO completo

- Rápidos de arrancar: a menudo segundos (o menos), ideal para escalado y pruebas

- Consistentes: el mismo runtime empaquetado reduce los problemas de “funciona en mi máquina”

Qué no son los contenedores

Los contenedores no son un límite de seguridad por defecto. Como los contenedores comparten el kernel del host, una vulnerabilidad a nivel de kernel puede afectar a múltiples contenedores. También significa que no puedes ejecutar un contenedor Windows en un kernel Linux (y viceversa) sin virtualización adicional.

Así que: los contenedores mejoran el empaquetado y la consistencia—pero aún necesitas prácticas inteligentes de seguridad, parcheo y configuración.

El modelo Docker: Dockerfile, imagen, contenedor

Docker triunfó en parte porque dio a los equipos un modelo mental simple con “partes” claras: un Dockerfile (instrucciones), una imagen (el artefacto construido) y un contenedor (la instancia en ejecución). Una vez entiendes esa cadena, el resto del ecosistema Docker comienza a tener sentido.

Dockerfile: una receta repetible

Un Dockerfile es un archivo de texto plano que describe cómo construir tu entorno de aplicación paso a paso. Piénsalo como una receta de cocina: no alimenta a nadie por sí sola, pero te dice exactamente cómo producir el mismo plato cada vez.

Los pasos típicos en un Dockerfile incluyen: elegir una base (como un runtime), copiar el código de la app, instalar dependencias y declarar el comando a ejecutar.

Imagen vs contenedor: plano vs app en ejecución

Una imagen es el resultado construido de un Dockerfile. Es un paquete con todo lo necesario para ejecutar: tu código, dependencias y valores por defecto de configuración. No está “viva”—es más como una caja sellada que puedes enviar.

Un contenedor es lo que obtienes cuando ejecutas una imagen. Es un proceso vivo con su propio sistema de archivos y ajustes aislados. Puedes iniciarlo, pararlo, reiniciarlo y crear múltiples contenedores desde la misma imagen.

Capas y caché: por qué las compilaciones pueden ser rápidas

Las imágenes se construyen en capas. Cada instrucción en un Dockerfile suele crear una nueva capa, y Docker intenta reutilizar (“cachear”) capas que no han cambiado.

En términos simples: si solo cambias tu código de aplicación, Docker puede reutilizar las capas que instalaron paquetes del sistema y dependencias, haciendo que las reconstrucciones sean mucho más rápidas. Esto también fomenta el reuso entre proyectos: muchas imágenes comparten capas base comunes.

Un flujo completo pequeño

Aquí tienes cómo luce el flujo “receta → artefacto → instancia en ejecución”:

FROM node:20-alpine

WORKDIR /app

COPY package*.json ./

RUN npm ci

COPY . .

CMD ["node", "server.js"]

- Dockerfile: las instrucciones de arriba

- Construir una imagen:

docker build -t myapp:1.0 .

- Ejecutar un contenedor:

docker run --rm -p 3000:3000 myapp:1.0

Esta es la promesa central que Docker popularizó: si puedes construir la imagen, puedes ejecutar la misma cosa de forma fiable—en tu portátil, en CI o en un servidor—sin reescribir los pasos de instalación cada vez.

Del portátil al equipo: registros y compartir imágenes

Construye y gana créditos

Gana créditos creando contenido sobre Koder.ai o invitando a compañeros con tu enlace de referido.

Ejecutar un contenedor en tu portátil es útil—pero no fue el gran avance. El cambio real vino cuando los equipos pudieron compartir exactamente la misma compilación y ejecutarla en cualquier parte, sin discusiones de “funciona en mi máquina”.

Docker hizo que ese compartir se sintiera tan normal como compartir código.

Qué es un registro (en lenguaje llano)

Un registro de contenedores es una tienda para imágenes. Si una imagen es la app empaquetada, un registro es el lugar donde guardas versiones empaquetadas para que otras personas y sistemas las descarguen.

Los registros soportan un flujo sencillo:

- Push: subir una imagen que construiste

- Pull: descargar una imagen que otra persona construyó

- Versionar: conservar múltiples releases nombradas para poder avanzar o retroceder

Los registros públicos (como Docker Hub) facilitaron empezar. Pero la mayoría de equipos rápidamente necesitan un registro que cumpla sus reglas de acceso y requisitos de cumplimiento.

Las imágenes se identifican habitualmente como nombre:tag—por ejemplo myapp:1.4.2. Ese tag es más que una etiqueta: es cómo humanos y automatización acuerdan qué build ejecutar.

Un error común es depender de latest. Suena conveniente, pero es ambiguo: “latest” puede cambiar sin aviso, haciendo que los entornos se desvíen. Un despliegue puede tirar una build más nueva que el anterior—aunque nadie quisiera actualizar.

Mejores prácticas:

- Usa etiquetas de versión explícitas (p. ej.,

1.4.2) para releases

- Considera también etiquetar con el hash del commit para trazabilidad

- Trata los tags como parte del proceso de release, no como un apéndice

Por qué los registros privados importan para equipos reales

En cuanto compartes servicios internos, dependencias pagas o código de la empresa, normalmente quieres un registro privado. Te permite controlar quién puede tirar o subir imágenes, integrar con single sign-on y mantener software propietario fuera de índices públicos.

Este es el salto de “portátil a equipo”: una vez que las imágenes viven en un registro, tu sistema CI, tus compañeros y tus servidores de producción pueden tirar el mismo artefacto—y el despliegue deja de ser improvisado y pasa a ser repetible.

Por qué los contenedores encajan tan bien con CI/CD

CI/CD funciona mejor cuando puede tratar tu aplicación como una única “cosa” repetible que avanza por etapas. Los contenedores ofrecen exactamente eso: un artefacto empaquetado (la imagen) que puedes construir una vez y ejecutar muchas veces, con muchas menos sorpresas.

Desarrollo local estandarizado

Antes de los contenedores, los equipos intentaban igualar entornos con docs largos y scripts compartidos. Docker cambió el flujo por defecto: clona el repo, construye una imagen, ejecuta la app. Los mismos comandos tienden a funcionar en macOS, Windows y Linux porque la aplicación corre dentro del contenedor.

Esa estandarización acelera la incorporación. Los nuevos compañeros pasan menos tiempo instalando dependencias y más tiempo entendiendo el producto.

"Construir una vez, ejecutar en cualquier parte" en la práctica

Un pipeline CI/CD sólido busca un único output. Con contenedores, el output es una imagen etiquetada con una versión (a menudo ligada al SHA del commit). Esa misma imagen se promociona de dev → test → staging → producción.

En lugar de reconstruir la app de forma distinta por entorno, cambias configuración (variables de entorno) manteniendo el artefacto idéntico. Esto reduce la deriva y facilita depurar lanzamientos.

Encaje natural en pipelines de CI

Los contenedores mapean limpiamente a pasos del pipeline:

- Build: crear la imagen desde un Dockerfile

- Test: ejecutar tests unitarios/integración dentro del contenedor

- Scan: comprobar la imagen por vulnerabilidades conocidas y paquetes inseguros

- Deploy: pushear al registro y luego tirar y ejecutar en el siguiente entorno

Como cada paso corre contra la misma app empaquetada, los fallos son más significativos: un test que pasó en CI probablemente se comporte igual tras el despliegue.

Si estás afinando tu proceso, vale la pena definir reglas simples (convenciones de tags, firmado de imágenes, escaneos básicos) para que el pipeline sea predecible. Puedes ampliar esto según crezca el equipo (ver /blog/common-mistakes-and-how-to-avoid-them).

Donde esto conecta con flujos modernos de “vibe-coding”: plataformas como Koder.ai pueden generar e iterar aplicaciones full-stack (React en web, Go + PostgreSQL en backend, Flutter en móvil) mediante una interfaz de chat—pero aun así necesitas una unidad de empaquetado fiable para pasar de “funciona” a “se envía”. Tratar cada build como una imagen de contenedor versionada mantiene incluso el desarrollo asistido por IA alineado con las expectativas de CI/CD: builds reproducibles, despliegues previsibles y releases listos para rollback.

Ejecutar a escala: por qué apareció Kubernetes

Lanza una app demo hoy

Crea una app pequeña en el chat y comprueba lo rápido que puedes obtener un servicio listo para desplegar.

Docker hizo práctico empaquetar una app una vez y ejecutarla en cualquier parte. El siguiente desafío apareció pronto: los equipos no ejecutaban un contenedor en un portátil—ejecutaban docenas (luego cientos) de contenedores en muchas máquinas, con versiones que cambiaban constantemente.

En ese punto, “arrancar un contenedor” deja de ser lo difícil. Lo difícil pasa a ser gestionar una flota: decidir dónde debe ejecutarse cada contenedor, mantener el número correcto de réplicas en línea y recuperarse automáticamente cuando algo falla.

Por qué aparecieron los orquestadores

Cuando tienes muchos contenedores en muchos servidores, necesitas un sistema que los coordine. Eso es lo que hacen los orquestadores: tratan tu infraestructura como una piscina de recursos y trabajan continuamente para mantener las aplicaciones en el estado deseado.

Kubernetes se convirtió en la respuesta más común (aunque no la única). Proporciona un conjunto compartido de conceptos y APIs en los que muchos equipos y plataformas se han estandarizado.

Docker vs. orquestación: trabajos distintos

Ayuda separar responsabilidades:

- Docker (y herramientas similares) se enfocan en construir imágenes y ejecutar contenedores en una sola máquina.

- Kubernetes se enfoca en ejecutar contenedores a escala: en múltiples máquinas, zonas de disponibilidad y durante actualizaciones continuas.

Ideas centrales que Kubernetes puso sobre la mesa

Kubernetes introdujo (y popularizó) capacidades prácticas que los equipos necesitaban cuando los contenedores dejaron de ser de un solo host:

- Scheduling: ubicar contenedores en máquinas adecuadas según CPU/memoria y restricciones.

- Scaling: aumentar o disminuir el número de copias en función de la demanda.

- Service discovery y balanceo de carga: ofrecer formas estables para que los contenedores se encuentren aunque cambien IPs o instancias.

- Autoreparación: reiniciar contenedores caídos, reemplazar instancias no saludables y reprogramar trabajo cuando una máquina falla.

En resumen, Docker hizo la unidad portátil; Kubernetes ayudó a hacerla operable—de forma predecible y continua—cuando hay muchas unidades en movimiento.

Cómo cambiaron los contenedores la arquitectura de aplicaciones

Los contenedores no solo cambiaron cómo desplegamos software: también empujaron a los equipos a diseñar el software de forma distinta.

“Microservicios más fáciles de enviar” (sin prohibir monolitos)

Antes de los contenedores, dividir una app en muchos servicios pequeños a menudo multiplicaba el dolor operativo: distintos runtimes, dependencias en conflicto y despliegues complicados. Los contenedores redujeron esa fricción. Si cada servicio se entrega como una imagen y se ejecuta igual, crear un nuevo servicio se siente menos arriesgado.

Dicho esto, los contenedores también funcionan bien para monolitos. Un monolito en un contenedor puede ser más simple que una migración a microservicios a medias: una unidad desplegable, un conjunto de logs, una palanca de escalado. Los contenedores no imponen un estilo: hacen que varios estilos sean más manejables.

Interfaces estándar se volvieron la norma

Las plataformas de contenedores alentaron a que las apps se comportaran como “cajas negras” bien portadas con entradas y salidas previsibles. Convenciones comunes incluyen:

- Puertos: la app escucha en un puerto conocido y la plataforma enruta el tráfico.

- Variables de entorno: la configuración se inyecta en tiempo de ejecución, no se hornea en el código.

- Volúmenes: los datos persistentes se montan, haciendo que el contenedor sea más fácil de reemplazar.

Estas interfaces hicieron más sencillo intercambiar versiones, hacer rollback y ejecutar la misma app en portátiles, CI y producción.

Nuevos patrones (y nuevas tentaciones)

Los contenedores popularizaron bloques reutilizables como sidecars (un contenedor auxiliar junto al principal para logging, proxies o certificados). También reforzaron la guía de un proceso por contenedor—no es una regla estricta, pero sí un buen defecto para claridad, escalado y diagnósticos.

La trampa principal es sobre-segmentar. Solo porque puedas convertir todo en un servicio no significa que debas hacerlo. Si un “microservicio” añade más coordinación, latencia y sobrecarga de despliegue que lo que elimina, mantenlo unido hasta que haya un límite claro—como diferentes necesidades de escalado, propiedad o aislamiento de fallos.

Seguridad y confianza: lo que los contenedores no solucionan automáticamente

Los contenedores facilitan enviar software, pero no lo hacen más seguro por arte de magia. Un contenedor sigue siendo código más dependencias, y puede estar mal configurado, desactualizado o ser malicioso—sobre todo cuando las imágenes se tiran desde Internet sin el escrutinio adecuado.

La confianza empieza con la procedencia de la imagen

Si no puedes responder “¿De dónde vino esta imagen?” ya estás asumiendo un riesgo. Los equipos suelen avanzar hacia una cadena clara de custodia: construir imágenes en CI controlado, firmar o atestiguar lo que se construyó y llevar un registro de qué entró en la imagen (dependencias, versión de la base, pasos de build).

Ahí también ayudan los SBOMs (Software Bills of Materials): hacen visible y auditable el contenido de tu contenedor.

El escaneo es el siguiente paso práctico. Escanea regularmente las imágenes por vulnerabilidades conocidas, pero trata los resultados como insumos para decisiones—no como una garantía de seguridad.

Menor privilegio y secretos: trampas comunes

Un error frecuente es ejecutar contenedores con permisos demasiado amplios—root por defecto, capacidades Linux extras, red del host o modo privilegiado “porque funciona”. Cada uno amplía el radio de impacto si algo sale mal.

Los secretos son otra trampa. Variables de entorno, archivos de configuración incrustados o .env comprometidos pueden filtrar credenciales. Prefiere stores de secretos o los secretos gestionados por el orquestador y rota secretos como si la exposición fuera inevitable.

Riesgos en tiempo de ejecución que se pasan por alto

Incluso imágenes “limpias” pueden ser peligrosas en tiempo de ejecución. Vigila sockets Docker expuestos, montajes de volúmenes demasiado permisivos y contenedores que pueden acceder a servicios internos que no necesitan.

Recuerda también: parchear el host y el kernel sigue siendo importante—los contenedores comparten el kernel.

Mentalidad de checklist simple

Piensa en cuatro fases:

- Build: builds controlados, SBOMs, escaneo, minimizar imágenes base

- Store: registros privados, control de acceso, políticas de inmutabilidad

- Run: mínimo privilegio, límites de red y recursos, nada de secretos por todos lados

- Monitor: logs, alertas, detección de anomalías, rebuild y redeploy rápidos

Los contenedores reducen la fricción—pero la confianza aún debe ganarse, verificarse y mantenerse continuamente.

Errores comunes y cómo evitarlos

De la especificación a Flutter

Prototipa una app móvil en Flutter a partir de una especificación sencilla y exporta el código fuente.

Docker hace que empaquetar sea predecible, pero solo si lo usas con disciplina. Muchos equipos tropiezan con los mismos baches—y luego culpan a “los contenedores” por problemas que son, en realidad, cuestiones de flujo de trabajo.

Antipatrones que ralentizan a todos

Un error clásico es construir imágenes enormes: usar imágenes base con SO completo, instalar herramientas de build que no necesitas en runtime y copiar el repo entero (incluyendo tests, docs y node_modules). El resultado son descargas lentas, CI lento y mayor superficie para problemas de seguridad.

Otro problema común son builds lentos que rompen la caché. Si copias todo el árbol de código antes de instalar dependencias, cada pequeño cambio de código fuerza reinstalar dependencias completas.

Finalmente, los equipos a menudo usan tags confusos o flotantes como latest o prod. Eso hace los rollbacks dolorosos y convierte los despliegues en conjeturas.

“Funciona localmente pero no en producción”: causas reales

Suele deberse a diferencias en configuración (vars o secretos faltantes), red (hostnames, puertos, proxies, DNS distintos) o almacenamiento (datos escritos en el filesystem del contenedor en vez de un volumen, o permisos de archivos distintos entre entornos).

Arreglos prácticos que puedes aplicar hoy

Usa imágenes base slim cuando sea posible (o distroless si el equipo está listo). Fija versiones para imágenes base y dependencias clave para que las builds sean reproducibles.

Adopta builds multi-stage para mantener compiladores y herramientas de build fuera de la imagen final:

FROM node:20 AS build

WORKDIR /app

COPY package*.json ./

RUN npm ci

COPY . .

RUN npm run build

FROM node:20-slim

WORKDIR /app

COPY --from=build /app/dist ./dist

CMD ["node","dist/server.js"]

Además, etiqueta imágenes con algo trazable, como un SHA de git (y opcionalmente una etiqueta amigable para humanos).

Cuando no conviene contenedorizarde

Si una app es realmente simple (un binario estático único, se ejecuta raramente, sin necesidades de escalado), los contenedores pueden añadir sobrecarga. Los sistemas legacy con acoplamiento al SO o controladores hardware especializados también pueden ser malas parejas—a veces una VM o un servicio gestionado es la opción más limpia.

Qué significa hoy “unidad por defecto”—y qué hacer a continuación

Los contenedores se convirtieron en el valor predeterminado porque resolvieron un dolor muy específico y repetible: conseguir que la misma app se ejecute de la misma forma en portátiles, servidores de prueba y producción. Empaquetar la app y sus dependencias juntos hizo los despliegues más rápidos, los rollbacks más seguros y los traspasos entre equipos menos frágiles.

Igual de importante, los contenedores estandarizaron el flujo: construir una vez, enviar, ejecutar.

Qué significa “predeterminado” en la práctica

“Predeterminado” no significa que todo corra en Docker en todas partes. Significa que la mayoría de pipelines modernos tratan la imagen de contenedor como el artefacto primario—más que un ZIP, una snapshot de VM o un conjunto de pasos manuales.

Ese predeterminado suele incluir tres piezas que trabajan juntas:

- Imágenes: salidas de build inmutables etiquetadas con versiones (y preferiblemente un SHA de commit).

- Registros: un lugar compartido para almacenar y recuperar imágenes (privado o público), permitiendo que equipos reutilicen el mismo artefacto en entornos.

- Orquestación: un scheduler (a menudo Kubernetes) que ejecuta contenedores de forma fiable, reemplaza instancias fallidas y escala.

Pasos siguientes que puedes dar esta semana

Empieza pequeño y céntrate en la repetibilidad.

- Aprende lo básico de Dockerfile: mantén imágenes minimalistas, fija versiones de la base y estructura las capas para que las reconstrucciones sean rápidas. Añade un

.dockerignore pronto.

- Usa un registro con intención: publica imágenes con tags significativos (p. ej.,

1.4.2, main, sha-…) y define quién puede push vs pull.

- Adopta reglas de build en CI: construye imágenes en CI, ejecuta tests dentro del contexto del contenedor y promueve la misma imagen hacia staging y producción (sin reconstruir por entorno).

Si experimentas con formas más rápidas de construir software (incluyendo enfoques asistidos por IA), mantén la misma disciplina: versiona la imagen, almacénala en un registro y haz que los despliegues promuevan ese único artefacto. Esa es una razón por la que equipos que usan Koder.ai siguen beneficiándose de una entrega centrada en contenedores—iteración rápida está bien, pero la reproducibilidad y la capacidad de rollback son lo que la hace segura.

Mantén una visión equilibrada

Los contenedores reducen los problemas de “funciona en mi máquina”, pero no sustituyen las buenas prácticas operativas. Aún necesitas monitorización, respuesta a incidentes, gestión de secretos, parcheo, control de accesos y una propiedad clara.

Trata los contenedores como un poderoso estándar de empaquetado—no como un atajo a la disciplina de ingeniería.