Por qué Shannon sigue importando en la tecnología cotidiana

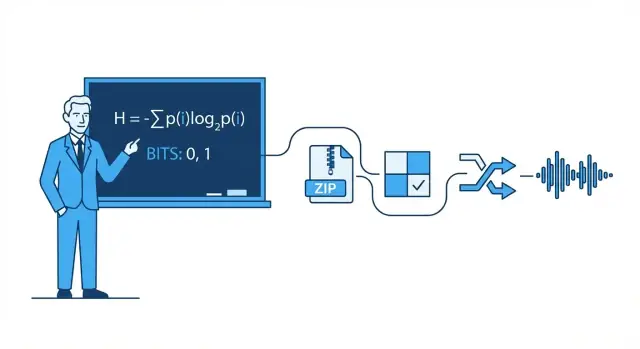

Usas las ideas de Claude Shannon cada vez que envías un mensaje, ves un vídeo o te conectas por Wi‑Fi. No porque tu teléfono "conozca a Shannon", sino porque los sistemas digitales modernos se construyen alrededor de una promesa simple: podemos convertir mensajes del mundo real en bits, mover esos bits por canales imperfectos y aun así recuperar el contenido original con alta fiabilidad.

La teoría de la información es la matemática de los mensajes: cuánto grado de elección (incertidumbre) contiene un mensaje, cuán eficientemente puede representarse y cuán fiable es su transmisión cuando el ruido, la interferencia y la congestión interfieren.

Hay matemáticas detrás, pero no necesitas ser matemático para entender la intuición práctica. Usaremos ejemplos cotidianos—como por qué algunas fotos se comprimen mejor que otras, o por qué una llamada puede sonar bien aun cuando la señal es débil—para explicar las ideas sin fórmulas pesadas.

Los cuatro pilares que verás por todas partes

Este artículo gira alrededor de cuatro pilares inspirados en Shannon que aparecen en la tecnología moderna:

- Compresión: reducir datos (audio, vídeo, archivos) sin perder lo que importa.

- Corrección de errores: añadir justos los suficientes bits extra para detectar y arreglar fallos.

- Confiabilidad en redes: lidiar con paquetes perdidos usando reintentos, orden y compensaciones de rendimiento.

- Comunicación digital de extremo a extremo: ver la cadena completa desde la fuente (tu mensaje) hasta el canal (Wi‑Fi, celular, fibra) y de vuelta.

Qué podrás razonar después

Al final deberías poder pensar con claridad sobre compensaciones reales: por qué mayor calidad de vídeo necesita más ancho de banda, por qué “más barras” no siempre significa internet más rápido, por qué algunas aplicaciones parecen instantáneas mientras otras hacen buffering, y por qué todo sistema tiene límites—especialmente el famoso límite de Shannon sobre cuánto dato fiable puede llevar un canal.

Claude Shannon en una página: la idea central

En 1948, el matemático e ingeniero Claude Shannon publicó un artículo con un título modesto—A Mathematical Theory of Communication—que cambió silenciosamente cómo pensamos en el envío de datos. En lugar de tratar la comunicación como un arte, la trató como un problema de ingeniería: una fuente produce mensajes, un canal los transporta, el ruido los corrompe y un receptor intenta reconstruir lo enviado.

El movimiento clave de Shannon fue definir la información de una manera medible y útil para las máquinas. En su marco, la información no trata de lo importante que parece un mensaje, de lo que significa o de si es verdadero. Trata de cuánto sorprende—cuánta incertidumbre se elimina cuando conoces el resultado.

Si ya sabes lo que va a pasar, el mensaje aporta casi ninguna información. Si realmente estás inseguro, conocer el resultado aporta más.

El bit: la unidad más simple que puedes contar

Para medir información, Shannon popularizó el bit (abreviatura de binary digit). Un bit es la cantidad de información necesaria para resolver una incertidumbre simple de tipo sí/no.

Ejemplo: si pregunto “¿Está la luz encendida?” y no tienes idea por adelantado, la respuesta (sí o no) puede considerarse como 1 bit de información. Muchos mensajes reales pueden descomponerse en largas secuencias de estas elecciones binarias, por eso todo, desde texto a fotos y audio, puede almacenarse y transmitirse como bits.

Qué hará (y qué no hará) este artículo

Este artículo se centra en la intuición práctica detrás de las ideas de Shannon y por qué aparecen en todas partes: compresión (hacer archivos más pequeños), corrección de errores (arreglar corrupciones), confiabilidad de redes (reintentos y rendimiento) y capacidad de canal (qué tan rápido puedes enviar datos por un enlace ruidoso).

Lo que no hará es recorrer pruebas matemáticas complejas. No necesitas matemáticas avanzadas para entender la conclusión: una vez que puedes medir información, puedes diseñar sistemas que se acerquen a la eficiencia posible—a menudo sorprendentemente cerca de los límites teóricos que describió Shannon.

Bits, símbolos y códigos: vocabulario práctico

Antes de hablar de entropía, compresión o corrección de errores, ayuda fijar unos cuantos términos cotidianos. Las ideas de Shannon son más fáciles cuando puedes nombrar las piezas.

Símbolos, alfabetos y mensajes

Un símbolo es un “token” de un conjunto acordado. Ese conjunto es el alfabeto. En texto en inglés, el alfabeto puede ser letras (más espacio y puntuación). En un archivo informático, el alfabeto podría ser valores de byte 0–255.

Un mensaje es una secuencia de símbolos de ese alfabeto: una palabra, una frase, un archivo de imagen o una secuencia de muestras de audio.

Para mantenerlo concreto, imagina un alfabeto pequeño: {A, B, C}. Un mensaje podría ser:

A A B C A B A ...

Bits y códigos

Un bit es un dígito binario: 0 o 1. Los ordenadores almacenan y transmiten bits porque el hardware puede distinguir con fiabilidad dos estados.

Un código es una regla para representar símbolos usando bits (u otros símbolos). Por ejemplo, con nuestro alfabeto {A, B, C} una posible codificación binaria es:

Ahora cualquier mensaje formado por A/B/C puede convertirse en un flujo de bits.

Codificación vs. compresión vs. encriptación

Estos términos a menudo se confunden:

- Codificación: traducir datos a un formato elegido para que puedan almacenarse/transmitirse/procesarse (como mapear A/B/C a bits o convertir texto a UTF‑8).

- Compresión: codificación que usa menos bits en promedio explotando patrones y frecuencias desiguales.

- Encriptación: ofuscar datos con una clave para que terceros no puedan leerlos; se trata de secreto, no de tamaño.

Una intuición rápida de probabilidad

Los mensajes reales no son aleatorios: algunos símbolos aparecen más que otros. Supón que A ocurre el 70% del tiempo, B el 20% y C el 10%. Un buen esquema de compresión normalmente dará patrones de bits más cortos a símbolos comunes (A) y más largos a los raros (C). Esa “desigualdad” es lo que las secciones posteriores cuantificarán con entropía.

Entropía: medir la sorpresa (y por qué predice la compresibilidad)

La idea más famosa de Shannon es la entropía: una manera de medir cuánta “sorpresa” hay en una fuente de información. No sorpresa como emoción, sino sorpresa como imprevisibilidad. Cuanto más impredecible sea el siguiente símbolo, más información aporta cuando llega.

Imagina que observas lanzamientos de moneda.

- Moneda justa (50/50 caras/cruces): cada lanzamiento es difícil de predecir. Cara es tan probable como cruz, así que te sorprende cualquiera de los dos; eso implica alta entropía.

- Moneda cargada (por ejemplo 95% caras, 5% cruces): la mayoría de lanzamientos son caras. Tras unos cuantos lanzamientos empiezas a esperar caras, así que ver una cara aporta poca información. Solo la rara cruz es sorprendente. En promedio, la secuencia tiene baja entropía.

Este encuadre de “sorpresa media” coincide con patrones cotidianos: un archivo de texto con espacios y palabras comunes repetidas es más fácil de predecir que uno de caracteres aleatorios.

Por qué la previsibilidad implica compresibilidad

La compresión funciona asignando códigos más cortos a símbolos comunes y códigos más largos a los raros. Si la fuente es predecible (baja entropía), puedes usar mucho los códigos cortos y ahorrar espacio. Si se acerca al azar (alta entropía), queda menos margen para reducirlo porque nada aparece lo bastante a menudo para explotarlo.

Shannon mostró que la entropía establece un referente conceptual: es la cota inferior de la media de bits por símbolo que puedes lograr al codificar datos de esa fuente.

Importante: la entropía no es un algoritmo de compresión. No te indica exactamente cómo comprimir un archivo. Te dice lo que es teóricamente posible—y cuándo ya estás cerca del límite.

Compresión: convertir entropía en archivos más pequeños

La compresión ocurre cuando tomas un mensaje que podría describirse con menos bits y realmente lo haces. La idea clave de Shannon es que los datos con menor entropía (más previsibilidad) tienen “espacio” para reducirse, mientras que los de alta entropía (cercanos al azar) no.

Por qué los patrones y las frecuencias desiguales se comprimen bien

Los patrones repetidos son la ganancia obvia: si un archivo contiene las mismas secuencias una y otra vez, puedes almacenar la secuencia una vez y referenciarla muchas veces. Pero incluso sin repeticiones claras, las frecuencias sesgadas de símbolos ayudan.

Si un texto usa “e” mucho más que “z”, o un log repite las mismas marcas de tiempo y palabras clave, no necesitas gastar el mismo número de bits en cada carácter. Cuanto más desiguales sean las frecuencias, más predecible será la fuente—y más compresible.

Codificación de longitud variable (la intuición central)

Una forma práctica de explotar frecuencias sesgadas es la codificación de longitud variable:

- Los símbolos frecuentes obtienen códigos cortos

- Los símbolos raros obtienen códigos largos

Hecho con cuidado, esto reduce los bits medios por símbolo sin pérdida de información.

Los compresores sin pérdida reales suelen mezclar varias ideas, pero comúnmente escucharás estas familias:

- Codificación de Huffman: construye una tabla eficiente “corta-para-común”

- Codificación aritmética: empaqueta símbolos en un rango fraccional, a menudo acercándose más al límite de entropía

- Métodos LZ (Lempel–Ziv): encuentran subcadenas repetidas y las reemplazan por referencias (usados en muchos formatos estilo ZIP)

Sin pérdida vs. con pérdida (ZIP vs. JPEG/MP3)

La compresión sin pérdida reproduce el original perfectamente (p. ej., ZIP, PNG). Es esencial para software, documentos y todo donde un bit incorrecto importa.

La compresión con pérdida descarta deliberadamente información que las personas suelen no notar (p. ej., JPEG para imágenes, MP3/AAC para audio). El objetivo cambia de “recuperar los mismos bits” a “mantener la misma experiencia”, logrando archivos mucho más pequeños al eliminar detalles perceptualmente menores.

Ocurren errores: por qué la redundancia es útil

Valida en producción

Despliega y hospeda tu versión para ver cómo se comporta en redes reales.

Todo sistema digital parte de una suposición frágil: un 0 permanece 0 y un 1 permanece 1. En realidad, los bits pueden invertirse.

De dónde vienen los errores

En transmisión, interferencias eléctricas, señales Wi‑Fi débiles o ruido de radio pueden empujar una señal por encima de un umbral y hacer que el receptor la interprete mal. En almacenamiento, pequeños efectos físicos—desgaste en memoria flash, arañazos en medios ópticos o incluso radiación—pueden cambiar una carga o un estado magnético.

Como los errores son inevitables, los ingenieros añaden intencionalmente redundancia: bits extra que no llevan “nueva” información, pero ayudan a detectar o reparar daños.

Redundancia simple que ya has usado

Bit de paridad (detección rápida). Añadir un bit extra para que el número total de 1s sea par (paridad par) o impar (paridad impar). Si un solo bit se invierte, la comprobación de paridad falla.

- Fortaleza: barato y rápido.

- Límite: normalmente no indica qué bit está mal, y dos inversiones pueden cancelarse y parecer “bien”.

Checksum (mejor detección por bloques). En lugar de un bit, calcula un número resumen pequeño de un paquete o archivo (p. ej., checksum aditivo, CRC). El receptor lo recalcula y compara.

- Fortaleza: detecta muchos errores multi‑bit en un bloque.

- Límite: sigue siendo solo detección; si falla, normalmente necesitas reintento o una copia de respaldo.

Código de repetición (corrección simple). Envía cada bit tres veces: 0 se convierte en 000, 1 en 111. El receptor usa voto por mayoría.

- Fortaleza: puede corregir una inversión única en cada grupo de tres.

- Límite: extremadamente ineficiente—triple los datos.

Detección vs. corrección (y cuándo usar cada una)

La detección de errores responde: “¿algo falló?” Es común cuando los reintentos son baratos—como paquetes de red que pueden reenviarse.

La corrección de errores responde: “¿cuáles eran los bits originales?” Se usa cuando reenviar es caro o imposible—como audio en streaming por un enlace ruidoso, comunicación espacial profunda o lectura de almacenamiento cuando volver a leer puede igualmente fallar.

La redundancia parece derrochadora, pero es la razón por la que los sistemas modernos pueden ser rápidos y fiables a pesar del hardware imperfecto y los canales ruidosos.

Capacidad de canal y el límite de Shannon (sin matemáticas pesadas)

Cuando envías datos por un canal real—Wi‑Fi, celular, un cable USB, incluso un disco duro—el ruido y la interferencia pueden invertir bits o emborronar símbolos. La gran promesa de Shannon fue sorprendente: la comunicación fiable es posible, incluso sobre canales ruidosos, siempre que no intentes meter demasiada información.

Capacidad de canal en términos sencillos

La capacidad de canal es el “límite de velocidad” del canal: la tasa máxima (bits por segundo) que puedes transmitir con errores llevados arbitrariamente cerca de cero, dado el nivel de ruido y restricciones como ancho de banda y potencia.

No es lo mismo que la tasa de símbolos bruta (qué tan rápido cambias una señal). Se trata de cuánto significado sobrevive al ruido—una vez que incluyes codificación inteligente, redundancia y decodificación.

El límite de Shannon: una frontera que los ingenieros persiguen

El límite de Shannon es el nombre práctico que la gente da a esta frontera:

- por debajo de él, en teoría puedes hacer la comunicación tan fiable como quieras;

- por encima, no puedes—los errores permanecen sin importar cuán ingenioso seas.

Los ingenieros dedican mucho esfuerzo a acercarse a ese límite con mejor modulación y códigos correctores. Sistemas modernos como LTE/5G y Wi‑Fi usan codificación avanzada para operar cerca de ese borde en lugar de desperdiciar mucha potencia de señal o ancho de banda.

La compensación clave (tasa vs. probabilidad de error)

Piénsalo como empacar objetos en un camión que va por un camino lleno de baches:

- Empacas demasiado apretado (tasa por encima de la capacidad) y algunos objetos siempre se romperán (un nivel de error distinto de cero).

- Empacas con espacio y acolchado (tasa por debajo de la capacidad) y puedes hacer que las roturas sean tan raras como quieras—a costa de menor rendimiento o más redundancia.

Shannon no nos dio un “mejor código” único, pero probó que la frontera existe—y que merece la pena acercarse a ella.

Códigos correctores de errores en sistemas reales

Diseña APIs fiables

Crea una API en Go y PostgreSQL para gestionar paquetes, sumas de verificación y reintentos de forma ordenada.

El teorema del canal ruidoso de Shannon se resume a menudo como una promesa: si envías datos por debajo de la capacidad de un canal, existen códigos que pueden hacer los errores arbitrariamente raros. La ingeniería real consiste en convertir esa “prueba de existencia” en esquemas prácticos que quepan en chips, baterías y plazos.

La caja de herramientas práctica: bloques, entrelazado y mejores estimaciones

La mayoría de los sistemas reales usan códigos por bloques (protegen un trozo de bits a la vez) o códigos orientados a flujo (protegen una secuencia continua).

Con códigos por bloques añades redundancia diseñada a cada bloque para que el receptor pueda detectar y corregir errores. Con entrelazado, reordenas los bits/símbolos transmitidos para que un estallido de ruido (muchos errores seguidos) se disperse en errores más pequeños y corregibles a través de varios bloques—crucial en inalámbrico y almacenamiento.

Otra gran división es cómo el receptor “decide” lo que escuchó:

- Decisiones duras (hard decisions): cada señal recibida se convierte en 0 o 1 de inmediato.

- Decisiones suaves (soft decisions): el receptor también conserva confianza (p. ej., “esto probablemente es un 1, pero no estoy seguro”).

Las decisiones suaves entregan más información al decodificador y pueden mejorar significativamente la fiabilidad, sobre todo en Wi‑Fi y celular.

Códigos que ya has usado

- Reed–Solomon: trabajan sobre símbolos (no bits individuales) y son excelentes contra ráfagas. Se usan en códigos QR, CD/DVD y algunos sistemas de difusión/almacenamiento.

- Convolucionales: elección clásica para flujos continuos; comunes históricamente en enlaces satelitales.

- Códigos Turbo: un gran salto en los 90, muy usados en 3G/4G.

- LDPC (Low‑Density Parity‑Check): códigos por bloques modernos y muy eficientes usados en Wi‑Fi, 5G y muchos sistemas de alto rendimiento.

Dónde importan

Desde comunicación espacial profunda (donde reenviar es caro o imposible) hasta satélites, Wi‑Fi y 5G, los códigos correctores son el puente práctico entre la teoría de Shannon y la realidad de los canales ruidosos—intercambiando bits y cómputo adicional por menos llamadas caídas, descargas más rápidas y enlaces más fiables.

Confiabilidad en redes: paquetes, reintentos y rendimiento

Internet funciona aun cuando los enlaces individuales son imperfectos. El Wi‑Fi se desvanece, la señal móvil se bloquea y cobre y fibra aún sufren ruido, interferencias y fallos esporádicos. El mensaje central de Shannon—el ruido es inevitable, pero la fiabilidad es alcanzable—aparece en redes como una mezcla cuidadosa de detección/corrección de errores y retransmisión.

Paquetes: pequeñas apuestas en lugar de una grande

Los datos se dividen en paquetes para que la red pueda enrutar alrededor de problemas y recuperarse de pérdidas sin reenviar todo. Cada paquete lleva bits extra (cabeceras y sumas de verificación) que ayudan al receptor a decidir si lo recibido es fiable.

Un patrón común es ARQ (Automatic Repeat reQuest):

- El receptor comprueba un paquete (típicamente con checksum/CRC).

- Si parece correcto, envía un acuse de recibo (ACK).

- Si falta o está corrupto, el emisor retransmite tras un tiempo de espera (o tras un NACK).

Corregir vs. retransmitir: la compensación de latencia

Cuando un paquete está mal, tienes dos opciones principales:

- Corregirlo ahora usando corrección hacia adelante (FEC): añadir suficiente redundancia para que el receptor arregle algunos errores sin pedir de nuevo.

- Retransmitir usando ARQ: enviar menos redundancia inicialmente, pero pagar tiempo extra cuando algo falla.

FEC puede reducir la latencia en enlaces donde las retransmisiones son caras (alta latencia, pérdida intermitente). ARQ puede ser eficiente cuando las pérdidas son raras, porque no cargas cada paquete con redundancia fuerte.

Rendimiento, congestión y por qué la fiabilidad no es gratis

Los mecanismos de fiabilidad consumen capacidad: bits extra, paquetes adicionales y espera. Las retransmisiones incrementan la carga, lo que puede empeorar la congestión; la congestión a su vez aumenta retraso y pérdidas, provocando más reintentos.

Un buen diseño de red busca equilibrio: suficiente fiabilidad para entregar datos correctos, manteniendo la sobrecarga baja para que la red mantenga buen throughput bajo condiciones variables.

Comunicación digital de extremo a extremo: de la fuente al canal

Una forma útil de entender los sistemas digitales modernos es como una tubería con dos tareas: hacer el mensaje más pequeño y hacer que el mensaje sobreviva el trayecto. La idea clave de Shannon fue que a menudo puedes pensar en estas tareas como capas separadas—aunque los productos reales a veces las mezclan.

Paso 1: codificación de la fuente (compresión)

Comienzas con una “fuente”: texto, audio, vídeo, lecturas de sensores. La codificación de la fuente elimina estructura predecible para no malgastar bits. Puede ser ZIP para archivos, AAC/Opus para audio o H.264/AV1 para vídeo.

La compresión es donde la entropía aparece en la práctica: cuanto más predecible es el contenido, menos bits necesitas en promedio.

Paso 2: codificación de canal (corrección de errores)

Luego los bits comprimidos deben cruzar un canal ruidoso: Wi‑Fi, celular, fibra, un cable USB. La codificación de canal añade redundancia diseñada para que el receptor detecte y corrija errores. Este es el mundo de CRCs, Reed–Solomon, LDPC y otros métodos de FEC.

La idea de separación de Shannon (un modelo mental útil)

Shannon demostró que, en teoría, puedes diseñar la codificación de fuente para acercarte a la mejor compresión posible y la codificación de canal para acercarte a la mejor fiabilidad hasta la capacidad del canal—de forma independiente.

En la práctica, esta separación sigue siendo una buena forma de depurar sistemas: si el rendimiento es malo, puedes preguntar si pierdes eficiencia en la compresión (codificación de fuente), si la fiabilidad falla en el enlace (codificación de canal), o si pagas demasiada latencia con reintentos y buffering.

Ejemplo concreto: vídeo en streaming por Wi‑Fi

Cuando transmites vídeo, la app usa un códec para comprimir fotogramas. Por Wi‑Fi, los paquetes pueden perderse o corromperse, así que el sistema añade detección de errores, a veces FEC, y luego usa retransmisiones (ARQ) cuando es necesario. Si la conexión empeora, el reproductor puede cambiar a un flujo de menor bitrate.

Los sistemas reales mezclan la separación porque el tiempo importa: esperar reintentos puede causar buffering y las condiciones inalámbricas cambian rápido. Por eso las pilas de streaming combinan decisiones de compresión, redundancia y adaptación—no separadas perfectamente, pero guiadas por el modelo de Shannon.

Conceptos erróneos comunes y compensaciones prácticas

Explora la compresibilidad

Crea un flujo de telemetría o registro y prueba qué se comprime realmente bien.

La teoría de la información se cita mucho y algunas ideas se simplifican en exceso. Aquí hay malentendidos comunes—y las compensaciones reales que hacen los ingenieros al diseñar compresión, almacenamiento y redes.

Falso 1: “Entropía significa aleatoriedad”

En el habla cotidiana, “aleatorio” puede significar “desordenado” o “impredecible”. La entropía de Shannon es más estrecha: mide la sorpresa dada un modelo de probabilidad.

- Una secuencia perfectamente predecible (como todos ceros) tiene baja entropía.

- Una secuencia difícil de predecir dado lo que sabes tiene mayor entropía.

Así que la entropía no es una sensación; es un número ligado a supuestos sobre el comportamiento de la fuente.

Falso 2: “Más compresión siempre es mejor”

La compresión elimina redundancia. La corrección de errores a menudo añade redundancia a propósito para que el receptor pueda arreglar daños.

Eso crea una tensión práctica:

- Si comprimes agresivamente y luego envías por un canal ruidoso, puedes tener menos margen para recuperar daños.

- Los sistemas bien diseñados suelen comprimir primero (eliminar patrones previsibles) y luego añadir redundancia estructurada (códigos correctores) para el canal.

Falso 3: “Podemos ser perfectamente fiables a cualquier velocidad”

La capacidad de canal de Shannon dice que cada canal tiene una tasa máxima fiable dadas unas condiciones de ruido. Por debajo de ese límite, las tasas de error pueden hacerse extremadamente pequeñas con la codificación adecuada; por encima, los errores son inevitables sin importar la técnica.

Por eso “perfectamente fiable a cualquier velocidad” no es posible: aumentar la velocidad suele significar aceptar mayor probabilidad de error, mayor latencia (más retransmisiones) o más sobrecarga (codificación más fuerte).

Lista de comprobación simple para sistemas reales

Al evaluar un producto o arquitectura, pregunta:

- Estadísticas de la fuente: ¿Los datos son predecibles (texto, logs) o ya cercanos al azar (encriptados, comprimidos)?

- Ruido: ¿Qué puede corromperlos—interferencia inalámbrica, bit rot, pérdida de paquetes?

- Presupuesto de latencia: ¿Puedes permitir reintentos y buffering, o debe ser en tiempo real?

- Elección de sobrecarga: ¿Estás gastando bits en ahorro por compresión, en corrección de errores, en retransmisiones o en una mezcla?

Acertar estas cuatro cosas importa más que memorizar fórmulas.

Conclusiones clave y a dónde ir después

El mensaje central de Shannon es que la información puede medirse, moverse, protegerse y comprimirse usando un conjunto pequeño de ideas.

- Un bit es la moneda común que permite tratar texto, audio, vídeo y telemetría por igual una vez codificados.

- La entropía mide cuán impredecible es una fuente y esa imprevisibilidad predice cuánto puede comprimirse.

- El ruido y la pérdida son inevitables, así que los sistemas fiables añaden redundancia mediante detección y códigos correctores de errores.

- La capacidad de canal fija un techo real: más allá de cierta tasa no puedes “esforzarte más” y seguir siendo fiable; debes bajar la tasa, mejorar el canal o cambiar la codificación.

Las redes y sistemas de almacenamiento modernos son esencialmente un continuo de compensaciones entre tasa, fiabilidad, latencia y cómputo.

Nota práctica para quienes construyen productos

Si construyes productos—APIs, funcionalidades de streaming, apps móviles, canalizaciones de telemetría—el marco de Shannon es una lista de verificación útil de diseño: comprime lo que puedas, protege lo que debas y sé explícito sobre el presupuesto de latencia/throughput. Un lugar donde esto aparece de inmediato es cuando prototipas sistemas de extremo a extremo rápidamente y luego iteras: con una plataforma de vibe‑coding como Koder.ai, los equipos pueden crear una app web en React, un backend en Go con PostgreSQL e incluso un cliente móvil en Flutter a partir de una especificación guiada por chat, y probar compensaciones del mundo real (tamaño de payloads, reintentos, comportamiento de buffering) pronto. Funcionalidades como modo de planificación, snapshots y rollback facilitan experimentar con cambios de “mayor fiabilidad vs. menor sobrecarga” sin perder impulso.

Quién debería profundizar

Profundizar paga la pena para:

- Estudiantes que quieren un modelo mental claro que conecte probabilidad con compresión y codificación

- Product managers que hacen compensaciones entre calidad, latencia, ancho de banda y coste

- Ingenieros que trabajan en redes, códecs multimedia, almacenamiento, telemetría o canalizaciones de datos para ML

Para seguir, explora explicaciones relacionadas en /blog, luego consulta /docs para ver cómo nuestro producto expone configuraciones y APIs relacionadas con comunicación y compresión. Si comparas planes o límites de throughput, /pricing es el siguiente paso.