La mayoría de la gente experimenta Internet a través de productos: un sitio web que carga al instante, una videollamada que (mayormente) funciona, un pago que se liquida en segundos. Debajo de esas experiencias están los protocolos—reglas compartidas que permiten que diferentes sistemas intercambien mensajes con la fiabilidad suficiente como para ser útiles.

Un protocolo es como ponerse de acuerdo en un lenguaje común y unas normas de etiqueta para comunicarse: cómo es un mensaje, cómo empiezas y terminas una conversación, qué haces cuando falta algo y cómo sabes para quién va un mensaje. Sin reglas compartidas, cada conexión se convierte en una negociación puntual, y las redes no escalan más allá de círculos pequeños.

A Vint Cerf a menudo se le acredita como uno de los “padres de Internet”, pero es más preciso (y más útil) ver su papel como parte de un equipo que hizo elecciones de diseño pragmáticas—especialmente alrededor de TCP/IP—que convirtieron “redes” en una internetwork. Esas decisiones no eran inevitables. Reflejaban compensaciones: simplicidad vs. características, flexibilidad vs. control, y rapidez de adopción vs. garantías perfectas.

Las plataformas globales de hoy—apps web, servicios móviles, infraestructura en la nube y APIs entre empresas—siguen viviendo o muriendo por la misma idea: si estandarizas los límites correctos, puedes permitir que millones de actores independientes construyan encima sin pedir permiso. Tu teléfono puede hablar con servidores al otro lado del planeta no solo porque el hardware es más rápido, sino porque las reglas de la carretera permanecieron lo bastante estables para que la innovación se acumule.

Esa mentalidad importa incluso cuando “solo” estás construyendo software. Por ejemplo, plataformas de creación rápida como Koder.ai triunfan cuando ofrecen un pequeño conjunto de primitivas estables (proyectos, despliegues, entornos, integraciones) mientras permiten que los equipos iteren rápido en los bordes—ya sea generando un frontend en React, un backend en Go + PostgreSQL, o una app móvil en Flutter.

Qué obtendrás de este artículo

Tocaremos la historia brevemente, pero el foco está en las decisiones de diseño y sus consecuencias: cómo el enmarcado en capas permitió el crecimiento, dónde la entrega “suficientemente buena” desbloqueó nuevas aplicaciones y qué suposiciones tempranas erraron sobre congestión y seguridad. La meta es práctica: tomar el pensamiento de protocolos—interfaces claras, interoperabilidad y compensaciones explícitas—y aplicarlo al diseño moderno de plataformas.

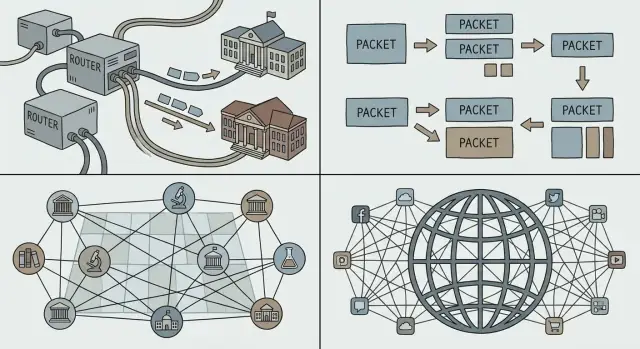

El problema antes de Internet: muchas redes, sin pegamento común

Antes de que “Internet” existiera, había muchas redes—simplemente no una red que todos pudieran compartir. Universidades, laboratorios gubernamentales y empresas construían sus propios sistemas para resolver necesidades locales. Cada red funcionaba, pero rara vez funcionaban juntas.

Una línea de tiempo rápida (alto nivel)

- Finales de los 60: ARPANET demuestra la idea de conectar ordenadores distantes sobre una red compartida.

- Inicios de los 70: Aparecen nuevas redes de paquetes, construidas por organizaciones diferentes con reglas y equipos distintos.

- Finales de los 70–principios de los 80: Los experimentos de internetworking maduran en estándares compartidos que muchas redes pueden adoptar.

Por qué había tantas redes separadas

Existían múltiples redes por razones prácticas, no porque la gente disfrutara la fragmentación. Los operadores tenían objetivos distintos (investigación, fiabilidad militar, servicio comercial), presupuestos diferentes y restricciones técnicas diversas. Los fabricantes de hardware vendían sistemas incompatibles. Algunas redes se optimizaban para enlaces de larga distancia, otras para entornos de campus y otras para servicios especializados.

El resultado fue muchas “islas” de conectividad.

El problema real: interconectar sin reescribir

Si querías que dos redes hablaran, la opción de fuerza bruta era reconstruir un lado para que coincidiera con el otro. Eso rara vez ocurre en el mundo real: es caro, lento y políticamente engorroso.

Lo que hacía falta era un pegamento común—una forma para que redes independientes se interconectaran manteniendo sus elecciones internas. Esto significaba:

- permitir que diferentes redes conserven su propio hardware y prácticas operativas

- habilitar que los mensajes viajen a través de múltiples redes como un único trayecto

- evitar un propietario único o control central en el que todos tengan que confiar

Ese desafío preparó el escenario para las ideas de internetworking que Cerf y otros promoverían: conectar redes en una capa compartida, para que la innovación ocurriera por encima de ella y la diversidad pudiera continuar por debajo.

Conmutación por paquetes: la base de todo

Si alguna vez has hecho una llamada telefónica, entiendes la intuición detrás de la conmutación por circuito: se reserva una “línea” dedicada de extremo a extremo durante la llamada. Eso funciona bien para voz en tiempo real constante, pero es derrochador cuando la conversación está mayormente en silencio.

La conmutación por paquetes invierte el modelo. Una analogía cotidiana es el servicio postal: en lugar de reservar una carretera privada desde tu casa hasta la de un amigo, pones tu mensaje en sobres. Cada sobre (paquete) está etiquetado, enrutado por carreteras compartidas y reensamblado en el destino.

Por qué los paquetes encajan con los ordenadores (y la web)

La mayor parte del tráfico informático es burbujeante. Un correo, una descarga o una página web no son flujos continuos—son ráfagas rápidas de datos, luego nada, luego otra ráfaga. La conmutación por paquetes permite que muchas personas compartan los mismos enlaces de red de forma eficiente, porque la red transporta paquetes de quien tenga algo que enviar en ese momento.

Esta es una razón clave por la que Internet pudo soportar nuevas aplicaciones sin renegociar cómo funcionaba la red subyacente: puedes enviar un mensaje pequeño o un vídeo enorme usando el mismo método básico—divídelo en paquetes y envíalos.

Escalar a través de la distancia—y entre organizaciones

Los paquetes también escalan socialmente, no solo técnicamente. Diferentes redes (gestionadas por universidades, empresas o gobiernos) pueden interconectarse si acuerdan cómo reenviar paquetes. Ningún operador tiene que “poseer” todo el camino; cada dominio puede llevar el tráfico hacia el siguiente.

Las compensaciones: retardo, pérdida y control

Como los paquetes comparten enlaces, puedes experimentar retardo por colas, jitter o incluso pérdida cuando las redes están ocupadas. Esos inconvenientes impulsaron la necesidad de mecanismos de control—retransmisiones, ordenación y control de congestión—para que la conmutación por paquetes se mantenga rápida y justa incluso bajo carga pesada.

Internetworking y la división TCP/IP: un enmarcado en capas simple y poderoso

El objetivo que Cerf y colegas perseguían no era “construir una única red.” Era interconectar muchas redes—universitarias, gubernamentales, comerciales—mientras cada una conservaba su tecnología, operadores y reglas.

Una gran idea: dividir el trabajo en dos

TCP/IP suele describirse como una “suite”, pero el movimiento de diseño crucial es la separación de responsabilidades:

- IP (Internet Protocol) maneja direccionamiento y enrutamiento: llevar paquetes de una red a otra, salto a salto.

- TCP (Transmission Control Protocol) maneja la entrega fiable (cuando la necesitas): ordenación, retransmisión y control de flujo para que las aplicaciones puedan tratar la conexión como una tubería limpia.

Esa división permitió que la “internet” actuara como una tela común de entrega, mientras que la fiabilidad se convirtió en un servicio opcional en capas superiores.

Por qué el enmarcado en capas sigue ganando

El enmarcado en capas hace que los sistemas sean más fáciles de evolucionar porque puedes actualizar una capa sin renegociar todo lo que está encima. Nuevos enlaces físicos (fibra, Wi‑Fi, celular), estrategias de enrutamiento y mecanismos de seguridad pueden llegar con el tiempo—y aun así las aplicaciones siguen hablando TCP/IP y funcionando.

Es el mismo patrón del que dependen los equipos de plataformas: interfaces estables, internos reemplazables.

Las “primitivas suficientemente buenas” crean aplicaciones sorprendentes

IP no promete la perfección; ofrece primitivas simples y universales: “aquí hay un paquete” y “aquí hay una dirección.” Esa contención permitió que florecieran aplicaciones inesperadas—correo, la web, streaming, chat en tiempo real—porque los innovadores podían construir lo que necesitaban en los extremos sin pedir permiso a la red.

Si diseñas una plataforma, esta es una prueba útil: ¿estás ofreciendo unas pocas piezas de construcción fiables, o sobreajustando el sistema al caso de uso favorito de hoy?

IP de mejor esfuerzo: deja la red simple, deja que las apps innoven

La entrega “mejor esfuerzo” es una idea simple: IP intentará mover tus paquetes hacia el destino, pero no promete que lleguen, que lleguen en orden o que lleguen a tiempo. Los paquetes pueden perderse cuando los enlaces están ocupados, retrasarse por congestión o tomar rutas distintas.

Por qué la falta de garantías ayudó a propagar Internet

Esa simplicidad fue una característica, no un defecto. Diferentes organizaciones podían conectar redes muy distintas—líneas caras y de alta calidad en algunos lugares; enlaces ruidosos y de bajo ancho de banda en otros—sin exigir que todo el mundo actualizara a la misma infraestructura premium.

IP de mejor esfuerzo redujo el “precio de entrada” para participar. Universidades, gobiernos, startups y, con el tiempo, hogares pudieron unirse usando la conectividad que podían costear. Si el protocolo central hubiera requerido garantías estrictas de cada red a lo largo de la ruta, la adopción se habría estancado: el eslabón más débil habría bloqueado toda la cadena.

La fiabilidad se movió a los extremos

En lugar de construir un núcleo perfectamente fiable, Internet empujó la fiabilidad hacia los hosts (los dispositivos en cada extremo). Si una aplicación necesita corrección—como transferencias de archivos, pagos o cargar una página web—puede usar protocolos y lógica en los bordes para detectar pérdidas y recuperarse:

- retransmitir datos perdidos

- reordenar paquetes

- verificar integridad y completitud

TCP es el ejemplo clásico: convierte un servicio de paquetes no fiable en un flujo fiable haciendo el trabajo duro en los extremos.

Para los equipos de plataforma, IP de mejor esfuerzo creó una base predecible: en todo el mundo puedes asumir el mismo servicio básico—envía paquetes a una dirección y normalmente llegarán. Esa consistencia hizo posible construir plataformas de software globales que se comportan de forma similar entre países, operadores y hardware.

El principio end-to-end y sus compensaciones en el mundo real

Itera sin miedo

Experimenta de forma segura con instantáneas y reversiones mientras iteras en la arquitectura.

El principio end-to-end es una idea aparentemente simple: mantén el “núcleo” de la red lo más mínimo posible y coloca la inteligencia en los bordes—en los dispositivos y en las aplicaciones.

Por qué los “bordes inteligentes” aceleraron el software

Para los desarrolladores, esta separación fue un regalo. Si la red no necesitaba entender tu aplicación, podías lanzar nuevas ideas sin negociar cambios con cada operador de red.

Esa flexibilidad es una gran razón por la cual las plataformas globales pudieron iterar rápido: correo, la web, voz/video y, más tarde, apps móviles, todas se apoyaron en la misma plomería subyacente.

Las compensaciones: abuso, seguridad y expectativas de QoS

Un núcleo simple también significa que el núcleo no te “protege” por defecto. Si la red principalmente reenvía paquetes, es más fácil para atacantes y abusadores usar esa misma apertura para spam, escaneos, ataques de denegación de servicio y fraude.

La calidad de servicio es otra tensión. Los usuarios esperan videollamadas fluidas y respuestas instantáneas, pero la entrega de mejor esfuerzo puede producir jitter, congestión y rendimiento inconsistente. El enfoque end-to-end empuja muchas soluciones hacia arriba: lógica de reintento, buffering, adaptación de tasa y priorización a nivel de aplicación.

Funcionalidades modernas construidas encima

Mucho de lo que la gente piensa como “Internet” hoy es estructura adicional sobre el núcleo mínimo: CDNs que mueven contenido cerca de los usuarios, cifrado (TLS) para añadir privacidad e integridad, y protocolos de streaming que adaptan la calidad a las condiciones actuales. Incluso capacidades “tipo red”—como protección contra bots, mitigación de DDoS y aceleración de rendimiento—se entregan a menudo como servicios de plataforma en el borde en lugar de integrarse en IP.

Direccionamiento, enrutamiento y DNS: hacer usable una red global

Una red solo puede volverse “global” cuando cada dispositivo puede ser alcanzado con suficiente fiabilidad, sin exigir que cada participante conozca a todos los demás. Ese es el trabajo del direccionamiento, enrutamiento y DNS: tres ideas que convierten un montón de redes conectadas en algo que la gente (y el software) puede usar realmente.

Direccionamiento vs. enrutamiento (versión simple)

Una dirección es un identificador que indica dónde está algo. Con IP, ese “dónde” se expresa en una forma numérica estructurada.

El enrutamiento es el proceso de decidir cómo mover paquetes hacia esa dirección. Los routers no necesitan un mapa completo de cada máquina en la Tierra; solo necesitan suficiente información para reenviar tráfico paso a paso en la dirección correcta.

La clave es que las decisiones de reenvío pueden ser locales y rápidas, mientras que el resultado global sigue pareciendo alcance mundial.

Por qué la jerarquía y la agregación hacen posible la escala

Si cada dirección de dispositivo individual tuviera que figurar en todos los sitios, Internet colapsaría bajo su propia contabilidad. El direccionamiento jerárquico permite agrupar direcciones (por ejemplo, por red o proveedor), de modo que los routers pueden mantener rutas agregadas—una entrada que representa muchos destinos.

Este es el secreto poco glamuroso detrás del crecimiento: tablas de enrutamiento más pequeñas, menos actualizaciones y coordinación más simple entre organizaciones. La agregación es también la razón por la que las políticas de asignación de direcciones IP importan: afectan directamente cuánto cuesta mantener el sistema global coherente.

Los humanos no quieren teclear números, y los servicios no quieren estar atados permanentemente a una sola máquina. DNS (Domain Name System) es la capa de nombres que mapea nombres legibles (como api.example.com) a direcciones IP.

Para los equipos de plataforma, DNS es más que conveniencia:

- Soporta bases de usuarios globales dirigiendo usuarios a regiones cercanas.

- Ayuda a servicios distribuidos a moverse y escalar sin cambiar la configuración de los clientes.

- Habilita apps multi-región y estrategias de conmutación por error donde el nombre permanece estable mientras la infraestructura subyacente cambia.

En otras palabras, el direccionamiento y el enrutamiento hacen que Internet sea alcanzable; DNS la hace usable—y operacionalmente adaptable—a escala de plataforma.

Estándares abiertos e interoperabilidad: la rueda que impulsa la adopción

Define límites estables primero

Usa el Modo de planificación para definir interfaces claras antes de generar código.

Un protocolo solo se convierte en “Internet” cuando muchas redes y productos independientes pueden usarlo sin pedir permiso. Una de las decisiones más inteligentes alrededor de TCP/IP no fue solo técnica—fue social: publicar las especificaciones, invitar a la crítica y permitir que cualquiera las implemente.

RFCs: publicar la receta

La serie Request for Comments (RFC) convirtió ideas de redes en documentos compartidos y citables. En lugar de un estándar caja negra controlado por un proveedor, los RFCs hicieron las reglas visibles: qué significa cada campo, qué hacer en casos límite y cómo mantenerse compatible.

Esa apertura hizo dos cosas. Primero, redujo el riesgo para los adoptantes: universidades, gobiernos y empresas podían evaluar el diseño y construir en torno a él. Segundo, creó un punto de referencia común, de modo que las discrepancias se podían resolver con actualizaciones del texto en lugar de negociaciones privadas.

La interoperabilidad desbloquea ecosistemas

Interoperabilidad es lo que hace que “multi‑vendedor” sea real. Cuando distintos routers, sistemas operativos y aplicaciones pueden intercambiar tráfico de forma predecible, los compradores no quedan atrapados. La competencia se desplaza de “¿a qué red puedes unirte?” a “¿qué producto es mejor?”—lo que acelera la mejora y reduce costos.

La compatibilidad también crea efectos de red: cada nueva implementación TCP/IP hace que toda la red sea más valiosa, porque puede hablar con todo lo demás. Más usuarios atraen más servicios; más servicios atraen más usuarios.

Los límites: los estándares aún requieren trabajo

Los estándares abiertos no eliminan la fricción—la redistribuyen. Los RFCs implican debate, coordinación y a veces cambios lentos, especialmente cuando miles de millones de dispositivos ya dependen del comportamiento actual. La ventaja es que el cambio, cuando ocurre, es legible e implementable ampliamente—preservando el beneficio central: todos todavía pueden conectarse.

Cuando la gente dice “plataforma”, suele referirse a un producto con otras personas construyendo encima: apps de terceros, integraciones y servicios que corren sobre rieles compartidos. En Internet, esos rieles no son la red privada de una sola empresa—son protocolos comunes que cualquiera puede implementar.

TCP/IP no creó la web, la nube o las tiendas de apps por sí mismo. Dio una base estable y universal donde esas cosas podían difundirse de forma fiable.

Una vez que las redes pudieron interconectarse mediante IP y las aplicaciones pudieron apoyarse en TCP para la entrega, fue práctico estandarizar bloques de construcción de nivel superior:

- La web (HTTP + navegadores): un cliente puede alcanzar muchos servidores, en cualquier lugar.

- APIs: los servicios pueden exponer funciones a través de la red de forma predecible.

- SaaS y la nube: el software pasó de “instalado localmente” a “entregado por red”, porque la red era lo bastante consistente como para apostar un negocio sobre ella.

- Ecosistemas y marketplaces de apps: distribución, actualizaciones e integraciones se volvieron expectativas normales.

El regalo de TCP/IP a la economía de plataformas fue previsibilidad: podías construir una vez y alcanzar muchas redes, países y tipos de dispositivos sin negociar conectividad a medida cada vez.

Protocolos estables reducen los costes de cambio

Una plataforma crece más rápido cuando usuarios y desarrolladores sienten que pueden irse—o al menos que no están atrapados. Los protocolos abiertos y ampliamente implementados reducen los costes de cambio porque:

- Los usuarios pueden cambiar de proveedor manteniendo herramientas familiares (el correo es el ejemplo clásico).

- Los desarrolladores pueden reutilizar habilidades y código entre proveedores (una petición sigue siendo una petición).

- Los entrantes pueden interoperar en lugar de empezar desde cero.

Esa interoperabilidad “sin pedir permiso” es por qué los mercados de software globales se formaron alrededor de estándares compartidos en lugar de un único dueño de la red.

Bloques de construcción habilitados por protocolos (ejemplos rápidos)

- HTTP hizo que “obtener un recurso desde cualquier lugar” sea un comportamiento por defecto para el software.

- TLS añadió confidencialidad e integridad para que el comercio y la identidad funcionaran a escala.

- SMTP convirtió el correo en un sistema entre proveedores, no en jardines amurallados.

Estos se sitúan encima de TCP/IP, pero dependen de la misma idea: si las reglas son estables y públicas, las plataformas compiten por producto sin romper la capacidad de conectar.

Realidad a escala: congestión, latencia y la necesidad de resiliencia

La magia de Internet es que funciona a través de océanos, redes móviles, puntos de acceso Wi‑Fi y routers de oficina sobrecargados. La verdad menos mágica: siempre opera bajo restricciones. El ancho de banda es limitado, la latencia varía, los paquetes se pierden o reordenan y la congestión puede aparecer repentinamente cuando mucha gente comparte el mismo camino.

Las restricciones que no se pueden desear fuera

Incluso si tu servicio está “en la nube”, tus usuarios lo experimentan a través de la parte más estrecha de la ruta hacia ellos. Una videollamada en fibra y la misma llamada en un tren abarrotado son productos distintos, porque la latencia (retardo), el jitter (variación) y la pérdida moldean la percepción del usuario.

Control de congestión, conceptualmente

Cuando demasiado tráfico golpea los mismos enlaces, se forman colas y los paquetes caen. Si cada emisor reacciona enviando aún más (o reintentando con demasiada agresividad), la red puede entrar en colapso por congestión—mucho tráfico y poca entrega útil.

El control de congestión es el conjunto de comportamientos que mantienen el reparto justo y estable: sondear capacidad disponible, reducir la velocidad cuando señales de pérdida/latencia indican sobrecarga y luego acelerar con cautela. TCP popularizó este ritmo de “retroceder, luego recuperar” para que la red pudiera seguir siendo simple mientras los extremos se adaptan.

Cómo esto modeló decisiones de producto

Porque las redes son imperfectas, las aplicaciones exitosas hacen trabajo adicional en silencio:

- Caché para evitar viajes caros repetidos (CDNs, cachés locales, respuestas API memoizadas).

- Reintentos con timeouts para recuperarse de pérdidas—pero no instantáneamente ni para siempre.

- Backoff exponencial para que un servicio en apuros no reciba aún más presión durante un incidente.

Diseña como si la red fallara, breve y con frecuencia:

- Haz las operaciones idempotentes para que los reintentos no dupliquen compras o mensajes.

- Prefiere degradación elegante (contenido obsoleto, calidad reducida) sobre la falla total.

- Instrumenta percentiles de latencia y tasas de error por región/tipo de red, no solo promedios.

La resiliencia no es una característica adicional—es el precio de operar a escala de Internet.

Seguridad y confianza: qué suposiciones tempranas fallaron

Ahorra con créditos ganados

Obtén créditos compartiendo lo que construiste o refiriendo a otros creadores.

TCP/IP tuvo éxito porque facilitó que cualquier red se conectara a cualquier otra. El coste oculto de esa apertura es que cualquiera también puede enviarte tráfico—bueno o malo.

La conectividad abierta también posibilita abuso

El diseño temprano de Internet asumía una comunidad relativamente pequeña y orientada a la investigación. Cuando la red se volvió pública, la misma filosofía de “simplemente reenvía paquetes” permitió spam, fraude, entrega de malware, ataques de denegación de servicio e suplantación. IP no verifica quién eres. El correo (SMTP) no exigía probar que poseías la dirección "From". Y los routers nunca estuvieron pensados para juzgar intención.

La seguridad dejó de ser opcional y se volvió fundamental

A medida que Internet se convirtió en infraestructura crítica, la seguridad dejó de ser una característica que se podía añadir y se convirtió en un requisito en cómo se construyen los sistemas: identidad, confidencialidad, integridad y disponibilidad necesitaron mecanismos explícitos. La red permaneció mayormente de mejor esfuerzo y neutral, pero las aplicaciones y plataformas tuvieron que asumir que el cable era no confiable.

Mitigaciones construidas encima (brevemente)

No “arreglamos” IP haciendo que policiara cada paquete. En su lugar, la seguridad moderna se apila encima:

- Cifrado (p. ej., TLS/HTTPS) para evitar espionaje y manipulación

- Autenticación (certificados, tokens firmados, MFA) para probar identidades

- Zero trust para evitar confianza basada en la localización de la red

Trata la red como hostil por defecto. Aplica el principio de menor privilegio en todo: ámbitos estrechos, credenciales de corta duración y valores por defecto fuertes. Verifica identidades e inputs en cada frontera, encripta en tránsito y diseña para casos de abuso—no solo para los caminos felices.

Internet no “ganó” porque todas las redes acordaran el mismo hardware, proveedor o conjunto perfecto de características. Perdura porque decisiones clave de protocolo hicieron que fuera fácil para sistemas independientes conectarse, mejorar y seguir funcionando incluso cuando partes fallaban.

Decisiones de diseño que vale la pena copiar

Enmarcado en capas con costuras claras. TCP/IP separó “mover paquetes” de “hacer aplicaciones fiables.” Ese límite permitió que la red siguiera siendo de propósito general mientras las apps evolucionaban rápido.

Simplicidad en el núcleo. La entrega de mejor esfuerzo significó que la red no necesitaba entender cada necesidad de aplicación. La innovación ocurrió en los bordes, donde nuevos productos podían lanzarse sin negociar con una autoridad central.

Interoperabilidad primero. Especificaciones abiertas y comportamiento predecible hicieron posible que distintas organizaciones construyeran implementaciones compatibles—y crearan un bucle de adopción compuesto.

Traduce esto a estrategia de producto

Si estás construyendo una plataforma, trata la interconexión como una característica, no como un efecto secundario. Prefiere un pequeño conjunto de primitivas que muchos equipos puedan componer en lugar de un gran conjunto de características “inteligentes” que encierren a los usuarios en un único camino.

Diseña para la evolución: asume que clientes serán antiguos, servidores serán nuevos y algunas dependencias estarán parcialmente caídas. Tu plataforma debería degradarse elegantemente y seguir siendo útil.

Si usas un entorno de construcción rápida como Koder.ai, los mismos principios aparecen como capacidades de producto: un paso de planificación claro (para que las interfaces sean explícitas), iteración segura vía snapshots/rollback y comportamiento predecible de despliegue/hosting que permite a múltiples equipos moverse rápido sin romper a los consumidores.

- APIs: Mantén un núcleo estable; añade capacidades opcionales sin romper clientes antiguos.

- Compatibilidad: Versiona deliberadamente; evita eliminar campos/comportamientos; documenta garantías.

- Comportamiento ante fallos: Timeouts, reintentos con backoff, claves de idempotencia y códigos de error claros.

- Interoperabilidad: Publica esquemas/especificaciones; proporciona implementaciones de referencia y tests de conformidad.

- Observabilidad: IDs de correlación, logs estructurados y SLOs que reflejen la experiencia del usuario.

- Control de cambios: Ventanas de deprecación, feature flags y guías de migración.

Lecturas siguientes

- /blog/api-design-basics

- /blog/platform-strategy

- /blog/versioning-and-backward-compatibility

- /blog/graceful-degradation-patterns