Por qué importa la idea de programa almacenado

En el corazón de la computación moderna hay una pregunta sencilla: ¿qué permitió que una misma máquina realizara muchas tareas distintas sin reconstruirse cada vez? Las primeras computadoras electrónicas podían calcular rápido, pero “cambiar el trabajo” a menudo significaba cambiar físicamente la configuración de la máquina. La idea del programa almacenado es el punto de inflexión que hizo que las computadoras fueran realmente programables.

El programa almacenado, en lenguaje sencillo

Una computadora de programa almacenado guarda las instrucciones de una tarea (el programa) en la misma clase de memoria interna que los datos con los que trabaja el programa. En lugar de recablear el hardware o reconfigurar paneles manualmente, puedes cargar un nuevo conjunto de instrucciones en la memoria y ejecutar un trabajo distinto.

Ahora suena obvio, pero es un cambio profundo:

- La computadora se convierte en una herramienta de propósito general, no en una máquina de propósito único.

- Los programas pasan a ser información: algo que se puede editar, guardar, copiar y compartir.

- El desarrollo de software se vuelve una actividad práctica: escribir, probar y mejorar instrucciones sin reconstruir la computadora.

Lo que cubrirá este artículo (y por qué sigue importando)

Esto no es sólo una curiosidad histórica. El concepto de programa almacenado explica por qué "software" existe como algo separado del "hardware", y por qué actualizar un dispositivo hoy puede desbloquear nuevas funciones sin cambiar los chips internos.

En las secciones siguientes veremos el problema al que se enfrentaban las primeras computadoras, qué cambió el enfoque del programa almacenado, las personas y documentos que clarificaron la idea (incluido el famoso informe EDVAC) y cómo el término "arquitectura von Neumann" pasó a representar un diseño ampliamente usado.

Una nota rápida sobre los créditos

Aunque el nombre de John von Neumann está fuertemente asociado con la computación de programa almacenado, el crédito se comparte entre un equipo y una época más amplios. Muchos investigadores convergían en ideas similares mientras construían las primeras computadoras electrónicas prácticas. Este artículo mantiene ese contexto, porque entender el esfuerzo colectivo ayuda a explicar cómo la idea se difundió tan rápido y se convirtió en el modelo por defecto para la mayoría de las computadoras que siguieron.

Antes de los programas almacenados: cuando cambiar de tarea significaba recablear

Antes de la idea del programa almacenado, muchas computadoras tempranas no “ejecutaban software” en el sentido actual. Podían calcular a velocidades impresionantes, pero decirles qué hacer a menudo implicaba cambiar físicamente la máquina.

“Programación por hardware” en la práctica

Un enfoque común consistía en usar paneles de clavijas, cables de conexión y paneles de interruptores. Los operadores conectaban cables entre enchufes, ajustaban filas de interruptores y, a veces, calibraban unidades de tiempo para que las señales llegaran en el orden correcto. El “programa” no era un archivo que cargar: era un diagrama de cableado temporal.

Este montaje funcionaba, pero tenía un coste oculto: cada nueva tarea era un pequeño proyecto de ingeniería. Si querías cambiar la secuencia de operaciones (sumar, multiplicar, comparar, repetir), quizá tenías que mover docenas o cientos de conexiones. Un solo cable colocado mal podía generar errores sutiles difíciles de diagnosticar, porque la lógica estaba distribuida por conexiones físicas en vez de estar escrita como pasos legibles.

Por qué cambiar tareas era caro

Reconfigurar podía llevar horas o días, especialmente si la máquina debía apagarse con cuidado, recablearse y probarse. Eso significaba flexibilidad limitada: esas máquinas solían reservarse para un tipo de cálculo durante largos periodos porque cambiar de trabajo era muy disruptivo.

Un ejemplo sencillo

Imagina una máquina configurada para calcular tablas balísticas—cálculos largos y repetitivos con una fórmula fija. Si después se quería usar la misma máquina para resolver otro problema, como tabular resultados estadísticos de un censo, no era un "editar el programa y volver a ejecutar" rápido. El orden de operaciones, los pasos de almacenamiento intermedios y las comprobaciones condicionales podían diferir, requiriendo un rediseño completo del panel de clavijas y una nueva ronda de verificación.

Ese es el mundo del que la computadora de programa almacenado buscó escapar.

La computadora de programa almacenado, explicada sencillamente

Una computadora de programa almacenado es una máquina donde las instrucciones (el programa) viven en la misma memoria de trabajo que los datos que usa el programa. En otras palabras, la computadora no trata el “qué hacer” como algo separado del “sobre qué trabajar”: ambos se almacenan como patrones de bits en la memoria.

Qué significa “memoria” aquí

Cuando los pioneros de la computación hablaban de memoria, se referían al almacenamiento interno rápido y de acceso directo del ordenador—lo que hoy asociaríamos más estrechamente con la RAM. Es el lugar al que el procesador puede leer y escribir rápidamente mientras se ejecuta.

Eso es distinto del almacenamiento a largo plazo como un disco duro o un SSD. Un disco es excelente para conservar archivos cuando hay corte de energía, pero no es la libreta de trabajo inmediata que el procesador usa constantemente para obtener la siguiente instrucción y actualizar resultados intermedios.

La consecuencia clave: cambiar el trabajo sin cambiar la máquina

Una vez que las instrucciones están en memoria, cambiar de tarea se vuelve mucho más sencillo: puedes cargar un nuevo programa en memoria y ejecutarlo, sin reconstruir, recablear o reconfigurar físicamente el hardware. La misma máquina de propósito general puede hacer nóminas por la mañana y cálculos balísticos por la tarde, porque el “cómo” del trabajo es simplemente otro conjunto de bits que puedes reemplazar.

Una analogía cotidiana

Imagina una cocina donde la receta y los ingredientes se guardan juntos en la misma despensa. El cocinero (el procesador) va repetidamente a la despensa (memoria) a leer el siguiente paso de la receta (instrucción) y a tomar o actualizar ingredientes (datos).

¿Quieres preparar un plato distinto? No remodelas la cocina. Solo cambias la receta—usando las mismas encimeras, horno y utensilios.

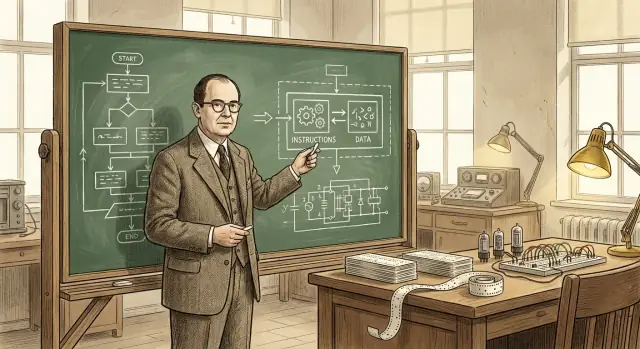

El papel de John von Neumann (y por qué su nombre perduró)

John von Neumann no “inventó la computadora”, y no creó en solitario la idea del programa almacenado. Lo que hizo—de forma brillante—fue ayudar a convertir un concepto prometedor en un diseño claramente expuesto y ampliamente compartido que otros ingenieros y laboratorios pudieron reproducir.

Un gran contribuyente y un comunicador inusualmente eficaz

Von Neumann participó activamente en proyectos de computación durante la guerra y el periodo de posguerra, asesorando equipos y afinando la estructura lógica de los diseños tempranos. Tenía talento para explicar decisiones técnicas complejas en términos claros y organizados, y eso importó porque la computación electrónica avanzaba deprisa, con múltiples grupos resolviendo problemas similares a la vez.

Igualmente importante fue que escribió y difundió descripciones influyentes de cómo una computadora podía almacenar instrucciones de programa en la misma memoria que los datos. Ese enmarcado claro facilitó que otros discutieran, enseñaran y replicaran el enfoque.

Por qué su nombre se asoció a la arquitectura

Los nombres suelen pegarse no al primer autor de una idea, sino a quien presenta una descripción que se convierte en punto de referencia. Los escritos de von Neumann fueron ampliamente leídos, copiados y citados—así que los lectores posteriores asociaron naturalmente la organización de “programa almacenado” con él.

Esa etiqueta también simplificó la historia: es más fácil decir “arquitectura von Neumann” que enumerar a todos los contribuyentes y reportes. Pero la abreviatura puede difuminar lo que realmente sucedió.

Un esfuerzo comunitario, no una hazaña en solitario

La computación electrónica temprana fue un esfuerzo colaborativo y multinstitucional que involucró matemáticos, ingenieros y programadores. El concepto de programa almacenado maduró mediante discusiones, borradores, prototipos y revisiones entre equipos. El papel duradero de von Neumann fue ayudar a cristalizar y difundir la idea—acelerando su adopción—más que reivindicarla como su creación exclusiva.

EDVAC (Electronic Discrete Variable Automatic Computer) fue uno de los proyectos informáticos tempranos de posguerra cuyo objetivo era ir más allá de las máquinas “únicas”. Tan importante como el esfuerzo de hardware fue la decisión de documentar las ideas de diseño de forma clara y compartible. En aquella época, construir ordenadores seguía siendo una ingeniería experimental: el conocimiento vivía en cuadernos de laboratorio, reuniones y en la cabeza de pocos especialistas. Un informe podía convertir esos conocimientos dispersos en algo que otros equipos pudieran discutir, criticar y reutilizar.

El First Draft of a Report on the EDVAC (a menudo abreviado como “informe EDVAC”) expuso, en términos conceptuales sencillos, la idea de programa almacenado: una computadora debía guardar las instrucciones del programa en la misma clase de memoria interna que los datos. Esa memoria no es sólo un lugar para mantener números mientras se realiza un cálculo: también contiene los pasos que dicen a la máquina qué hacer a continuación.

Este planteamiento hace que una computadora se sienta menos como un dispositivo de propósito fijo y más como una máquina general que puede “reorientarse” cambiando lo que hay en la memoria. No se recablea el sistema para pasar de un trabajo a otro; se carga una secuencia distinta de instrucciones.

Por qué importó para los demás

Más allá del propio concepto, el informe ayudó a estandarizar la forma en que la gente hablaba sobre computadoras: memoria, control, aritmética y entrada/salida como partes funcionales distintas que trabajan juntas. Tener un vocabulario compartido y una descripción ampliamente leída no solo explicó EDVAC: dio al campo un modelo mental común para construir, comparar y mejorar computadoras de programa almacenado.

Crédito compartido: el equipo detrás del pensamiento temprano del programa almacenado

Crea una demo de programa almacenado

Crea una pequeña interfaz de simulador para enseñar fetch-decode-execute en minutos.

Es tentador preguntar “¿quién inventó la computadora de programa almacenado?” y esperar un solo nombre. Pero la ciencia y la ingeniería rara vez funcionan así. Las ideas suelen desarrollarse en paralelo, refinarse mediante discusión y solo resultan convincentes cuando se demuestran en hardware operativo.

Colaboradores clave y esfuerzos paralelos

John von Neumann está fuertemente asociado con el concepto, pero el trabajo temprano involucró a muchas personas y grupos:

- J. Presper Eckert y John Mauchly (trabajo ENIAC/EDVAC): centrales en el empuje de ingeniería hacia computadoras electrónicas prácticas y diseños mejorados.

- Herman Goldstine: organizador y puente crucial entre matemáticos e ingenieros, y figura clave en documentar y difundir ideas.

- Arthur Burks: contribuyó al diseño lógico temprano y a relatos posteriores sobre cómo se formalizaron estas arquitecturas.

- Alan Turing: escribió pensamiento influyente, anterior a EDVAC, sobre computación de propósito general y máquinas controladas por programas.

- Maurice Wilkes (EDSAC) y Frederic Williams & Tom Kilburn (Manchester): ayudaron a demostrar que los sistemas de programa almacenado podían funcionar, con pruebas tempranas y avances en memoria.

Por qué es complicado decir “quién lo inventó”

Una computadora de programa almacenado no es una sola revelación. Combina (1) el salto conceptual de que las instrucciones pueden vivir en memoria como datos, (2) la ingeniería necesaria para construir memoria y unidades de control fiables, y (3) las prácticas de programación que hacen el diseño utilizable. Diferentes personas contribuyeron a piezas distintas.

Proponer vs. construir

Otra razón para compartir créditos: proponer una idea no es lo mismo que construir una máquina que funcione día tras día. Los informes y discusiones iniciales hicieron el concepto más claro; los primeros prototipos y sistemas productivos demostraron su viabilidad. Una historia cuidadosa respeta ambos tipos de contribuciones, sin forzar un veredicto simplista de “primer inventor”.

Qué suele significar “arquitectura von Neumann”

Cuando la gente dice “arquitectura von Neumann”, suele referirse a un modelo simple y ampliamente enseñado de cómo se organiza una computadora de programa almacenado. No es una marca ni una máquina histórica única: es una etiqueta conveniente para un plan básico que aparece, de una forma u otra, en muchas computadoras.

El diagrama de bloques común: CPU, memoria y entrada/salida

A un nivel conceptual, el esquema se ve así:

- CPU (unidad central de procesamiento): el “trabajador” que realiza operaciones.

- Memoria: el lugar donde la computadora guarda tanto las instrucciones del programa como los datos que el programa usa.

- Entrada/Salida (E/S): formas de recibir y enviar información—teclados, discos, pantallas, redes, sensores, etc.

La idea clave es que la CPU no tiene un lugar físico separado para “el programa” frente a “los números”. Extrae todo lo que necesita desde la memoria.

Cómo fluyen las instrucciones: buscar, decodificar, ejecutar

La CPU ejecuta un programa repitiendo un bucle a menudo descrito como buscar–decodificar–ejecutar:

- Buscar: leer la siguiente instrucción de la memoria.

- Decodificar: interpretar qué pide esa instrucción (sumar, comparar, cargar, almacenar, saltar…).

- Ejecutar: llevar a cabo la acción, que puede implicar leer/escribir memoria o interactuar con E/S.

Esta descripción es simplificada, pero captura el núcleo: el programa es una secuencia de instrucciones almacenadas en memoria, y la CPU las recorre.

Por qué "instrucciones y datos en la misma memoria" es potente

Poner instrucciones y datos en la misma memoria hace que una computadora sea de propósito general de manera muy práctica:

- Para cambiar lo que hace la máquina, normalmente cambias el programa en memoria, no el cableado.

- Los programas pueden tratar instrucciones como información—copiarlas, cargarlas, modificarlas (aunque los sistemas modernos a menudo restringen esto por seguridad).

- Es más fácil construir herramientas como ensambladores, compiladores y sistemas operativos, porque “un programa” es solo otro tipo de información almacenada.

Una etiqueta conveniente, no una afirmación de invención exclusiva

“Arquitectura von Neumann” es mejor entenderla como un atajo para el modelo de programa almacenado con una CPU, una memoria compartida que guarda instrucciones y datos, y E/S—una idea asociada con las claras explicaciones de von Neumann, aunque la historia temprana involucró a muchos contribuyentes.

Von Neumann vs. Harvard: dos maneras de organizar instrucciones y datos

Crea una app móvil complementaria

Crea una app en Flutter junto a tu backend usando el mismo flujo de chat.

A menudo se habla de “von Neumann” y “Harvard” como si fueran filosofías en pugna. En realidad son dos maneras prácticas de disponer instrucciones y datos para que la computadora pueda obtener lo que necesita.

Estilo von Neumann: una memoria, camino compartido

En un diseño al estilo von Neumann, instrucciones y datos viven en la misma memoria y normalmente viajan por la misma ruta hacia la CPU.

Eso es conceptualmente simple: un programa son solo bytes en memoria, junto a los números, textos e imágenes con los que trabaja. También facilita la computación de propósito general: el software puede cargarse, cambiarse y almacenarse usando los mismos mecanismos que los datos.

El trade-off: cuando instrucciones y datos comparten la misma “carretera”, pueden competir por ancho de banda. (A veces se describe esto como un “cuello de botella”.)

Un enfoque Harvard mantiene el almacenamiento de instrucciones separado del almacenamiento de datos, a menudo con rutas separadas para obtener cada uno.

Esa separación puede facilitar la obtención de la siguiente instrucción mientras se leen o escriben datos—útil en sistemas pequeños y previsibles. Muchos microcontroladores simples siguen este patrón, donde el código del programa vive en memoria flash y las variables en RAM.

Por qué muchos sistemas reales mezclan ambos

Las CPUs modernas a menudo parecen “von Neumann” para el software (un espacio de direcciones, un modelo de programa), mientras que internamente toman ideas tipo Harvard. Un ejemplo común son las cachés separadas de instrucciones y datos (I-cache y D-cache). Para tu programa, sigue pareciendo una sola memoria, pero el hardware puede obtener código y datos con más eficiencia.

Qué recordar: no hay un ganador universal. Von Neumann enfatiza simplicidad y flexibilidad; Harvard enfatiza separación y rendimiento. Muchas máquinas mezclan ambas para equilibrar programabilidad, coste, consumo y velocidad.

Cómo los programas almacenados hicieron posible la programación moderna

Una computadora de programa almacenado no solo ejecuta cálculos: puede cargar un conjunto de instrucciones desde la memoria, ejecutarlas y luego cargar otro conjunto después. Ese cambio hizo que el software fuera reutilizable y compartible: un programa podía escribirse una vez, guardarse, copiarse, mejorarse y distribuirse sin tocar el hardware.

De “esta máquina” a “cualquier tarea”

Cuando el programa vive en memoria, la misma computadora física puede realizar muchos trabajos distintos simplemente intercambiando las instrucciones que lee. Eso es lo que realmente significa “propósito general”: una máquina, muchos programas. La computadora deja de definirse por un único flujo de trabajo y se convierte en una plataforma.

Un ejemplo moderno fácil de entender es tu portátil, que ejecuta correo, juegos y hojas de cálculo. Bajo el capó, es la misma idea: el hardware permanece igual mientras se cargan y ejecutan distintos programas al cambiar de aplicación.

Por qué esto hizo posibles herramientas reales de programación

Cuando las instrucciones se tratan como datos en memoria, resulta práctico construir capas de software que ayuden a escribir software:

- Ensambladores permiten escribir mnemónicos más legibles en lugar de códigos numéricos crudos.

- Compiladores traducen lenguajes de alto nivel a instrucciones de máquina, haciendo los programas más fáciles de escribir y mantener.

- Sistemas operativos gestionan la carga de programas, el uso compartido de memoria y dispositivos, y la planificación para que múltiples programas puedan funcionar sin conflictos.

Estas herramientas dependen de la suposición de que los programas pueden almacenarse, moverse y manipularse como otra información. Eso convirtió al software en un ecosistema en lugar de un artefacto único ligado a un cableado particular.

Una forma útil de ver el arco histórico: los programas almacenados permitieron compiladores y sistemas operativos, que permitieron herramientas modernas de desarrollo—y hoy estamos viendo otra capa de abstracción donde puedes describir una aplicación en lenguaje natural y herramientas generan código ejecutable. Por ejemplo, Koder.ai es una plataforma de “vibe-coding” donde construyes apps web, backend o móviles a través de una interfaz de chat, apoyándose en LLMs y un flujo de trabajo basado en agentes para acelerar el camino desde la intención (“¿qué debe hacer?”) hasta instrucciones ejecutables (código fuente que puedes exportar, desplegar y revertir mediante snapshots).

El resultado sigue siendo el mismo ciclo virtuoso: los programas almacenados hicieron posibles mejores herramientas, y mejores herramientas hicieron posibles programas más ambiciosos, convirtiendo las computadoras en máquinas flexibles y de propósito general.

La limitación famosa: el “cuello de botella von Neumann”

La idea de programa almacenado hizo las computadoras flexibles, pero también puso de manifiesto una limitación práctica que los ingenieros todavía discuten: el “cuello de botella von Neumann”. En términos cotidianos, es como un atasco de tráfico en la carretera entre la CPU (el trabajador) y la memoria (el almacén).

Un atasco entre CPU y memoria

En un diseño típico de programa almacenado, tanto las instrucciones como los datos viven en la memoria. La CPU busca una instrucción, luego los datos que necesita, luego escribe resultados—a menudo por la misma conexión. Si esa conexión no puede mover información lo bastante rápido, la CPU acaba esperando aunque pudiera calcular mucho más rápido.

Por qué importan velocidad y ancho de banda

Dos factores relacionados dan forma a este cuello de botella:

- Latencia de la memoria (velocidad): cuánto tarda en llegar la primera pieza de información después de pedirla.

- Ancho de banda de la memoria: cuánta información se puede mover por segundo una vez que la transferencia está en curso.

Una CPU puede realizar miles de millones de operaciones por segundo, pero si la memoria no suministra un flujo constante de instrucciones y datos, el rendimiento queda limitado por el paso más lento: conseguir los bytes de ida y vuelta.

Mitigaciones comunes (no soluciones mágicas)

Esto es una consideración de ingeniería muy discutida, y las computadoras modernas usan varias técnicas para reducir el impacto:

- Caches: memoria pequeña y rápida cerca de la CPU que guarda instrucciones/datos usados recientemente.

- Prefetching: adivinar qué se necesitará a continuación y cargarlo antes.

- Paralelismo: hacer más de una cosa a la vez (múltiples núcleos, solapamiento de acceso a memoria y cómputo).

Estas aproximaciones no eliminan la “carretera” subyacente, pero ayudan a mantenerla menos congestionada—para que la CPU pase más tiempo trabajando y menos tiempo esperando.

Dónde ves la idea en las computadoras que usas hoy

Gana créditos mientras enseñas

Publica lo que construyas con Koder.ai y gana créditos mediante el programa.

La idea del programa almacenado no es un objeto de museo: es la forma en que la computación cotidiana mantiene su flexibilidad. Tus dispositivos no necesitan “recablearse” para hacer algo nuevo; simplemente cargan distintas instrucciones en memoria y las ejecutan.

Teléfonos, portátiles y servidores: el mismo truco básico

En un teléfono, tocar un icono hace que el sistema operativo cargue el código de esa app (instrucciones) desde el almacenamiento a la memoria, y la CPU lo ejecute. En un portátil, lo mismo ocurre al abrir un navegador, editar un documento o ejecutar un juego. En servidores se ve aún más: la máquina puede ejecutar miles de cargas de trabajo cambiantes—peticiones web, consultas de base de datos, tareas en segundo plano—sin cambiar el hardware.

Incluso funciones que consideramos “de hardware” a menudo se definen por software. Enrutamiento de red, rutas de decodificación de vídeo, mejora fotográfica y políticas de gestión de energía se actualizan frecuentemente mediante firmware y software de sistema—nuevas instrucciones, mismo dispositivo.

Intérpretes y máquinas virtuales siguen ejecutando instrucciones almacenadas

Lenguajes como Python y JavaScript suelen ejecutarse mediante un intérprete o una máquina virtual. En lugar de que la CPU ejecute directamente tu código fuente, tu programa se traduce a una forma estructurada (bytecode o instrucciones internas) que se almacena en memoria y se ejecuta paso a paso. La JVM de Java, .NET, runtimes de WebAssembly y los motores de JavaScript del navegador dependen de esto: las instrucciones se vuelven estructuras de datos que la máquina puede cargar, mover y ejecutar.

Una nota de seguridad: cuando los datos se convierten en instrucciones

Porque las instrucciones son “solo” información, los ataques a menudo intentan introducir código malicioso a través de datos—la clásica inyección de código. Defensas como protección de memoria, firma de código y regiones no ejecutables existen para evitar que datos no confiables sean tratados como instrucciones ejecutables.

Todo esto vuelve al compromiso central del programa almacenado: flexibilidad mediante software—nuevo comportamiento en el mismo hardware.

Puntos clave y lecturas recomendadas

Puntos clave

- Una computadora de programa almacenado guarda las instrucciones del programa en el mismo tipo de memoria de lectura/escritura que los datos, de modo que puedes cambiar lo que hace la máquina cambiando la memoria, no recableando el hardware.

- La etiqueta “arquitectura von Neumann” suele señalar una organización práctica (CPU + memoria + entrada/salida) donde instrucciones y datos comparten vías, no una afirmación de que una sola persona inventó todo.

- El pensamiento temprano sobre programas almacenados fue trabajo en equipo: las discusiones y el informe EDVAC ayudaron a declarar la idea claramente, y múltiples proyectos demostraron cómo construir y operar estos sistemas de forma fiable.

- Los programas almacenados hicieron posible la programación moderna porque permiten código reutilizable, bibliotecas, compiladores y sistemas operativos, todos basados en la suposición de que el software es dato que la máquina puede cargar y ejecutar.

Preguntas rápidas para reconocer una arquitectura

Cuando mires una computadora (o leas una especificación), estas preguntas te ayudan a identificar el modelo básico:

- ¿Dónde se almacenan las instrucciones en tiempo de ejecución: la misma memoria que los datos o una memoria separada?

- ¿Instrucciones y datos viajan por la misma vía/bus, o hay rutas separadas (frecuentes en diseños Harvard)?

- ¿Puede el sistema modificar o generar código y luego ejecutarlo (una capacidad clásica de programa almacenado), o el almacenamiento de código es fijo/aislado?

- ¿La “memoria de programa” se describe como flash/ROM mientras la “memoria de datos” es RAM (una pista de separación al estilo Harvard en muchos microcontroladores)?

Lecturas recomendadas

- Libros: The Computer from Pascal to von Neumann (Herman H. Goldstine); encuestas generales de historia de la computación que cubren ENIAC/EDVAC/IAS.

- Museos: Computer History Museum; Science Museum (colecciones de computación); Smithsonian (historia de la tecnología).

- Archivos y revistas: artículos históricos de IEEE y ACM (incluidas entrevistas orales), además de colecciones especiales en bibliotecas universitarias que conservan documentos de computación temprana.

Si quieres más artículos de tono accesible como este, explora /blog.

Nota: Si experimentas con formas modernas de convertir “instrucciones” en sistemas en ejecución—ya sea escribiendo código directamente o usando plataformas de construcción guiadas por chat como Koder.ai—considera documentar lo que aprendes. Koder.ai también ofrece un programa para ganar créditos por contenido publicado y referencias, lo que puede ser una forma práctica de financiar más experimentos y tutoriales.