কেন স্টোনব্রেকারের কাজ এখনও আপনার ডেটা স্ট্যাকেই দেখা যায়

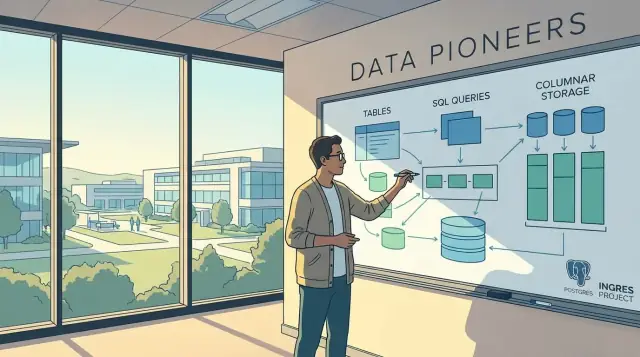

মাইকেল স্টোনব্রেকার একজন কম্পিউটার বিজ্ঞানী, যাঁর প্রকল্পগুলো কেবল ডাটাবেস গবেষণাকে প্রভাবিত করেনি—এগুলো সরাসরি সেই পণ্য এবং ডিজাইন প্যাটার্নগুলোকে ধরেছে যেগুলো অনেক টিম প্রতিদিন ব্যবহার করে। যদি আপনি একটি রিলেশনাল ডাটাবেস, কোনো অ্যানালিটিক্স ওয়্যারহাউস বা স্ট্রিমিং সিস্টেম ব্যবহার করে থাকেন, তাহলে আপনি এমন ধারণাগুলি উপভোগ করেছেন যা তিনি প্রমাণ, নির্মাণ বা প্রচলিত করেছেন।

এই আর্টিকেল থেকে আপনি কী পাবেন

এটি কোনো জীবননীতি বা একাডেমিক থিওরির ট্যুর নয়। বরং, এটি স্টোনব্রেকারের বড় সিস্টেমগুলোর (Ingres, Postgres, Vertica ইত্যাদি) সাথে আধুনিক ডেটা স্ট্যাকগুলোতে দেখা নির্বাচনের সংযোগ করে:

- কেন SQL ডেটা কাজের সাধারণ ভাষা হয়ে উঠল

- কেন অ্যানালিটিক্স ইঞ্জিনগুলো OLTP ডাটাবেস থেকে আলাদা দেখায় ও আচরণ করে

- কেন “সবকিছুর জন্য একটি ডাটাবেস” প্রায়ই ব্যর্থ হয়

- কিভাবে আর্কিটেকচার সিদ্ধান্ত খরচ, পারফরম্যান্স ও নির্ভরযোগ্যতাকে প্রভাবিত করে

"আধুনিক ডাটাবেস" বলতে কী বোঝায় (সরল ভাষায়)

একটি আধুনিক ডাটাবেস হচ্ছে এমন কোনো সিস্টেম যা নির্ভরযোগ্যভাবে করতে পারে:

- সংরক্ষণ: ডেটা নিরাপদে রাখা (তাই আপনি এটি হারাবেন না)

- কোয়েরি: দ্রুত প্রশ্ন করা (টিমগুলো উত্তর পেতে পারে)

- স্কেল: ভলিউম ও ইউজার বাড়লে সামলাতে পারে (চাপ পড়লে ভেঙে না পড়ে)

- সঠিকতা বজায় রাখা: কনকারেন্সির মধ্যে ফলাফল বাস্তবতার সাথে মেলে

বিভিন্ন ডাটাবেস আলাদা উপায়ে এই লক্ষ্যগুলোকে অপ্টিমাইজ করে—বিশেষত ট্রানজ্যাকশনাল অ্যাপ, BI ড্যাশবোর্ড এবং রিয়েল-টাইম পাইপলাইনের মধ্যে তুলনা করলে।

এই লেখার প্রতিশ্রুতি

আমরা প্র্যাকটিক্যাল প্রভাবের ওপর ফোকাস করব: সেই ধারণাগুলো যা আজকের “ওয়্যারহাউস + লেক + স্ট্রিম + মাইক্রোসার্ভিস” জগতে দেখা যায়, এবং কীভাবে এগুলো কিনবেন, বানাবেন ও অপারেট করবেন তা প্রভাবিত করে। প্রত্যাশা করুন পরিষ্কার ব্যাখ্যা, ট্রেড-অফ এবং বাস্তব জীবনের পরিণাম—প্রমাণপত্র বা ইমপ্লিমেন্টেশন ডিটেইলে গভীর ডুব নয়।

তাঁর প্রধান ডাটাবেস মাইলস্টোনগুলোর সংক্ষিপ্ত, কার্যকরী টাইমলাইন

স্টোনব্রেকারের ক্যারিয়ার বোঝা সহজতম করা যায় এক ধারা হিসেবে—নির্দিষ্ট কাজের জন্য নির্মিত সিস্টেমগুলোর ক্রম এবং তারপর সেই সেরা ধারণাগুলো কিভাবে মেইনস্ট্রিম পণ্যগুলোতে ঢুকেছে।

1970s: Ingres — রিলেশনাল ডাটাবেসকে ব্যবহারযোগ্য করা

Ingres এক একাডেমিক প্রকল্প হিসেবে শুরু হয়েছিল যেটি প্রমাণ করেছিল রিলেশনাল ডাটাবেস কেবল সিদ্ধান্ত নয়—এগুলো দ্রুত ও ব্যবহারিক হতে পারে। এটি SQL-স্টাইল কুয়েরি এবং কস্ট-ভিত্তিক অপটিমাইজেশনের ধারণাকে প্রচলিত করতে সাহায্য করে যা পরে বাণিজ্যিক ইঞ্জিনগুলোতে স্বাভাবিক হয়ে ওঠে।

1980s–1990s: Postgres — এক্সটেনসিবিলিটি এবং "ডাটাবেসকে বিকাশ করো"

Postgres (গবেষণামূলক সিস্টেম যা PostgreSQL-এ পরিণত হয়) একটি ভিন্ন দাওবা করেছিল: ডাটাবেসগুলো স্থির-ফাংশন হওয়া উচিত না। আপনি যেন নতুন ডেটা টাইপ, নতুন ইনডেক্সিং পদ্ধতি এবং সমৃদ্ধ আচরণ যোগ করতে পারেন ইঞ্জিন পুরোপুরি পুনর্লিখন না করেই।

অনেক আধুনিক ফিচার এখান থেকেই এসেছে—এক্সটেনসিবল টাইপ, ইউজার-ডিফাইন্ড ফাংশন, এবং এমন একটি ডাটাবেস যা ওয়ার্কলোড বদলে গেলে মানানো যায়।

2000s: কলাম স্টোর এবং অ্যানালিটিক্স-মুখী ডিজাইন

অ্যানালিটিক্স বাড়ার সঙ্গে, রো-অরিয়েন্টেড সিস্টেমগুলো বড় স্ক্যান ও অগ্রিগেশনে কষ্টে পড়তে শুরু করল। স্টোনব্রেকার কলামভিত্তিক স্টোরেজ এবং সংশ্লিষ্ট এক্সিকিউশন কৌশলগুলোর পক্ষে ছিলেন—এগুলো কেবল প্রয়োজনীয় কলামই পড়ে বার করা এবং সেগুলোকে ভালভাবে কমপ্রেস করার ধারণা, যা আজ অ্যানালিটিক্স ডাটাবেস ও ক্লাউড ওয়্যারহাউসে স্ট্যান্ডার্ড।

মিড-2000s: Vertica — MPP অ্যানালিটিক্স পণ্য হিসেবে নিয়ে আসা

Vertica কলামার স্টোর গবেষণার ধারণাগুলোকে বাণিজ্যিকভাবে সক্ষম massively parallel processing (MPP) SQL ইঞ্জিনে পরিণত করেছিল, যা বড় অ্যানালিটিক্স কুয়েরিগুলো দ্রুত করার উদ্দেশ্যে তৈরি। গবেষণা প্রোটোটাইপ একটি কনসেপ্ট যাচাই করে; একটি পণ্য এটিকে রিলায়িবিলিটি, টুলিং ও বাস্তব কাস্টমার কন্ডিশনের জন্য শক্ত করে তোলে—এটাই শিল্পে বারবার দেখা প্যাটার্ন।

2010s ও পরবর্তী: স্ট্রিমিং এবং "ওয়ার্কলোড-ড্রিভেন" ইঞ্জিন

পরে কাজগুলো স্ট্রিম প্রসেসিং এবং ওয়ার্কলোড-স্পেসিফিক ইঞ্জিনে বিস্তৃত হয়—দাবি ছিল যে এক সাধারণ উদ্দেশ্যের ডাটাবেস সব জায়গায় জেতে না।

গবেষণা প্রোটোটাইপ বনাম পণ্য (কেন পার্থক্য গুরুত্বপূর্ণ)

প্রোটোটাইপ দ্রুত একটি হাইপোথিসিস পরীক্ষা করার জন্য নির্মিত হয়; একটি পণ্য অপারাবিলিটির ওপর জোর দেয়: আপগ্রেড, মনিটরিং, সিকিউরিটি, পূর্বানুমেয় পারফরম্যান্স এবং সাপোর্ট। স্টোনব্রেকারের প্রভাব দেখা যায় কারণ অনেক প্রোটোটাইপ ধারণা বাণিজ্যিক ডাটাবেসে ডিফল্ট ক্ষমতায় গ্র্যাজুয়েট করেছে, বিভক্ত অপশন নয়।

Ingres: রিলেশনাল ডাটাবেসকে ব্যবহারিক করা

Ingres (INteractive Graphics REtrieval System) ছিল স্টোনব্রেকারের প্রাথমিক প্রমাণ যে রিলেশনাল মডেল কেবল সুন্দর তত্ত্ব নয়। তখনকার সময়ে অনেক সিস্টেম কাস্টম অ্যাক্সেস মেথড ও অ্যাপ্লিকেশন-স্পেসিফিক ডেটা পাথের উপর নির্মিত ছিল।

Ingres একটি সরল ব্যবসায়িক সমস্যা সমাধান করতে নেমেছিল:

কিভাবে মানুষকে ডেটার উপর নমনীয় প্রশ্ন করার সুযোগ দিবেন, প্রতিবার সফটওয়্যার পুনর্লিখতে না হয়ে?

Ingres কি ঠিক করতে চেয়েছিল

রিলেশনাল ডাটাবেস আপনাকে বলে আপনি কি চান সেটা বর্ণনা করতে পারবেন (উদাহরণ: “ক্যালিফোর্নিয়ার কাস্টমারদের যারা বিল শেষ তারিখ পেরিয়েছে”), কিভাবে ধাপে ধাপে তা আনতে হবে না। কিন্তু সেই প্রতিশ্রুতি বাস্তব করতে একটি সিস্টেম দরকার যা করে:

- টেবিল আকারে ডেটা নির্ভরযোগ্যভাবে সংরক্ষণ করতে পারে

- SQL-অনুরূপ উচ্চ-স্তরের কুয়েরি ভাষা গ্রহণ করে

- সেই কুয়েরি কে 자동ভাবে একটি দক্ষ পরিকল্পনায় রূপান্তর করে

Ingres ঐ “প্রায়োগিক” রিলেশনাল কম্পিউটিংয়ের দিকে বড় পদক্ষেপ ছিল—একটি সিস্টেম যা তখনকার হার্ডওয়্যারে চলেও প্রতিক্রিয়াশীল বোধ করত।

SQL গ্রহণযোগ্যতা ও কোয়েরি অপ্টিমাইজেশনের জন্ম

Ingres এই ধারণা প্রচলিত করতে সাহায্য করল যে একটি ডাটাবেসকে কুয়েরি পরিকল্পনা করা কঠোর কাজটাই করা উচিত। ডেভেলপাররা প্রতিটি ডেটা এক্সেস পাথ হাত দিয়ে টিউন না করে, সিস্টেমই সিদ্ধান্ত নিতে পারে—কোন টেবিল প্রথম পড়বেন, কোন ইনডেক্স ব্যবহার করবেন, কিভাবে টেবিলগুলো জয়েন করবেন ইত্যাদি।

এটা SQL-স্টাইল চিন্তাধারাকে ছড়িয়ে দিতে সাহায্য করল: যখন আপনি ডিক্লারেটিভ কোয়েরি লিখতে পারেন, আপনি দ্রুত পুনরাবৃত্তি করতে পারেন, এবং আরও মানুষ সরাসরি প্রশ্ন করতে পারে—অ্যানালিস্ট, প্রোডাক্ট টিম, এমনকি ফাইন্যান্স—বিনা কাস্টম রিপোর্টের অপেক্ষায় থাকাও।

কেন কস্ট-বেসড অপটিমাইজেশন গুরুত্বপূর্ণ

বড় ব্যবহারিক অন্তর্দৃষ্টি হচ্ছে কস্ট-বেসড অপটিমাইজেশন: ডেটা সম্পর্কে পরিসংখ্যান ব্যবহার করে সর্বনিম্ন প্রত্যাশিত “খরচ” (সাধারণত I/O, CPU, মেমরির মিশ্রণ) অনুযায়ী কোয়েরি প্ল্যান বেছে নাও।

এর প্রভাব প্রায়ই দেখা যায়:

- দ্রুততর কোয়েরি কোনো অ্যাপ পরিবর্তন না করেই

- কম হার্ডওয়্যার একই পারফরম্যান্স লক্ষ্য পেতে

- বড় ডেটাসেটে অধিক পূর্বানুমেয় পারফরম্যান্স

Ingres প্রতিটি আধুনিক অপ্টিমাইজেশনের উপাদান আবিষ্কার করেনি, কিন্তু এটি প্যাটার্নটা প্রতিষ্ঠা করতে সাহায্য করল: SQL + একটি অপ্টিমাইজার রিলেশনাল সিস্টেমগুলোকে “ভালো ধারণা” থেকে দৈনন্দিন টুল বানায়।

Postgres: এক্সটেনসিবল ডাটাবেসের বড় ধারণা

প্রাথমিক রিলেশনাল ডাটাবেসগুলো সাধারণত ধার্য টাইপ সেট (নাম্বর, টেক্সট, তারিখ) এবং ধ্রুব অপারেশন (ফিল্টার, জয়েন, অ্যাগ্রিগেট) ধরে নিত। এটা ভাল কাজ করত—যতক্ষণ না টিমগুলো নতুন ধরনের তথ্য (জিওগ্রাফি, লগ, টাইম সিরিজ, ডোমেইন-স্পেসিফিক আইডেন্টিফায়ার) সংরক্ষণ শুরু করে বা বিশেষায়িত পারফরম্যান্স ফিচার দরকার হয়।

কঠোর ডিজাইনে, প্রতিটি নতুন চাহিদা একটি খারাপ বিকল্পে পরিণত হয়: ডেটাকে টেক্সট ব্লব হিসেবে ফোর্স করা, আলাদা সিস্টেম লাগানো, বা ভেন্ডারের আপডেটের জন্য অপেক্ষা করা।

এক্সটেনসিবিলিটি, কঠিন জার্গন ছাড়া ব্যাখ্যা

Postgres ভিন্ন একটি ধারণা এগিয়ে আনল: ডাটাবেসকে এক্সটেনসিবল হওয়া উচিত—অর্থাৎ আপনি নিয়ন্ত্রিতভাবে নতুন ক্ষমতা যোগ করতে পারেন, সেই সুরক্ষা ও সঠিকতা বজায় রেখে যা আপনি SQL থেকে আশা করেন।

সরল ভাষায়, এক্সটেনসিবিলিটি মানে একটি পাওয়ার টুলে সার্টিফায়েড এটাচমেন্ট যোগ করার মত—মোটর নিজে বদলাতে হচ্ছে না। আপনি ডাটাবেসকে “নতুন ট্রিক” শেখাতে পারেন, এবং তবু ট্রানজ্যাকশন, অনুমতি ও কুয়েরি অপটিমাইজেশন একটি সমন্বিত পদ্ধতিতে কাজ করবে।

এটা কীভাবে আধুনিক এক্সটেনশন ইকোসিস্টেমকে গঠন করেছে

এই মানসিকতা আজকের PostgreSQL ইকোসিস্টেমে (এবং অনেক Postgres-প্রেরিত সিস্টেমে) স্পষ্টভাবে দেখা যায়। কোর ফিচারের জন্য অপেক্ষা না করে টিমগুলো ভেটেড এক্সটেনশন গ্রহণ করতে পারে যা SQL এবং অপারেশনাল টুলিংয়ের সাথে মসৃণভাবে একীভূত হয়।

উচ্চ-স্তরের সাধারণ উদাহরণগুলিঃ

- কাস্টম ডেটা টাইপ: সমৃদ্ধ মান (জিওস্পেশাল পয়েন্ট, রেঞ্জ, বা JSON-ধাঁচ) প্রথম-শ্রেণীর নাগরিক হিসেবে স্টোর করুন।

- কাস্টম ফাংশন: এমন ডোমেইন লজিক যোগ করুন যা সরাসরি কুয়েরিতে ও রিপোর্টে ব্যবহৃত হবে।

- ইন্ডেক্সিং অপশন: বিভিন্ন অ্যাক্সেস প্যাটার্নের জন্য বিভিন্ন ইনডেক্স টাইপ বেছে নিন, যাতে একই SQL কোয়েরি অনেক দ্রুত চলতে পারে।

কী হলো: Postgres ডিজাইন লক্ষ্য হিসেবে “ডাটাবেস কী করতে পারে তা বদলানো” নিল—এবং সেই ধারণা আজও আধুনিক ডেটা প্ল্যাটফর্মগুলোকে প্রভাবিত করে।

ট্রানজ্যাকশন ও কনকারেন্সি: স্কেলে সঠিক ফলাফল পাওয়া

ডাটাবেস কেবল তথ্য রাখার বিষয়ে নয়—এগুলো নিশ্চিত করে তথ্যটি সঠিক থাকে, এমনকি অনেক কিছু একযোগে ঘটলেও। সেইটাই ট্রানজ্যাকশন ও কনকারেন্সি কন্ট্রোলের কাজ, এবং এটিই একটি বড় কারণ কেন SQL সিস্টেমগুলো বাস্তব ব্যবসায়িক কাজের জন্য বিশ্বাসযোগ্য।

একটি ট্রানজ্যাকশন বাস্তবে কী গ্যারান্টি দেয়

একটি ট্রানজ্যাকশন হচ্ছে পরিবর্তনের এমন একটি গ্রুপ যা সফল বা ব্যর্থ—দুইটিই একসাথে হতে হবে।

যদি আপনি একাউন্ট থেকে আরেকটায় টাকা ট্রান্সফার করেন, অর্ডার রাখেন বা ইনভেন্টরি আপডেট করেন, আপনি "আকারে অসম্পূর্ণ" ফলাফলকে ভোগ করতে পারবেন না। একটি ট্রানজ্যাকশন নিশ্চিত করে আপনি এমন সমস্যায় পড়বেন না—উদাহরণস্বরূপ, একটি অর্ডার গ্রাহককে চার্জ করেছে কিন্তু স্টক রিজার্ভ করে নি—বা স্টক হ্রাস হয়েছে কিন্তু কোনো অর্ডার রেকর্ড হয়নি।

ব্যবহারিকভাবে, ট্রানজ্যাকশনগুলো দেয়:

- মানব-বোধগম্য কনসিস্টেন্সি: ডাটাবেস 'আংশিক'ভাবে পরিবর্তন প্রয়োগ করে না।

- রিকভারিবিলিটি: যদি মাঝপথে ক্র্যাশ ঘটে, সিস্টেম নিরাপদ অবস্থায় রোলব্যাক করতে পারে।

কনকারেন্সি: বাস্তব জগতের সমস্যা যেগুলো ডাটাবেস সামলায়

কনকারেন্সি মানে অনেক মানুষ (এবং অ্যাপ) একই সময়ে ডেটা পড়া ও বদলানো: কাস্টমার চেকআউট, সাপোর্ট এজেন্টদের অ্যাকাউন্ট এডিট, ব্যাকগ্রাউন্ড জবগুলো স্ট্যাটাস আপডেট, অ্যানালিস্টদের রিপোর্ট চলানো।

বিনা নিয়মের, কনকারেন্সি সৃষ্টি করে সমস্যাগুলো যেমন:

- লস্ট আপডেট: দুইজন ব্যবহারকারী একই রেকর্ড এডিট করে; একজন অপরজনকে ওভাররাইট করে।

- ডার্টি রিডস: কেউ এমন ডেটা দেখে যা পরে রোলব্যাক হয়।

- অসঙ্গত রিপোর্ট: একটি কোয়েরি ‘আগে’ এবং ‘পরে’ রাজ্যের মিশ্রণ দেখে।

MVCC সরল ভাষায়

একটি প্রভাবশালী পদ্ধতি হচ্ছে MVCC। ধারণাগতভাবে, MVCC কিছুক্ষণ রেকর্ডের একাধিক সংস্করণ রাখে, যাতে রিডাররা একটি স্থির স্ন্যাপশট পড়তে পারে যখন লেখকরা আপডেট করছে।

বড় সুবিধা হল যে রিডস প্রায়ই রাইটসকে ব্লক করে না, এবং লেখকরা দীর্ঘ-চলমান কুয়েরির পেছনে বারবার আটকে পড়ে না। আপনি এখনো সঠিকতা পান, কিন্তু অপেক্ষা কম থাকে।

কেন এটা আধুনিক SQL ওয়ার্কলোডে বিষয়বস্তু

আজকের ডাটাবেসগুলো প্রায়ই मिक্সড ওয়ার্কলোড সেবা করে: উচ্চ-ভলিউম অ্যাপ রাইটস প্লাস ড্যাশবোর্ড, কাস্টমার ভিউ এবং অপারেশনাল অ্যানালিটিক্সের জন্য ঘন ঘন রিড। আধুনিক SQL সিস্টেমগুলি MVCC, স্মার্ট লকিং এবং আইসোলেশন লেভেলগুলির মতো কৌশলের ওপর নির্ভর করে গতি এবং সঠিকতার মধ্যে ভারসাম্য রাখতে—যাতে আপনি স্কেল করতে পারেন কার্যকলাপ ছাড়াই ডেটার ওপর বিশ্বাস হারাতে।

কলাম স্টোর: অ্যানালিটিক্স পারফরম্যান্সের একটি টার্নিং পয়েন্ট

এককালীন কুয়েরির ওপর নির্ভরতা ছেড়ে দিন

টিমের এককালীন SQL অনুরোধ কমাতে একটি হালকা অ্যাডমিন প্যানেল তৈরি করুন।

রো-অরিয়েন্টেড ডাটাবেস ট্রানজ্যাকশন প্রসেসিংয়ের জন্য তৈরি: অনেক ছোট রিড ও রাইট, সাধারণত একটি গ্রাহক/অর্ডার/অ্যাকাউন্ট একবারে ছোঁয়া হয়। সেই ডিজাইন দারুণ যখন আপনাকে একটি পুরো রেকর্ড দ্রুত ফেচ বা আপডেট করতে হয়।

সারি বনাম কলাম (দৈনন্দিন উপমা)

একটি স্প্রেডশীট ভাবুন। একটি রো স্টোর প্রতিটি সারিকে আলাদা ফোল্ডারে রেখে দেওয়ার মতো: যখন আপনি “অর্ডার #123 সম্পর্কে সবকিছু” চান, আপনি একটাই ফোল্ডার তোলেন। একটি কলাম স্টোর হলো কলাম অনুযায়ী ফাইলিং: এক ড্রয়ার “order_total” জন্য, আরেক ড্রয়ার “order_date” জন্য, আরেকটি “customer_region” জন্য।

অ্যানালিটিক্সে, আপনি বিরলভাবে পুরো ফোল্ডারই চান—সাধারণত প্রশ্ন থাকে “গত কোর্টারের অঞ্চন অনুযায়ী মোট রাজস্ব কত?” এই কোয়েরি মিলিয়ন রেকর্ডের বেশ কয়েকটি ফিল্ডই হবে।

কেন অ্যানালিটিক্স ওয়ার্কলোড কলামকে পছন্দ করে

অ্যানালিটিক্স কোয়েরি প্রায়ই:

- একটি টেবিলের বড় অংশ স্ক্যান করে

- শুধু কয়েকটি কলাম ব্যবহার করে

- ভারী অ্যাগ্রিগেট (SUM/AVG/COUNT) ও ফিল্টার করে

কলামার স্টোরে, ইঞ্জিন শুধু কোয়েরিতে উল্লিখিত কলামগুলোই পড়ে, বাকি থেকে যায়। ডিস্ক থেকে কম ডেটা পড়া (এবং মেমরিতে কম মুভমেন্ট) প্রায়ই সবচেয়ে বড় পারফরম্যান্স লাভ।

কম্প্রেশন কেবল স্থান বাঁচানোর কথা নয়

কলামগুলোতে প্রায়ই পুনরাবৃত্তি মান থাকে (রিজিয়ন, স্ট্যাটাস, ক্যাটেগরি)। তাই এরা অত্যন্ত কম্প্রেসযোগ্য—এবং কম্প্রেশান দ্রুততার কারণও হতে পারে, কারণ সিস্টেম কম বাইট পড়ে এবং কখনও কখনও কম্প্রেসড ডেটার ওপরই অপারেট করতে পারে আরও দক্ষভাবে।

বড় পরিবর্তন

কলাম স্টোরগুলো OLTP-প্রথম ডাটাবেস থেকে অ্যানালিটিক্স-প্রথম ইঞ্জিন এ একটি বড় ধাক্কা দিয়েছে, যেখানে স্ক্যানিং, কম্প্রেশন এবং দ্রুত অ্যাগ্রিগেট এখন প্রাথমিক ডিজাইন লক্ষ্য।

Vertica ও MPP অ্যানালিটিক্স: বড় কুয়েরির জন্য SQL কে স্কেলে নেওয়া

Vertica হল সবচেয়ে স্পষ্ট বাস্তব উদাহরণ কিভাবে স্টোনব্রেকারের অ্যানালিটিক্স ডাটাবেস ধারণাগুলো একটি প্রোডাক্টে রূপ নিয়েছে। এটি কলামার স্টোরেজ থেকে শিক্ষা নিয়ে একটি বিতরণকৃত ডিজাইনের সাথে জোড়া দিল যা একটি নির্দিষ্ট সমস্যার জন্য—বড় পরিমাণ ডেটা থাকলে দ্রুত অ্যানালিটিক SQL কুয়েরি উত্তর দেওয়া—লক্ষ্য করে তৈরি।

MPP মানে কী (সরল ভাষায়)

MPP হল massively parallel processing। সহজভাবে ভাবুন: অনেক মেশিন মিলে এক SQL কুয়েরি নিয়ে কাজ করে।

একটি সার্ভার যাতে সব ডেটা পড়ে এবং সব গ্রুপিং ও সোর্ট করে, তার বদলে ডেটা নোডগুলিতে ভাগ করা থাকে। প্রতিটি নোড তার নিজের অংশে প্রসেস করে, এবং সিস্টেম আংশিক ফলাফলগুলো মিলিয়ে চূড়ান্ত উত্তর দেয়।

যদি ডেটা ভালভাবে বণ্টিত থাকে এবং কুয়েরি প্যারালালাইজেবল হয়, তাহলে একটি কুয়েরি যা এক বক্সে মিনিট নিত পারে, ক্লাস্টারে সেকেন্ডে নেমে যেতে পারে।

বাস্তবে এটা কী অনুধাবন দেয়

Vertica-ধাঁচের MPP অ্যানালিটিক্স সিস্টেমগুলো তখনই উজ্জ্বল যখন আপনার অনেক সারি থাকে এবং আপনি সেগুলো স্ক্যান, ফিল্টার ও অ্যাগ্রিগেট করতে চান দক্ষভাবে। সাধারণ ইউজকেসগুলিঃ

- ড্যাশবোর্ড যা বড় ফ্যাক্ট টেবিল পড়ে (প্রোডাক্ট অ্যানালিটিক্স, মার্কেটিং পারফরম্যান্স)

- শিডিউলড রিপোর্টিং ও অ্যাড-হক SQL বিশ্লেষণ

- বড় অ্যাগ্রিগেশন (ডেলি কোহর্ট, ফানেল, টপ-এন র্যাঙ্কিং, বহু-ডাইমেনশন রোলআপ)

ট্রেড-অফ বনাম ট্রানজ্যাকশনাল ডাটাবেস

MPP অ্যানালিটিক্স ইঞ্জিনগুলো ট্রানজ্যাকশনাল (OLTP) সিস্টেমের সরাসরি বিকল্প নয়। এগুলো অপ্টিমাইজ করা হয় অনেক সারি পড়ার এবং সারাংশ হিসাব করার জন্য, ছোট আপডেটে দক্ষতা নয়।

সাধারণ ট্রেড-অফগুলোঃ

- ফ্রেশনেস: ডেটা প্রায়ই ব্যাচ বা মাইক্রো-ব্যাচে আসে, রো-বাই-রো নয়

- আপডেট: ঘন ঘন সিঙ্গেল-রো আপডেট/ডিলিট সাধারণত ধীর বা অপারেশনালি জটিল

- ল্যাটেন্সি: সেকেন্ড-টু-মিনিট অ্যানালিটিক কুয়েরির জন্য চমৎকার; মিলিসেকেন্ড-স্তরের ইউজার-ফেসিং ট্রানজ্যাকশনের জন্য নয়

মূল ধারণা হচ্ছে ফোকাস: Vertica ও অনুরূপ সিস্টেমগুলো তাদের গতি লাভ করে স্টোরেজ, কম্প্রেশন ও প্যারালাল এক্সিকিউশনের জন্য টিউন করে—তারপর ট্রানজ্যাকশনাল সিস্টেমরা এড়িয়ে যাওয়া সীমাবদ্ধতাগুলি গ্রহণ করে।

কুয়েরি এক্সিকিউশন উদ্ভাবনগুলো যা অ্যানালিটিক্সকে দ্রুত করেছে

একটি ডাটাবেস "স্টোর ও কোয়েরি" করতে পারলেও অ্যানালিটিক্সের জন্য ধীর লাগতে পারে। পার্থক্য প্রায়ই আপনি কী লিখেন না, বরং কিভাবে ইঞ্জিন সেটা এক্সিকিউট করে: কিভাবে পেজগুলো পড়ে, ডেটা CPU-তে মুভ করে, মেমরি ব্যবহার করে, এবং অনাবশ্যক কাজ কমায়।

স্টোনব্রেকারের অ্যানালিটিক্স-কেন্দ্রিক প্রকল্পগুলো এই ধারণাকে এগিয়ে নিয়েছিল যে কোয়েরি পারফরম্যান্স হচ্ছে এক্সিকিউশন সমস্যা যতটা স্টোরেজ সমস্যা। এই চিন্তা টিমগুলোকে এক-রো লুকআপ টিউন করা ছাড়িয়ে মিলিয়ন বা বিলিয়ন রো জুড়ে লম্বা স্ক্যান, জয়েন ও অ্যাগ্রিগেশন অপ্টিমাইজ করার দিকে সরিয়ে দিয়েছে।

ভেক্টরাইজড এক্সিকিউশন (একা রো নয়, ব্যাচে কাজ করা)

অনেক পুরনো ইঞ্জিন কোয়েরি "টুপল-অ্যাট-এ-টাইম" (এক-কতি-এক)ভাবে প্রসেস করে, যা অনেক ফাংশন কল ও ওভারহেড তৈরি করে। ভেক্টরাইজড এক্সিকিউশন সেই মডেল উল্টো করে: ইঞ্জিন একটি ব্যাচ (ভেক্টর) মানের উপর টাইট লুপে কাজ করে।

সরলভাবে বলতে, এটা যেমন এক আইটেম করে না বলে কার্টে করে মুদি নিয়ে যাওয়া—ব্যাচিং ওভারহেড কমায় এবং আধুনিক CPU-গুলোকে তাদের শক্তিতে চালানো যায়: প্রত্যাশিত লুপ, কম ব্রাঞ্চ, ভালো ক্যাশ ব্যবহার।

মেমরি-ফ্রেন্ডলি অ্যানালিটিক্স ডিজাইন

দ্রুত অ্যানালিটিক্স ইঞ্জিনগুলো অতি CPU ও ক্যাশ-দক্ষ থাকতে চাই। এক্সিকিউশন উদ্ভাবনগুলো সাধারণত ফোকাস করে:

- অপ্রয়োজনীয় ম্যাটেরিয়ালাইজেশন এড়ানো (বড় ইন্টারমিডিয়েট টেবিল না বানিয়ে স্ট্রিমিং করতে চেষ্টা করা)

- সম্ভব হলে কম্প্রেসড ডেটার উপরে কাজ করা (কম মেমরি ব্যান্ডউইডথ, কম বাইট মুভ)

- হট ডেটা ক্যাশে রাখা (লেআউট ও ব্যাচিং যা CPU অ্যাক্সেস প্যাটার্নের সাথে মেলে)

এই ধারণাগুলো গুরুত্বপূর্ণ কারণ অ্যানালিটিক্স কোয়েরিগুলো প্রায়ই মেমরি ব্যান্ডউইডথ ও ক্যাশ মিস দ্বারা সীমাবদ্ধ, কাঁচা ডিস্ক স্পিড নয়।

আপনি আজ কোথায় এটাকে দেখতে পাবেন

মডার্ন ডেটা ওয়্যারহাউস ও SQL ইঞ্জিন—ক্লাউড ওয়্যারহাউস, MPP সিস্টেম, এবং দ্রুত ইন-প্রসেস অ্যানালিটিক্স টুল—প্রায়শই ভেক্টরাইজড এক্সিকিউশন, কম্প্রেশন-অ্যাওয়্যার অপারেটর এবং ক্যাশ-ফ্রেন্ডলি পাইপলাইনগুলো স্ট্যান্ডার্ড হিসেবে ব্যবহার করে।

যদিও ভেন্ডররা "অটোস্কেলিং" বা "স্টোরেজ ও কম্পিউট আলাদা" মতো ফিচার বাজারজাত করে, দৈনন্দিন গতি আপনি অনুভব করেন তাতে এগুলোর এক্সিকিউশন মডেলই বড় ভূমিকা রাখে।

প্লাটফর্ম মূল্যায়ন করলে শুধু কি তারা স্টোর করে তা নয়, কিভাবে তারা জয়েন ও অ্যাগ্রিগেট চালায় তার ব্যাখ্যাও জিজ্ঞেস করুন—এবং তাদের এক্সিকিউশন মডেল কি অ্যানালিটিক্সের জন্য তৈরি।

স্ট্রিমিং সিস্টেম: ব্যাচ চিন্তা থেকে রিয়েল-টাইম ডেটায়

ডেটা প্রোডাক্ট UI তৈরি করুন

চ্যাট ব্যবহার করে একটি React ওয়েব অ্যাপ তৈরি করুন এবং আপনার স্কিমা বদলালে দ্রুত পুনরাবৃত্তি করুন।

স্ট্রিমিং ডেটা সহজভাবে হচ্ছে ধারাবাহিকভাবে আগত ইভেন্টসের স্রোত—যেমন একটি ক্রেডিট-কার্ড সোয়াইপ, সেন্সর রিডিং, পণ্যের পেজে ক্লিক, একটি প্যাকেজ স্ক্যান, বা লোগ লাইন। প্রতিটি ঘটনা রিয়েল-টাইমে আসে এবং থামে না।

কেন ব্যাচ ডাটাবেস লাইভ কাজে ধীর মনে হয়

প্রথাগত ডাটাবেস ও ব্যাচ পাইপলাইনগুলো দুর্দান্ত যখন আপনি অপেক্ষা করতে পারেন: গতকালের ডেটা লোড করুন, রিপোর্ট চালান, ড্যাশবোর্ড প্রকাশ করুন। কিন্তু রিয়েল-টাইমের চাহিদা পরের ঘণ্টার জবের জন্য অপেক্ষা করে না।

যদি আপনি কেবল ব্যাচে ডেটা প্রসেস করেন, আপনি প্রায়ই পান:

- পুরনো মেট্রিক (নম্বরগুলো ঘটনার থেকে পেছনে থাকে)

- দেরিতে অ্যালার্ট (ক্ষতি হওয়ার পরে জানেন)

- অদ্ভুত ওয়ার্কঅ্যারাউন্ড (টেবিল পোল করা, কোয়েরি বারবার চালানো)

স্ট্রিমিং সিস্টেমগুলো continuous computation—ইভেন্ট আসার সঙ্গে সঙ্গে আপডেট হওয়া ফলাফল—কে কেন্দ্র করে ডিজাইন করা।

কোর ধারণা: কন্টিনিউয়াস কোয়েরি এবং উইন্ডোজ

একটি কন্টিনিউয়াস কোয়েরি এমন একটি SQL-রকম কুয়েরি যা কখনো "শেষ" হয় না। বদলে এটা নতুন ইভেন্ট আসার সাথে সাথে ফলাফল আপডেট করে।

স্ট্রিমগুলো অপরিমেয় (শুধু শেষ হয় না), তাই স্ট্রিমিং সিস্টেমগুলো উইন্ডো ব্যবহার করে গণনা সীমাবদ্ধ রাখতে। উইন্ডো হতে পারে সময়ভিত্তিক ("সর্বশেষ 5 মিনিট"), প্রতি মিনিট, বা ইভেন্ট-ভিত্তিক (শেষ 1000 ইভেন্ট)। এর ফলে রোলিং কাউন্ট, অ্যাভারেজ বা টপ-এন তালিকা পরিচালনা করা যায় পুনরায় সবকিছু প্রসেস না করে।

ব্যবসায়িক উদাহরণ যেখানে রিয়েল-টাইম তৎক্ষণাৎ কাজে লাগে

- ফ্রড মনিটরিং: সেকেন্ডের মধ্যে অস্বাভাবিক লেনদেন চিহ্নিত করা

- অপারেশনাল অ্যালার্ট: ত্রুটি স্পাইক শুরু হওয়া মাত্র ডিটেক্ট করা

- লাইভ প্রোডাক্ট মেট্রিক্স: সাইন-আপ, কনভার্শন বা ইনভেন্টরি পরিবর্তন লাইভ দেখা

- লজিস্টিকস ভিজিবিলিটি: ধারাবাহিক স্ক্যান থেকে আনুমানিক ডেলিভারি সময় আপডেট করা

ওয়ার্কলোড-ড্রিভেন আর্কিটেকচার: ঠিক কাজের জন্য ঠিক ইঞ্জিন ব্যবহার করা

স্টোনব্রেকার বহু দশক ধরে যুক্তি দিয়েছেন যে ডাটাবেসগুলো সবই সাধারণ-উদ্দেশ্যের না হওয়াই ভাল। কারণ সাধারণ: বিভিন্ন ওয়ার্কলোড বিভিন্ন ডিজাইন পছন্দকে পুরস্কৃত করে। যদি আপনি একজায়গায় এক কাজের জন্য কঠোরভাবে অপ্টিমাইজ করেন (যেমন ছোট ট্রানজ্যাকশান আপডেট), সাধারণত আপনি আরেক কাজকে ধীর করে ফেলবেন (যেমন রিপোর্টিংয়ের জন্য বিলিয়ন সারি স্ক্যান)।

কেন টিমগুলো একাধিক সিস্টেম নিয়ে শেষ হয়

অধিকাংশ আধুনিক স্ট্যাক একাধিক ডেটা সিস্টেম ব্যবহার করে কারণ ব্যবসা একাধিক ধরনের উত্তর চায়:

- OLTP ডাটাবেস (অ্যাপ ডাটাবেস): দ্রুত ইনসার্ট/আপডেট, কড়া সঠিকতা, বহু কনকারেন্ট ইউজার

- ওয়্যারহাউস / অ্যানালিটিক্স ডাটাবেস: বড় ডেটার ওপর দ্রুত রিড, ভারী অ্যাগ্রিগেশন, লম্বা স্ক্যান

- ক্যাশ / কী-ভ্যালু স্টোর: অত্যন্ত দ্রুত রিড "হট" ডেটার জন্য (সেশন, কাউন্টার, ফিচার ফ্ল্যাগ)

- স্ট্রিম প্রসেসিং + লগ: ধারাবাহিক ইভেন্টস (ক্লিক, পেমেন্ট, IoT), লো-ল্যাটেন্সি পাইপলাইন, রিয়েল-টাইম মেট্রিক্স

এটাই বাস্তবে "ওয়ান সাইজ ডোন্ট ফিট অল": আপনি সেই কাজের আকৃতির সাথে মেলে এমন ইঞ্জিন বেছে নেন।

একটি সরল সিদ্ধান্ত গাইড

নিচের দ্রুত ফিল্টার ব্যবহার করুন যখন আরেকটি সিস্টেম বাছাই (বা ন্যায্যতা দেখানো) করছেন:

- যদি আপনি প্রয়োজন অনেক ছোট রিড/রাইটস এবং ট্রানজ্যাকশন (অর্ডার, ইউজার প্রোফাইল): OLTP DB দিয়ে শুরু করুন।

- যদি প্রয়োজন বৃহৎ কুয়েরি ও অ্যাগ্রিগেশন (সাপ্তাহিক রাজস্ব, কোহর্ট অ্যানালাইসিস): একটি অ্যানালিটিক্স ওয়্যারহাউস যোগ করুন।

- যদি প্রয়োজন সাব-সেকেন্ড রেসপন্স রিপিটেড লুকআপে: ক্যাশ যোগ করুন।

- যদি প্রয়োজন রিয়েল-টাইম ইভেন্টে বিক্রিয়া (ফ্রড রুল, লাইভ ড্যাশবোর্ড): স্ট্রিমিং যোগ করুন।

টুল স্প্রল এড়ান

একাধিক ইঞ্জিন স্বাস্থ্যকর হতে পারে, কিন্তু কেবল তখনই যখন প্রতিটির একটা স্পষ্ট ওয়ার্কলোড থাকে। নতুন টুল পায়ের জায়গা পেয়ে উঠুক না—প্রতিস্থাপন করার আগে সেটি খরচ, ল্যাটেন্সি বা ঝুঁকি কমায় কিনা তা প্রমাণ করুক।

ওপরে উল্লেখিত চেকলিস্ট মেনে কয়েকটি কম ইঞ্জিন ধরে শক্ত অপারেশনাল মালিকানা রাখুন, এবং যেসব কম্পোনেন্টের স্পষ্ট উদ্দেশ্য নেই সেগুলো অবসান করুন।

এই ধারণাগুলো আধুনিক ডেটা আর্কিটেকচারে কীভাবে দেখা যায়

একটি লিগ্যাসি প্রক্রিয়া আধুনিক করুন

ধীর লিগ্যাসি ওয়ার্কফ্লোকে সেই কাজের সঙ্গে মেলে এমন একটি কেন্দ্রীভূত অ্যাপ দিয়ে প্রতিস্থাপন করুন।

স্টোনব্রেকারের গবেষণার থ্রেডগুলো—রিলেশনাল ভিত্তি, এক্সটেনসিবিলিটি, কলাম স্টোর, MPP এক্সিকিউশন, এবং "ওয়ার্কের জন্য সঠিক টুল"—আধুনিক ডেটা প্ল্যাটফর্মগুলোর ডিফল্ট আকারে দেখা যায়।

পরিচিত আর্কিটেকচার প্যাটার্ন (এবং কেন এরা এমন দেখায়)

ওয়্যারহাউস SQL অপ্টিমাইজেশন, কলামার স্টোরেজ, এবং প্যারালাল এক্সিকিউশনের বহু দশকের কাজের প্রতিফলন। যখন আপনি বড় টেবিলের ওপর দ্রুত ড্যাশবোর্ড দেখতে পান, প্রায়শই আপনি কলাম-ভিত্তিক ফরম্যাট, ভেক্টরাইজড প্রসেসিং ও MPP-স্টাইল স্কেলিং দেখেন।

লেকহাউস ওয়্যারহাউস ধারণা (স্কিমা, পরিসংখ্যান, ক্যাসিং, কস্ট-ভিত্তিক অপটিমাইজেশন) নেয় কিন্তু তা খোলা ফাইল ফরম্যাট ও অবজেক্ট স্টোরেজে রাখে। "স্টোরেজ সস্তা, কম্পিউট ইলাস্টিক" স্থানান্তর নতুন; কিন্তু কুয়েরি ও ট্রানজ্যাকশন চিন্তাভাবনা নতুন নয়।

MPP অ্যানালিটিক্স সিস্টেম (শেয়ারড-নথিং ক্লাস্টার) সরাসরি সেই গবেষণার বংশধর যা প্রমাণ করে আপনি ডেটা পার্টিশন করে, ডেটার কাছে কম্পিউটেশন পাঠিয়ে এবং জয়েন/অ্যাগ্রিগেশনের সময় ডেটা মুভমেন্ট সাবধানে ম্যানেজ করে SQL স্কেল করতে পারেন।

আজ SQL কোথায় ফিট করে

SQL হয়েছে ওয়্যারহাউস, MPP ইঞ্জিন এবং এমনকি "লেক" কোয়েরি স্তরের একটি সাধারণ ইন্টারফেস। টিমরা এটাকে ব্যবহার করে:

- BI টুল ও অ্যানালিস্টদের জন্য একটি স্থির কনট্রাক্ট হিসেবে

- যখন ইঞ্জিন বদলে যায় তখন পোর্টেবিলিটি লেয়ার হিসেবে

- গভর্ন্যান্স সারফেস হিসেবে (ভিউ, পারমিশন, অডিটেড এক্সেস)

একইভাবে যখন এক্সিকিউশন বিভিন্ন ইঞ্জিনে হয় (ব্যাচ, ইন্টারঅ্যাকটিভ, স্ট্রিমিং), ব্যবহারকারী-ফেসিং ভাষা অনেক সময় SQL-ই থাকে।

ডেটা মডেলিং ও গভর্ন্যান্স: স্কিমা এখনও গুরুত্বপূর্ণ

ফ্লেক্সিবল স্টোরেজ স্ট্রাকচার-অবধি নয়। পরিষ্কার স্কিমা, ডাটা মিষ্ট্য ব্যাখ্যা ও নিয়ন্ত্রিত বিবর্তন ডাউনস্ট্রিম ব্রেকেজ কমায়।

ভাল গভর্ন্যান্স কাগজপত্র নয়—এটা ডেটাকে নির্ভরযোগ্য করা: ধারাবাহিক সংজ্ঞা, মালিকানা, কোয়ালিটি চেক ও অ্যাকসেস কন্ট্রোল।

প্ল্যাটফর্ম বাছাই করার জন্য কোনো-হাইপ চেকলিস্ট

প্ল্যাটফর্ম মূল্যায়ন করলে প্রশ্ন করুন:

- ওয়ার্কলোড মেলাচ্ছে কি: মূলত BI ড্যাশবোর্ড, অ্যাড-হক এক্সপ্লোরেশন, ML ফিচার বিল্ডিং, নাকি অপারেশনাল ওয়ার্কলোড?

- ল্যাটেন্সি চাহিদা: সেকেন্ড, মিনিট বা ঘণ্টা? স্ট্রিমিং ফ্রেশনেস কি দরকার?

- ডেটার আকৃতি: প্রধানত ওয়াইড ইভেন্ট লগ (কলামারের জন্য আদর্শ) না অনেক পয়েন্ট লুকআপ?

- কনকারেন্সি: কতজন ইউজার/কুয়েরি একসঙ্গে, এবং কতটা পূর্বানুমেয়?

- কনসিস্টেন্সি চাহিদা: শক্ত ট্রানজ্যাকশন দরকার, না ইভেন্টুয়াল কনসিস্টেন্সি গ্রহণযোগ্য?

- অপারেশনাল বাস্তবতা: কে চালাবে, কী স্কিল আছে, এবং ২টা.এম.এ.এম.-এ ব্যর্থতা মোড কি?

যদি কোনও ভেন্ডর এই মৌলিকগুলোকে সাধারণ ভাষায় ম্যাচ করতে না পারে, তাহলে "ইনোভেশন" সম্ভবত প্রায়ই প্যাকেজিং।

টিমগুলোর জন্য মূল টেকওয়ে—বিল্ড বা বাই করার সময়

স্টোনব্রেকারের থ্রুপ্লাইন সহজ: ডাটাবেসগুলো সবচেয়ে ভালো কাজ করে যখন সেগুলো নির্দিষ্ট কাজের জন্য ডিজাইন করা হয়—এবং যখন সেগুলো সেই কাজ বদলালে অভিযোজ্য হতে পারে।

1) সিস্টেমকে ওয়ার্কলোডে মেলান (একটি ইঞ্জিন সব জায়গায় জিতবে বলে আশা করবেন না)

ফিচার তুলনা করার আগে, আপনি আসলেই কী করতে চান তা লিখে রাখুন:

- অ্যানালিটিক্স: লম্বা স্ক্যান, বড় অ্যাগ্রিগেশন, প্রচুর রিড

- ট্রানজ্যাকশনস: বহু ছোট আপডেট, শক্ত সঠিকতা, দ্রুত রেসপন্স

- মিক্সড ওয়ার্কলোড: উভয়ই, কিন্তু প্রায়শই যত্নশীল টিউনিং ও স্পষ্ট অগ্রাধিকার লাগবে

- রিয়েল-টাইম ফিড: ধারাবাহিক ইনজেশন ও ইনক্রিমেন্টাল কম্পিউটেশন

একটি ব্যবহারযোগ্য নিয়ম: যদি আপনি আপনার ওয়ার্কলোড কয়েক বাক্যে বর্ণনা করতে না পারেন (কুয়েরি প্যাটার্ন, ডেটা সাইজ, ল্যাটেন্সি চাহিদা, কনকারেন্সি), আপনি বাজে শব্দভাণ্ডারের ওপর কেনাকাটা করবেন।

2) আজকের স্কিমার জন্য নয়, পরিবর্তনের জন্য ডিজাইন করুন

টিমগুলো কতবার চাহিদা বদলে যায় তা হালকা অনুধাবন করে না: নতুন ডেটা টাইপ, নতুন মেট্রিক, নতুন কপ্লায়েন্স রুল, নতুন কনজিউমার।

রুটিন পরিবর্তনকে ঝুঁকিহীন করে এমন প্ল্যাটফর্ম ও ডেটা মডেল পছন্দ করুন:

- স্টোরেজ, কোয়েরি ও এক্সটেনশন পয়েন্ট এর মধ্যে পরিষ্কার বিভাজন

- স্কিমা পরিবর্তন ও নতুন লজিক রোলআউট করার নিরাপদ উপায়

- অর্গানিক গ্রোথে ভেঙে না পড়ার পরিমাপযোগ্য পারফরম্যান্স

3) সঠিকতা একটি পণ্য ফিচার

দ্রুত উত্তরগুলো কেবল মূল্যবান যদি সেগুলো সঠিক। অপশন মূল্যায়ন করলে জিজ্ঞেস করুন সিস্টেম কিভাবে সামলায়:

- কনকারেন্ট রাইটস (যখন দুই মানুষ/প্রসেস একই রেকর্ড আপডেট করে)

- আইসোলেশন ও কনসিস্টেন্সি গ্যারান্টি (কী গ্যারান্টি দেয়, আর কী ট্রেড-অফ আছে?)

- অপারেশনাল ফেইলিওর মোড (রিস্টার্ট, আংশিক আউটেজ, ব্যাকফিল)

4) নন-স্পেশালিস্টদের জন্য বাস্তবিক মূল্যায়ন চেকলিস্ট

একটি ছোট "প্রুফ উইথ আপনার ডেটা" চালান, কেবল ডেমো নয়:

- 3–5 প্রতিনিধিক কোয়েরি চালিয়ে সময় ও খরচ মাপুন।

- পিক কনকারেন্সি (উদাহরণ: সোমবার সকালের স্পাইক) টেস্ট করুন।

- ডেটা ফ্রেশনেস, রিকভারি ধাপ এবং দিন-দিন কার কে অপারেট করতে পারে তা ভ্যালিডেট করুন।

5) আর্কিটেকচার সিদ্ধান্তগুলোকে শিপযোগ্য সফটওয়্যারে পরিণত করা

অনেক গাইডেন্স কেবল "ঠিক ইঞ্জিন বেছে নাও"তে থেমে যায়, কিন্তু টিমগুলোর অ্যাপ ও ইনভেন্টরি টুলগুলোও সেই ইঞ্জিনের চারপাশে বানাতে হয়: অ্যাডমিন প্যানেল, মেট্রিকস ড্যাশবোর্ড, ইনজেশন সার্ভিস, ব্যাক-অফিস ওয়ার্কফ্লো।

আপনি যদি দ্রুত প্রোটোটাইপ করতে চান বিনা পুনর্নির্মাণের, তাহলে একটি ভাইব-কোডিং প্ল্যাটফর্ম যেমন Koder.ai আপনাকে চ্যাট-ড্রিভেন ওয়ার্কফ্লো থেকে ওয়েব অ্যাপ (React), ব্যাকএন্ড সার্ভিস (Go + PostgreSQL) এবং মোবাইল ক্লায়েন্ট (Flutter) ঝটপট স্পিন-আপ করতে সাহায্য করতে পারে। এটা প্রায়ই উপকারী যখন আপনি স্কিমা ডিজাইন নিয়ে দ্রুত ইটারেট করছেন, একটি ছোট ইন্টার্নাল “ডেটা প্রোডাক্ট” বানাচ্ছেন, বা আপনার ওয়ার্কলোড কিভাবে আচরণ করে তা লং-টার্ম ইনফ্রাসট্রাকচারে কমিট করার আগে যাচাই করছেন।

পড়ার পরবর্তী ধাপ (ইনটুইশন গড়তে)

যদি আপনি গভীরতর যেতে চান, খুঁজে দেখুন কলামার স্টোরেজ, MVCC, MPP এক্সিকিউশন, এবং স্ট্রিম প্রসেসিং। আরও এক্সপ্লেইনার আছে /blog এ।